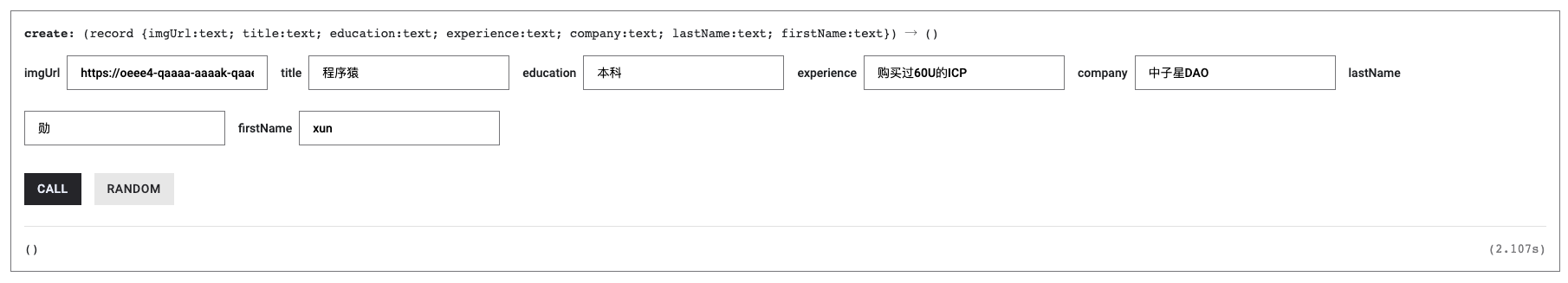

(。・∀・)ノ゙嗨!欢迎登录中子星~🫡 来了就是中子星人!🎉

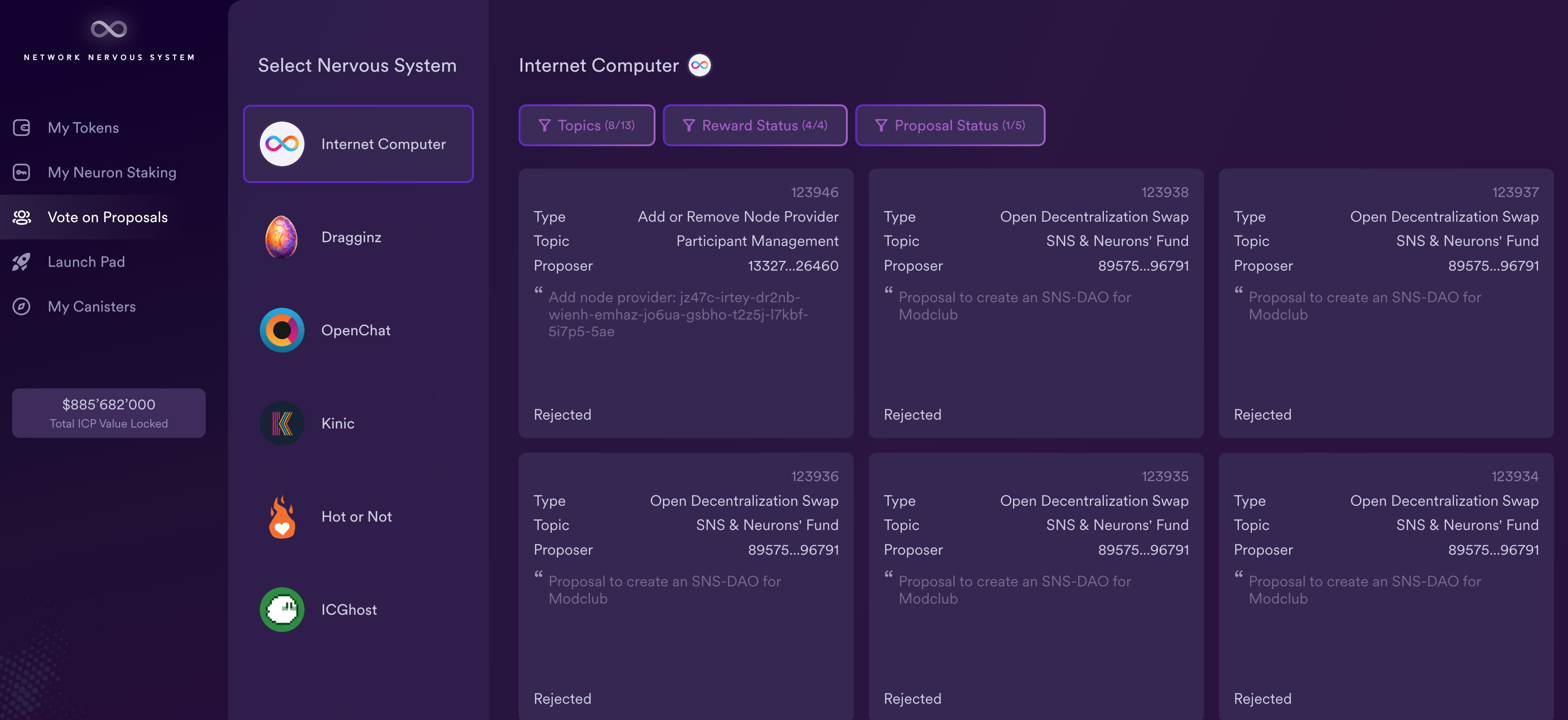

1️⃣如果你还不了解 区块链、比特币、IC ,没关系。听我向你娓娓道来加密发展史!

2️⃣如果你只听说过 IC ,还没有详细了解 IC ,那你来对地方啦,在这里了解更多相关信息!

3️⃣想知道关于多米尼克的故事嘛?他在这里!

—〦———〦———〦———〦—————〦———→ ∞ 💥 区块链奇点

有时候,我真的为生活在这个充满奇迹的时代而感到震撼。仅仅几年前,我们还在嘲笑比特币,而现在,去中心化金融、以太坊和加密货币已经深入人心。而在这个飞速发展的新世界中,有一堆新技术,正以其独特的方式,为我们的生活增添色彩:互联网计算机,是新一代通用计算区块链。

起源于多米尼克 2015 年的想法:一个可以横向扩展的去中心化的世界计算机。 2018 年完成了雏形。并在深度优化底层协议后,于 2021 年上线。经过几年发展,它旨在成为一个去中心化的云服务, 底层的去中心化保证了上层的 Dapp 不会被别人强制关掉。上层应用可以由 DAO 控制,社区共同治理。可以自己部署一个自己用的私人 Canister 存储数据。 底层做成了去中心化的云,上层应用则通过 DAO 控制权限,达到去中心化的目的。 ,全栈上链,无需使用其他中心化服务。

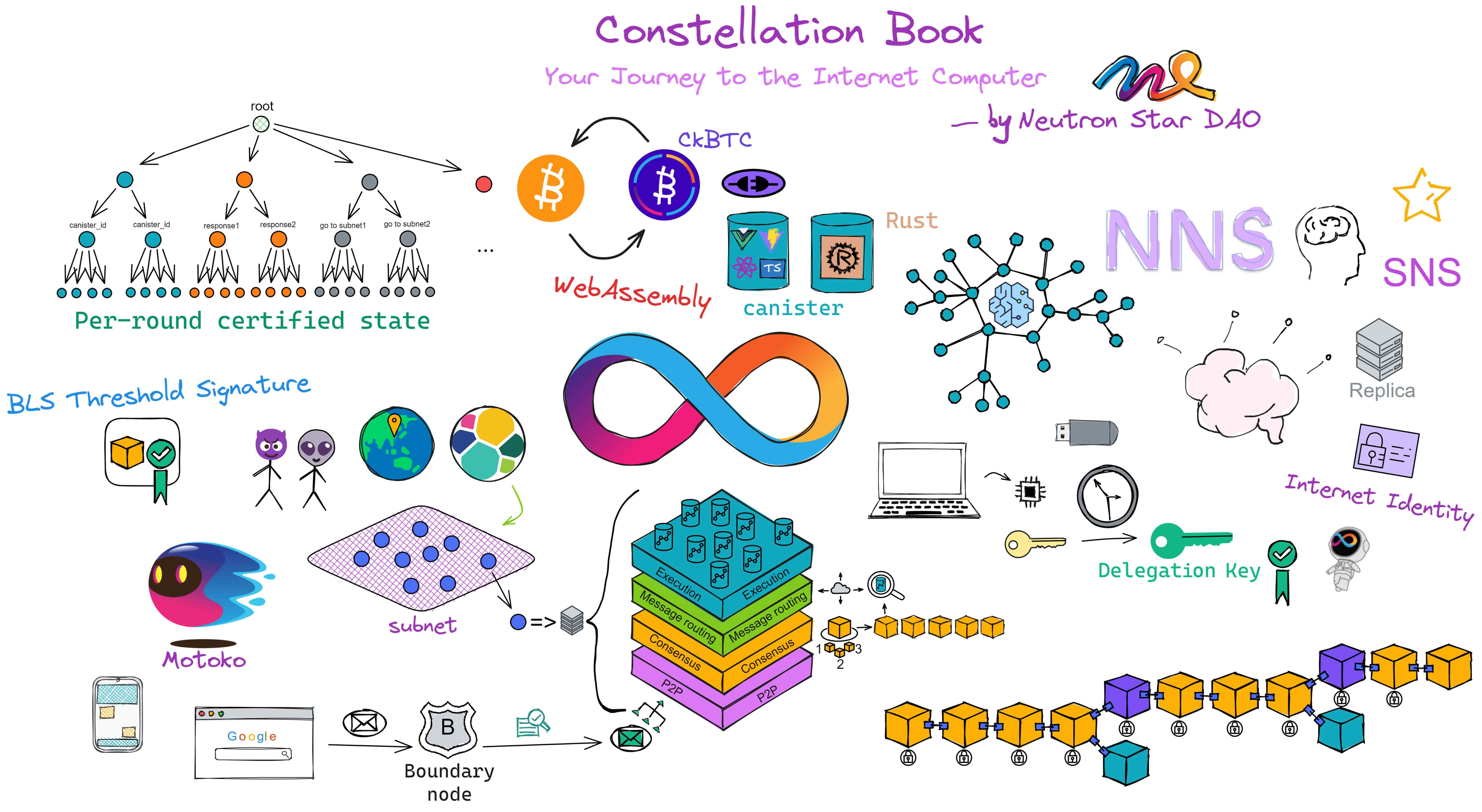

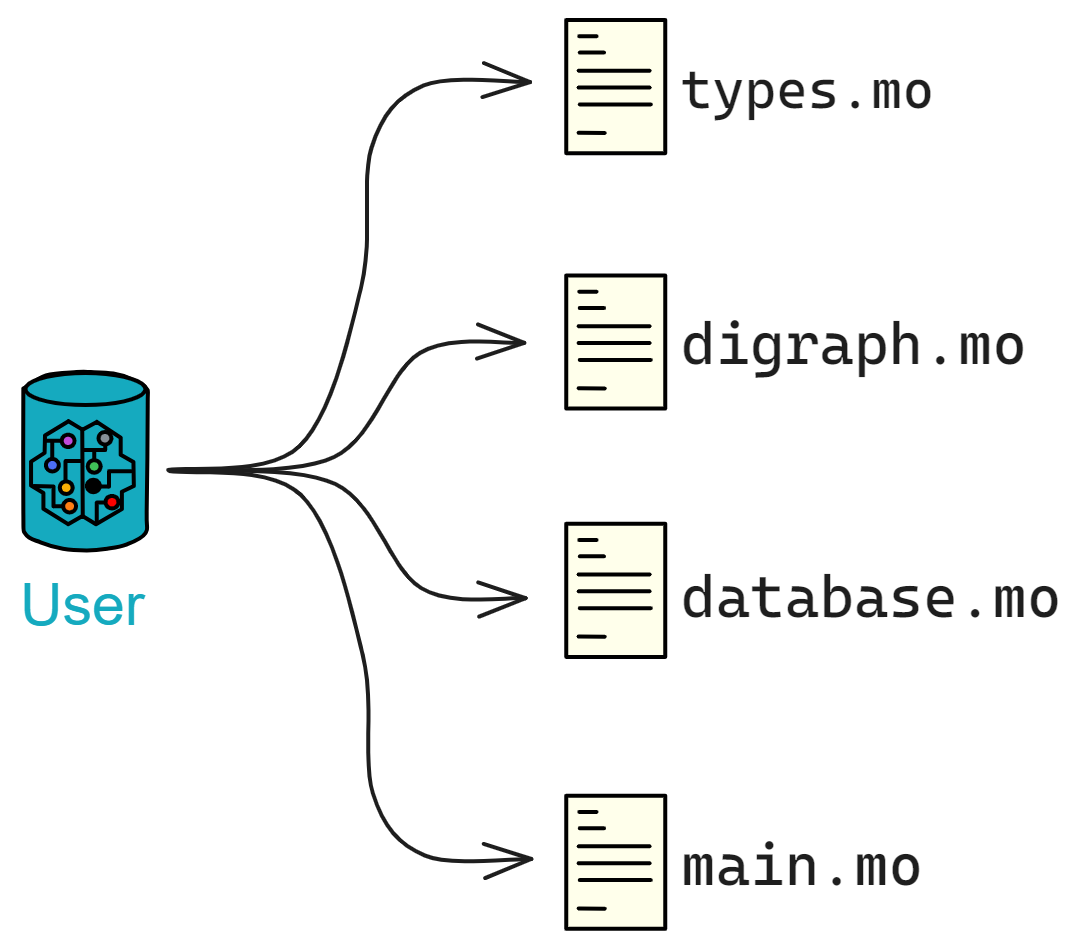

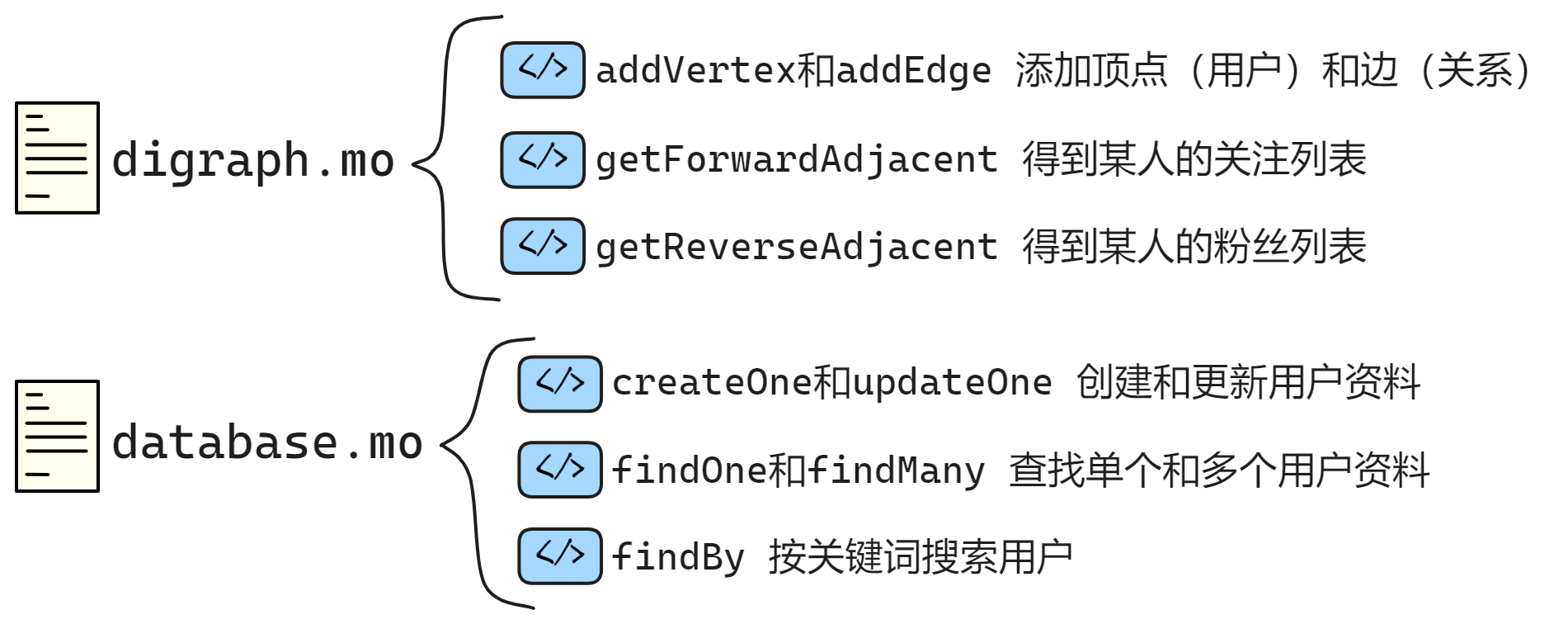

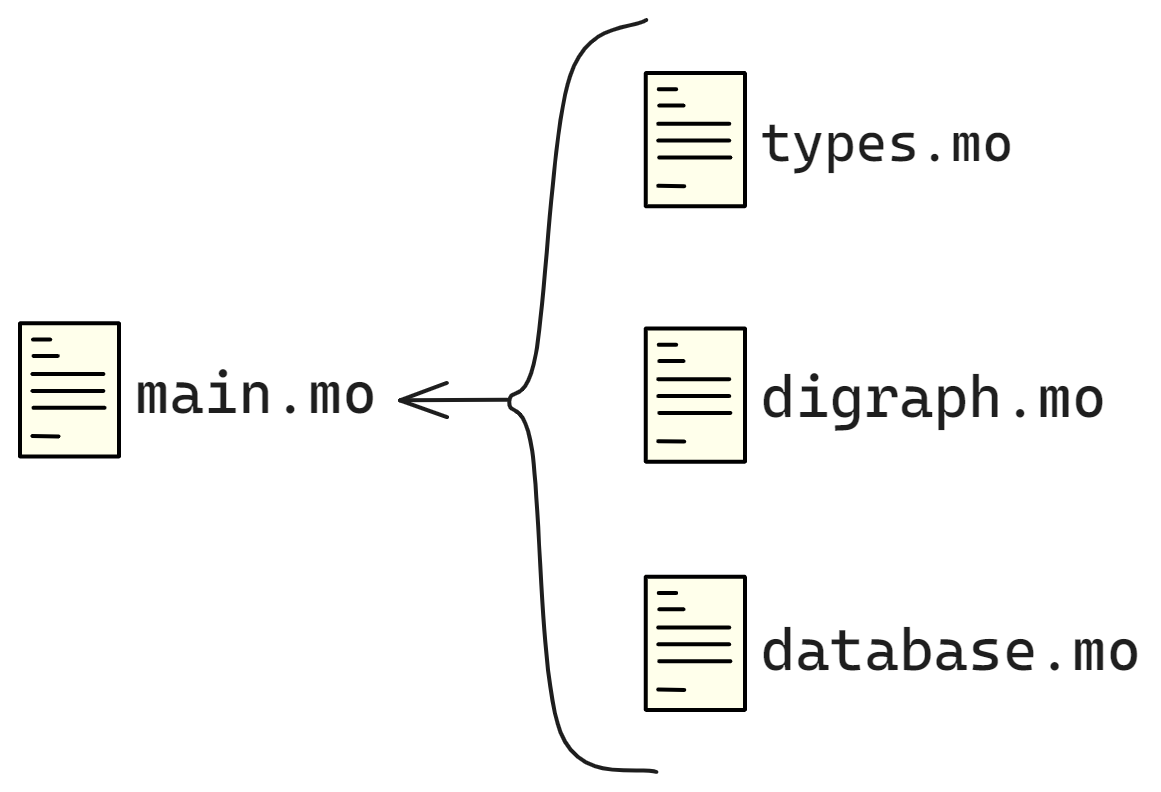

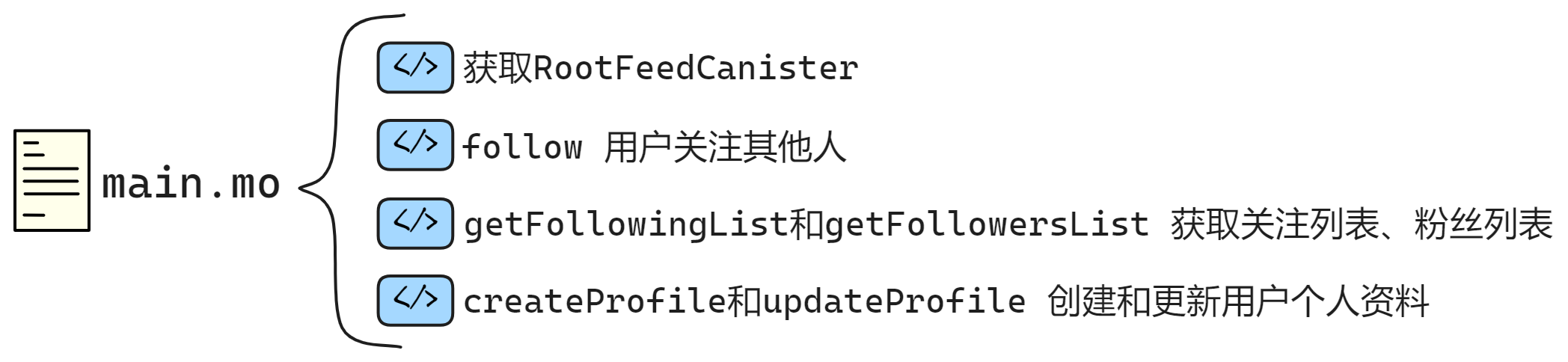

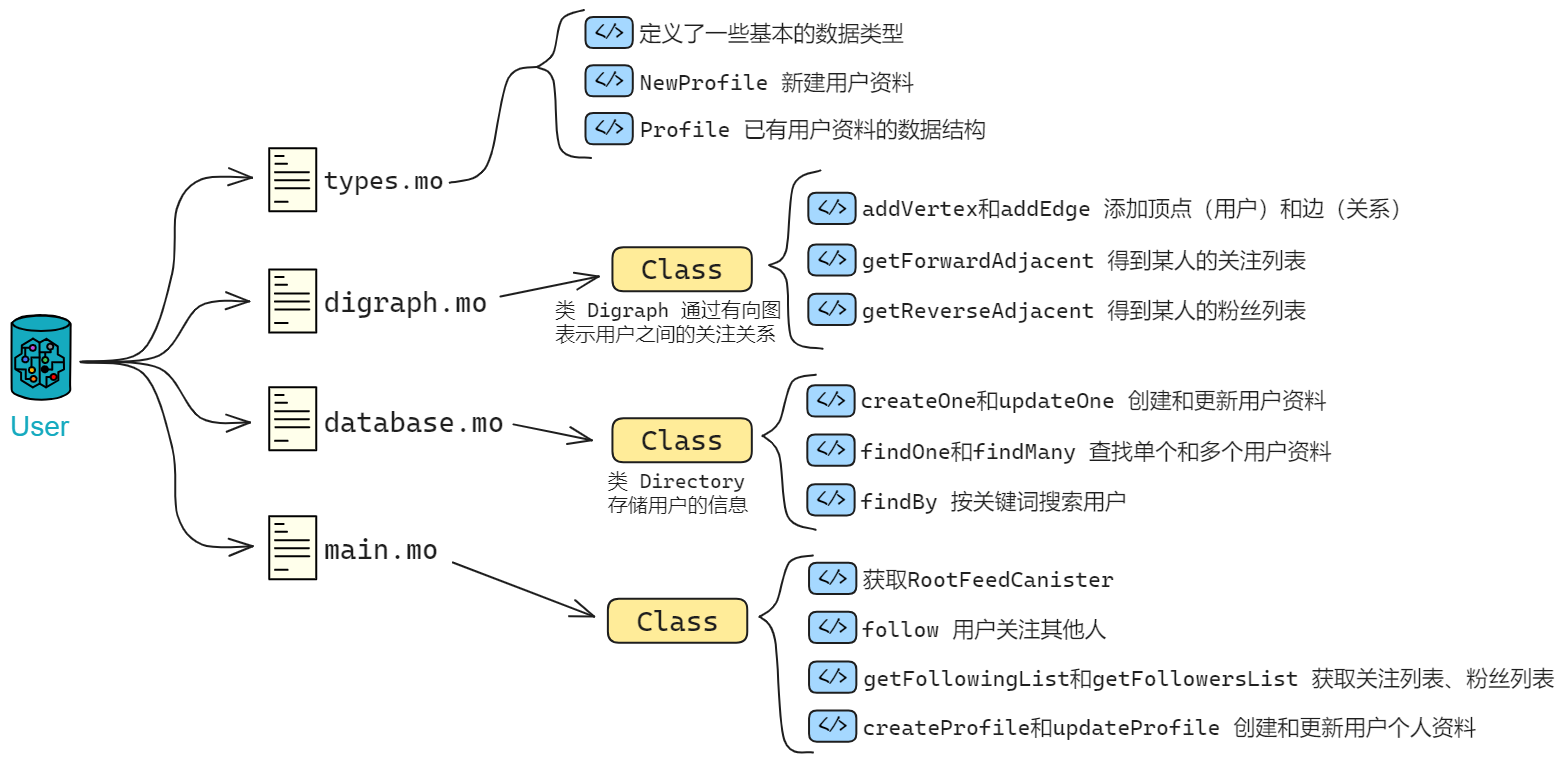

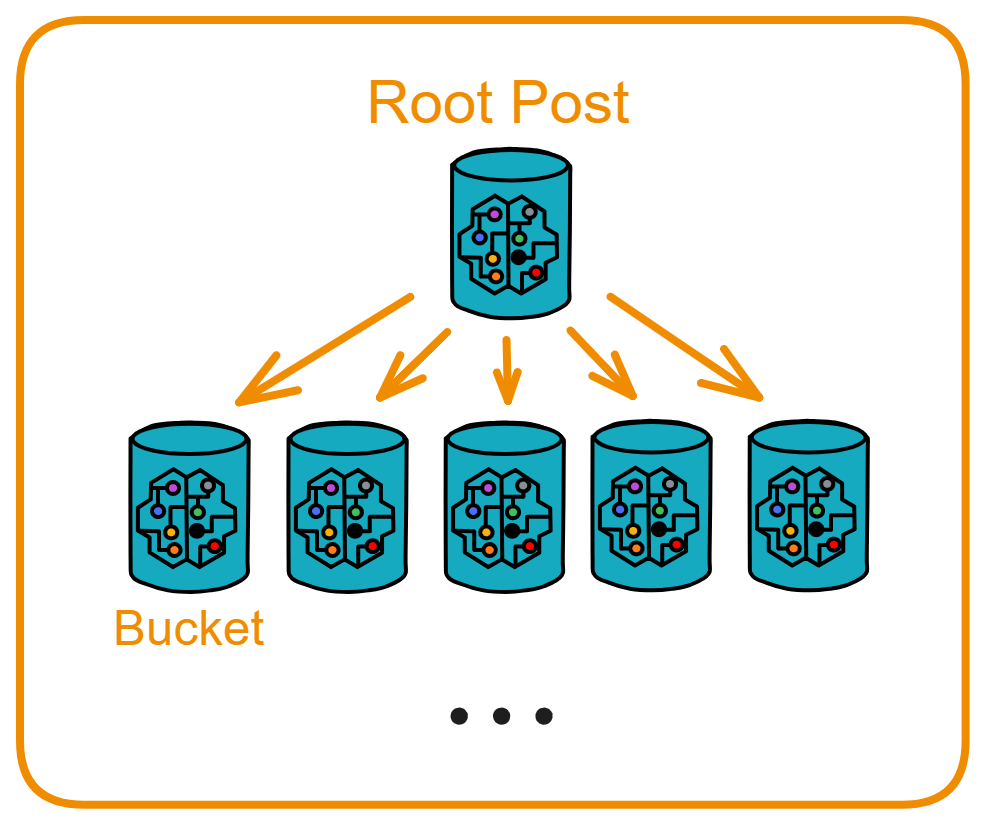

《互联网计算机漫游指南》的结构:

-

前半部分生动有趣,后半部分言简意赅

-

前半部分谈 IC 原理,后半部分论开发实战

为什么写这本书?

最初我了解 IC 后,收集整理了 IC 白皮书、Medium 、ICPL 论坛、IC Developer Forum 里的资料。给朋友讲了 IC 的架构以后,还跟她说正在整理关于 IC 资料的笔记,整理好就分享出来,没想到这一整理就是一年。在经历了天荒地老、沧海桑田、时过境迁的漫长岁月(拖延)后,加上自己后来学到的东西,终于凑出了笔记的初代版本。又经过一段时间的深入学习,我觉得把这些笔记分享出来比较好。做成一本开源书帮大家学习 IC 。也是为 IC 开发者社区做一点贡献。

零门槛学习区块链,抹平学习 IC 门槛。

为什么开源?

我很喜欢 Rust 开源社区,Rust 社区里有很多开源书、开源优质项目,给了我很大帮助。我从 Rust 开源社区学到了很多东西。像比特币、以太坊以及相关的项目也都有浓厚的开源氛围,我希望 IC 社区也涌现出越来越多的开源项目。供大家互相学习。

另外,IC 的内容更新迭代很快,开源大家一起贡献,内容保持新鲜不过时。

加入本书的开发者讨论群,勘误、修改、提出建议、共同为开源书贡献力量!

🌎 OpenChat, Telegram, Discord, Github

每个极客心中都有一个去中心化梦想。

这是一个关于多米尼克·威廉姆斯(Dominic Williams)的故事。

来自伦敦的极客😎

他喜欢把自己称作 “ JAHEBIL ” ,即 Just Another Hacker Entrepreneur Based in London 。

他写代码,创业,在伦敦做 “ 造梦家 ” 。

他勇敢又乐观,过着 “ 与世隔绝 ” 的生活,不喜社交,只关心他创立的公司品牌,重复两点一线的生活。即使每天工作 18 个小时、当时英国的创业环境也不友好,他也能哼出最快乐的小调。

英国的创业环境相对于硅谷来说,简直是地狱模式。硅谷一大批公司的成功造就了更多大笔的投资,投资又吸引了几乎全球顶尖的创业者去硅谷淘金,走向巅峰或失败。与人才济济的硅谷不同,在英国创业,多米尼克创立的每一个公司都能产生一些有限的回报,然后继续创办下一个公司,陷入循环怪圈:拼命工作,制造梦想,维持梦想,再制造下一个梦想 ...... 既要磨砺自己提升技术,又要使公司保持盈利。

厌倦了怪圈式的生活,无限循环只会耗尽他的热情。希望的嫩芽磨砂着多米尼克的心,2010 年,造梦家跳出怪圈,决定干票大的!

Fight My Monster ,一款大型多人在线游戏,也是儿童社交网络。他计划让全球各地的孩子都能联机玩这款游戏。玩家拥有自己的怪物,在回合制的战斗中使用不同的技能攻击对方。彼时,地球的另一端也在为洛克王国疯狂。

在比较了 HBase 、Cassandra 和其他数据库之后,多米尼克选择了早期的 Cassandra beta ,第一个分布式 “ 横向扩展 ” 的数据库。多米尼克为 Cassandra 构建了各种工具,包括第一个在可扩展的最终一致存储上运行原子事务的系统。他们是世界上第一个尝试把复杂 Cassandra 系统用于生产实践的团队。

多米尼克想用分布式系统把全球数百万用户联系起来,这在当时算不小的创新。经过几次试运行后,游戏在 2011 年新年正式推出,在短短两周内获得了 3 万名用户,并在几个月内暴涨到 30 万名用户。

团队成功以微薄的预算将业务规模不断扩大。不过他低估了一点,这种大型在线游戏需要更多专业人员,例如 flash 网页、数据库、网络、支付系统、运维、复杂性分析、卡通形象、音效音乐、动画特效、广告投放 ……

这笔庞大的支出比他之前的任何创业项目预算都多。很快用光了多米尼克和他朋友们的投资,不得不开始筹集额外资金。通宵工作换来了近乎完美的增长图表,“ 所以融资应该不会太难吧 ” 。

多米尼克向投资人介绍:“ Fight My Monster 发展迅速,很快将超过 100 万用户。我们认为工程师生活在一个激动人心的时代,互联网的基础设施已经成熟了。很多事情突然之间可以用新方式来实现了。这家公司最初是在非常有限的预算下自力更生的。您可能已经听说,Fight My Monster 正在扩张,现在很多优秀的工程师有机会加入。”

“ 我向您简述一下我们的架构方案以及我们为什么这么做。如您所见,它并不是一个传统架构。我们选择了一个简单但可扩展的三层架构,我们在云端托管。我希望这个系统工作 ...... ” 多米尼克继续声情并茂。

“ 既然你们已经有这么多用户了,也许应该尝试让更多用户付费。这样既能证明你们的赚钱能力,也能获得我们的投资。” 对方眉头紧蹙,明显不愿意投钱。面对如此疯狂的用户增长,伦敦的投资人甚至怀疑多米尼克造假数据。

这下,多米尼克的心像饼干一样碎成了片。多米尼克还是低估了融资的难度。

很快,片又变成了渣。此时竞争对手已经获得了另一些投资公司的资金,还阻止别的投资公司再给 Fight My Monster 投资。

难道是自己还不够努力?

由于 Cassandra 也处于早期开发中。2011 年底,因为 Cassandra beta 版代码里的 bug ,Fight my monster 的用户数据差点丢失。Cassandra 资深工程师和多米尼克团队经过好几天通宵达旦的工作才保存下来,最终化解了这毛骨悚然的事。

多米尼克太忙了。

他像一辆上紧发条的玩具车,在公司与住宅之间飞速穿梭:刚改完 bug 还没测试就要去会见投资人;连饭都顾不上吃,便埋头和工程师们开会讨论系统调整方案;从公司出来,马上又奔赴超市给妻子买圣诞节礼物 ......

团队在各方面都高度依赖他。他的工作量变得异常繁重,即使在硅谷这样容易获得投资的地方也很难看到。当时的多米尼克每天都工作 12 - 18 小时, 相比现在的创业公司这样的工作模式已经很少见了。他要在管理业务、管理系统、写代码之间取得平衡,同时还要留出时间照顾个人生活。没多久,多米尼的妻子也适应了这种生活:白天她当游戏导演、策划,再优化游戏玩法、制定项目流程;晚上回家做饭、打扫房间,和多米尼克无缝配合。

多米尼克头像。

之后的生活更加努力了。很幸运,他在硅谷偶然遇到了愿意投资的公司。终于有投资人被眼前这个造梦家打动了。Fight My Monster 在筹集到资金后的几周内,用户数量迅速达到了 100 万。几个月后,多米尼克将公司迁至圣马特奥(旧金山附近的一个小镇)。

他去楼下喝咖啡,回来时备忘录里密密麻麻的记载着 ConcurrentHashMap 的常见问题以及解决方法;听极客们讲创业公司组建团队的经验;结交硅谷的风险投资人 ......

经过一年的发展,多米尼克在 2012 非常兴奋:

“ Fight My Monster 今天出现在了 TechCrunch 上,值得大声欢呼,谢谢!!!我们在努力工作,希望我们能够实现愿望。”

“ 如果您还没有玩过 Fight My Monster,我建议您试一试 – 网上真的没有什么比得上它了。我们正在英国孵化,体验该网站的最佳时间是工作日(放学后)下午 4 点至晚上 8 点或周末的白天。”

然而,挫折呼啸而至。在融资后,公司新入职的财务高管在战略上与原来的团队意见不合,分歧进而演变为决策失误。尽管用户依然在增长,但 Fight My Monster 的前进已经阻力重重,无力回天。

从财务回报来看,Fight My Monster 还是失败了,用户在 2013 年最终扩大到了 300 多万。

不过这段经历非常宝贵,弥足珍贵的部分是找到一群给力的同事,沉迷于自己热爱的那个分布式系统。多米尼克非常钦佩 Fight My Monster 的设计师 Jon Ball,Jon 总能用团队的设计系统造出一大堆好看的模型,之后又顺利创造了广告收视率最高纪录。还有 Cassandra 的工程师 Aaron Morton “ We work together,believe each other ” ,他和多米尼克一起打造了游戏背后的 “ 引擎 ” ——分布式数据库。

事后看来,多米尼克的 Flash 游戏当时已经风光不再。那时候人们在逐渐转向手机游戏、平板电脑这类移动端。2010 年,乔布斯宣布苹果手机不再使用 Flash ,原因是影响手机性能。因为 Flash 安全漏洞频发,BBC 发表一篇报道名叫《 Flash 还能活多久?》。BBC 话音刚落, Adobe 就宣布放弃 Flash 项目,改用 Animate 来制作专业动画。

多米尼克回忆自己那段经历时说:We could have succeeded but needed to move faster: if I had my time again, I would have relocated to The Valley very soon after the company started growing to raise money faster and gain access to a bigger pool of experienced gaming executives. 要是我们动作再快点,就能成功:如果在公司开始快速发展时赶紧融资,然后搬到硅谷,吸纳更多经验丰富的游戏高管。

工程师出身的企业家,企业家出身的工程师

虽说游戏业务日渐萧条,但在硅谷,一种陌生却强大的吸引力击中了他,多米尼克感到脑海中那片灵感的死水泛起了涟漪,很快。涟漪变成了翻滚的波浪。

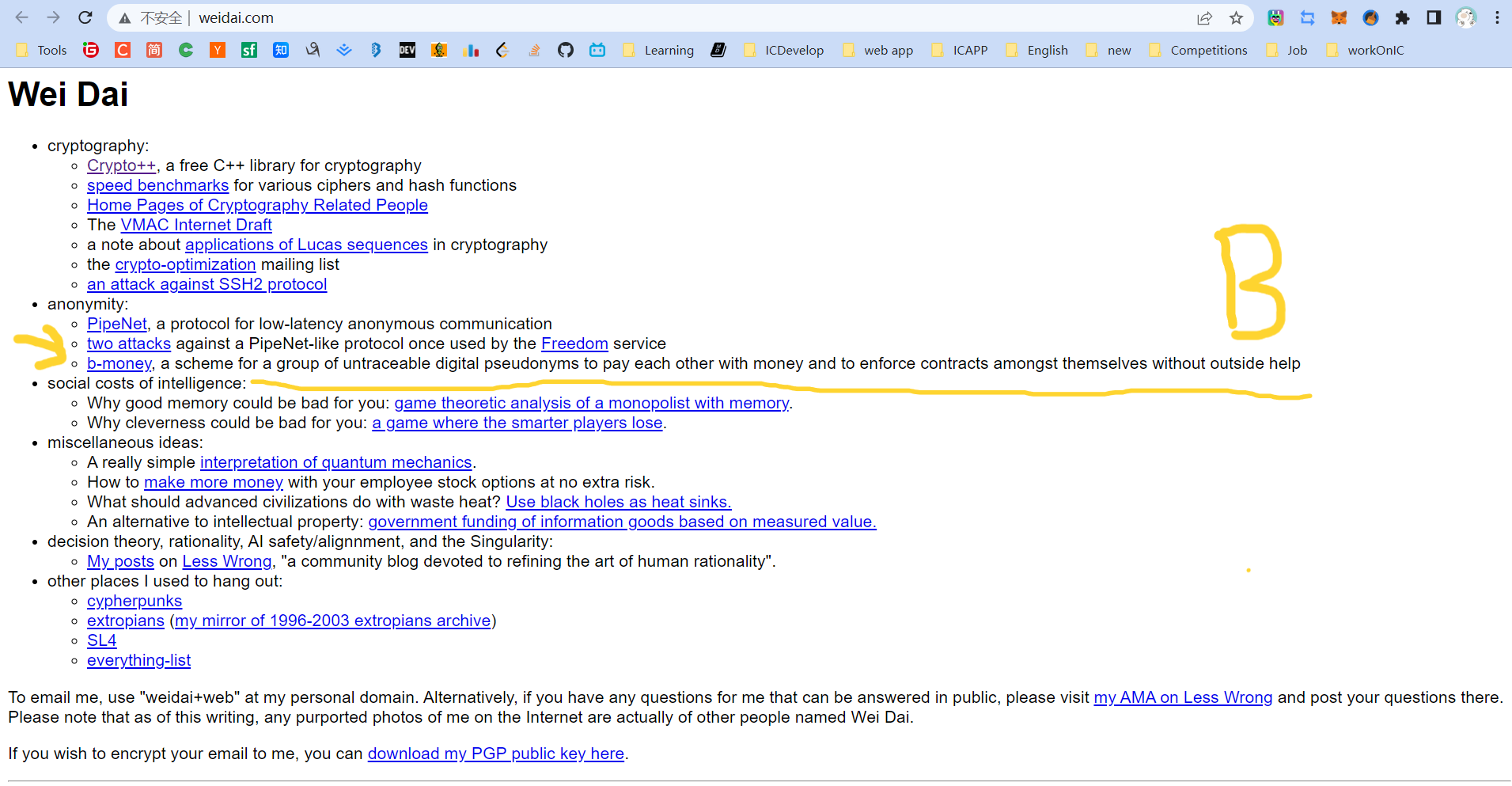

时间倒回到 1998 年,多米尼克当时在伦敦的创业公司开发一个在线存储系统时,用 Wei Dai 的 Crypto++ 库做了很多事情。在 Wei Dai 的网站里,多米尼克发现了一篇关于 “ B-money ” 的文章,这当然是比特币的先驱之一。

多米尼克没有想到来自 98 年遇到的那篇文章,点燃了比特币这颗火种,并在多年之后串联起了他往后十年加密生涯的时间线。

在 2013 年多米尼克离开 Fight My Monster 之后,因为多年以前尘封心底的 “ B-money ” 迷上了比特币。

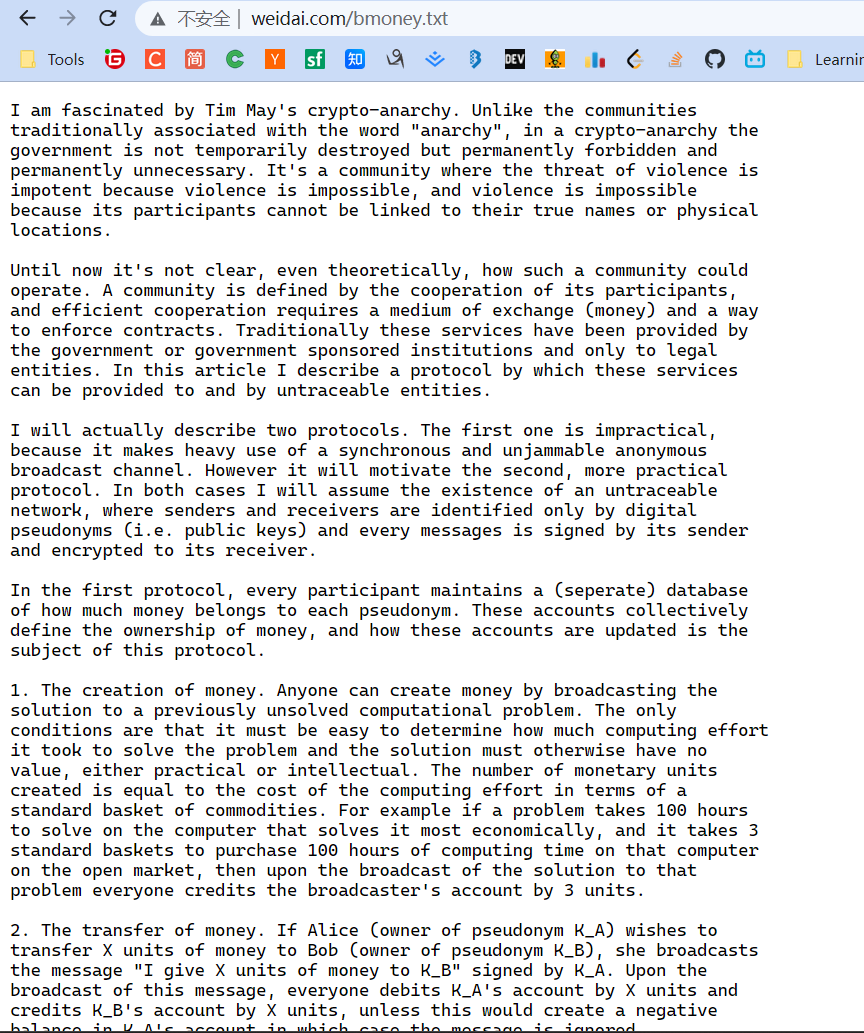

Wei Dai 在 B-money 里写道:

我对 Tim May 的加密无政府主义非常着迷。与传统上 “ 无政府主义 ” 的意思不同。在加密无政府主义中,政府不是暂时 “ 消失 ” 了,而是永远没有必要存在的。这是个人人平等的自治社区,是个没有暴力威胁的社区。因为这里利用密码学,使暴力破解从理论上就是不可能的,社区参与者的身份与他们的真实名字或物理位置没有任何关系 ......

还可以在这看看关于加密朋克的更多内容。

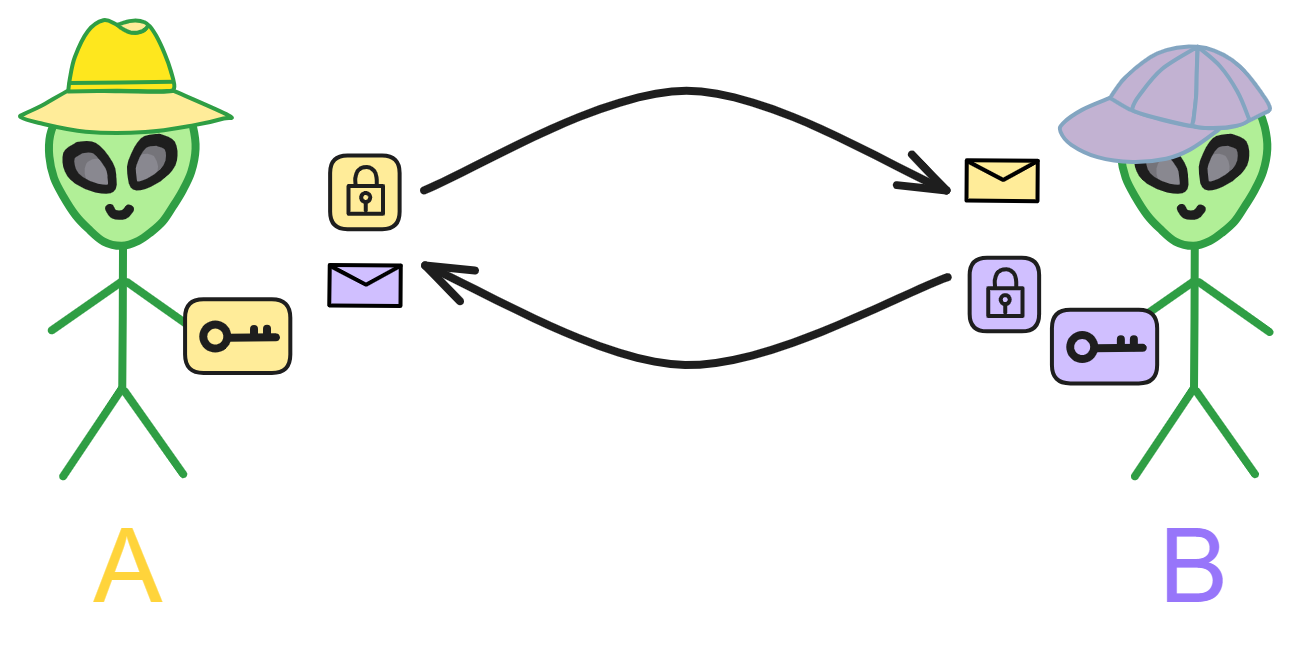

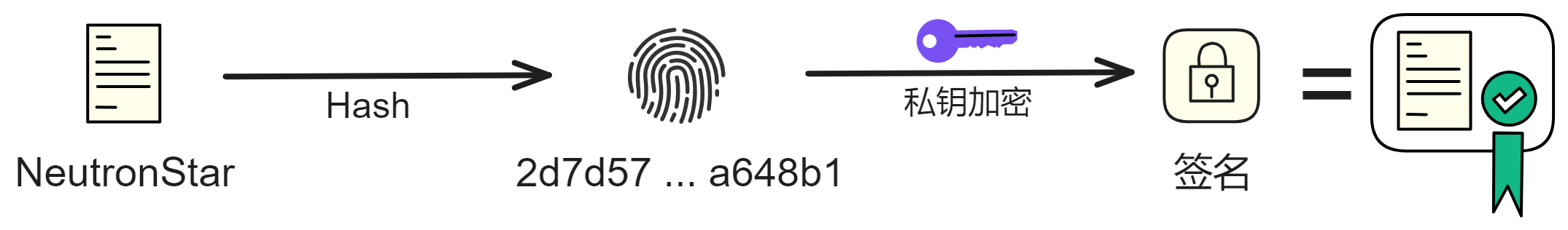

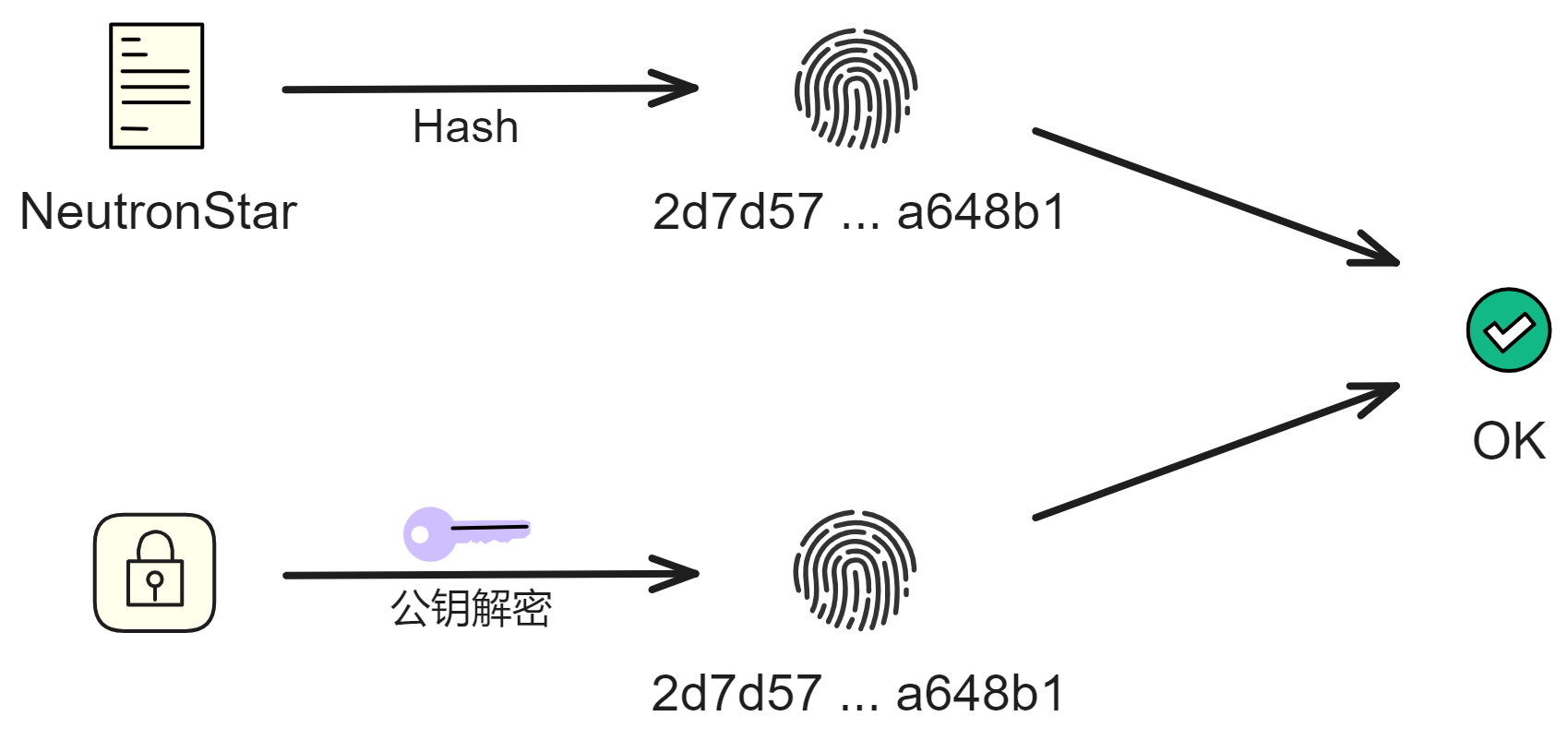

B-money 论述了一种协议,用于在匿名社区中提供货币交换和合同执行服务。 Wei Dai 首先介绍了一种不太实用的协议作为铺垫,因为它需要同步的、不可干扰的匿名广播信道。然后提出了一种实用的协议。在所有方案中,Wei Dai 假设存在一个不可追踪的网络,其中发送者和接收者仅能通过数字伪名(即公钥)识别,每条消息由发送者签名并加密给接收者。

Wei Dai 详细介绍了货币的创造、怎么发送、怎么防止双花、广播交易信息、让服务器们达成一致 ......

从 Wei Dai 的网站可以看出,他仍在密码朋克社区活跃。最近更新日期是 2021 年 1 月 10 日。

多米尼克说:“ 我喜欢算法和分布式计算,大学时就在这方面获得了很多奖项。更重要的是,我之前从未遇到过这样一个技术领域,它结合了金融、法律、政治、经济和哲学的思考,同时也有望推动世界做出重大变革。对我来说,这个新兴领域是梦想成真。我做出了一个更大的人生决定,将我的职业生涯重新投入到这个领域。”

2013 年,多米尼克开始全职炒币,顺便埋头学习一点共识算法的基础知识🤣😉。他感兴趣的是如何设计更快的共识机制,以与权益证明(PoS)架构配合使用。

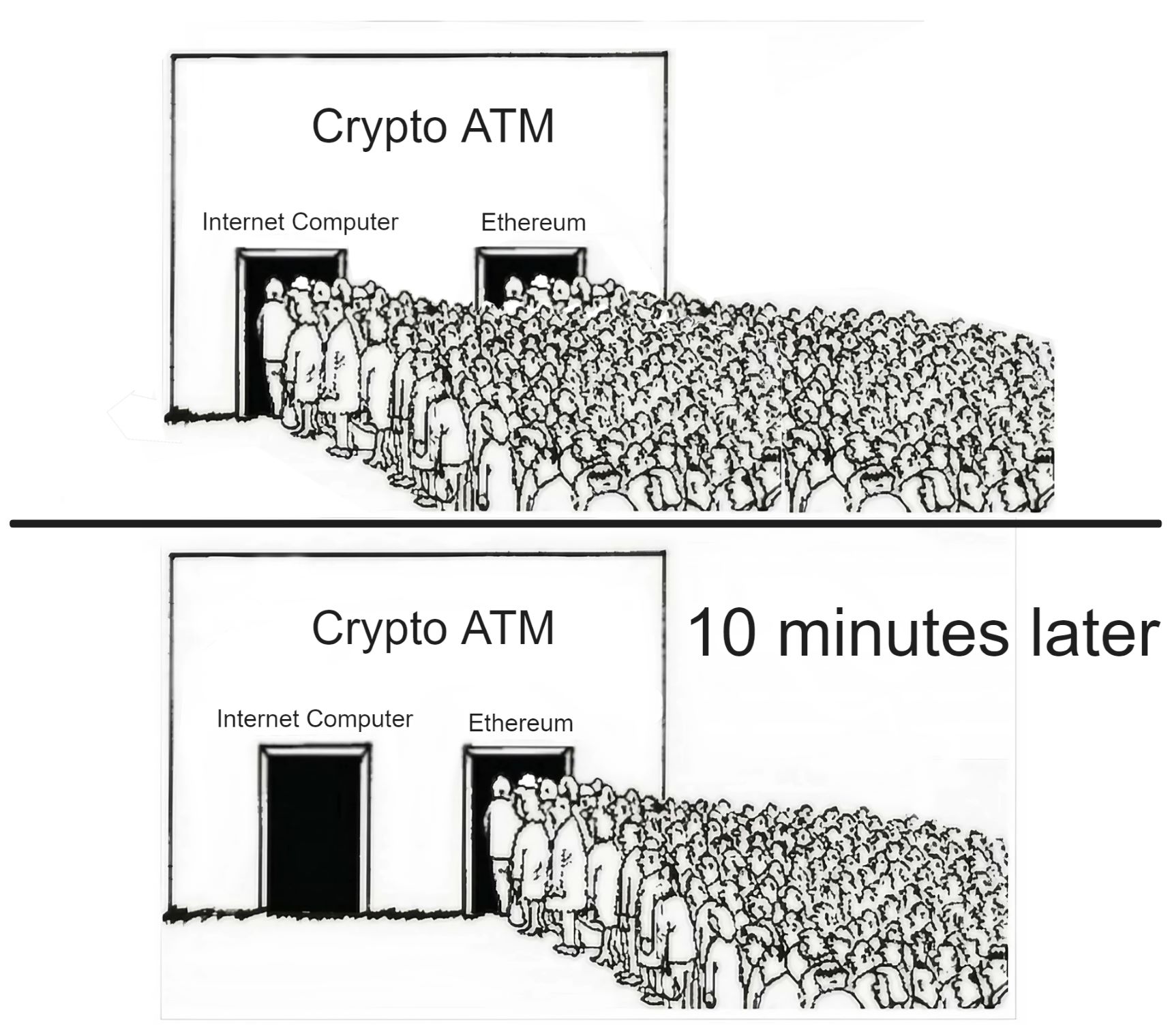

多米尼克 2014 年的 “ 比特币 ATM 之吻 ” 。

2 月 7 号,全球最大的比特币交易所门头沟宣布破产。多米尼克发推特表示心爱的比特币跌了,心痛。

比特币暴跌至 666 美元。

他沉下心来,深入研究传统的拜占庭容错,再结合之前积累的制作在线游戏的经验。多米尼克构思了一种像 Cassandra 那样能横向扩展的去中心化网络 —— 可以让越来越多的服务器加入并保持高性能。没过几天,多米尼克发表了一篇论文,描述了一种可扩展的加密货币,名为 Pebble 。论文悄悄在狭小加密圈里流传开,那是首个描述去中心化分片的系统。在这个系统中,每个分片都使用异步拜占庭共识算法来达成协议。

学习之余,多米尼克不忘炒币。投资比特币给他带来不少安稳觉,现在他能安心设计共识算法了。至少再也不用日夜兼程、手忙脚乱地工作了。

后来多米尼克融合了源于以太坊早期的使命,犹如一幅千丝万缕的织锦。受以太坊启发,在多米尼克听说 “ 世界计算机 ” 的概念之后,这成为他的终极目标 —— 他认为也许这就是未来互联网的样子。

他认识到智能合约实际上是一种崭新的、极其先进的软件形式。他意识到如果能突破性能和扩展性的局限,那么无疑几乎所有东西终将在区块链之上重构。因为智能合约运行在开放的公共网络,优于私有基础设施,它们天生防篡改、势不可挡,可以在一个网络中互联,使每个合约同时成为多个系统的组成部分,提供非同寻常的网络效应,并可以自治运行,继承区块链的特性等等。

其中的大部分细节早已随着时间的不断推移,而隐去在岁月的长河之中 —— 虽然并未过去多久,但在区块链日新月异的变革进化中,这段时间仿佛已经历了一生的波澜壮阔。

多米尼克的研究重点是在协议和密码学上,这些协议和密码学如同一把干柴,重新燃起造梦家内心的小火苗。多米尼克相信这些协议和加密算法可以改变世界。他取了去中心化(Decentralized)的 “ D ” 和无限(Infinity)的 “ finity ” ,组合在一起成为 “ Dfinity ” 。Dfinity 旨在创造一个具有无限规模的去中心化应用程序基础设施。

多米尼克从中国回到加州山景城后发推特说:China Loves Blockchain :) 。

和以太坊一样,多米尼克也在中国融到了投资。原因很简单,硅谷很早就把资金投入了比特币,并获得了巨额回报,他们不怎么关心 “ 山寨币 ” (世俗观点认为,除比特币之外的币都是 “ 山寨币 ” ,即基本模仿比特币、稍稍改进过的币)。

接下来我得好好介绍介绍 Dfinity 团队到底是干啥的了。

点. 线. 面. 体!

我们知道比特币是区块链的先驱。如果你还不了解什么是区块链,先看看这里。

比特币本身是在加密朋克(cypherpunk)对去中心化货币项目的长期追求中慢慢出现的。

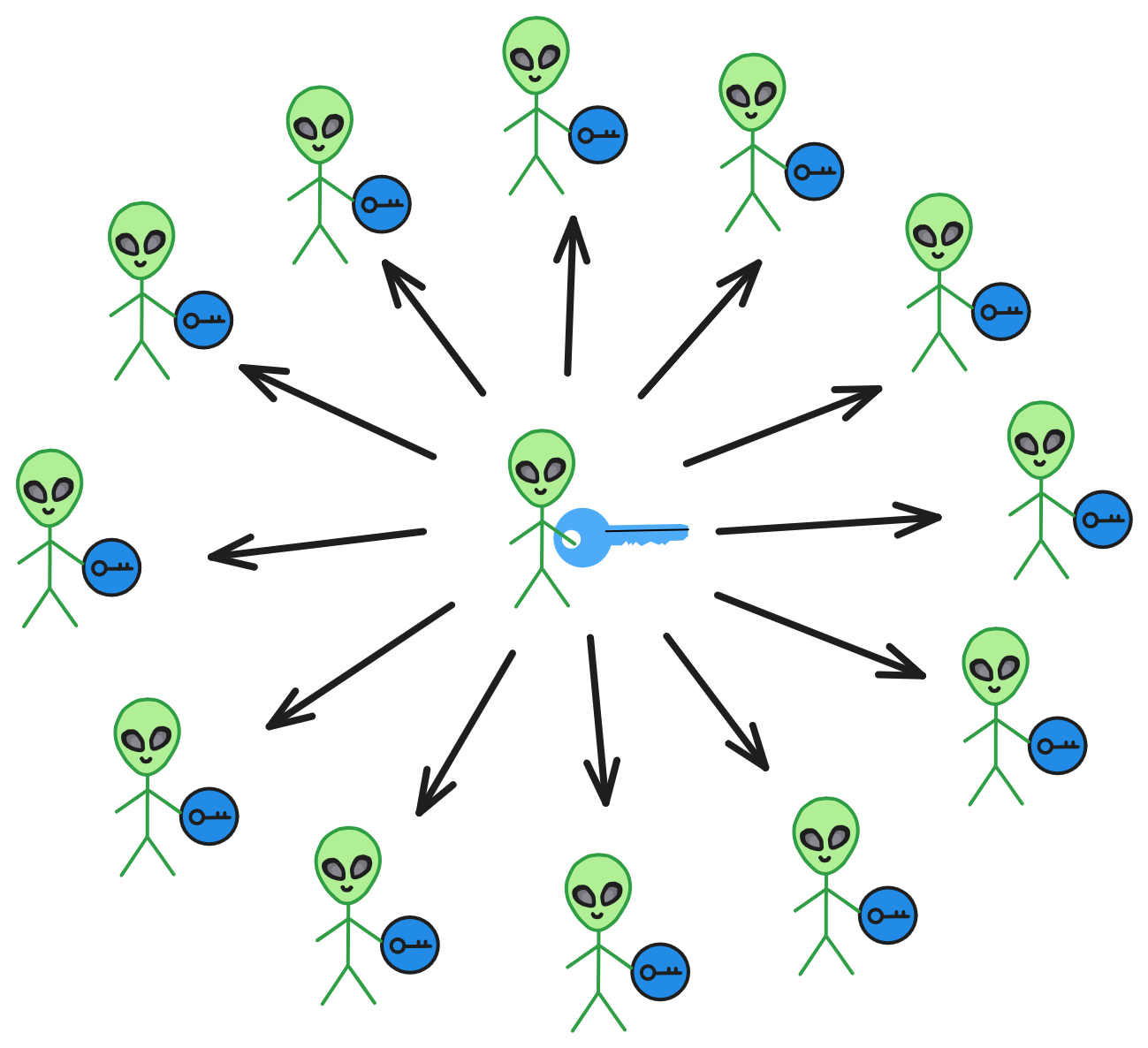

它创建了一个开放的记账系统:世界各地的人都可以随时加入或退出、靠共识算法让大家的数据保持一致、一个共创共建共享的去中心化网络。人们只要下载比特币软件(下载源代码并编译也行),然后在自己的机器上启动运行就可以加入比特币网络。比特币会让全球的电脑达成一致,共同记录每一笔转账交易。有大家的记录,便有了传说中区块链 “ 不可篡改 ” 的特性,实际上就是少数服从多数,没法跟所有人耍赖。

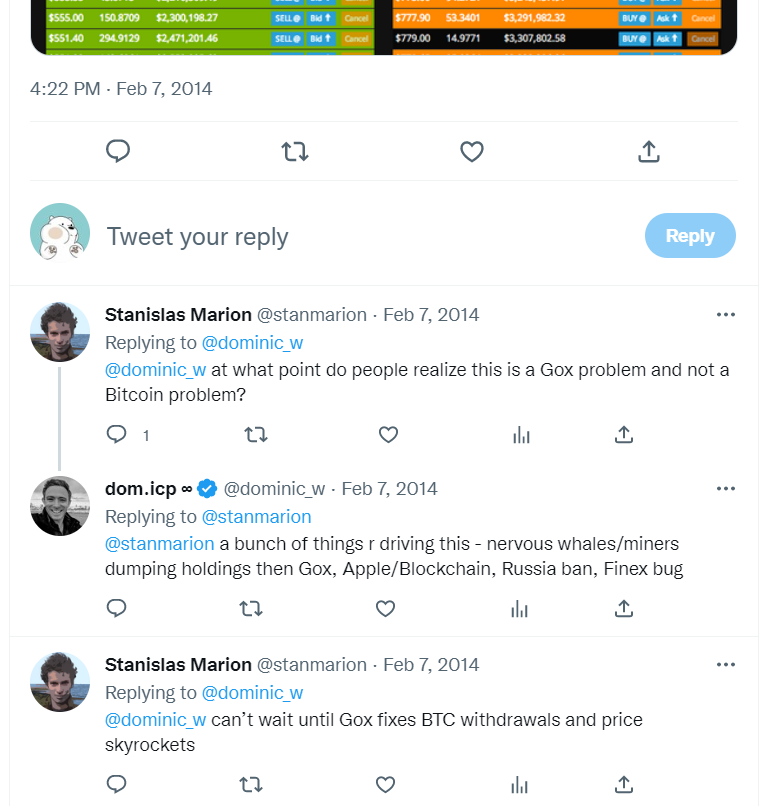

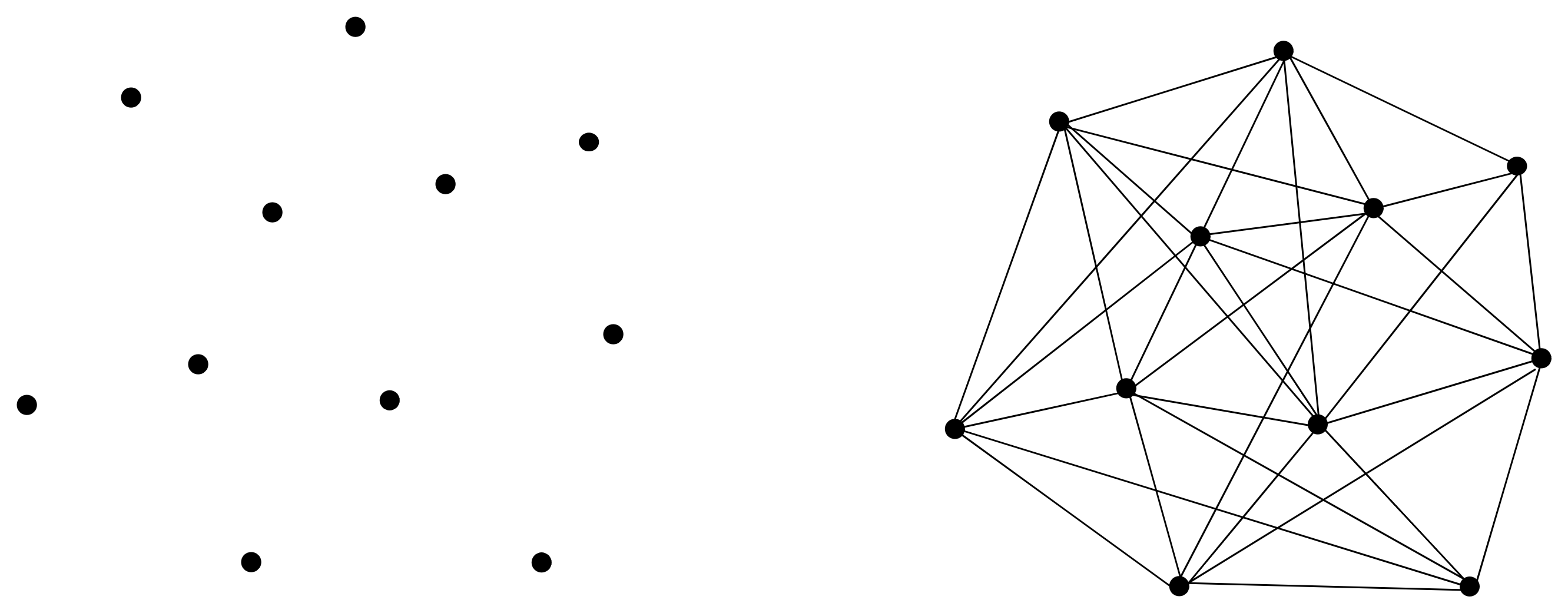

在传统网络架构中,不分青红皂白,用户数据被一股脑塞进服务器里。用户不是真正拥有自己的数据,因为谁控制着服务器谁说了算。如果我们可以把这种一对多的关系看成 “ 点 ” ,星罗棋布,分散在世界各地。用户的数据流进一个个点里,乐此不疲。

那么比特币网络就可以看成 “ 线 ” ,它把孤立的点串联成线,使互联网向更公平更开放发展。比特币做的是把世界各地的电脑组合在一起,形成一个庞大的 “ 世界账本 ” 。那如果想换一种功能,记点别的东西怎么办?模仿比特币重新做一个!

在比特币诞生 6 年后,一个可以在去中心化网络上部署软件的 “ 面 ” 慢慢崭露头角,它叫以太坊。以太坊不是模仿比特币的世界账本。以太坊创造了一个共享、通用的虚拟 “ 世界计算机 ” ,每个人的电脑里运行着以太坊的虚拟机。它与比特币账本一样不可破坏、不可篡改。大家都可以编写软件部署在虚拟机里,只要交一点以太币给矿工就行。(现在已经没矿工了)

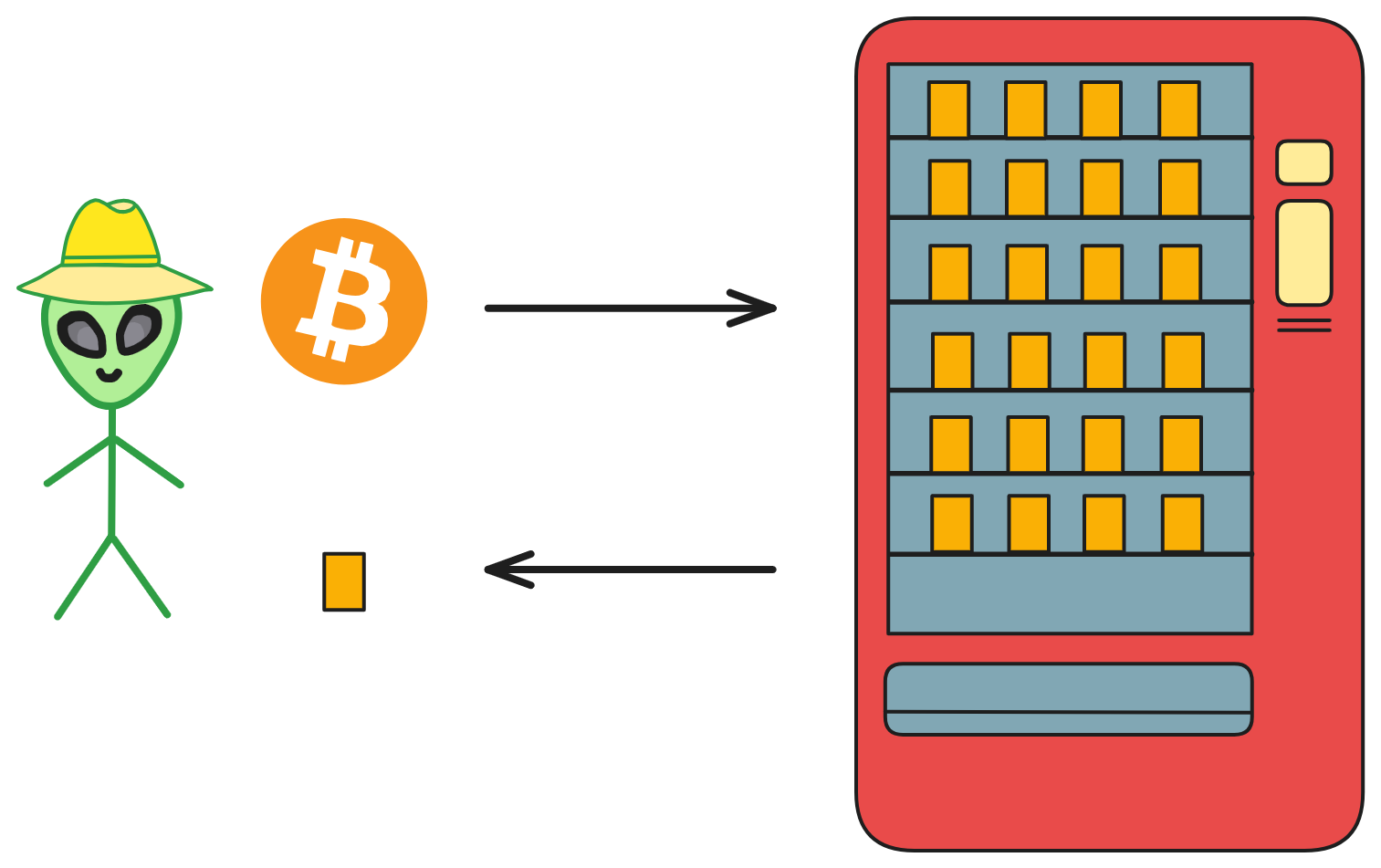

部署上链的软件化身自动售卖机,永久存储在这个分布式去中心化网络中,公平公正的判断每一笔交易是否达到条件。加上区块链永久存储的特性,便有了 “ 代码即法律 ” 一说。在这里,软件有另一个名字: “ 智能合约 ” 。

不过,咳咳,打断一下。想法很美好,现实也很残酷。早期以太坊社区中确实有实现 “ 世界计算机 ” 的想法,建立一个分布在世界各地的去中心化基础设施。但是以太坊的架构有一些局限性,使得它执行交易的性能较低、ETH 涨价导致高 Gas 费、扩展性不佳、不能大量存储数据等等。

多米尼克满怀期待地希望自己的研究成果能为以太坊项目所用。他的工作出发点并非图财,而是对分布式计算长久以来的热情,已升华为对区块链的无限向往,让他难以想象还有任何事物能超越眼前的激情与决心。很快他便成为了以太坊圈子里中的熟面孔,经常在各种会议里讨论在下一代区块链中,应用新密码学与分布式计算协议的种种可能。

一种解决方法是在原来的基础上改进:把以太坊的共识由 PoW 转为 PoS(Casper)、构建分片链(Shard)或者侧链;另一种解决方法就是推倒重来:重新设计一种可以高速处理信息、大规模存储数据的架构。

不断改进、扩容、兼容以太坊的老架构,还是从头开始设计一个真正的 “ 世界计算机 ” ?

当时,人们虽对他的想法抱有兴趣,但积重难返的是,他的设想过于复杂且遥不可及,花多少时间都难以实现、困难重重。即使后来以太坊没有采纳多米尼克的想法,但他仍然感谢像 Vitalik 和 Joe Lubin 这样的以太坊早期成员,在许多初期讨论中耐心倾听了他的想法。

最后,多米尼克做了个困难重重的决定,选择从头开始设计一个真正的 “ 世界计算机 ” 。

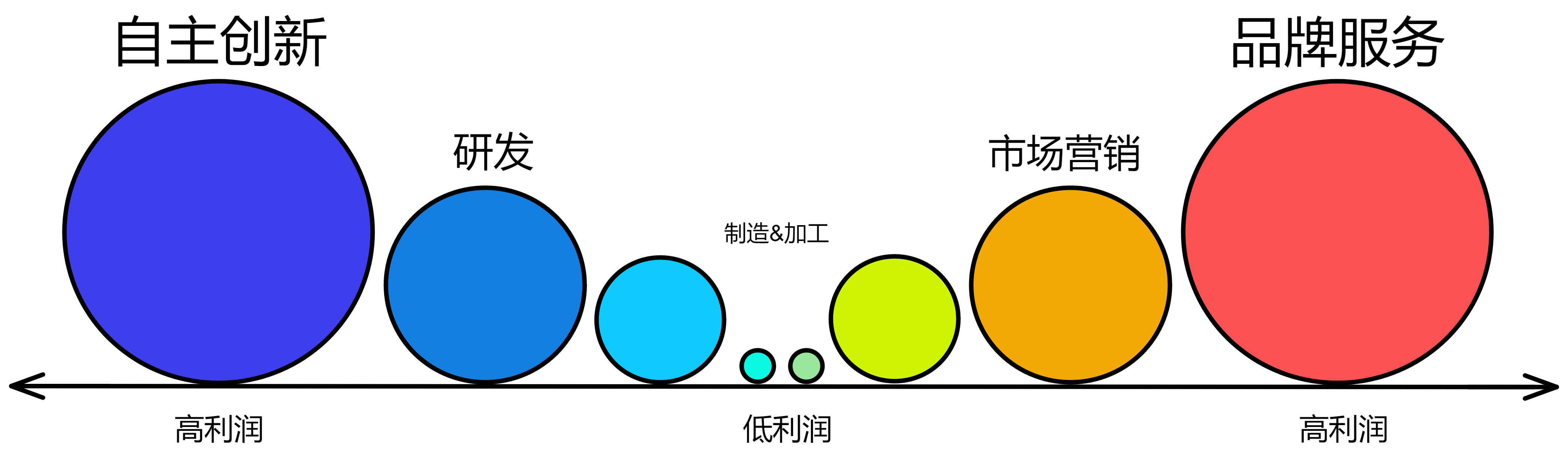

当我们试图解决一个特定问题时,最终常常发现关键在于创建强大的 “ 工具 ” 。有个更先进实用的工具,并不断维护和改进,逐渐变成更加强大的工具,能解决很多有价值的问题。一个普遍的商业现象是,为了实现某个产品或服务,开发了一种工具,后来发现这个工具有更广泛的适用性,然后工具本身演变成了更大、更成功、估值更高的产品。

亚马逊的云服务最初是为了解决黑色星期五之后的计算资源浪费问题,后来成为全球最早、最大的云服务提供商。同样,SpaceX 解决了火箭发射成本过高的问题。多米尼克为了彻底解决扩展性的问题,决心重新设计共识算法和架构。

机会终于来了。2015 年 11 月,伦敦。

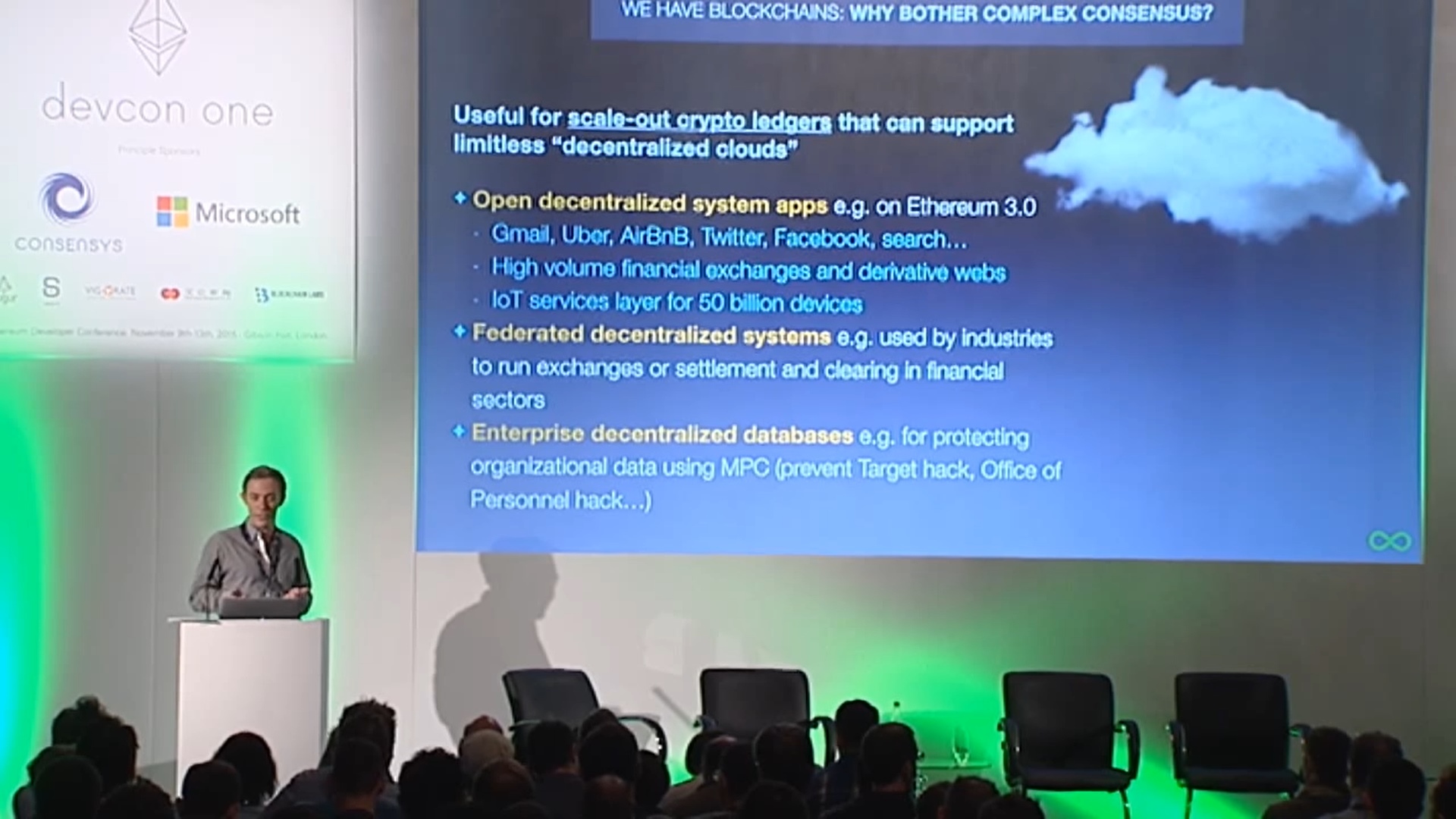

多米尼克在 devcon one 上讲述了他研究的共识算法。

现在我们可以从多米尼克当年 devcon one 的演讲 PPT 中看到,他将 IC 描述为 Ethereum 3.0 。实际上称为区块链 3.0 也不为过。如果比特币和以太坊叫 “ 区块链 1.0 ” 和 “ 区块链 2.0 ” 的话。他想创造 “ 体 ” ,一个真正的世界计算机,连项目的名字都叫互联网计算机(Internet Computer ,简称 IC)。在 “ 面 ” 的基础上承载大规模应用,可以 “ 横向扩展 ” 无限扩容的 “ 世界计算机 ” 。

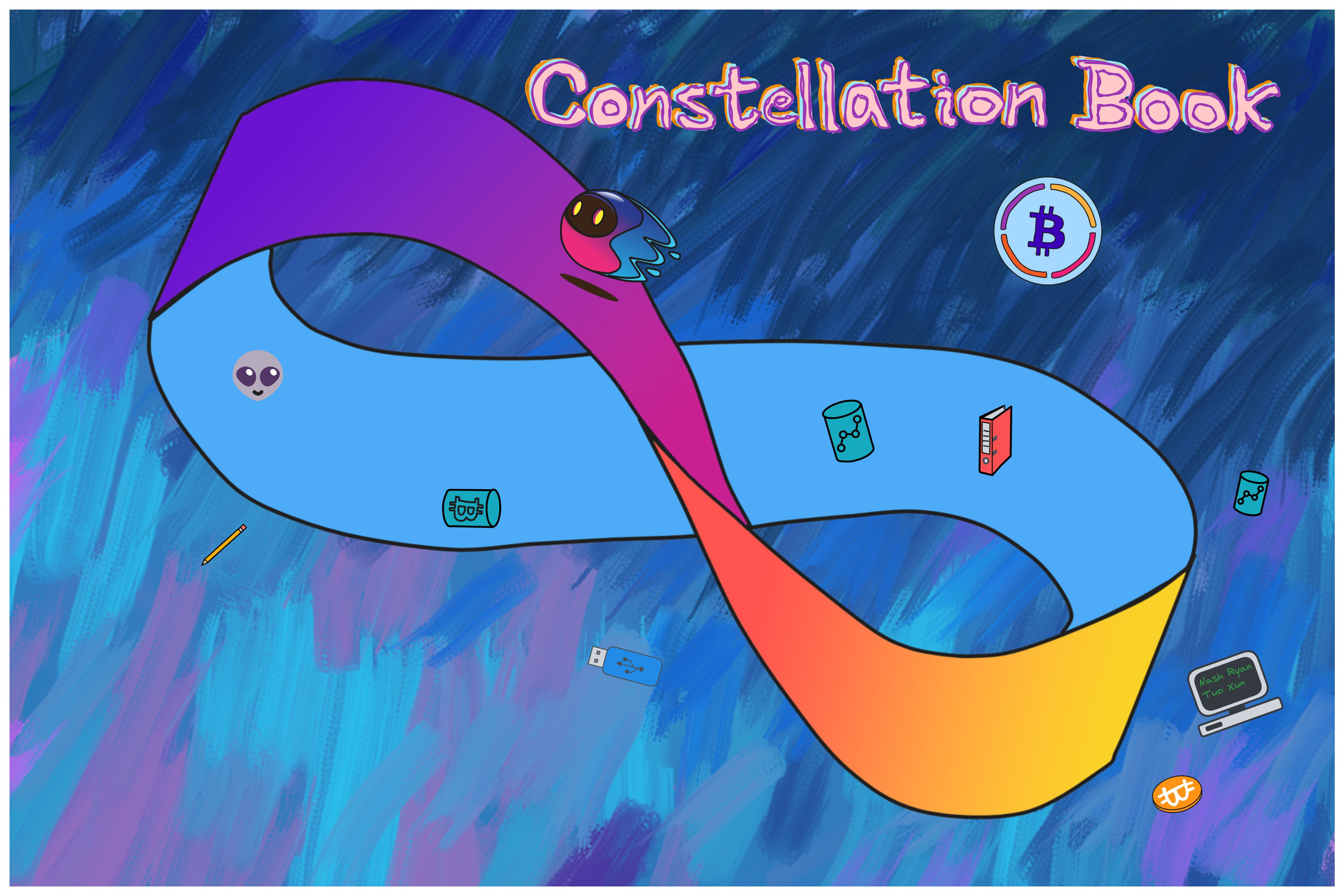

不是,放错图了。下面这个是 IC 。

交谈中多米尼克发现,之前坚决拥护比特币的顽固派对以太坊的概念非常感兴趣。这使他更坚定地相信可信计算(Trusted Computing)的前景。

这是比以太坊更宏伟的目标。多米尼克希望做一个由服务器组成的公共网络,提供 “ 去中心化的云 ” —— 一个可信计算平台。软件在去中心化云上部署运行。

多米尼克做的是重塑一个完全去中心化的基础设施,也可以理解为下一代互联网基础设施,还可以理解为结合区块链的去中心化可信计算平台😉。所有能在区块链上跑的都将由区块链来跑,包括 Web 。建立一个以互联网服务为核心的去中心化社会系统。

简单来说,就是:

传统防御系统:主要由防火墙、入侵检测、病毒防范等组成。传统网络安全的原理是被动防御,往往都是 “ 救治于后 ” ,例如当应用出现病毒,就要借助杀毒软件查杀。而此时企业或多或少已经产生了损失。

可信计算:基于密码的运算与防护并存的安全技术,保证全程可检测可监控。可信计算的原理是主动出击。由于整个链路从应用、操作系统还是硬件,必须经过验证。这就大大降低了病毒、网络攻击的概率。

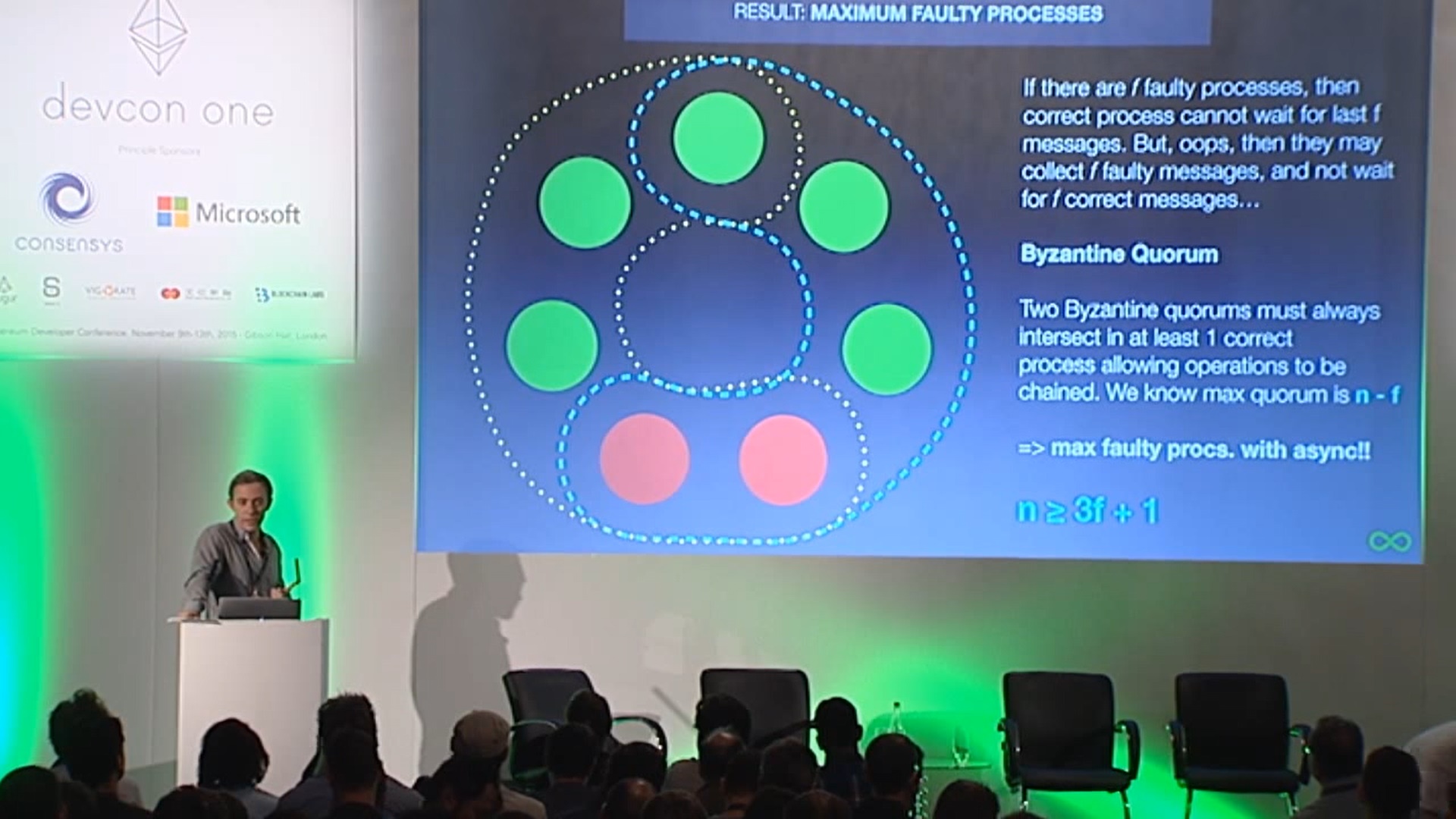

区块链都有一个叫共识算法的东西。他负责协调网络中的节点。共识算法可以在网络中让大家的信息达成一致,因为这是一个所有人随时随地都可以加入或退出的网络,而且不知道有哪个节点会故意捣乱。有了共识算法,网络中即使存在三分之一的捣乱节点,其他的节点也照样能正常达成共识。(不同共识算法的抵抗能力不一样)

而去中心化平台不止涉及代币之间的转账交易,还涉及用共识算法建立起一道屏障,把不怀好意的家伙隔离在外面。然而效率与去中心化不可兼得,很难建立一个完全去中心化的系统:既要保护正常的节点们达成共识,又要在一堆节点之间协调、同步数据。多米尼克需要把可信计算和区块链融合在一起,让世界各地的服务器形成一个无限、开放、高性能、强一致性、可扩展、可以大量储存数据的区块链网络,不再需要防火墙保护。

对多米尼克来说,未来区块链就是互联网,互联网就是区块链。互联网不再是简单的把机房服务器之间连接到用户,而是先又世界各地的服务器组成一个可信、安全的区块链网络,然后再在上面部署 Dapp ,服务用户。多米尼克希望银行金融、共享经济(例如 Uber)、社交网络、电子邮件和搜索引擎之类的东西都能转移到这样的网络上。

从现在来看,当年以太坊没采纳多米尼克的意见是对的。因为以太坊当时专注于工作量证明(PoW)的同时也在探索使用权益证明(PoS)的升级路径。他当初描绘的蓝图太过远大,没法在有限的时间内实现。要实现他的构想,需要一个非常庞大且出色的团队经过不懈努力、研究出新的密码学技术等等。

2016 年秋天,多米尼克宣布自己以 “ 去中心化冒险家 ” 的身份回归。理论搭建完成,造梦家的冒险之旅,正式开启!

Dfinity !

IC 为了实现 “ 世界计算机 ” 的想法,重新设计了区块链架构,研发了更高效的共识,并配套创新的密码学组合。目标是解决传统区块链架构中速度、效率和扩展的限制。

多米尼克左手忙着和技术团队搞研究,右手写团队战略规划,嘴巴还得去各种区块链论坛介绍项目。

这些年来,多米尼克已经与其他区块链团队分享了许多关键密码学技术,比如 VRF 的应用,现在已经有很多知名项目用了(比如 Chainlink 等等)。💡

2017 年 2 月,多米尼克和 V 神以及众多大佬的圆桌论坛。Vitalik Buterin (左一),多米尼克(左二),Timo Hanke(右一)。

Ben Lynn (左二 / 红色短袖)正在演示一种屌炸天的技术:阈值中继(Threshold Relay)。它可以大幅提升区块链的性能,快速生成区块🪄。

顺便提一嘴,工程师 Timo Hanke (左三 / 中间)之前是亚琛工业大学的数学和密码学教授。2013 年创建了 AsicBoost ,将比特币开采的效率提高 20 - 30 % ,现在已成为大规模挖矿作业的标准。

Ben Lynn 是 BLS 签名算法的创造者之一。他的 “ L ” 就是 BLS 中间那个 “ L ” ,BLS 来自三位创造者的名字首字母。从斯坦福博士毕业后他在 Google 工作了 10 年,在 2017 年 5 月加入 Dfinity 。如果你没听说过 BLS 算法,那你一定读过早些年 Ben Lynn 火遍全网的 《Git 魔法》。

2021 不是平凡的一年。

5 月 10 日,IC 主网上线。

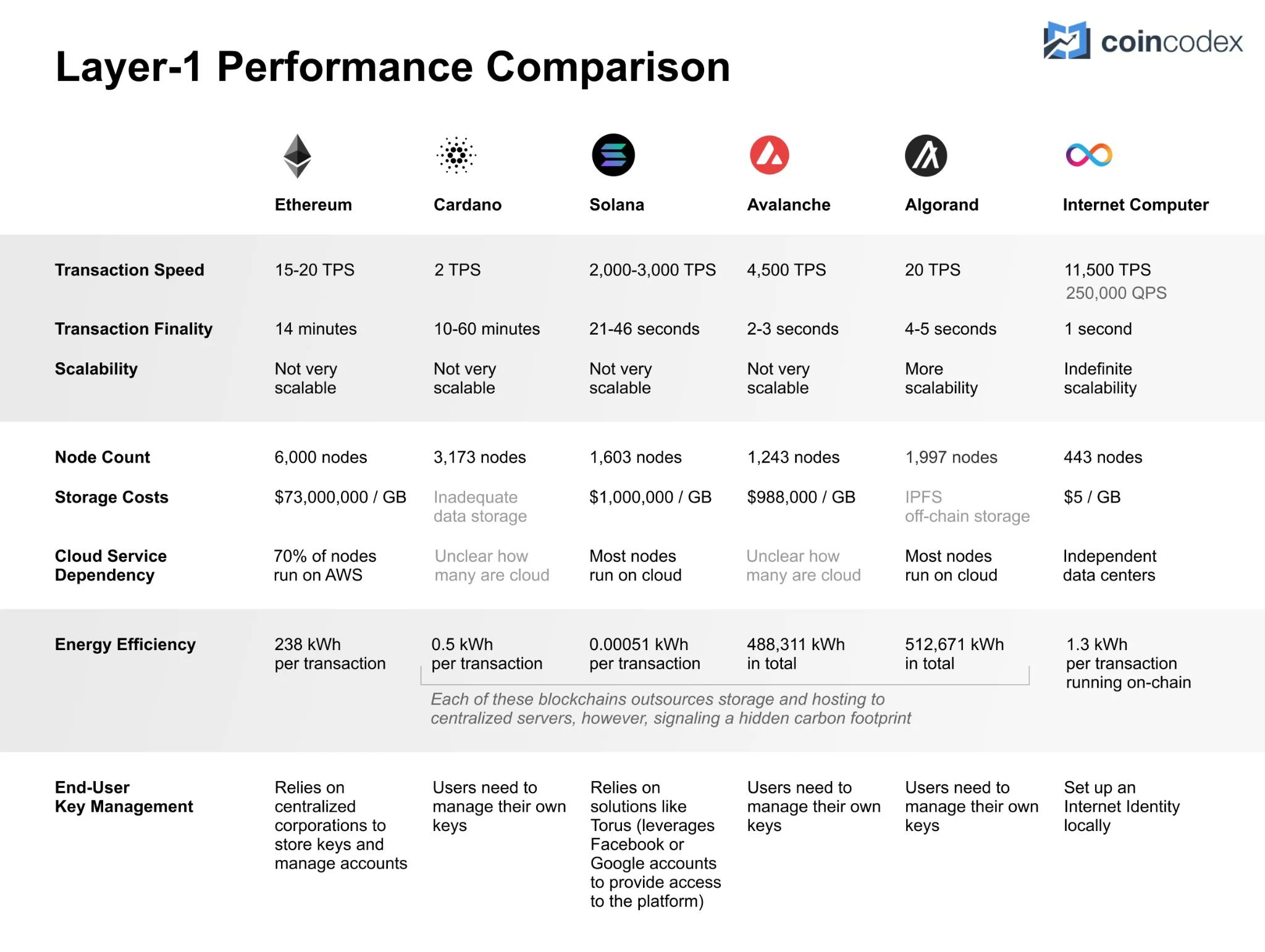

上图展示了对比其他区块链的性能、存储数据费用和能耗。

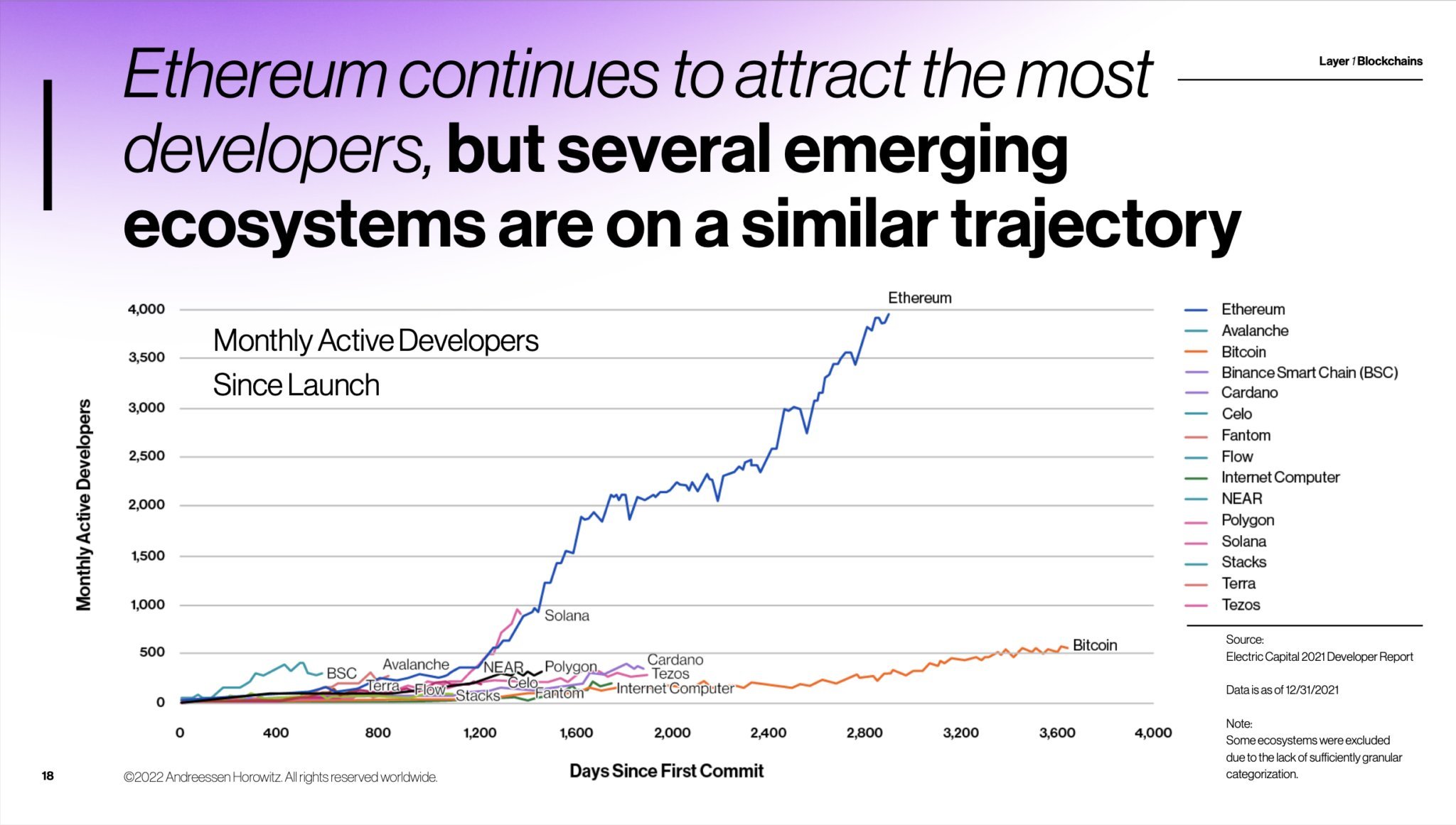

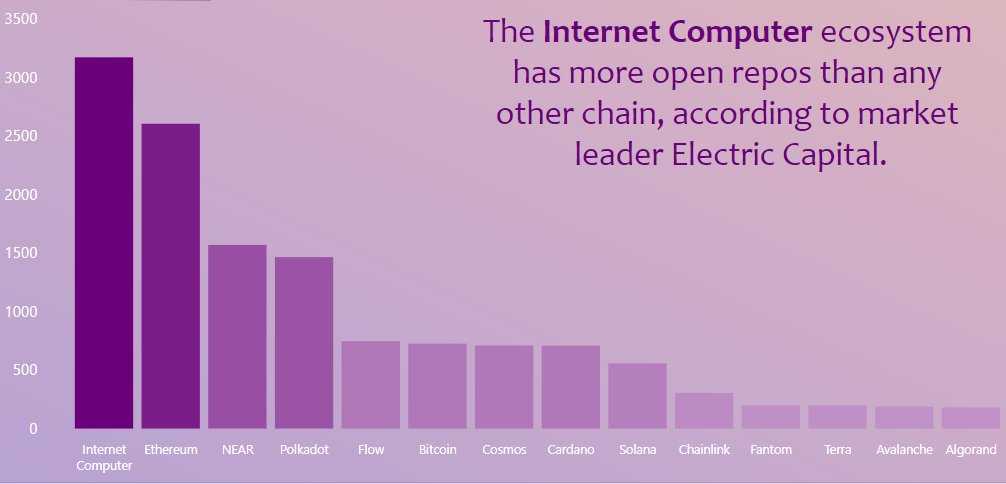

IC 主网上线时,已经有超过 4000 名活跃的开发者了。下图是对比其他区块链的开发者增长图。

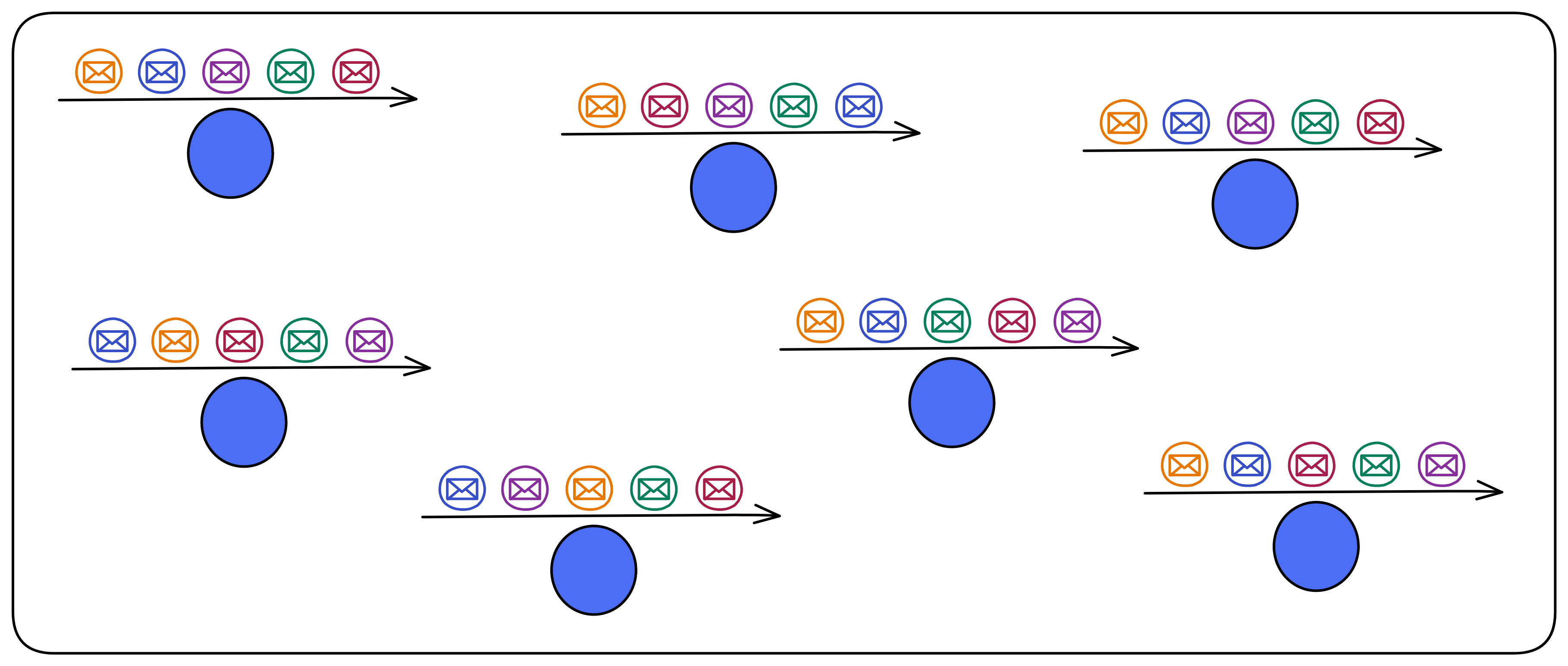

IC 有许多创新,比如可以无限横向扩展,通过 Chain Key 赋予了 IC 网络可以无限扩容的能力。由一个 DAO —— 网络神经元系统(Network Nervous System,NNS)管理网络的拆分和组合。所以这就需要一个不同寻常的共识算法了, IC 的共识只对消息排序,让副本按照相同的顺序执行消息。依靠 BLS 阈值签名算法和非交互分布式密钥生成(DKG)产生的随机数选择谁出块,共识速度很快。也就使得 IC 有了更高的 TPS ,做到了毫秒级查询、秒级更新数据,Dapp 的使用体验相对其他公链丝滑不少。

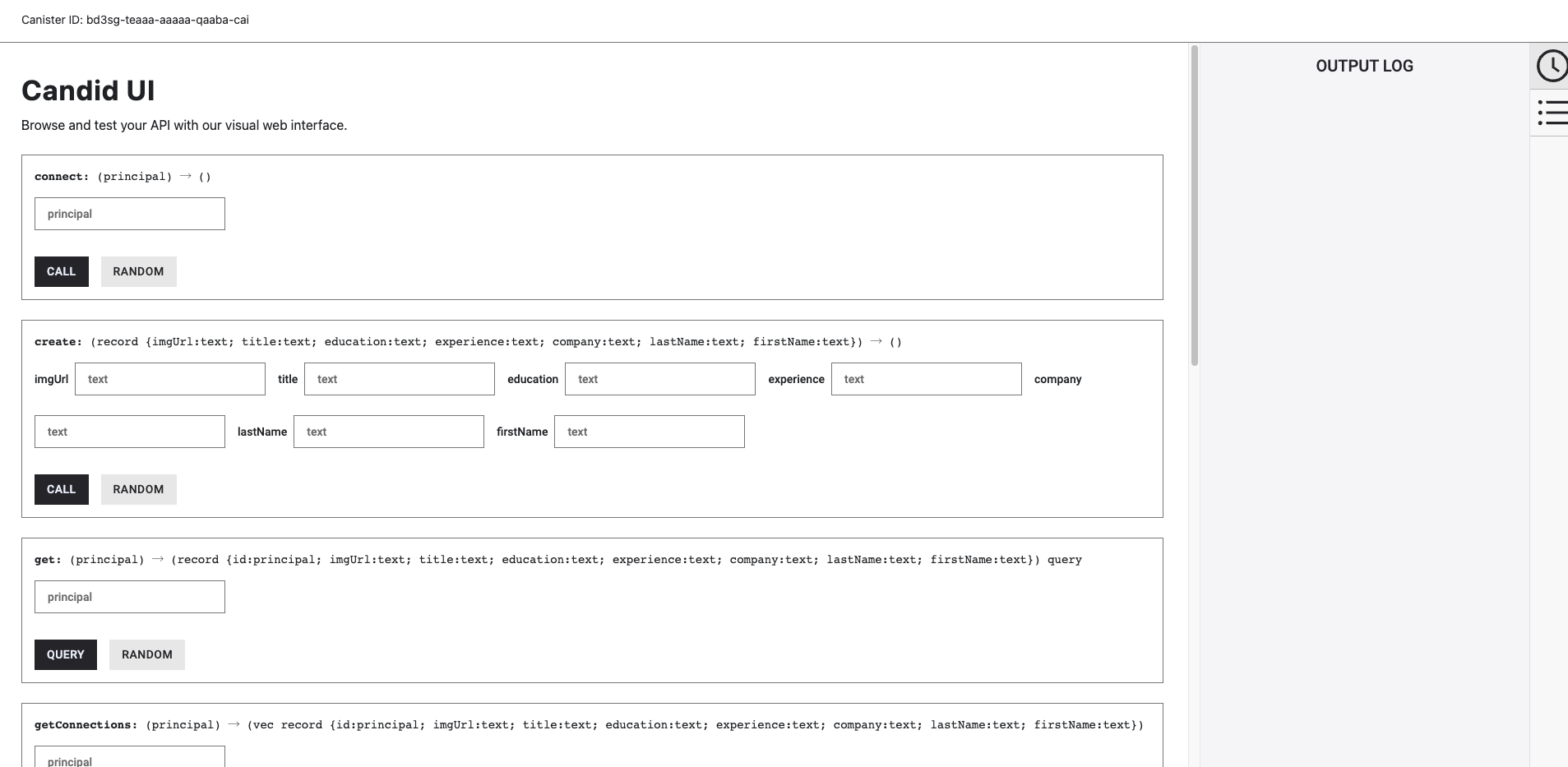

IC 的目标是去中心化的云服务,为了能让 Dapp 全栈部署上链,所有 Dapp 都安装在一个虚拟化容器里。IC 上的 “ Canister ” 相当于以太坊的智能合约,Canister 里可以存储数据,部署代码。并且开发者可以通过后端虚拟容器自动生成的 Candid UI 进行测试,不用一行代码。客户端直接通过 https 访问部署在 IC 上的前端页面以及智能合约。虚拟容器就像小型服务器一样,给每个 Dapp 提供了自己的链上存储空间,还能支持从智能合约直接调用外部的 https 服务器,无需预言机。这是区块链历史上第一次实现了智能合约能够直接与外部的 https 服务器进行通信,并在智能合约进一步处理消息后做出响应。以太坊和特币一样,也接受了 “ 代码即法律 ” 的范式。这也就意味着没有任何治理来规范平台的使用或底层网络本身,IC 的 “ 智能合约 ” Canister 不是不变的,它可以保存数据并更新代码。

也是历史上第一次在底层通过密码学直接集成了比特币和以太坊(不是跨链桥):IC 在协议层面与比特币直接集成。IC 上的 Canister 能直接在比特币网络上接收、持有和发送比特币。也就是说,Canister 可以像用户的钱包一样持有比特币。Canister 能够通过阈值 ECDSA 的 Chain Key 签名协议安全持有和使用 ECDSA 密钥。相当于赋予了比特币智能合约的功能!

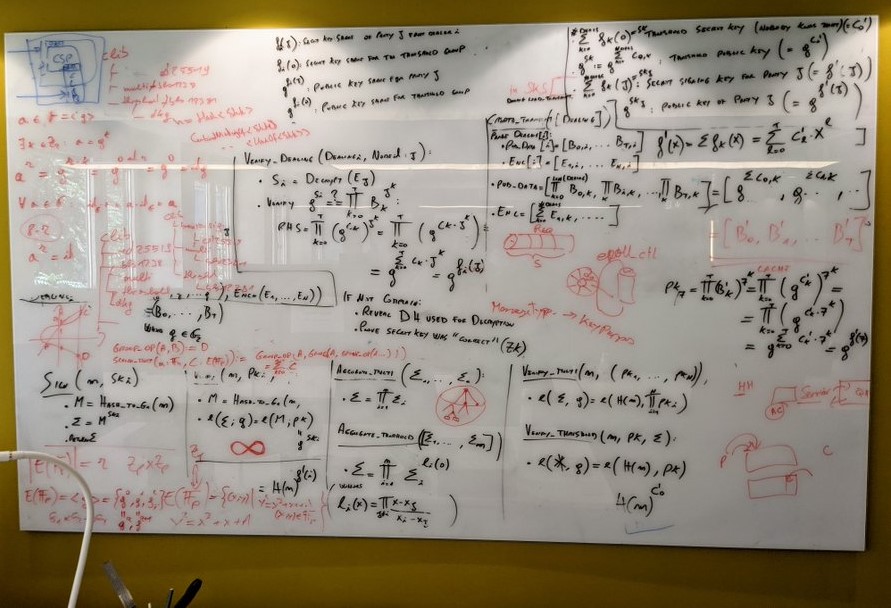

苏黎世办公室演算集成比特币的白板。👇

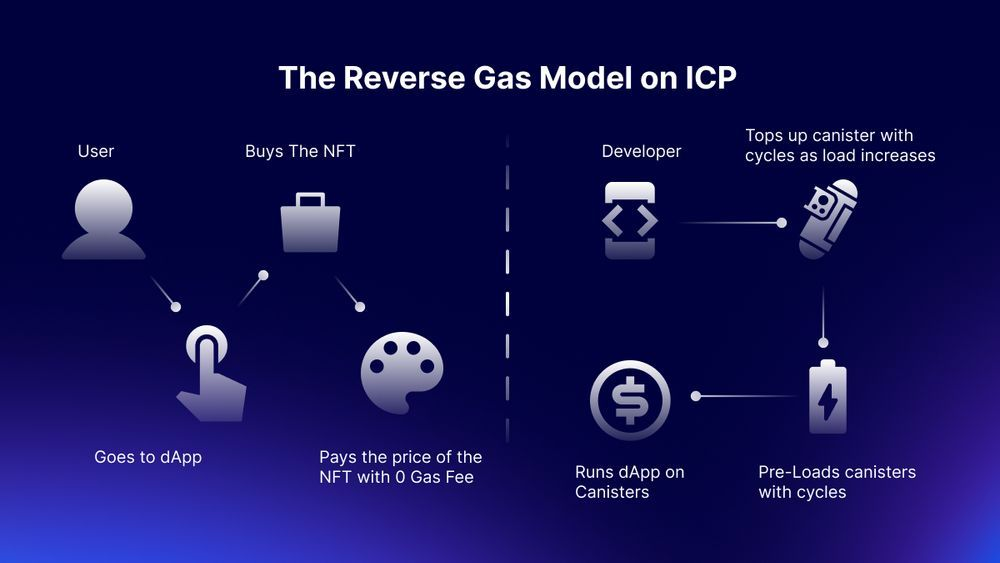

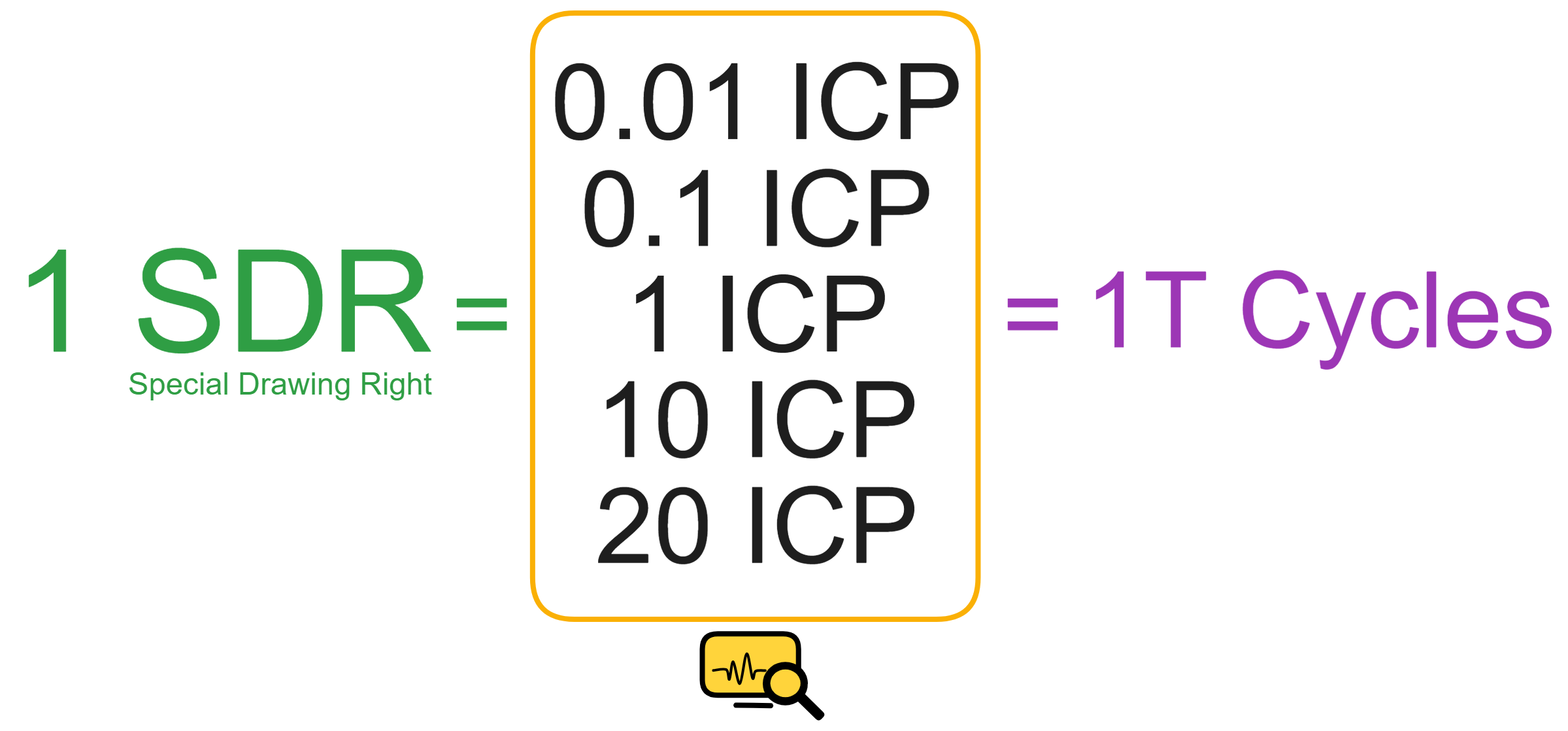

既然数据都存在链上,那就要有足够低的 Gas 费:1 G 1 年 5 美元!Gas 光低还不够,为了用户能无门槛使用 Dapp ,IC 使用了反向 Gas 费模型,Gas 由开发团队支付。Dfinity 团队还把 Gas 锚定 SDR ,变成了不随币价波动的 稳定的 Gas 。IC 有一个统一的去中心化匿名身份:互联网身份(Internet Identity,ii),作为 Dapp 的登录入口,加入网络神经系统参与治理 ......

IC 架构和共识也是独领风骚。IC 理论上有无限高的计算和存储,只要不断加服务器节点进来就行。经过改良的共识有点像实用拜占庭,又更复杂,因为和目前已有的共识都不太一样,多米尼克给它起了个名字叫 “ PoUW ” 共识,Proof of Uesful Work 。BLS 阈值签名方案的 VRF ,产生真正不可预测的随机数,而且可以让大家都来验证这个随机数不是别人伪造的。抗女巫攻击的边缘节点,分层的架构,随机指定的出块,无需多言,就一个字,妙。

根据 GitHub 和 Electric Capital 的统计(2023),IC 拥有最活跃的开发者社区。🔝💥并且还在快速增长。

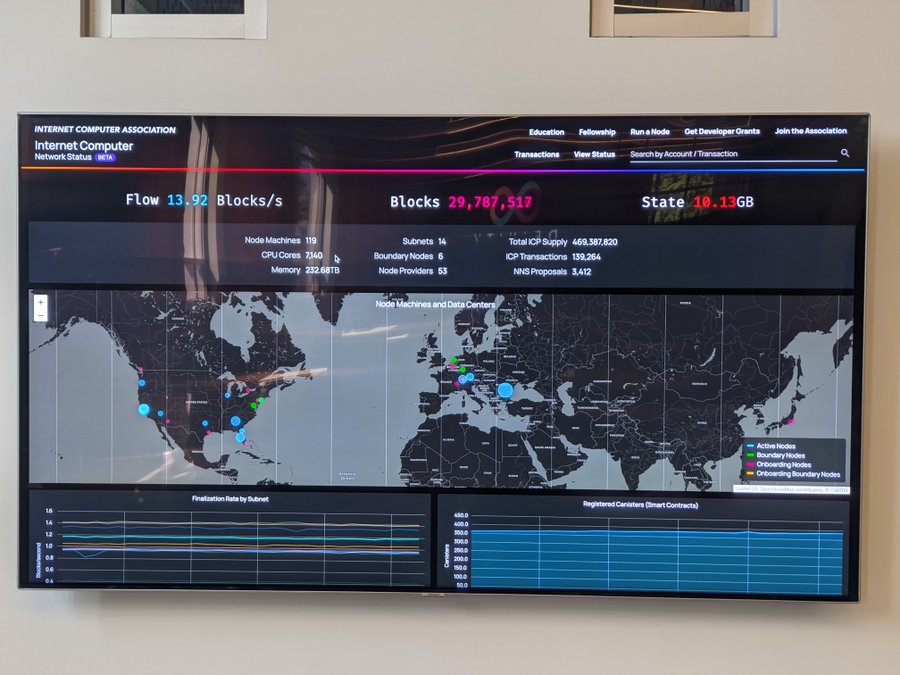

主网上线三个星期,IC 快要达到 3000 万个区块时,办公室墙上的照片。

2021 年 7 月,有许多新的 Dfinity 成员在新冠大流行期间通过视频会议面试加入团队,还从未见过面。这天一小群人来到位于苏黎世的办公室 face to face 。

多米尼克的博客里写过 Dfinity 的两方面愿景:

一方面,许多传统的垄断性技术中介,如 Uber 、eBay 、社交网络、即时通信甚至搜索引擎,可能会被重新设计为 “ 开源企业 ” ,使用自主软件,使用自己的去中心化治理系统来更新自己。

另一方面,我们希望看到企业 IT 系统的大规模重新设计,以利用区块链计算机提供的特殊属性,并大幅削减成本。最后一点是不明显的,因为区块链计算机上的计算要比亚马逊网络服务等传统云计算昂贵得多。但大幅节省成本是可能的,因为运行企业 IT 系统所涉及的绝大多数成本来自于支持人力资本,而不是计算本身,而 IC 将使创建涉及人力资本少得多的系统成为可能。

图片来自 2021 年 10 月,上海。

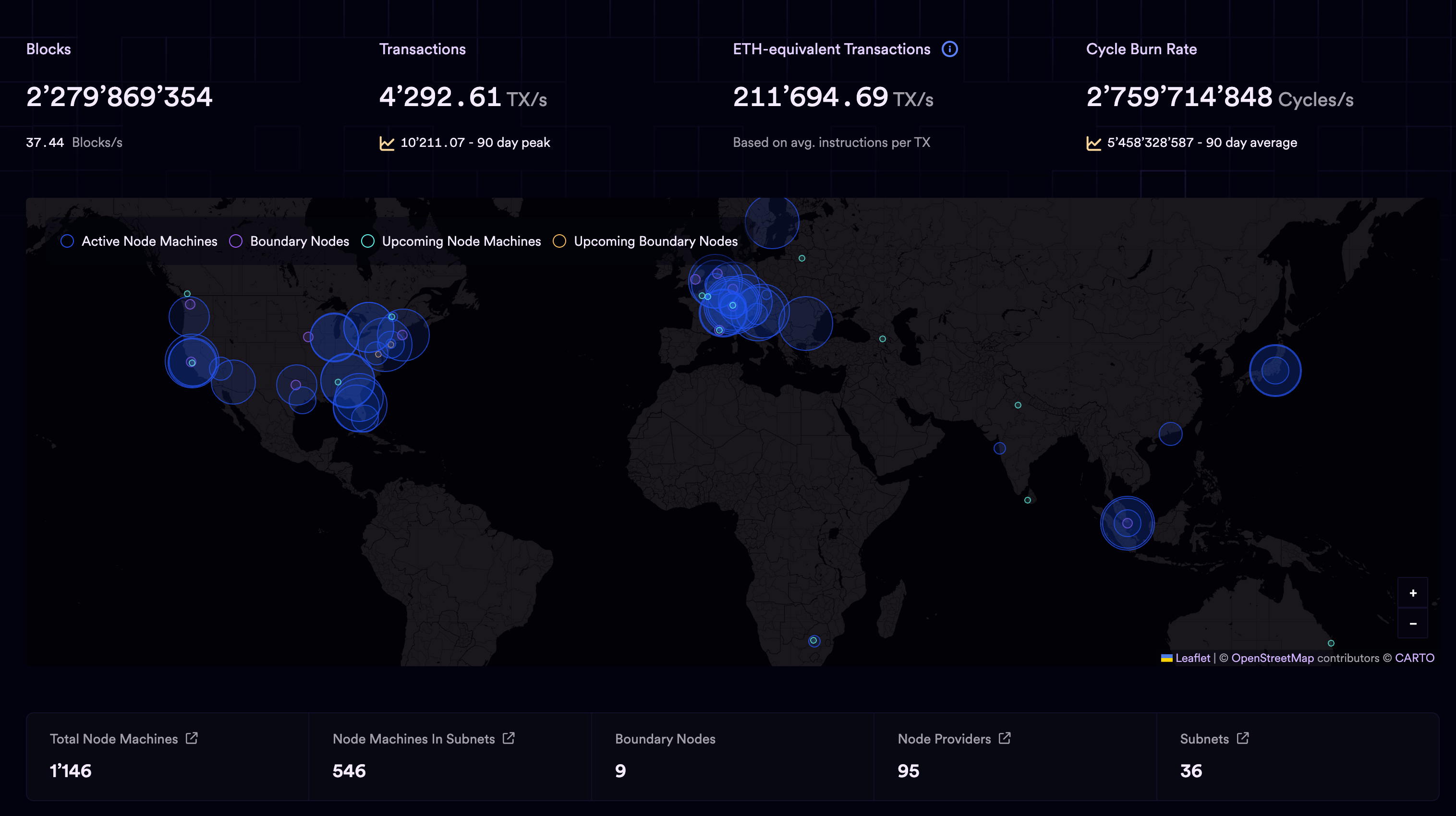

关于 IC 数据的实时统计 。

2022 年 7 月 14 日,在苏黎世的街头咖啡馆。多米尼克和他的小伙伴正在等待 IC 的第 1,000,000,000 个区块打包。

Dfinty 位于瑞士总部的新办公楼。

多米尼克离开办公室时,拍了几张食堂墙上的壁画,由才华横溢的 IC NFT 艺术家创作。

多米尼克吃着蛋糕,唱着歌,一不小心又写了几百行代码的小项目。

工作之余,吹拉弹唱一样不能少。

说了这么半天,IC 到底解决了什么问题呢?总的来说,它解决了传统区块链的 TPS 太低、扩展性太差、Dapp 仍然依赖一部分中心化服务。

比特币是一个去中心化记账本。一条链就是一个网络。

以太坊创造了去中心化计算机。也有侧链、跨链交互。

Cosmos、Polkadot 实现了区块链的可组合性和可扩展性。多链的时代,许多区块链组织在一起,链和链有交互。而且这些链有组织性的协议,可以无限扩张。

Internet Computer 打造了一个可以自动弹性扩容、超高 TPS 的去中心化云服务。全新的系统和架构,整个网络从底层到最上层都经过重新设计。

IC 是底层设计成去中心化的云服务,底层去中心化就代表部署的网站服务、智能合约不会被别人强制关掉。

上层部署的应用可以由用户自己掌控,储存自己的私人数据。也可以选择通过 DAO 来控制,变成完全去中心化的 Dapp ,社区自治。

IC 的合约是一种 Wasm 容器,类似于云服务的小型服务器,功能强大,可以直接提供计算、储存、托管网页、HTTP 外调(预言机)、WebSocket 等服务。

扩展性的关键在于接近于零的边际成本。Polkadot 的可扩展是建立在软件工程师的开发上的,而 IC 的扩展性是在底层自动完成的。使得上层做应用的团队在 IC 上开发成本降低不少。

想做出高扩展性、高性能的公链:

-

第一要在规划上就要重视扩展性和性能,方方面面的设计布局上都是以尽快实现扩展性和 TPS 为重。

-

第二是需要有信心和实力,坚持自己的路线,直到生态爆发的那一天。在此之前,需要忍受短期内其他竞争对手的打压,需要熬过长时间的现金流的压力,需要无视世俗的不理解。

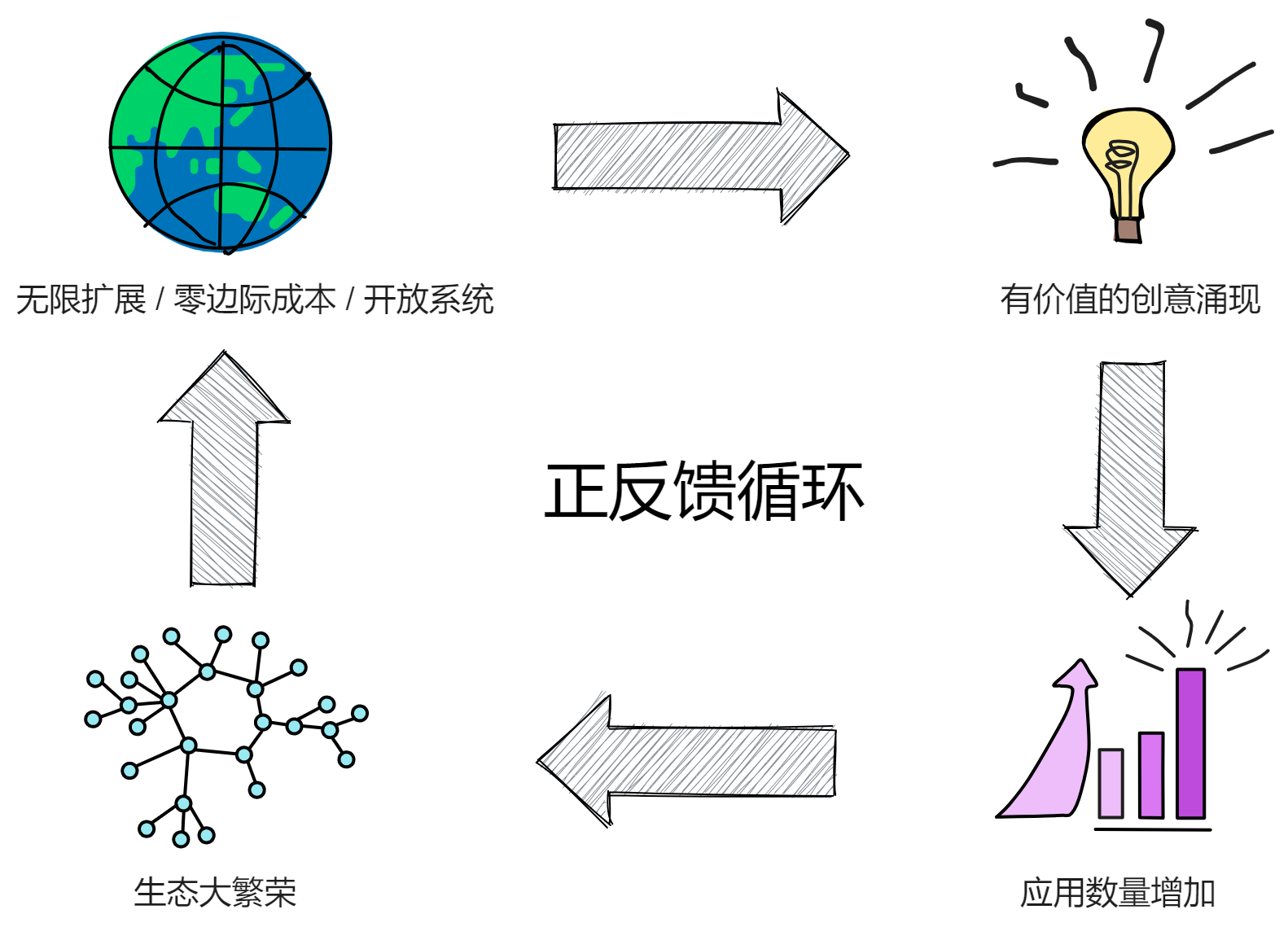

专注底层基础设施的研发,直到各种各样有创意的应用出现,使生态圈的参与者数量增加。数量的增加导致新的创意和应用进一步涌现。这样就形成正反馈循环,使生态圈不断自发的更加繁荣更加复杂化:

扩展性 / 零边际成本 / 开放系统 → 应用数量增加 → 各种连接指数倍出现 → 有价值的创意涌现 → 形成应用 → 系统复杂化 → 数量继续指数倍增加 → 正反馈循环 → 生态大繁荣。

所有的技术开发的选择都有优缺点。根据局部片面的技术优缺点,来断定谁最终会胜出,是幼稚的和危险的。最终的区块链上的赢家,将是生态系统最丰富的,开发者,软件应用,和终端用户数量最多的。

未来区块链的关键词是:零延迟,零边际成本,开放的生态,和它带来的巨大规模效应,极低的单位成本,极复杂丰富的生态。

技术革命带来的产业巨变,对于大多数普通人来说,是突然的。但在这突然的背后,是几年,甚至十几年的渐进的演变。

一旦影响产业格局的几个关键参数越过了临界点,生态进入大繁荣时期,变革是极其迅速的。其影响之深远,大多数人完全措手不及。变革结束之后,产业又进入一个长时间的新的平衡。这之后的一段时间内几乎没有竞争者能追上行业里的领导者了。

经过 2 年的发展,IC 生态系统已经涌现出许多优秀的应用。前后端全部上链,完全不依赖中心化服务的 Dapp 。

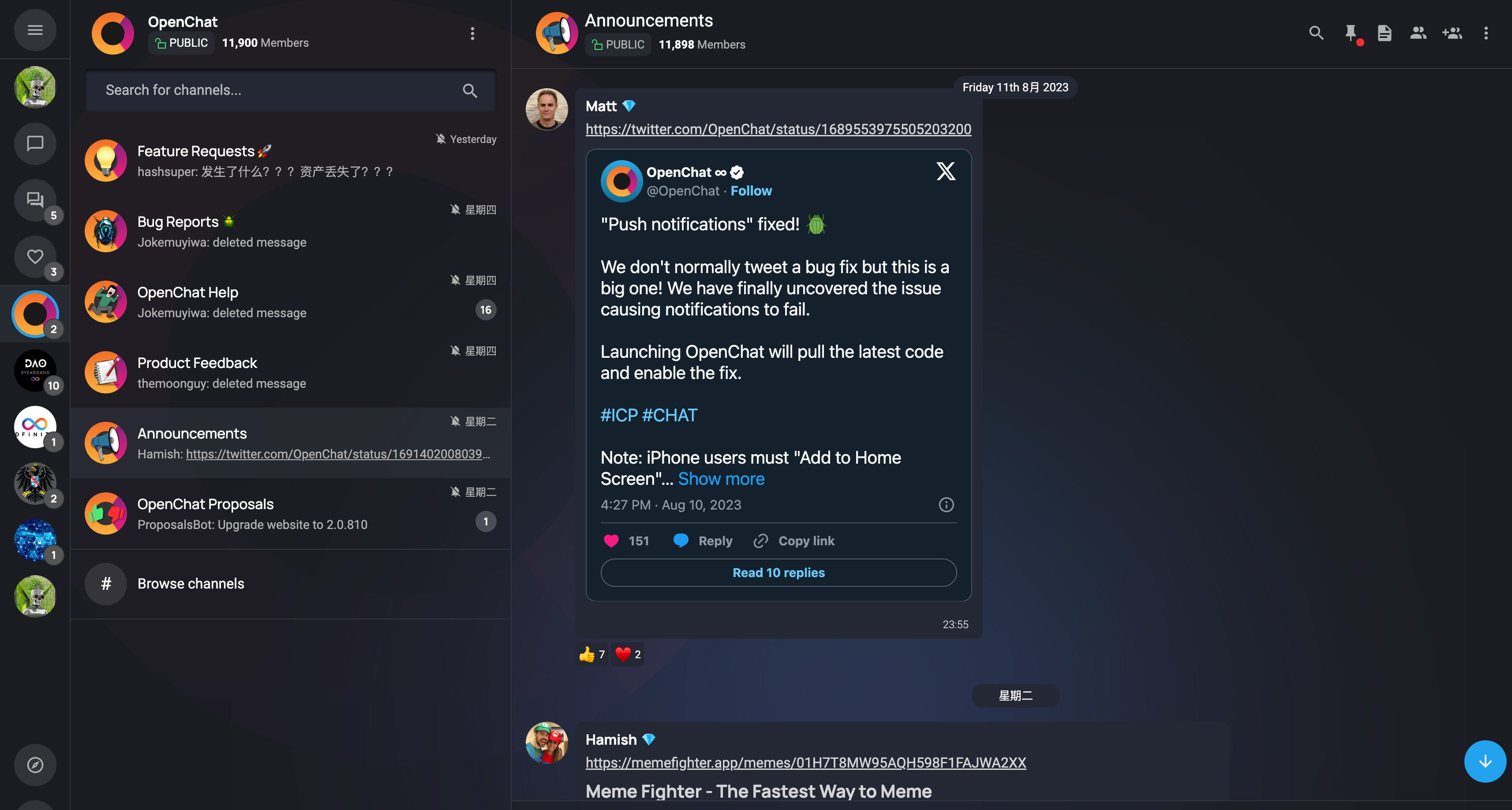

在社交类 Dapp (SocialFi)方面,有 DSCVR 、Distrikt 、Mora 、Openchat 等。DSCVR 是一个端到端的去中心化 Web3 社交媒体平台。Distrikt 是一个 Web3 微博客平台,使大家可以在去中心化网络中分享内容或参与讨论。Mora 可以给每个用户部署自己的智能合约,来存储用户的博客数据。Mora 使用户在区块链上发布博客,永久存储自己的数据。这里有关于 Mora 的更多内容。Openchat 提供了去中心化的即时通讯服务,是个去中心化的聊天 Dapp 。

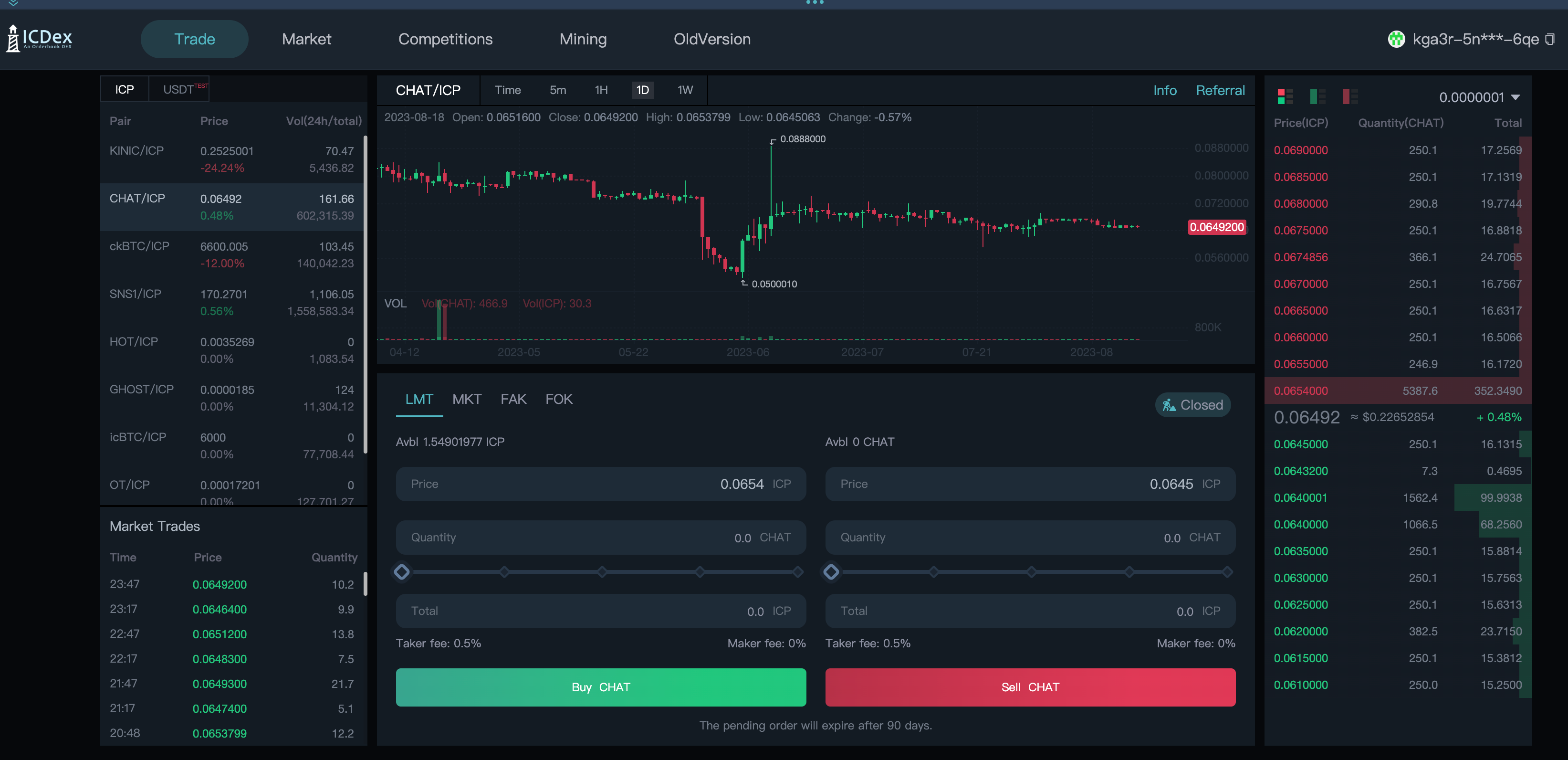

在去中心化金融(DeFi)领域,IC 生态也有一些体验很好的 Dapp : ICLightHouse 、InfinitySwap 和 ICPSwap 等应用。2022 年是中心化机构信任倒塌的一年。3AC 、Celsius 、Voyager Digital 、BlockFi 、Babel Finance 、FTX 等头部对冲基金、借贷平台和交易所,在这一年纷纷战败破产。不仅如此,DCG 灰度、Binance 币安和 Huobi 火必等巨头也深受不同程度的 FUD 之苦。中心化机构没法做到彻底透明,它们的信任依赖于创始人的声誉和公司的品牌等外在形象。而去中心化则以 " Code is law. " (法则即代码)和 " Don't trust, verify! "(不要相信,验证!)为基石。不破不立。在这个革命性的理念下,中心化的神话彻底被打破,为去中心化的未来铺平了道路。去中心化的金融服务,让用户可以进行无需中间人的借贷、交易和资产管理等操作,增强了金融系统的透明度和可访问性。

AstroX ME 钱包是一款备受关注的钱包应用。ME 钱包可以安全可靠的存储和管理数字资产,让用户能够方便地管理他们的 IC 代币和各种数字资产。

还有去中心化的 NFT 市场 Yumi 。用户可以创建、购买和交易数字艺术品,为艺术家和收藏家提供了全新的机会和市场。

IC 生态系统已经涌现出许多令人印象深刻的 Dapp ,涵盖了社交、金融、NFT 市场、AI 、元宇宙和钱包等不同领域,提供了丰富多样的体验和服务。随着 IC 生态系统的不断壮大和创新,我们期待更多优秀的应用出现。还有更多有趣的项目在官网等你发现。

瑞士现在是响当当的 “ 加密谷 ” 了,世界上很多知名区块链项目都在瑞士诞生。Dfinity 是这里第一个完全非营利性的基金会。

多米尼克组建了一支非常强大的区块链研发团队,包括密码学、计算机科学和数学教授、博士和博士后、加密货币专家、高级工程师和专业的管理人员。

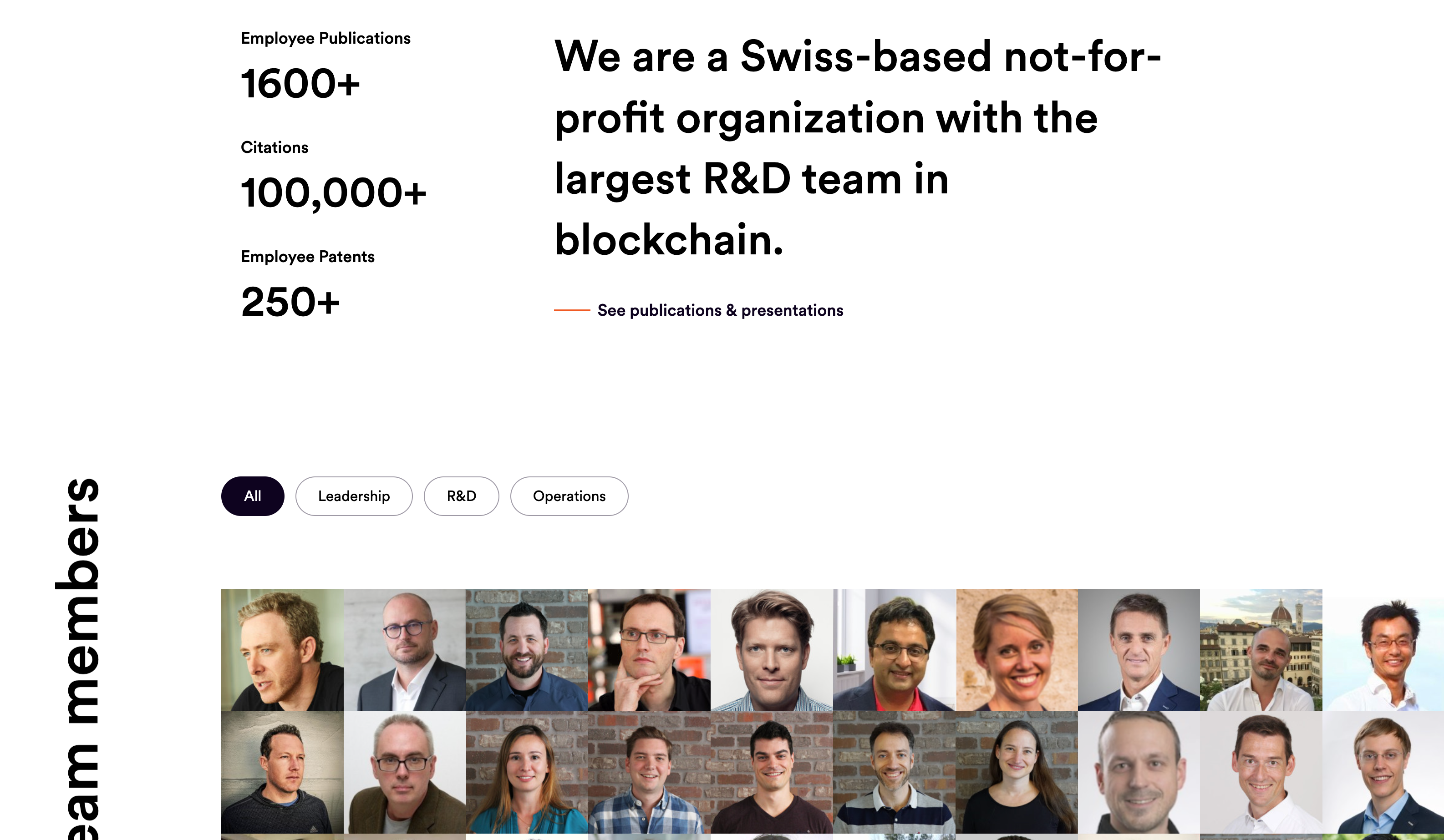

互联网计算机是顶级密码学家以及分布式系统和编程语言专家五年研发的结晶。Dfinity 目前拥有近 10 万次学术引用和 200 多项专利。

我认为未来 10 年区块链仍将是最有趣、最有影响力和发展最快的技术领域之一。🚀🚀🚀

这就是我要讲的关于多米尼克的故事了,不过,多米尼克自己的故事远未结束,甚至才刚刚开始 ......

多米尼克自己说过:Our mission is to push towards a blockchain singularity, where the majority of the world’s systems and services are created using smart contracts, and run entirely on chain, a transformation that will also take years. 我们的使命是推动区块链奇点,世界上大多数系统和服务都是使用智能合约创建的,并完全在链上运行,这一转变也需要数年时间。

@1.5x.jpg)

谁能想到,一篇来自遥远的 1998 的博客,激起了世界往后二十年波澜壮阔的 “ 加密运动 ” ,贯穿了多米尼克心中追求无限分布式的热情 ......

那,是一片新天地了。

后记

写完结尾,我察觉隐隐有些响动。簌簌簌,簌簌簌,由远及近,这时整间房变得无声无息。那声音若有若无,不知从什么地方响起,方向也搞不清楚,也许是电脑风扇,也许是窗外树枝,也许只是脑子里的幻觉。

那声音越来越清楚。那声音,听起来似乎是电脑里传来的?

我赶忙把耳朵贴到电脑主板上。不是。我又看向窗外,难道是?窗外一切正常。

那声音又来了,更清楚了,是嗞啦、嗞啦、嗞啦!没错!

忽然,时间暂停了。周围的一切都暂停了。神经元膨胀、崩裂,释放出的信息素又催化了其他的神经元,我的头不受控制的抖动起来,又突然膨胀,眼珠子大的像鼠标,耳朵拧成了麻花 ...... 那声音似乎伴随着玻璃破碎的声音,鞋底敲地的声音,鸟鸣犬吠的声音 ......

脑子闪过一道白光,很快,白光扩散成一白茫茫片。周围是蓝色的,下面有密密麻麻的方块和线条;一个点亮光突然闪耀、扩大,吞没了一切;周围还是蓝色的,下面是白色的。

现在,我什么都不记得了。

也许是梦吧。

也许是一种改变世界的东西。

就写到这里吧,该睡觉了,晚安。

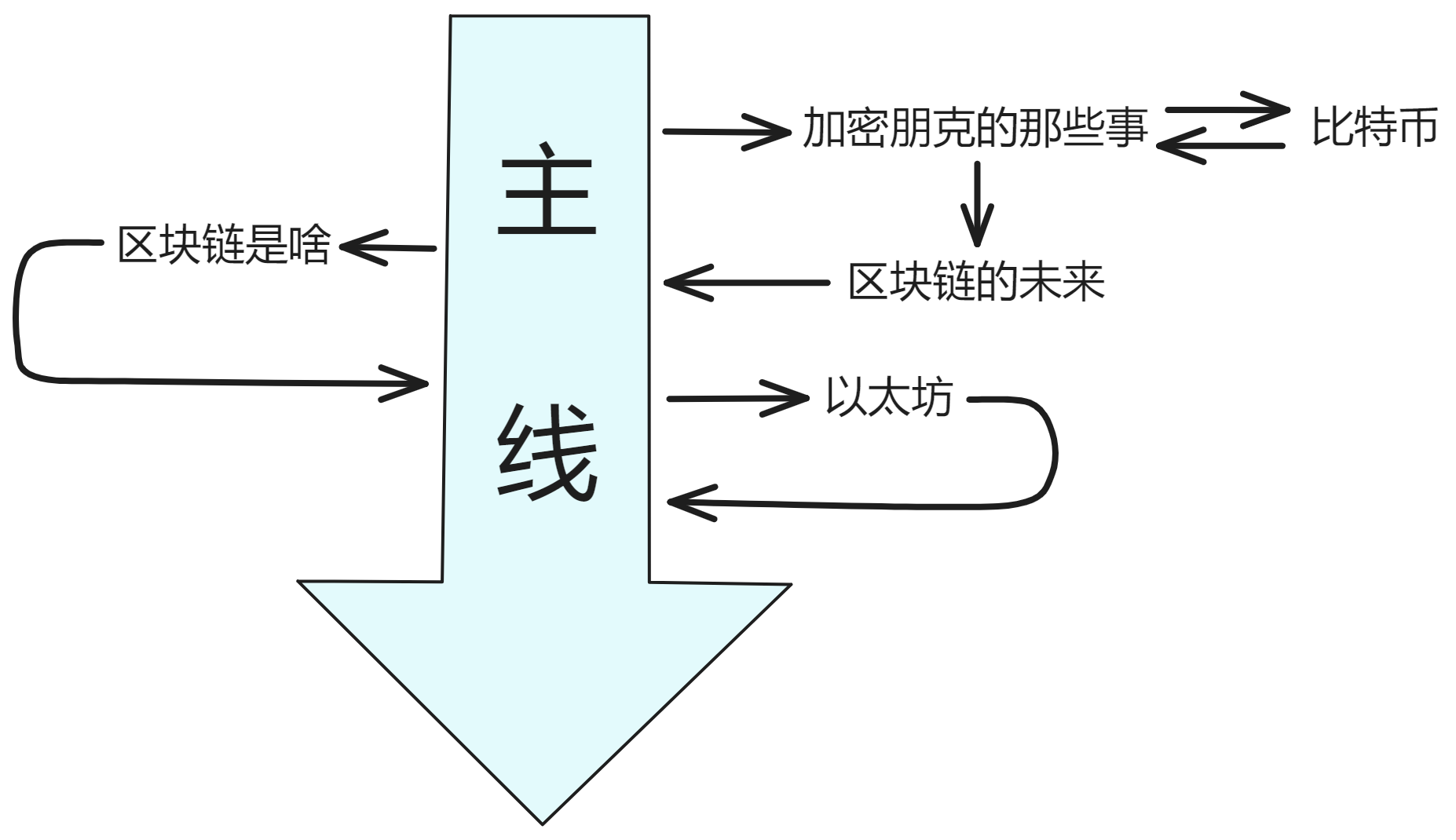

对了,文章的结构是这样的:

如果有不了解的地方可以跳出故事主线看看。

接下来,了解一下 IC 的技术架构吧 ~

未来已来🧐

我读了很多网上关于区块链的看法,然后总结成了这篇文章。客观讲述了我阅读了大量博客之后对区块链的看法以及对未来互联网技术的想法。

农场里的火鸡

现在的区块链很火。好像所有人都在买加密货币。

四年一度的牛市,数字黄金比特币,火爆的 ICO ,涨幅百倍的 meme 币 ...

等等,让我看看日历,现在是 2023 年 3 月 ... 似乎又快到牛市了,如果牛市依然如期而至的话。上次是 2020 年,这次也许是 2024 年。

但是先别高兴,让我来讲个故事:

一个农场里有一群火鸡,农场主每天上午 11 点来给它们喂食。火鸡中的一名科学家观察这个现象,一直观察了近一年都没有出现意外。

于是,它也宣布了自己发现的伟大定律:每天早上 11 点,就有食物降临。第二天上午 11 点,农场主又来了,火鸡们又得到了食物。于是纷纷认同了科学家的定律。

但到了感恩节这天上午没有食物降临,农场主进来把它们都抓出去杀了。

最初是英国哲学家罗素提出的,用来讽刺不科学的归纳推理,滥用归纳法。

我们希望牛市能如期而至,但不妨先放下牛市会不会来这个问题,从历史中找找类似的情况看看是什么结局:

九十年代末互联网泡沫时,市场出现过多次的大跌大涨。96 年,97 年,98 年都有过若干次反复。最后一次也是最大一波的上涨,从 98 年 10 月到 2000 年 3 月,纳指从 2000 多点一路涨到 4900 点左右。这会慢慢给市场内的投机者心理上一个极为坚定的信念:不管跌多惨,最后都会涨回来的。

当人们经历过几个牛熊周期,更加强化了这种坚定的信念,等真正的漫长的熊市开始时,他们继续按照自己总结的经验继续加仓抄底 ...

当泡沫破裂时,股价在几天内暴跌超过 50% ,大部分股票最终跌去 99% 直接归零。许多人靠加杠杆而迅速暴富,在熊市中押注全部的身价抄底,最终输得一干二净。

互联网的本质是把信息搜索和交互的成本降到接近于零,并在此基础上催生了很多扩展性极高,利润极高,垄断性极强的传统经济人无法理解的新模式。但九十年代很多项目和创意,在硬件软件基础设施还没有到位,个人电脑和宽带互联网还未普及时就强行推出,过于超前,因此悲催地失败。比如 1996 年创立,2001 年破产,累计融资约八亿美元的 webvan 。

2001 年互联网泡沫破灭后,随着基础设施的成熟和各种成本的下降,后来涌现出来的新应用( taobao, youtube, netflix, facebook, amazon, aws, iphone,uber,tiktok 等等)。其发展势头之猛,规模之大, 又远远超越悲观者的想象。

同理,大量过于超前于基础设施、无法对终端用户直接产生价值的区块链项目,最终会凋零,催生各种悲观负面情绪。

但基础设施成熟后,许多当年吹的牛,做的梦,最终会被在正确时间正确地点出现的创业者实现。

2014 年比特币被大众视为互联网支付领域时,实际上比特币的吞吐量根本不支持在超市买菜时付款。以太坊的早期叫称自己为 “ 一个世界计算机 ” 。起初有许多人认为以太坊可以取代比特币,因为它有可编程的特性。但这其实是一种错误的假设,这也很容易导致另外一个错误的观点:某某某下一代智能合约平台是以太坊杀手,只是因为它提供了更多的可扩展性。

同理,就像以太坊没法取代比特币一样。接下来的 “ 云服务 ” 区块链也不太可能杀死以太坊,而是扩展相邻的可能性并承载不同的应用程序,利用它们独特的特性。这不代表比特币和以太坊已经永久确立了它们的地位。比特币和以太坊也有它们各自存在的问题。只是更先进的技术并不一定会替代原有的技术,而更可能是创造一个复杂的、专业化的技术栈。

今天以太坊的用途已经不是不是处理大型通用计算了,而是作为一个久经沙场的、缓慢而安全的计算机,用于基于代币的应用程序,如众筹、借贷、数字公司和投票的世界会计系统。即使以太坊网络有些拥堵、Gas 费有亿点贵、还要等待几分钟的时间才能完成交易,可这些 Dapp 也依然能与银行、股东投票、证券公司抗衡。

因为这些智能合约能让陌生人之间可以完全不通过中心化机构来自由交易,并让中心化机构的庞大人员编制变得多余。以太坊上的自动做市商Uniswap ,只有二十多名员工,目前市值约两百亿美元。与之相比,纽约证券交易所的母公司 Intercontinental ,将近九千名员工,市值六百多亿美元。著名区块链投资者 Raoul Pal 估算,区块链的全球用户数,目前每年增长 110% 以上, 而 1997 年全球互联网用户数增长只有 63%。即使按照 1997 年以后的互联网发展的轨迹,区块链全球用户数,也会从现在的大约两亿,增长到 2030 年的四十三亿左右。

区块链技术的本质是把全球个体经济人和机器之间的价值交换的壁垒和成本降到几乎为零。

但是以太坊目前达不到这个愿景,最终还是需要各种基础设施的成熟和普及。

想象一下,如果有区块链技术成功解决了可扩展性、安全性和易用性等问题后,将会呈现怎样的面貌。最终可能只有寥寥几个公链能代表未来,走向世界,承载全球各地的去中心化梦想。

区块链就站在现代社会三大主题的交汇点上:技术、金融和民主。区块链是利用加密和计算的进步,将金钱和我们日常生活的许多方面 “ 民主化 ” 的一种技术。它的目的就是要改善我们的经济运行方式,让我们更容易控制自己的信息、数据,最终掌控我们的生活。在现在这个科技时代,这就是民主该有的样子。我们时常听人们抱怨科技巨头(像苹果、谷歌和 Facebook)对我们隐私数据的窥窃。解决这个问题,把权力还给人民是最好的办法。

马车夫与司机

历史是不断轮回螺旋上升的:

现在人人都可以开车,只要有钱买车就行。🚗

以前人人都可以骑马,只要有钱买马就行。🐎

所以车只是这个时代的代步工具,以后可能就很少有人会开车了。类似于现在人们骑马,只能在马场和一些景区骑到。自动驾驶技术成熟之后完全不需要人们开车,会开车的人也就越来越少。想开车得去赛道上体验驾驶的快乐。

古代有普通马、汗血宝马、战马、赛马场。

现在有普通车、超级跑车、坦克、赛车场。

马并没有消失,只是换成了车。

汽车出现之初,因为噪音大,速度慢,容易出车祸,经常熄火抛锚,缺少加油站,缺乏泊油马路等等而长期被鄙视憎恶。后来等到马路修多了,加油站多了,车的质量提高了,交通规则推广了,马车早就被淘汰了。

现在的特斯拉也是同样的道理:耗电快;着火;自动驾驶开进海里,开上树;没充电桩;刹车失灵被媒体渲染成笑话,啊不是,现在成笑柄和梗了。等电池续航提升、自动驾驶算法完善进步、充电桩慢慢普及、充电时间越来越短的时候,还有油车什么事😄。而且电能还会随着技术进步越来越便宜的,光伏、风电、地热,直到未来实现可控核聚变,用之不竭。

另外,媒体为了吸引眼球的负面报导也是阻碍人们客观认识新事物的障碍之一。为了吸引人们关注,媒体选择性报道负面消息的次数远远大于正面报道,对新生事物尤其如此。iphone 出来后,媒体开始是嘲笑果粉脑残,然后是卖肾换手机,又攻击手机信号不好,之后而又渲染因为 iphone 抢劫、谋财害命的孤立事件。每次特斯拉着火、刹车故障、出车祸,总有人像打了鸡血一样开心,而没有客观的和别的汽车的事故率进行横向比较。人们诅咒共享单车的各种问题时,却没注意共享单车正在改变都市人的出行习惯,减少汽油消费,甚至影响房地产价格。

负面消息的长期轰炸,使大部分人根本不可能去真正钻进去,研究新事物背后的整套逻辑。因为某个技术的现在的缺点局限,断定它没有前途,就像因为害怕触电的危险,而继续烧煤油灯一样。可是煤油灯也有着火的风险啊喂!实际上这不是怕触电,只是害怕陌生未知的新技术罢了。如果我们能保持客观和好奇心,会对世界产生很多不一样的看法。尤其是在现在技术发展日新月异的时候。

同样的,很多人不了解 IC 的底层运行原理,不知道 Chain Key 密码学的创新,不知道 IC 解决了扩展性的问题,不知道 BLS 阈值签名,不知道 IC 的共识算法。很难真正理解 IC 的概念,因为这是一个全新的,没有先例可以类比的复杂系统。即使是有计算机背景的人,要全面深入理解所有的概念,也得花几个月的时间深入各种论坛讨论、收集资料。而且每天还有新的发展,要想掌握,没有捷径。如果只是图一时之利,盲目跟风,追逐热点。在 ICP 价格高点投资了 ICP ,然后因为亏损过大和不理解本质而给这个东西贴上一个标签 “ 骗子 ” 、“ 垃圾 ” 等等是一个很自然的事。所有亏钱的散户都很伤心,逐渐变成失望,并在社交媒体上加入 FUD 大军,导致更多不了解 IC 的人产生偏见。更重要的是,很多时候人们都不知道那些因为无知而错过的信息。个体偏见普遍存在,每个人学习生活经历不同,思维模型不同,会自动忽略掉自己不感兴趣或者不理解的东西。

更多相关内容延申阅读:Were attacks on ICP initiated by a master attack — multi-billion dollar price manipulation on FTX? 、How The New York Times promoted a corrupt attack on ICP by Arkham Intelligence 、专访DFINITY:ICP是SBF资本运作的受害者;Web3的很多未来都在亚洲 。

人类社会的生产力在循环中前进:

一个新技术产生 → 少数人先接触试用 → 雇佣更多人研发维护这项技术 → 组织(公司 或者 DAO)发展壮大 → 越来越多的人开始尝试使用它,提高生产力 → 直到另一项新技术萌芽,尝试使用更先进更前沿的方法解决问题,便利生活 → 旧组织逐渐走向衰败死亡(变了死的更快,不变只是等死,也有少数组织能成功改革) → 大批雇员失业,并加入到新工作中 → 新组织继续发展壮大 ...... 直到有一天!人真的什么都不用干了,完全自动化、物资充足 ...... 人生只剩下享受 ~

区块链技术的精髓在于,创新可由人人开展,无需权威机构的审核和批准。任何人都可以通过区块链技术保护自己的权益,免受强者的侵犯。在密码学面前人人平等。只要妥善保管好私钥,个人资产就可完全由自己掌控,不依赖任何人托管。

Visa 卡的 TPS 是 2400 ,比特币是 7 。即使是比特币这么慢的速度,依然受到了全球各地爱好者、组织、一些国家政府的支持。如果能把以前的中心化应用,比如 Telegram 和 Dropbox ,转移到去中心化的区块链上,那得是啥样的情景?生产力肯定得提升一个档次。

尽管区块链技术在过去几年中得到了广泛应用和发展,但它们仍然存在一些明显的缺点。其中一个主要的问题是可扩展性。随着区块链技术的广泛应用,如数字货币、智能合约、供应链追溯等,区块链网络中的交易量和数据量迅速增长,这给区块链的可扩展性带来了严峻挑战。当前的区块链架构面临着吞吐量低、延迟高等问题,难以支持大规模的应用场景。这是因为,传统的区块链技术采用了分布式共识算法,需要所有节点都参与到区块验证和生成的过程中,从而导致网络的吞吐量和延迟受到了限制。此外,由于区块链数据存储在每个节点上,数据同步和传输也会成为可扩展性的瓶颈。

因此,解决区块链可扩展性问题已成为当前区块链技术发展的重要方向之一。研究者们提出了许多解决方案来提高区块链网络的吞吐量和延迟性能,比如分片技术、侧链技术、Lightning Network 等。这些技术都旨在将区块链网络分解为更小的部分,方便分别处理交易和数据,并且可以通过跨链通信协议进行互操作。通过这些创新技术,可以提高区块链的可扩展性,更好地满足实际应用场景的需求。

区块链一旦解决了扩展性、吞吐量的问题,实现底层技术突破,就可能成为互联网的新基础设施,重塑未来互联网格局。

Dfinity 就是选择了重构区块链底层技术,创新研发更优秀的去中心化网络服务,并孕育更多 Dapp,从而形成全新的去中心化互联网生态。

这个领域是如此之新,涉及的知识面要求是如此之广,没有谁是真正的权威。成功来自全方位的观察,不断的学习研究。这样才能看到大多数人看不到,理解不了的东西。

继续阅读多米尼克的故事。

要是说起这个,那得从比特币之前说起。

如果你还不了解比特币,可以先看看这个。

比特币是完全虚拟的。没有任何实际价值,亦不能创造任何价值,只是一种虚拟币,人们为什么疯狂送钱购买比特币?不妨再深入一下,为什么会有比特币这种东西?

比特币是在 2008 年金融危机的背景下诞生的。金融危机波及全球,哪个国家都不能独善其身,法币变得不再可靠。想象一下这背后的关系,政府以国家信誉为背书,发行法定货币。但世界并不总是安宁稳定的,战争、自然灾害、金融危机都会对社会造成影响,这又会影响经济。

关于战争:社会依赖政府,政府掌握军队,军队维护社会,经过循环,组成国家。国家哪来的钱支持军队,纳税。而国家之间的冲突,如果收益大于成本,那就可能发生战争。全民纳税出钱支持军队发起战争。大炮一响,黄金万两。有国获利,有国赔钱。

关于金融:这世界上大部分国家:欧洲、北美等等,都有经济周期。小周期组成大周期,像正弦函数一样。周期性的金融危机是一把剑,悬在头顶,只能祈祷:达摩克里斯饶了我吧。

关于自然:自然灾害难以预测。虽然随着科技的发展,天灾对人类的冲击越来越小。病毒、洪水、火山。但未来几十年仍有不少威胁。这时经济自然要受连累。

既然怎么都要影响经济,那能不能找一种不影响经济的东西呢。害,经济不就是钱嘛!只要找到一种不贬值的钱就行了。不用抵抗所有危机,直到人类毁灭这钱还在;只要这种钱能抵御一部分天灾人祸就 ok 的。钱呀,求求你,别让地球一端的金融危机影响到地球另一端人们的正常生活。

我靠。还真有这种神奇东西。

这种钱源自一种 “ 无政府主义 ” 思想。前面的 b-money 就体现了这种思想。

“ 无政府主义 ” 的基本立场是反对包括政府在内的一切统治和权威,提倡个体之间的自助关系,关注个体的自由和平等。对无政府主义者而言,“ 无政府 ” 一词并不代表混乱、虚无、或道德沦丧的无政府状态,而是一种由自由的个体自愿结合,以建立互助、自治、反独裁主义的和谐社会,是无政府而有权威的自治体系。他们认为根源在于 “ 政府 ” ,在于现在这种自上而下的金字塔结构。层层管理的模式不仅有不作为、贪腐、浪费的问题,更重要的是,总有一个组织在上面管理大家、维护秩序,容易因大的利益争端引发战乱。

-

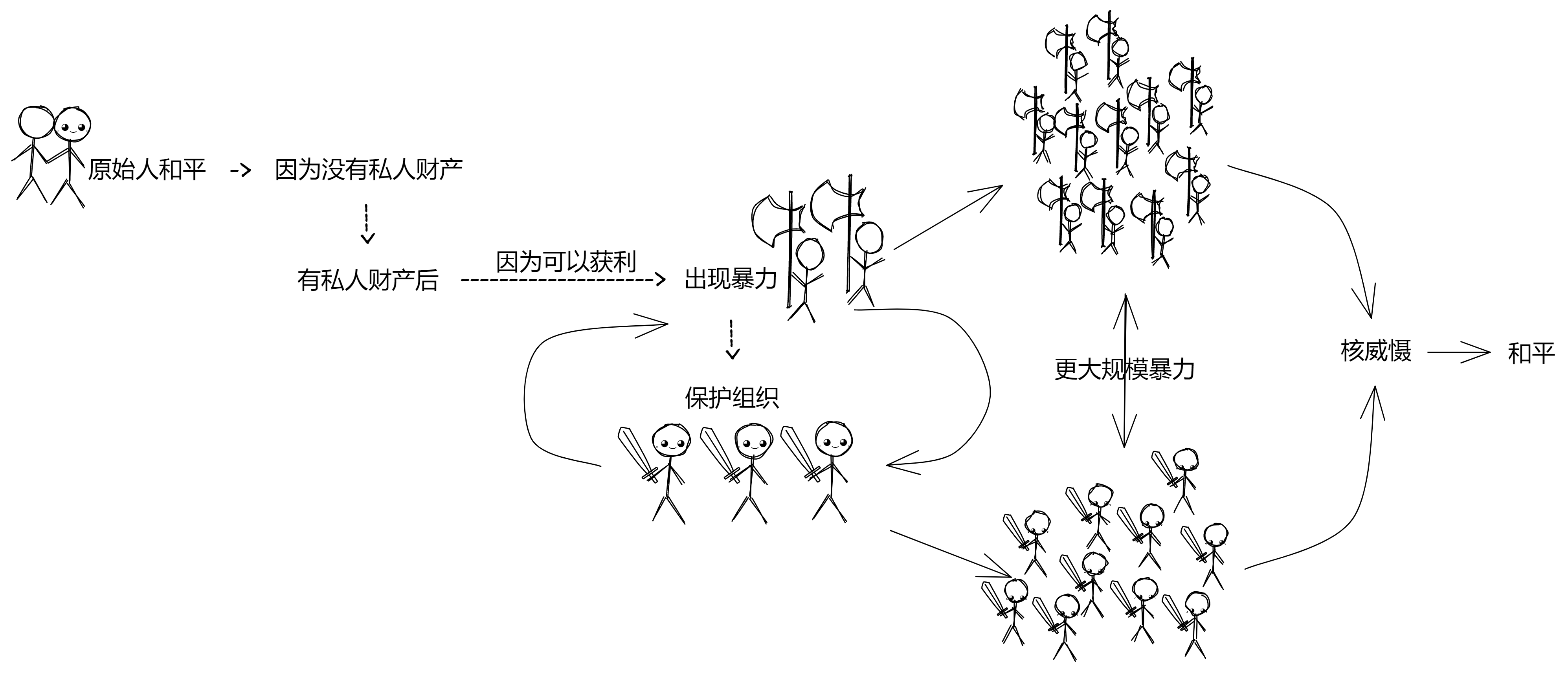

进一步分析,你看原始社会就很和平呀,人们自发以大家庭的形式聚居,一起打猎、合作。没有所谓政府和国家,只有小规模的财富积累和劳动分工,也没有法律和警察。因为原始社会没有私人财富,大家都是一块会跑会跳的肉,光溜溜的。

-

后来,有了私人财富便有了暴力。原因很简单,因为可以获利嘛 ~ 通过暴力掠夺财富,有利可图就有 “ 勇夫 ” 干。

-

之后,当出现大量 “ 获利 ” 组织时,就会有人站出来保护大家。出现防止暴力的暴力组织 —— 军队。大家每人交一点钱(纳税)就可以获得保护。人们为了更高效的提供保护服务,形成了政府。大家把钱存进银行,因为银行可以提供保护:金库、保险箱、保安、警察等等。这个体系依赖政府运作,银行、警察,要么接受政府监管,要么是政府组建的。我的钱不带在身上,在银行里,嘿嘿你抢不着。

-

这样一来,两个大组织(政府)就会因集体利益的冲突,展开更大规模的战争,如果收益大于发动战争的成本。再招募更多军队来保护集体财产 ...... 暴力冲突越来越大,和平在哪里?核威慑。

到了 21 世纪,人们的财产,包括社交、娱乐逐步转移到互联网。所以保护人们财产的保护组织也迁移到了网上:网上银行、支付宝。

没事,钱放我们这,嘿嘿。交点手续费就行,嘿嘿。又是保护组织帮大家保管,丢了钱找平台解决!战争也变为网络攻防战,保护组织和黑客打的有来有回,拼命保住大家的钱。

以前保护组织只提供物理保护,并不会在你家里驻军把守。可是在网上就不一样了,你的数据被一股脑的传进服务器里。我的数据也是我的资产啊!数据里包含隐私、财产,你今天买了什么东西,喜欢和谁聊天,喜欢看什么,晚上想吃什么 ...... 对能通过数据分析出来。这相当于 “ 网络军队 ” 在你家里驻扎了,天天监视你的一举一动。而且数据怎么处理,人家说了算。因为保护组织控制着服务器,人家觉得不好、对某人不利就直接删掉,不用你同意。

可不可以把 “ 金字塔 ” 压扁,构建一种完全不依赖保护组织的 “ 个人主权 ” 体系,每个人代表平等、独立的个体?

可以的。有一种方法可以让你自己安全的持有自己私人财产。不需要银行保护你的财富、不需要保险箱保护、不需要保护组织,你自己保管即可。

那自己一个人怎么保护财产呢?答案是用现代密码学通过数学保护!

炸弹可以炸开保险箱,但是不可能炸开密码学!

比特币就是这种钱!自己生成一个私钥,只要私钥不泄露,别人谁都没法抢走你的比特币。收发比特币都是脱离第三方中心化平台(银行)进行点对点转账。当然,如果私钥丢了,比特币也就永远找不回来了。

自己的私钥,掌握自己的数据,不依赖第三方,完美。

当然,加密货币并不是中本聪自己的想法。

戴维(Wei Dai)所说的 Tim May 就是 Timothy May ,那个在 1992 年的加州湾区和 Eric Hughes 以及 John Gilmore 共同发起成立密码学研究小组的三人之一。在第一次聚会上,加密朋克(Cypherpunk)这个单词诞生了,取了密码学(cipher)和赛博朋克(cyberpunk)的词根拼合而成。

他们在密码学和算法中发现了解决互联网太过中心化的潜在解决方案。密码学家们认为,如果要减少政府和公司的权力,得需要新技术、更好的计算机和更多的密码学机制。然而他们的计划遇到了一道似乎不可逾越的障碍:到最后,他们所有的项目都需要资金支持,而政府和银行控制着这些钱。如果他们要实现自己的计划,就需要一种不受政府控制的货币形式。于是,加密货币的大竞赛开始了。但是结果适得其反。最初的各种努力都失败了,包括传奇密码学家大卫 · 乔姆的 ECash ,还有比如 Hashcash 和 Bit Gold 各种各样的加密货币。

戴伟是一位华裔计算机工程师,华盛顿大学的校友,他 20 世纪 90 年代末和 21 世纪初曾在微软的密码学研究组工作。在微软工作期间,他参与研究,设计和实现密码学系统。之前他是马萨诸塞州 TerraSciences 的程序员。

1998 年,他在个人网站 weidai.com 上发布了一篇名为 “ B-money ,一个匿名的分布式电子现金系统 ” 的非正式白皮书。他因对密码学和加密货币的贡献而闻名,他开发了 Crypto++ 密码库,创建了 B-Money 加密货币系统,并共同提出了 VMAC 消息认证码算法。戴伟在区块链和数字货币领域的开拓性工作,为后来的比特币技术奠定了基石,具有里程碑意义。

1998 年 11 月,刚刚大学毕业的他在社区提出 B-money 想法:“ 有效的合作需要一种交换媒介(金钱)和一种确保合同执行的方法。本文中,我描述了一种协议,通过这些协议使得不可追踪的匿名参与者可以更高效的彼此合作 … ,我希望这个协议能够推动加密学无政府主义在理论上以及时间上向前迈进。” B-money 的设计目标是是一个匿名,分布式电子现金系统。

在 Cyberpunks 社区看来,这种方式的问题在于政府能够通过政策管理来控制金钱的流动,同时要使用这些机构服务(银行或支付宝)需要暴露身份,于是 Dai 提供了两个替代方案(工作量证明和分布式记账)。

1.工作量证明创造金钱,任何人都可以通过计算一些数学难题,算出答案的人可以广播到全网,每个网络节点验证之后,都在自己的账本上给这个人的账户上添加或销毁工作量等价值的加密货币。

2.分布式记账追踪交易,发送方和接收方都没有真实姓名,都只是公钥。发送方用私钥签名,然后广播交易到全网。每一笔新的交易产生,每个人都更新他们手里的账本,使得没有任何人能够阻止交易,保证所有用户的隐私安全。

3.交易通过合约来执行,在 B-money 中,交易是通过合约(Contract)来实现的,每一个合约都需要有仲裁人(第三方)参与,Dai 为此设计了复杂的奖惩机制以防止作弊。

我们可以看到与比特币之间的关联,通过 POW 工作量证明来创造金钱,并把记账的工作分配到一个点对点的网络上,所有交易必须通过合约来执行。但是 Dai 认为他第一个版本的方案无法真正应用到实践中来,“ 因为它需要一个很大的即时同步、防干扰的匿名广播通道。” 换句话说,第一个方案并不能解决双重花费(双花)的问题,而比特币是通过激励解决拜占庭将军问题的。

Dai 随后在 Cyberpunks 社区中解释:“ B-money 还不是一个完整的可行的方案,我认为 B-money 最多可以为那些不想或者不能用政府发行的货币或者合约强制执行机制的人提供一个替代解决方案。” B-money 的许多问题一直未得到解决,或者至少是没有被指出。也许最重要的是,它的共识模型并不非常稳健,Dai 在提出 B-money 之后并没有再继续试图解决这些问题,他去了 TerraSciences 和微软工作。

但他的提案并没有被人忘记,比特币白皮书的第一条参考文献就是 B-money,在比特币白皮书发表前不久,Hashcash 的 Adam Back 建议中本聪去读一读 B-money ,Dai 是为数不多中本聪亲自联系过的人之一。但是 Dai 并没有回复中本聪的邮件,后来回想起时他表示很后悔。

他在 LessWrong 上写道 “ 这可能有一部分是我的错,因为中本聪给我发邮件询问我对他的稿件的看法时,我没有回复他。不然我可能能够成功劝说他不要用固定货币发行量这个想法。”

B-money 是加密朋克社区对研发数字世界中的独立自主的货币的又一次探索。为纪念他,有两种加密货币分别命名为 “ Dai ” 和 “ Wei ” ,其中 Wei 是 2013 年 V神 命名的以太坊最小单位。

不过随着每次新的尝试和每次新的失败,“ 加密朋克 ” 都对他们所面临的困难有了更多了解。也因此,有了前人大量的尝试探索,中本聪借鉴改进了先辈们遇到的问题,并在 2008 年 10 月 31 日推出了比特币。

正如中本聪在他关于这个问题的第一封电子邮件中所说的那样,“ 我一直在研究一个新的电子现金系统,这完全是点对点的,不需要任何可信的第三方 ” 。他认为自己的核心贡献在于:创造了一种由用户管理和维护的虚拟货币;政府和企业对货币的运行几乎没有发言权;这将是一个完全去中心化的系统,由用户来运行。

中本聪非常清楚加密货币不光彩的历史。在 2009 年 2 月发布比特币后不久的一篇文章中,中本聪提到了乔姆的工作,但将比特币与乔姆的工作进行区分。很多人想当然地把电子货币当成了一个失败的事业,因为自 20 世纪 90 年代以来,所有的公司都失败了。在我看来,那些数字货币的失败因其系统仍未去中心化。我认为,比特币是我们首次尝试搭建一个去中心化的、不以信任为基础的虚拟货币系统。

为了确保参与者之间的信任,中本聪设计了一种公链,允许人们进入并检查以确保他们的钱仍然存在。为了保护隐私,比特币使用了一种加密的私钥系统,该系统允许用户在不公开身份的情况下告诉其他人自己的账户。为了激励用户维护系统,比特币引入了挖矿的概念,在该概念中,用户可以创建新的交易区块,并通过使用新铸造的比特币获得回报。为了防止黑客入侵,区块与之前的区块进行了加密链接,使得交易的历史记录实际上是不可更改的。比特币真正的创新,都在于这一货币系统是完全去中心化的,也就是没有最终决策者或权威机构来决定争端或决定货币的发展方向,而是用户作为一个集体共同决定比特币的未来。

加密朋克对这些威胁保持警惕,他们试图通过创建一套确保隐私的程序和方法来削弱政府和企业的监控能力,这些手段包括强大的密码学、安全的电子邮件和加密货币。他们的最终目标是在互联网上分散决策。加密朋克并没有将权力集中在少数人手中,而是寻求将权力分配给大众,让大家一起决定整个系统应该如何运行。

在加密朋克们看来,互联网时代的主要问题是,政府和公司变得过于强大,以至于对个人的隐私权构成了严重威胁。此外,美国政府和企业滥用它们的权力和地位,向消费者收取过多的费用和沉重的税收。答案在于权力去中心化 —— 将权力和决策权从少数人分散到多数人手中。但在比特币出现之前,人们并不清楚如何才能做到这一点,而中本聪提供了解决方案。

难道比特币是绝对安全的吗?当然不是,如果你想抢某个人的比特币,把刀架他脖子上,让他交出私钥即可。谁有私钥就是谁的比特币,加密算法只认私钥。这就是去中心化的魅力。我们为什么相信比特币,不是因为中本聪不会抛售他的巨量比特币,而是因为我们相信个人主权和密码学。

人们会说,中本聪发明比特币的时候,根本预料不到后果会这么惊人。当然,在某种程度上,他确实不可能预料到 “ 比特币披萨 ” 、“ 丝绸之路 ” 、Mt.Gox 或者 2017 年疯狂的牛市。

不过,中本聪对这项技术的发展方向有着惊人的眼光。比如,他写道,虽然区块链技术解决不了互联网上的隐私问题,但如果成功的话,用户将 “ 在军备竞赛中赢得一场重大战役,并在未来几年里获得新的自由领域 ” 。他也预见到区块链技术很难被关掉。就像他写的,“ 政府擅长砍掉像 Napster 这样的中央控制网络的脑袋,但像 Gnutella 和 Tor 这样的纯点对点网络似乎保持着自己的优势 ” 他还看出区块链本身是个灵活的技术,可以被用户开发出无限的应用,“ 一旦启动,只要你不费力气地向网站支付几分钱,就像在自动售货机中投币一样容易,立刻会出现许多应用程序。”

同时,中本聪也对自己给世界带来的后果感到担忧。他担心政府会如何对付他的虚拟货币。当区块链用户推动维基解密使用比特币躲避政府制裁后,中本聪强烈反对,他说:“ 你们的做法很可能会在现阶段摧毁我们。 ” 他还担心超级矿工的出现,他写道:“ 我们应该有一个君子协定,为了网络的利益,尽可能地推迟 GPU 军备竞赛。” 他最担心的可能是网络安全。在详细说明对虚拟货币的改进后,他在最后的公开信息中总结道:“ 攻击的方式仍然比我能计算的还要多。”

围绕中本聪的神秘感只会增加人们对他和他的技术的好奇心。虽然记者们千方百计想揭开他的神秘面纱,但我们可能永远也不知道他是谁。中本聪就像半夜的星辰,永远闪烁在我们的视线里,却可望不可及。 这很朋克,也很有诗意。比特币的发明人拒绝成为他发明的中心。 区块链技术是一种把可信的中间人从我们生活中移除,把权力下放给每个人的技术。他拒绝成为人们关注的焦点。区块链的成败必须依靠它自己的优点 —— 依靠技术本身的特征,以及用户为使其发挥作用所付出的努力。

中本聪的点子也许挺新颖,但比特币的崛起也并非必然。比特币是在 2008 年金融危机的背景下诞生的。金融危机波及全球,哪个国家都不能独善其身,法币变得不再可靠。中本聪和他的支持者在早期经常一而再再而三地求来求去,才说服别人信比特币。他们经常说的一句话是:你想象一下,如果比特币成为世界货币,会发生什么。想象一下,到时候每个比特币会值多少钱!而你只要下载软件并在家里的电脑上运行,就能赚到几百枚。当然,大多数人都在中本聪孜孜不倦的努力下,相信了这是传销骗局。

但也不影响最终还是有一些技术极客对比特币产生了兴趣,中本聪的努力得到了回报,人们开始在现实世界中使用和接受比特币。然后在 2010 年 5 月 22 日,程序员拉斯洛 · 汉耶克花 1 万个比特币买了 2 盒披萨。

于是,整个互联网世界开始发生的根本性的变化:一旦人们开始在现实世界中使用比特币,一个围绕比特币的生态系统就出现了。比如 Mt.Gox 、Binance 、Coinbase 这样的加密货币交易所应运而生,让人们更容易购买和出售这种货币。为了处理货币背后困难的数学问题,专业矿工开始在世界各地建立矿场。芯片制造商开始制造专门的芯片。

人们对比特币的兴趣激增刺激了比特币和加密货币市场的发展。比特币价值开始的狂飙。在 2010 年,比特币还不到 1 美分。到 2021 年年中就涨到 60000 美元了。这种疯狂的飙升让很多外行人将它与历史上的泡沫相提并论,比如 17 世纪的郁金香热和 18 世纪的南海泡沫。人们对比特币价格崩溃的担忧开始蔓延。其次,竞争性加密货币的出现。

看到了比特币的成功,一些有计算机知识的企业家先后推出了基于区块链的加密货币。例如莱特币、狗狗币(Doge Coin)、以太坊。以太坊在比特币的基础上建立了新型计算机,运行在世界各地的去中心化虚拟计算机。无法篡改,无法被政府关掉,亦不受政府控制,全球各个地区、各个种族、生活习惯不同的人们,一起组成的网络。除非联合国停掉地球上的互联网,只要互联网不停,这种去中心化组织就会一直存在。2017 年,首次代币发行(ICO,即个人或团体通过出售加密货币或 “ 代币 ” 来筹集资金)迅速走红。但是,其中大部分都惨遭失败。大约有一半的首次代币发行在一年内倒闭了。尽管虚拟货币引起媒体广泛的关注。

但是几乎所有的电子设备都能加入的网络速度实在太慢。你想想,早期随便一台电脑就能加入比特币网络挖矿,但是现在随着挖比特币的人越来越多、哈希难度上升,人们不得不购买更高算力的显卡,组合更多的电脑去挖矿,这就相当于一种去中心化的服务器机房了。

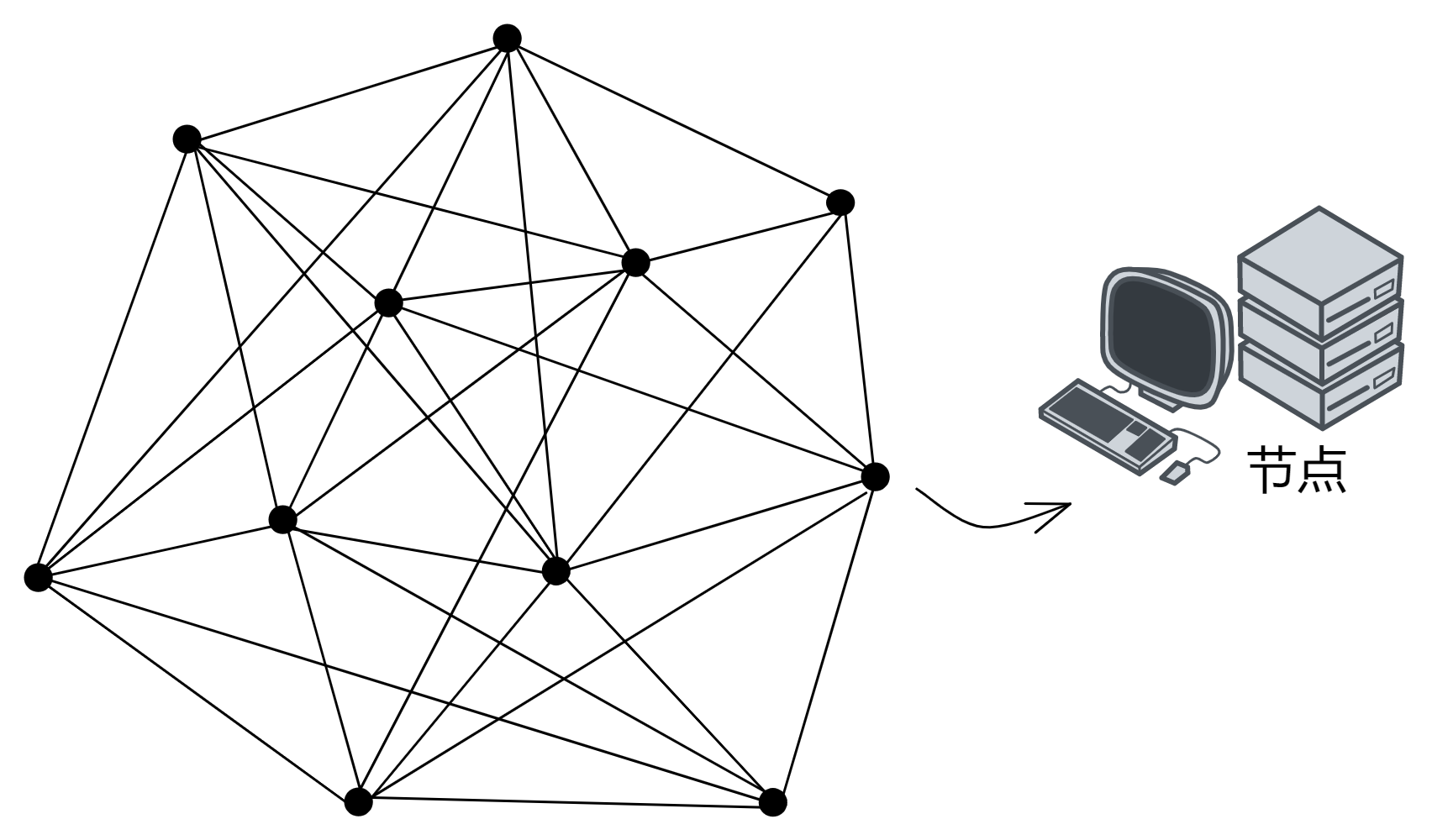

多米尼克想,那就直接让数据中心的机房来做节点吧,这样还能提升性能呢!

于是 IC 就变成 “ 机房链 ” 了,一个由世界各地的机房组成的去中心化网络。以太坊更擅长金融类 DApp ,而 IC 擅长通用 DApp 。这样一来就形成了各种互联网应用的 “ 个人主权 ” 革命:畅想区块链的未来。

区块链是啥?

区块链是通过密码学组成的一个去中心化分布式系统。

等等,那去中心化又是啥意思?

别急,听我一个一个慢慢讲。

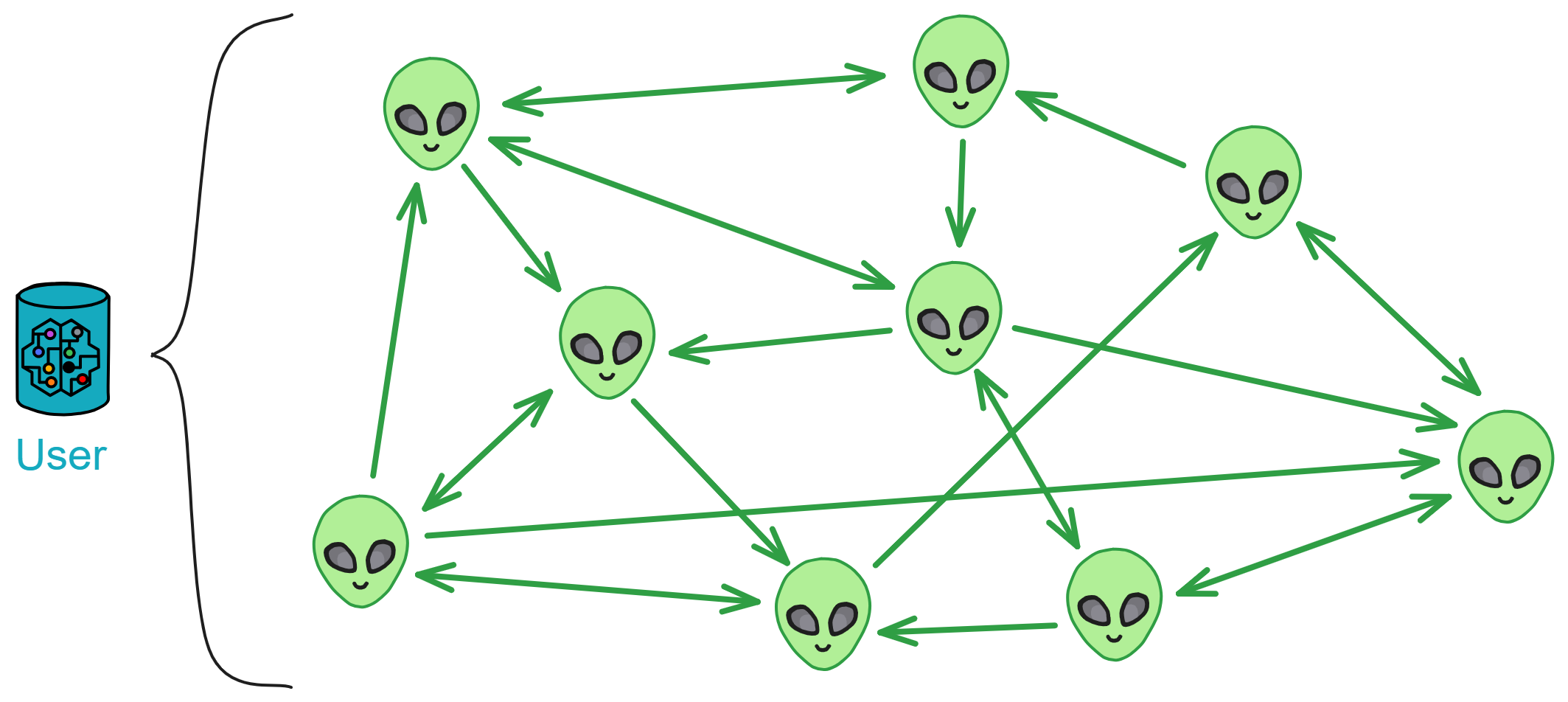

假如几个中子星人想建一套网上银行系统,名叫 “ 中子星银行 ” 。他们买了一个服务器用来处理所有的请求。所有用户的余额和交易信息都存在这一个服务器上。中子星银行就这样开业了。

随着在线支付的日益普及,用户和使用场景越来越多,交易数据呈指数级增长。

一台服务器承载能力不断受到挑战,开始有些吃不消了:

一方面,存储容量难以满足海量交易数据的储存需求;另一方面,每到双十一、618 之类的购物狂欢节,系统访问量飙升,CPU 负载不断攀升,过载情况时有发生。更为严峻的是,有时服务器还会发生故障,导致整个系统瘫痪,丢失交易数据。

业务增长使系统不堪重负,也为了避免系统瘫痪的情况发生,中子星人对系统进行了扩容优化:

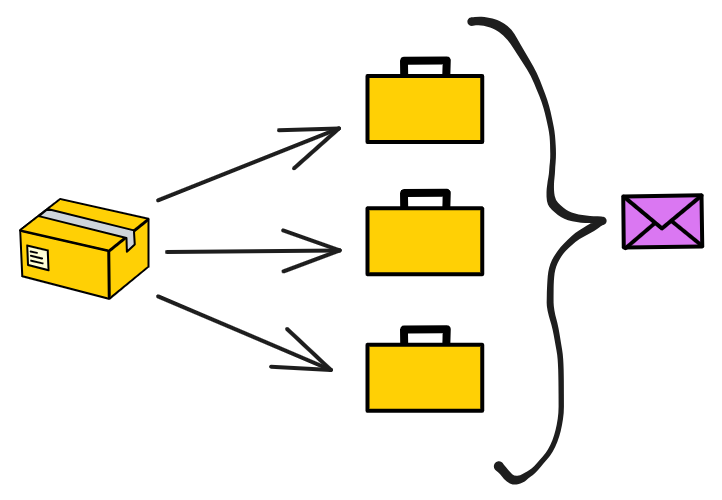

买一台服务器作为 “ 管理员 ” ,再买几台服务器专门存数据。管理员服务器收到交易数据就转发给负责储存数据的服务器里。存满一台服务器就存进另一台服务器。

如果管理员也忙不过来了,就继续加管理员服务器。这样终于把系统扩展完了。

可这时有一群黑客盯上了中子星银行。反正钱就是一串数字,只要潜入银行数据库偷偷改掉账户余额和交易记录就能财富自由。

银行的系统一开始没有做好保护措施,很容易受到攻击。

在付出惨痛代价后,银行意识到了问题的严重性,并开始采取了一系列措施来保护银行系统:他们先买几台服务器用作数据备份,每 3 小时备份一次数据。然后在系统上部署了独立的哨兵监控系统,专门保护整个系统安全。

现在有了安保力量,系统的安全性大大提高,黑客们再也无法使用以往的攻击手段。

由于这些服务器都放在中子星银行的大楼里,黑客们心想:既然不能攻进系统,不如就从物理上攻击吧~ 😎 先从银行借一大笔钱,然后炸坏银行的服务器,唉,服务器死,死无对证。

还好银行门口的安检不是吃素的,谁会带着炸弹去银行呢。安检拦截了炸弹,成功阻止了黑客通过物理方式黑掉服务器。

这下可把银行吓坏了,服务器放在银行里不安全呀,怎么办呢?

必须得想出一个万全之策,确保服务器的本体安全!

于是中子星银行决定:建立专门放服务器的数据中心,并对数据中心的路由器、交换机、接口等网络设备全部独立保护。

建设数据中心的位置非常苛刻,旁边不能有铁路、公路、机场、化工厂、垃圾填埋场、核电站、军火厂、加油站等有安全隐患的设施。也不能设置在洪水、地震多发的地方,并且犯罪率较高的地方也不行。但银行还是怕有突发自然灾害,给数据中心仍然做了抗洪防护和 8 级抗震。

除了位置要合适之外,机房还要符合很多严格的建设标准,建筑材料,内部的暖通系统,空调系统,照明系统,灭火系统、防雷接地措施、内部恒温恒湿等等设备一应俱全。

万一黑客们切断了数据中心的供电,整个系统都会瘫痪,再安全的设备也不能没有电。

既然怕断电那就在数据中心附近安排两个发电厂同时供电,每个发电厂都能满足数据中心的全部电力需求,还有一个备份电力供应,以备两个发电厂同时断电的情况。每个发电厂配备独立的配电室。

没事,数据中心还配备了 UPS 室。就是在房间里放一堆电池,能够支持数据中心满载运行 15 分钟以上。

即使黑客切断了数据中心的供电,数据中心仍然可以通过 UPS 不间断电源保持一段时间的运行。

那 15 分钟能恢复供电吗?不用赶着恢复。因为数据中心还配备了发电机和储油罐,能够支持数据中心满载 12 小时以上。

而且银行还跟附近至少两个加油站签订协议,保证 4 个小时之内供应柴油。虽然运油不是长久之计,但支撑一周还是轻轻松松的。

储油罐失火了怎么办,那可全是油。

数据中心检测火情有温感系统,视频系统,还有值班人员盯着。发现火情后,灭火系统抽出一部分气体,然后释放七氟丙烷。这种东西无色无味,杀人于无形之中,额,不是,这东西是无色、无味、低毒性、不导电、不污染、无腐蚀性。

那里面的人不都憋死了么。

数据中心灭火时,有警铃报警,门禁系统自动断电,人可以撤离灭火区域。就算无法及时离开,数据中心内也配备足够量的氧气面罩。

可是一个数据中心再怎么做安全措施也不能确保系统万无一失。

2001 年 911 事件时,摩根士丹利位于世贸大厦的数据中心全部被摧毁,但因为有成熟的容灾系统,第二天就恢复了全部业务。摩根士丹利在世贸大厦25层办公场所全毁,3000 多员工被迫紧急疏散的情况下,半小时内就在灾备中心建立了第二办公室,第二天就恢复全部业务。有些公司却因为备用灾备系统,最终不得不申请破产。

你看,这时候有另一座数据中心就很有用了。

这就是所谓的 “ 双活数据中心 ” ,两个数据中心同时工作。炸了一个,还有一个,系统几乎没有影响 ~

没关系,还有异地容灾数据中心,两个主数据中心都挂了还可以切换到异地容灾数据中心。和主数据中心一样的配置,超级安全。

异地容灾数据中心也被破坏了怎么办?

这下系统还真被整挂了,不过数据还在。因为有冷备份,备份不运行在系统里,独立运行。备份系统每 2 个小时做一次增量备份。安置在另几座城市里。

发现了没?做了这么多,其实目的只有一个,就是确保系统顺利运行,尽可能的提升系统可靠性。

分布式系统虽然系统在地理上分布在不同的地方的,有多个数据中心承担业务。但所有服务器都需要银行来保护。这是一种中心化的方式,而许多人的诉求是对于现有网络的可见性、选择权和对数据的合理控制。用户需要知情权,知道谁可以访问用户数据,知道自己的数据是如何被使用的,如果用户不愿意共享某些数据,我们也有权拒绝。或许,最重要的是,用户希望自身的数据要用于自身利益。如果你对这方面的历史感兴趣,可以先看看这里。

那区块链的本质是什么?

一个遍布全球的分布式网络,一个 “ 去中心化 ” 系统,一个 “ 共享的分布式 ” 系统,一个 “ 容错、容灾 ” 系统。

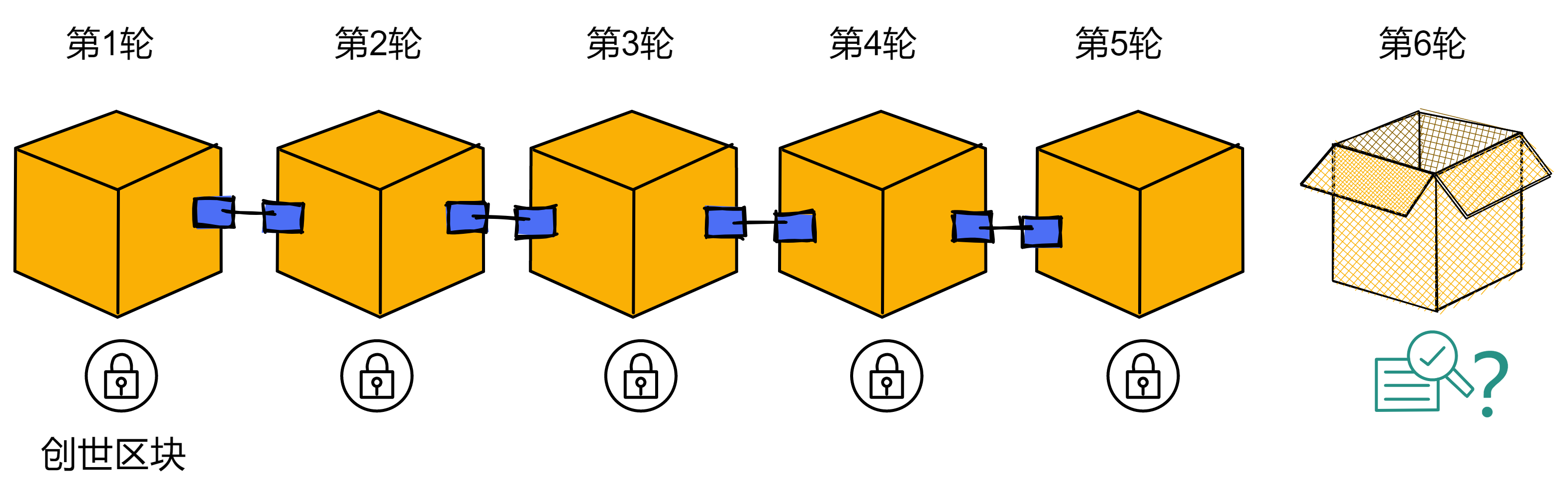

区块链的概念分为两部分:“ 区块 ” 和 “ 链 ” 。我们先来讲讲 “ 区块 ” 。区块就像是账本的一页,里面记录着一些信息。在区块链的世界里,这些信息通常是一些交易记录。比如,A 给 B 转了 10 个比特币,这就是一笔交易。把一定数量的交易打包在一起,就形成了一个区块。

现在我们来看看 “ 链 ” 。链的概念很简单,就是把这些区块按照一定的顺序连接起来。有了链,我们就可以追踪到每个区块之间的联系。每个新产生的区块都会连接到前一个区块,形成一个链条。

从电于货币的诞生与发展来看,虽然我们已经做到了让货币以数字化的形式高效流通,但这种数字化还相当初级。我们不得不依赖大量的第三方中介机构才能保障电子货币的流通,而这种形式不仅引人了中心化的风险,也提升了传输的成本。

区块链就是在这样的背景下诞生的。由于信息与价值的密不可分,我们有了互联网这个全球范围的高效可靠的信息传输系统后,必然会要求一个与之匹配的高效可靠的价值传输系统。也就是说,区块链的诞生不是偶然的,其背后有着深刻的必然逻辑。“区块链”这个名字或许是偶然,但行区块链之实的系统的诞生则是必然。

信用是制造货币的真正原材料。而区块链通过构造一个可以量化信用的经济系统,使得一个点对点的电子现金系统——比特币的出现成为可能。或者说,区块链创造了一个数字化的、可以点对点传输价值的信用系统。

那么,区块链的全貌就是:一系列按照时间顺序排列的区块,它们通过特定的算法连接在一起。这样的结构能够确保数据的安全性和完整性。

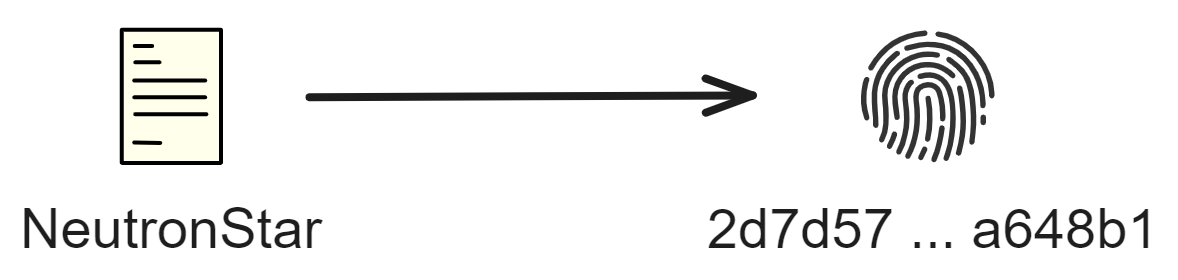

接下来,我们要了解一个重要的概念 —— 加密。在区块链中,每个区块都有一个独一无二的数字串,这个数字串叫做 “ 哈希值 ” 。哈希值是通过一个叫做 “ 哈希函数 ” 的算法生成的。这个算法非常神奇,即使只改动一个小小的信息,哈希值也会发生巨大的变化。这就保证了区块链的安全性,因为篡改任何一个区块的信息都会改变哈希值,同时影响到后面的所有区块。

另外一个关键的概念是 “ 去中心化 ” 。在传统的数据库中,数据是由一个中心化的机构控制的。这就意味着,如果这个机构出了问题,整个系统的安全性就会受到影响。而区块链却不同,它是由全球各地的成千上万台计算机共同维护的。这些计算机被称为 “ 节点 ” 。

区块链的去中心化特性意味着,它不依赖于单一的中心化实体来维护数据。传统的数据库是由一个中心化的机构控制的,这样的话,如果这个机构出了问题,整个系统的安全性就会受到影响。而区块链呢,是分布在全球各地的成千上万台计算机共同维护的。这些计算机被称为 “ 节点 ” 。一笔交易要被记录到区块链上,必须得到大部分节点的共识。这带来了很多优势,比如更高的安全性、更好的隐私保护、更低的运营成本等。在区块链中,一笔交易要被记录到区块链上,必须得到大部分节点的共识。这种共识机制保证了区块链的透明性和安全性。

那么,如何达成共识呢?这里我们以比特币为例。比特币采用了一种叫做 “ 工作量证明 ”(Proof of Work,简称 PoW)的共识机制。工作量证明的核心思想是,让节点参与竞争,通过解决一个复杂的数学问题来争夺记账权。谁先解决出这个问题,谁就有权将交易打包成一个新区块,并添加到区块链上。同时,其他节点会验证这个区块,确认无误后将其接受。这个过程就是所谓的 “ 挖矿 ” 。

挖矿的过程确保了区块链的安全性和去中心化特性。然而,这种方法也有一些问题。例如,它需要大量的计算能力和电力消耗。为了解决这个问题,出现了其他共识机制,如 “ 权益证明 ”(Proof of Stake,简称 PoS)和 “ 委托权益证明 ”(Delegated Proof of Stake,简称 DPoS)等。

权益证明(PoS)是一种更为环保的共识机制。在 PoS 系统中,节点的记账权取决于它们持有的货币数量。持有更多货币的节点有更高的概率获得记账权。这种方法减少了能源消耗,但可能导致货币分布不均的问题。

委托权益证明(DPoS)则是 PoS 的一种变体。在 DPoS 系统中,持币者可以将自己的货币权益委托给其他节点,让它们代表自己进行记账。这样可以进一步降低能源消耗,同时提高系统的效率和安全性。

区块链就像是一个公共的、安全的、分布式的账本。它可以用来记录交易、存储数据等等。目前,区块链技术已经应用到很多领域,比如金融、物联网、医疗等。未来的区块链技术还有很多可能性。其他的科技都是提升生产力,比如 AI 、VR 。而区块链改变的是生产关系。

重点在 2 点:

第一是用技术解决 “ 信任 ” 问题。

第二是在技术基础上 “ 自治 ” 。

比如类似《头号玩家》里面的若干年后的世界服游戏,角色和装备资产,必然要放在区块链存储,不然游戏公司或黑客就可以任意篡改数据了。

在区块链的世界里,你只要用一个区块链账户身份,就可以无需许可地加入任何网络,不用再为了使用某项服务而牺牲隐私或付出代价。跟 Web2 时代商业价值完全掌握在资本家的大平台不同,Web3 建立在去中心化的网络。应用开发者负责开发并部署到区块链平台,部署在区块链上之后就不能独占和使用用户数据。这将彻底改变商业逻辑和商业价值归属,打造一个更加公平的互联网商业环境,打破行业巨头的垄断。

区块链更加地强调平等、公正、民主、自治,这与共产主义社会的思想完全是一脉相承的。在区块链网络里,利益共享、民主自治的机制会抑制一切垄断巨头的产生,通过剥削用户和内容创作者剩余价值来积累财富的方式被彻底颠覆。

区块链的应用场景非常广泛,从日常生活、医疗保健到能源慈善、选举金融,覆盖方方面面:

数字货币:区块链最著名的应用就是数字货币了,比如比特币和以太坊。数字货币是一种基于区块链技术的虚拟货币,它可以用来进行点对点的交易,无需通过中心化的金融机构。

智能合约:智能合约是一种基于区块链的、自动执行的合同。它可以在满足特定条件时自动触发相应的操作,从而降低合同执行的成本和风险。以太坊等平台支持智能合约,使得开发者可以在区块链上构建各种去中心化应用(DApps)。

供应链管理:区块链可以用来追踪物品在供应链中的流转。这样可以提高供应链的透明度,防止假冒伪劣产品,降低成本。

身份认证:区块链可以作为一个去中心化的身份认证系统,帮助用户在网络中验证自己的身份。这可以减少依赖中心化机构,提高隐私保护。

版权保护:区块链可以用来存储和验证知识产权信息,防止盗版和伪造。这对于创作者和知识产权所有者来说是非常有价值的。

跨境支付:数字货币可以用来进行跨境支付,这样可以降低汇款的手续费和时间成本。

物联网:区块链可以用来记录和验证物联网设备的数据,保证数据的安全和完整性。

医疗保健:区块链可以用来存储和共享医疗数据,提高数据的安全性和可用性。这有助于提高医疗水平和降低医疗成本。

能源交易:区块链可以用来记录和验证能源交易,如太阳能、风能等可再生能源。这有助于实现能源市场的去中心化和提高能源利用效率。

选举投票:区块链可以用来构建透明、安全的选举投票系统。这可以防止选举舞弊,提高民主参与度

慈善公益:区块链可以用来追踪慈善捐款的流向,确保捐款真正用于有需要的人群。这有助于提高慈善透明度,增强公众对慈善组织的信任。

金融服务:区块链可以用于构建去中心化的金融服务平台,如借贷、保险、证券等。这可以降低金融服务的成本,提高金融体系的效率和安全性。

汽车产业:区块链可以用于记录汽车的生命周期信息,如生产、销售、维修等。这有助于提高汽车产业的透明度,防止二手车市场中的欺诈行为。

房地产:区块链可以用于记录房地产交易信息,简化房地产交易流程,降低交易成本。此外,通过智能合约,可以实现自动化的房地产交易。

教育:区块链可以用于存储和验证学历、证书等教育信息。这有助于防止学历造假,提高教育体系的公信力。

社交媒体:区块链可以用于构建去中心化的社交媒体平台,保护用户的隐私和数据安全。此外,区块链还可以用于激励内容创作者,实现公平的收益分配。

游戏产业:区块链可以用于游戏产业的虚拟资产交易、版权保护等方面。通过区块链技术,玩家可以在游戏中拥有真正的数字资产,实现跨游戏的资产流通。

人力资源:区块链可以用于人力资源管理,如记录员工的工作经历、技能、绩效等。这有助于简化招聘流程,提高招聘效率和准确性。

法律服务:区块链可以用于存储和验证法律文件,如合同、遗嘱等。这有助于提高法律服务的效率,降低法律服务的成本。

食品安全:区块链可以用于追踪食品在供应链中的流转过程,确保食品的安全和质量。这有助于防止食品安全问题,提高消费者的信心。

以上只是区块链技术在各个领域的部分应用。随着技术的发展和创新,区块链将会在更多领域发挥巨大的潜力。同时,我们也要关注区块链技术带来的挑战,如能源消耗、网络拥堵、隐私保护等问题。持续探讨和改进区块链技术,将有助于创造一个更加安全、透明和高效的价值互联网数字世界。

价值互联网是一个新兴的概念,是在信息互联网成熟之后,特别是移动互联网普及后出现的一种高级的互联网形式。价值互联网的核心特征是实现资金、合约、数字化资产等价值的互联互通。正如信息互联网时代实现了信息互联互通状态一样,在价值互联网时代,人们将能够在互联网上像传递信息一样方便快捷、安全可靠、低成本地传递价值。价值互联网与信息互联网之间并不是更替的关系,而是在信息互联网基础上增加了价值属性,从而逐渐形成实现信息传递和价值传递的新型互联网。

广义上讲,价值互联网的雏形可以追溯到 20 世纪 90 年代,美国安全第一网络银行(SFNB)从 1996 年开始开展网上金融服务,中国在 1998 年也有了第一笔网络支付。其后,很多金融机构借助互联网技术来拓展支付业务,并出现了第三方支付、大数据金融、网络金融门户等模式,以互联网金融为代表的价值互联网相关产业不断发展,价值互联网特征逐渐显现。尤其是 2010 年以来,随着互联网金融呈现爆发式增长,价值互联互通的范围和程度逐渐加大,价值互联网的规模和功能有了初步的发展。

区块链的出现,为价值互联网带来了新的发展空间,触发了一个新的发展阶段。可以说,在区块链出现之前,价值互联网处于一个非常初级的发展阶段,基本上是以一些中介化机构为中心的碎片化发展模式。而区块链在技术上具有去中心化、透明可信、自组织等特征,使得其应用更容易扩散为全球范围内的无地域界限的应用,为价值互联网注入了新的内涵。随着应用的逐渐发展,区块链将推进形成规模化的、真正意义上的价值互联网。

区块链在各领域的应用在信息互联网的基础之上,衍生出新型的价值存储和传递机制,推动了价值互联网的快速发展。区块链在各领域的应用案例和模式表明,其能够在提供基础设施、扩大用户规模、降低社会交易成本等方面有效地促进价值互联网建设,是未来价值互联网发展的关键技术。

云计算是一种能够通过网络,以便利的、按需付费的方式获取计算资源(包括网络、服务器、存储、应用和服务等)并提高其可用性的模式,这些资源来自一个共享的、可配置的资源池,并能够以最省力和无人干预的方式获取和释放。现阶段云计算不仅是一种分布式计算,还包括效用计算、负载均衡、并行计算、网络存储、热备份冗杂和虚拟化等计算机技术,是以上技术融合演进的结果。

当前云计算技术的产业发展中仍存在一些问题:第一,云计算市场极度中心化,少数几家互联网科技巨头依靠自身高度集中化的服务器资源垄断了整个云计算市场;第二,云计算过度集中导致算力服务价格居高不下,算力成为稀缺资源,极大地限制了企业上云的发展需求。

云计算是一种按使用量付费的模式,而区块链则是一个分布式账本数据库,是一个信任体制。从定义上看,两者似乎没有直接关联,但是区块链作为一种资源存在,具有按需供给的需求,也是云计算的组成部分之一,两者之间的技术可以相互融合。

依托区块链实现分布式云计算的架构,基于区块链的分布式云计算,允许按需、安全和低成本地访问最具竞争力的计算能力。去中心化应用(DApp)可通过分布式云计算平台自动检索、查找、提供、使用、释放所需的所有计算资源,同时使数据供应商和消费者等能够更易获得所需计算资源。用区块链的智能合约来描述计算资源的特征,可以实现按需调度。基于区块链的分布式云计算很可能成为未来云计算的发展方向。

“ 去中心化云 ” 旨在打造一个可扩展的、普适的无需信任计算底层。这是一种梦寐以求的技术,开发 Dapp 会变得非常简单,人们只需要发挥想象力创造,不受规模或通信复杂性的限制,创新可以持续复合而不会遇到收益递减。

这时的区块链大多是软件创新。当大众开始接受 “ 去中心化云 ” 时,可信的可组合性将成为开发者的超能力,当开发者能够以更少的资源做更多事情时,我们都会从互联网上更多的协作、创造力和选择中受益。

继续了解多米尼克的故事。

以太坊是一种去中心化的平台,允许开发者在其上构建各种应用。你可以把它想象成一个无须依赖中心服务器的全球计算机。这个计算机运行着智能合约——一种自动执行预定任务的程序。

智能合约,是 20 世纪 90 年代由 Nick Szabo 提出的理念,几乎与互联网同龄。由于缺少可信的执行环境,智能合约并没有应用到实际产业中,自比特币诞生后,人们认识到比特币的底层技术区块链天生可以为智能合约提供可信的执行环境。

以太坊是一个平台,它提供了各种模块让用户用以搭建应用,这是以太坊技术的核心。而平台之上的应用,其实也就是合约。以太坊提供了一个强大的合约编程环境,通过合约的开发,以太坊实现了各种商业与非商业环境下的复杂逻辑。支持了合约编程,让区块链技术不仅仅是发币,还提供了更多的商业、非商业的应用场景。

你可以把它想象成一个巨大的计算机,这个计算机可以运行各种各样的应用程序。但这个计算机不是一个实体的东西,而是一个由许多人共同维护的虚拟网络。这些人,我们称之为 “ 节点 ” ,它们分布在世界各地,共同维护着以太坊这个网络。

那么,以太坊与我们平常用的计算机有什么区别呢?最大的区别就是:以太坊是去中心化的。也就是说,数据不是存储在一个中心服务器上,而是分散在许多不同的节点上。这样一来,数据就不容易被篡改,也不容易被攻击,因为攻击者需要同时攻击成千上万个节点才能达到目的。

现在,我们知道了以太坊是一个去中心化的、巨大的计算机。那么,我们如何在这个计算机上运行应用程序呢?在以太坊上运行的应用程序,我们称之为智能合约。智能合约其实就是一段自动执行的程序代码。当某些条件满足时,智能合约就会自动执行相应的操作。这种自动执行的特性,让智能合约在金融、游戏、投票等许多领域都有广泛的应用。

举个简单的例子,我们可以用智能合约来实现一个自动支付的系统。比如说,你需要付款给一个人,但你希望在对方完成某项任务后再支付。你可以把钱存入智能合约,然后设定一个触发条件,当对方完成任务后,智能合约就会自动把钱转给对方。这样,你就不用担心对方拿了钱不干活,或者是自己忘记付款了。

为了在以太坊上运行智能合约,我们需要一种数字货币作为燃料。这种货币叫做 “ 以太币 ”(Ether),简称 ETH 。每当我们在以太坊上执行一个操作,都需要消耗一定数量的以太币。这些以太币会作为奖励,分给那些维护以太坊网络的节点。这个过程被称为“挖矿”。

要知道,以太坊上的智能合约不仅仅可以进行简单的转账操作。它们还可以用来创建一种全新的数字货币,这种货币我们称之为代币(Token)。代币可以代表任何东西,比如股票、积分、财产等。通过智能合约,我们可以轻松地在以太坊上发行自己的代币,然后用这些代币来进行交易。

以太坊上的代币有许多种类,其中最常见的是 ERC-20 代币。ERC-20 代币是一种遵循统一标准的代币,这个标准规定了代币的创建和交易方式。有了这个标准,不同的代币就可以互相兑换和交易了。这就像现实生活中的货币,虽然美元和欧元来自不同的国家,但它们之间仍然可以进行兑换。

除了 ERC-20 代币,还有一种叫做 ERC-721 代币的标准。这种代币非常特殊,因为它代表的是独一无二的、非同质化的资产。这些资产可以是艺术品、收藏品、房产等。有了 ERC-721 代币,我们可以在以太坊上进行独特资产的交易,而不用担心伪造或者复制。这也是为什么许多加密艺术品、收藏品等在以太坊上进行交易的原因。

那么,以太坊有什么实际应用呢?事实上,以太坊已经在很多领域产生了影响。比如我举几个例子:

以太坊可以用来进行金融业务。通过智能合约,我们可以创建去中心化的金融产品,比如借贷、保险、衍生品等。这些金融产品不需要中介机构,因此可以降低成本,提高效率。同时,智能合约的透明性也可以降低欺诈的风险。

以太坊可以用来进行供应链管理。通过智能合约,我们可以实时追踪商品的来源、流通路径等信息。这样一来,消费者可以确保购买的商品是真实可靠的,而企业可以更好地监控供应链,提高效率。

以太坊还可以用来进行身份认证。通过智能合约,我们可以创建一个去中心化的身份系统,让用户在不同的平台之间共享认证信息。这样,用户就不用每次都重新提交自己的个人资料,同时还能保护自己的隐私。

虽然以太坊具有很多优势,但它也有一些局限性。比如,以太坊目前的交易速度和扩展性还有待提升。为了解决这些问题,以太坊团队正在进行一系列的升级,以太坊 2.0 旨在解决以太坊 1.0 中存在的性能瓶颈和可扩展性问题。这次升级将会对以太坊的性能产生以下几个方面的影响:

-

更高的吞吐量:以太坊 1.0 目前的交易处理速度受到限制,每秒只能处理大约 30 笔交易。以太坊 2.0 通过引入分片技术,将网络分成多个独立的子链,这可以大大提高整个网络的交易处理能力。预计以太坊 2.0 的吞吐量将能达到每秒数千笔交易。

-

更低的延迟:以太坊 1.0 中,每个区块的出块时间约为 15 秒。这意味着用户需要等待一段时间才能确认自己的交易。以太坊 2.0 将采用新的共识机制,降低出块时间,从而减少用户在交易确认上的等待时间。

-

更环保的共识机制:以太坊 1.0 采用的是能源密集型的工作量证明(Proof of Work,PoW)共识机制。以太坊 2.0 将会逐步过渡到权益证明(Proof of Stake,PoS)共识机制,这是一种更为环保、高效的共识方式。权益证明机制下,验证节点(验证者)需要锁定一定数量的以太币作为抵押,根据抵押的金额获得出块权。这样可以降低能源消耗,提高网络的安全性。

-

更高的安全性:以太坊 2.0 引入了一种名为“验证者”的新角色,取代了以太坊 1.0 中的矿工。通过权益证明机制,验证者需要抵押一定数量的以太币才能参与共识过程。这样的设计使得攻击以太坊 2.0 网络的成本变得更高,从而提高了网络的安全性。

-

更好的可扩展性:以太坊 2.0 的分片技术和其他优化措施可以提高网络的可扩展性。

尽管以太坊为区块链世界带来了很多创新,但它仍然存在一些缺点,主要包括以下几点:

- 扩展性问题:以太坊虽然对扩展性做了升级,但这并不意味着永久解决了扩展性的问题。这不是一劳永逸的工程,如果用户持续增加,工程师们还需要继续扩展改进以太坊。

- 交易费用仍然比较高:因为以太坊的处理能力有限,所以用户为了让自己的交易更快地被处理,通常需要支付更高的手续费。这导致了以太坊上的交易费用变得昂贵,使得一些用户和开发者难以承受。在网络拥堵时,交易确认可能需要很长时间,同时还可能导致交易费用上升。

- 中心化问题:尽管区块链的初衷是去中心化,但是传统的区块链技术存在着部分中心化的问题,这使得某些节点对整个网络的控制力过大,带来了安全风险和操纵风险。

- 隐私保护问题:传统的区块链技术存在隐私保护方面的问题,一旦交易数据被记录在区块链上,将永久保存,这会带来很大的隐私泄露风险。

- 开发和维护成本:构建和维护区块链应用程序可能需要高昂的开发和运维成本。此外,区块链技术的不断发展,使得开发者需要不断更新和优化现有应用。

对比来看 IC 具有以下特点,可以解决以太坊的一部分问题:

- 无限的扩展性:IC 使用了一种名为 “ Chain Key ” 的技术,它能够让网络更高效地运行。IC 还将网络分成许多子网,每个子网络负责处理一部分消息。这样,整个网络的处理能力就大大提高了,可以更好地应对高交易量。

- 更低的交易费用:由于 IC 的扩展性更好,网络可以处理更多的交易,这意味着用户不再需要支付高昂的手续费来加快交易速度。因此,Dfinity 的交易费用会相对较低。

- 共识算法:IC 采用了一种名为 PoUW 的共识算法,这是一种基于 BLS 阈值签名的随机共识算法。与其他权益证明 (PoS) 或工作量证明 (PoW) 系统相比,PoUW 旨在提供更高的安全性和性能。

- 可扩展性和性能:IC 的设计使其具有高度的可扩展性和性能。通过采用分层体系结构、子网 (Subnet) 和并行处理等技术,IC 的互联网计算机能够支持大量并发交易和智能合约执行。与其他公链相比,IC 的目标是实现更高的吞吐量和低延迟。

- 互操作性:IC 的互联网计算机构想是支持各种去中心化应用和服务的平台。尽管互操作性并非其主要关注点,但 IC 的设计允许开发人员轻松地在互联网计算机上构建和部署各种应用程序,从而实现跨应用程序的协同作用。

- 更简单的开发过程和更容易维护:IC 旨在降低开发者的学习成本和开发难度。它允许开发者使用更多种熟悉的编程语言编写智能合约。这使得开发者可以更容易地上手和开发去中心化应用。

- 更强大的安全性:IC 还提供了一种网络自治机制,网络可以自我修复和升级,这有助于提高整个网络的安全性和稳定性。

- 安全性和去中心化:IC 的共识算法和网络设计旨在实现高度的安全性和去中心化。与其他公链相比,IC 采用了一些创新的技术,如阈值中继和分布式密钥生成,以提高网络的抗攻击能力。

- 开发者体验:IC 提供了一组友好的开发工具和资源,包括 Motoko 编程语言和 SDK。还可以在本地环境完成代码调试,不需要测试网。这使得开发者能够轻松地为互联网计算机构建和部署应用程序。与其他公链相比,IC 致力于简化去中心化应用程序的开发过程。

IC 试图解决以太坊等现有区块链平台所面临的诸多问题,如扩展性、交易费用、能源消耗和开发复杂性等。通过采用创新的技术和设计,IC 为开发者和用户提供了一个更高效、更安全、更易用的去中心化计算平台。当然,IC 也不是没有挑战,它仍然需要在实际应用中证明自己的价值,但它的目标是成为一种可行的区块链技术解决方案,以满足未来去中心化应用的需求。

IC 旨在成为一个无限可扩展的、去中心化的全球计算基础设施。IC 的目标和愿景:IC 的目标是创建一种新型的互联网基础设施,这种基础设施可以支持各种去中心化应用,同时具备高可扩展性、安全性和性能。与其他公链类似,IC 致力于解决传统区块链技术的局限性;但它的愿景是创建一个更大的互联网生态系统,而不仅仅是一个区块链平台。

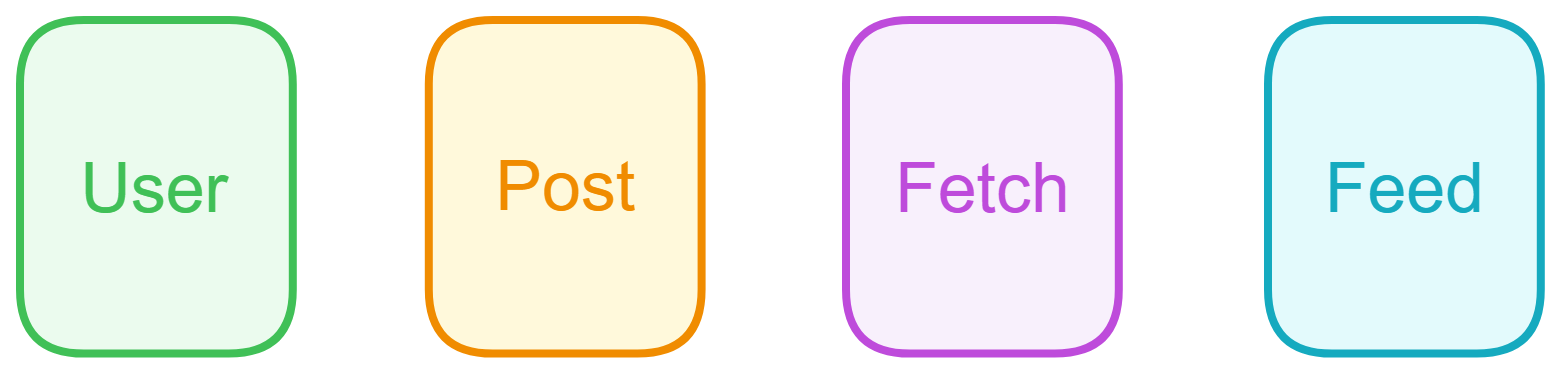

我的隐私⊙﹏⊙∥

这是个比较严重的问题,虽然互联网可以存你的数据,但你的数据不一定会被互联网永久保存。因为现在大多数应用的后台是 “ 独立 ” 的。每个公司都有自己维护的服务器,要么自建机房要么用云服务。所有用户都通过访问他们的服务器来传输网络信息,和其他用户交互。一旦公司宣布停服,你的数据也就都没了。

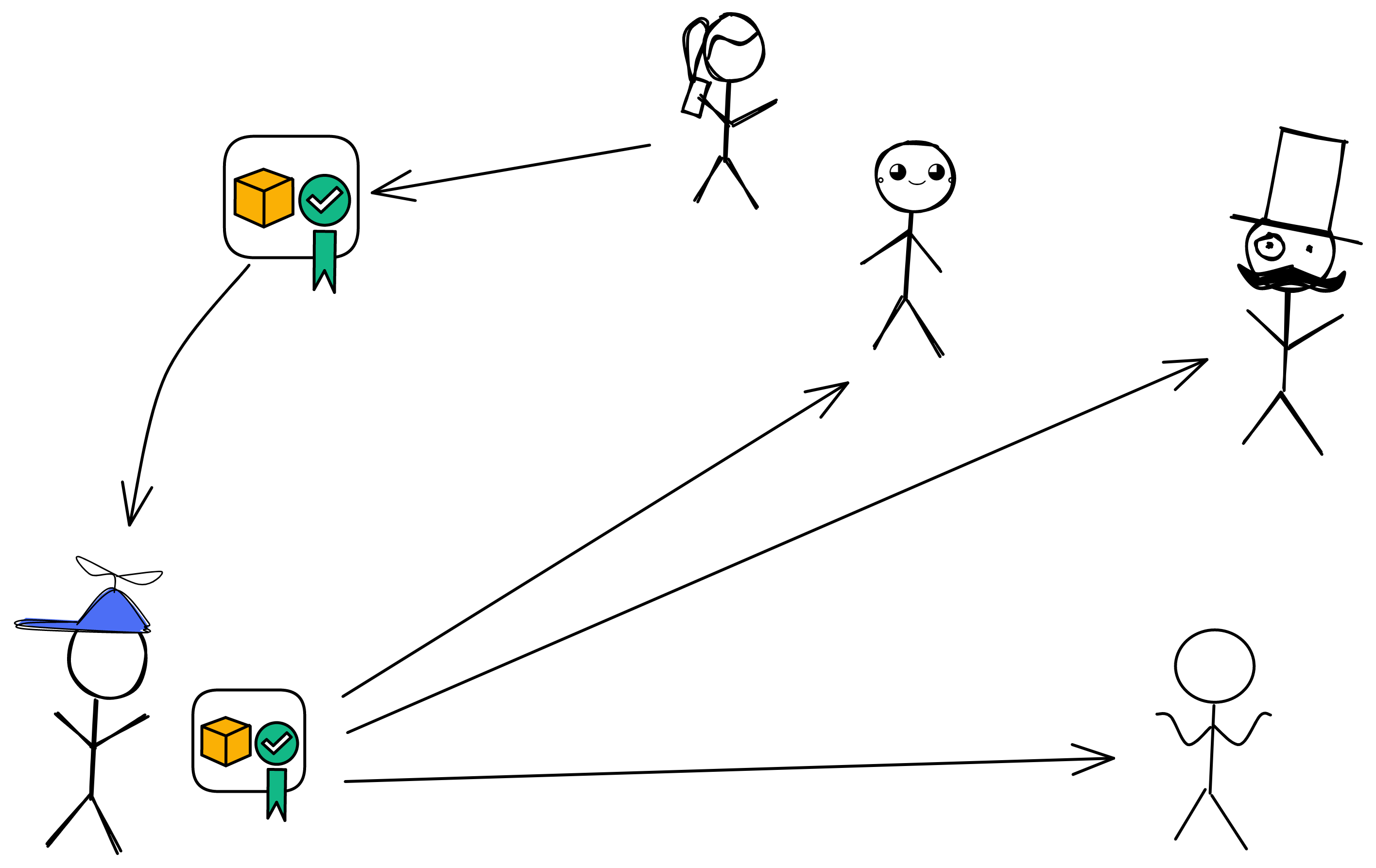

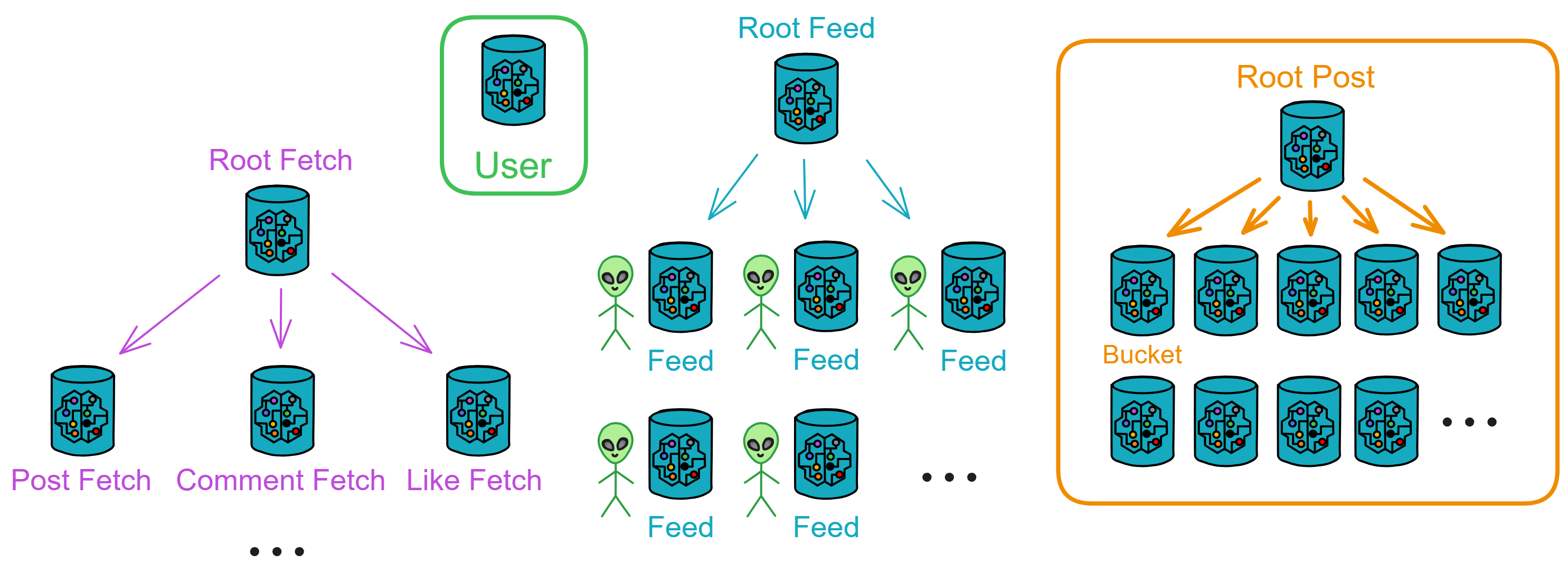

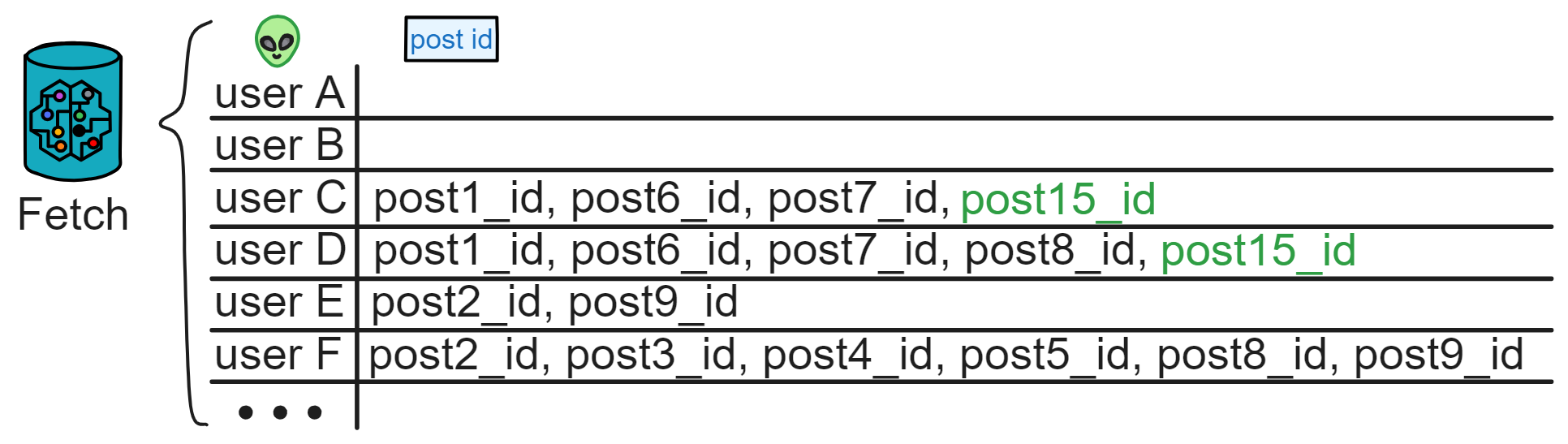

比如抖音是这样的:

每个公司的服务器为用户提供自家的网络服务:

数据在带来信息时代便利的同时亦会引发数据滥用、个人隐私泄露、企业商业秘密受侵犯等诸多问题。你的数据被一股脑地传进了他们的服务器里。他们控制着服务器,怎么处理服务器里的数据,人家说了算。虽然工程师们负责只研究 AI 推荐算法,不偷看你的数据。你喜欢什么只有 AI 知道,存储在服务器中,而且那么多用户的数据也看不过来。但是当他们想要查找某个人的时候,管理层还是可看到各种数据的。

数据包含你的隐私,你今天买了什么东西,聊天说了什么,喜欢看什么,晚上想吃什么,口味偏好,买衣服的身高体重,地图定位 ...... 都能通过数据分析出来。他们完全可以监视你在网络中的一举一动。

你可能会说:谁让他们看我数据啦?非礼呀!救命啊!有没有人管?

但我还是得说句公道话。其实在刚安装 App 的时候,他们都会让你勾选一个《用户协议》,或者好听一点叫《用户体验改善计划》。虽然几乎没人会完整看一遍《用户协议》,但已经跟你 “ 约定 ” 好了,你要把自己的使用数据交给他们。不然就不能用!😡

虽然表面上是你先同意了《用户协议》,然后他们才 “ 用 ” 你的数据改善体验。

至于他们拿数据去做了什么,没人知道。

我们已经知道的有棱镜计划,2018 年 Facebook 上亿用户数据泄露事件,2020 年 7 月 Amazon 因违反欧盟《一般数据保护条例》被欧盟隐私监管机构处以 7.46 亿欧元罚款,这也是欧盟有史以来最大的数据隐私泄露罚款。国内的美团、饿了么等外卖平台也曾被爆出用户资料遭泄露、倒卖,精确到了订餐内容、地址等私密信息;李彦宏:中国人对数据隐私可以更开放,愿用隐私换效率 ......

而且他们觉得不好的内容、对他们不利就可以直接删掉,不用你同意。(当然,非法内容肯定要删掉的)

(︶^︶)

鲁迅先生在《秋夜》的开篇写道:“在我的后园,可以看见墙外有两株树,一株是枣树,还有一株也是枣树。” 当下互联网面临的情况,也可以说是: 当我打开手机,一个 App 要读取我的隐私,另一个 App 也要读取我的隐私。 不然就不能用。

大数据时代个人隐私数据泄露已成为全球重大的社会问题。互联网平台大规模采集用户数据,并将用户的个人信息长期集中化储存,数据一旦泄露就是大规模的群体事件,不仅侵犯用户的隐私权、侵害公民生命财产安全,还将对互联网企业自身造成不可预估的经济损失,数据泄露后对企业声誉的负面影响也很难消除。

就在上周,2023 年 3 月 21 日,拼多多被谷歌强制下架,并提示已安装拼多多的用户尽快将其卸载。这还是谷歌第一次提示用户卸载一个 App 。随后著名反病毒软件实验室卡巴斯基证实了拼多多利用安卓系统漏洞肆意收集用户信息、破解系统屏蔽机制、篡改手机系统记录、隐匿自己行踪、常驻系统后台运行监控手机、逃避系统清理进程、读取手机输入法信息的情况。

靠!想存个信息这么难,还不如刻在石头上呢!

这种现象的本质在于用户没有自己的数据权。自己的数据,居然自己没有数据权!

用户本应该有权了解自己的个人信息被收集、使用、分享的情况,有权决定自己的个人信息被如何使用、分享,以及有权控制自己的个人信息被如何收集、存储和使用。那如果我想删除一些隐私数据呢,嘿嘿,你想删掉的内容,你还不知道他们会不会真的删掉,他们甚至可以把信息隐藏起来,自己偷偷保存着。

尾声

如果你在维基百科搜索去中心化,你会看到这样一条描述:“ 相对于早期的互联网(Web 1.0)时代,Web 2.0内容不再是由专业网站或特定人群所产生,而是由全体网民共同参与、权级平等的共同创造的结果。任何人都可以在网络上表达自己的观点或创造原创的内容,共同生产信息。 ” 。

继续了解关于区块链的未来。

不同于传统的货币,比特币是完全虚拟的。

比特币隐匿于发送者和接收者间价值传递的交易中。比特币用户拥有能够使他们在比特币网络中证明自己交易权的密钥,解密后可使用比特币,也可以将它购买、出售,以及与其他币种进行兑换。由于比特币快捷、安全以及无国界的特性,在某种意义上,比特币就是互联网货币的完美形态。

比特币是一个分布式的点对点网络系统。因此,没有 “ 中央 ” 服务器,也没有中央控制点。

比特币开创性的提出了一个分布式计算问题的解决方案。

中本聪的此项发明,对 “ 拜占庭将军 ” 问题也是一个可行的解决方案,这是一个在分布式计算中未曾解决的问题。简单来说,这个问题包括了试图通过在一个不可靠、具有潜在威胁的网络中,通过信息交流来达成一个行动协议共识。中本聪的解决方案是使用工作量证明的概念在没有中央信任机构下达成共识,这代表了分布式计算的科学突破,并已经超越了货币广泛的适用性。

说到比特币的缘起,就不得不谈到一个略显神秘的团体:密码朋克(Cypherpunk)。这个团体是密码天才们的松散联盟,比特币的创新中大量借鉴了密码朋克成员的贡献。密码朋克这个词一部分来源于密码(Cipher),这在密码学中意为用于加密解密的算法;一部分来源于赛博朋克(Cyberpunk),指那个时代流行的一个科幻流派。这样的组合有很微妙的意味,散发着改变社会的激进理想。

密码朋克们的观点是:现代社会不断蔓延着对个人隐私和权利的侵蚀。他们互相交流着对这一问题的看法,并认为在数字时代保护隐私对于维持一个开放社会是至关重要的。这一理念在比特币中得到体现:去中心化的追求,对匿名的拥抱。密码朋克本身就是数字货币最早的传播者,在其电子邮件组中,常见关于数字货币的讨论,并有一些想法付诸实践。比如大卫·乔姆、亚当·贝克、戴伟、哈尔·芬尼等人在早期数字货币领域做了大量的探索。

比特币并不是数字货币的首次尝试。据统计,比特币诞生之前,失败的数字货币或支付系统多达数十个。正是这些探索为比特币的诞生提供了大量可借鉴的经验。

大卫·乔姆(David Chaum)是一位密码破译专家,也是 20 世纪八九十年代密码朋克的 “ 主教 ” 级人物。他是很多密码学协议的发明者,他在1981年的研究奠定了匿名通信的基础。1990 年,创建了数字现金公司(DigiCash),并试验了一个数字化的货币系统,称为 Ecash 。在他的系统中,付款方式是匿名的,而收款方不是。更精确的说法是,Ecash 是个人对商家的系统。他发明的这个货币系统还有部分绕过中间商的特质,数字现金公司作为可信的第三方来确认交易,避免重复消费,保证系统诚实。

亚当·贝克(Adam Back)是一位英国的密码学家,1997 年,他发明了哈希现金(Hashcash),其中用到了工作量证明系统(Proof of Work)。这个机制的原型可用于解决互联网垃圾信息,比如作为垃圾邮件的解决方案。它要求计算机在获得发送信息权限之前做一定的计算工作,这对正常的信息传播几乎不会造成可以察觉的影响,但是对向全网大量散布垃圾信息的计算机来说,这些计算会变得不可承受。这种工作量证明机制后来成为比特币的核心要素之一。

哈伯和斯托尼塔(Haber and Stornetta)在 1997 年提出了一个用时间戳的方法保证数字文件安全的协议。对它的简单解释是,用时间戳的方式表达文件创建的先后顺序,协议要求在文件创建后其时间戳不能改动,这就使文件被篡改的可能性为零。这个协议成为比特币区块链协议的原型。

戴伟(Wei Dai)是一位兴趣广泛的密码学专家,他在 1998 年发明了 B-money 。B-money 强调点对点的交易和不可更改的交易记录,网络中的每一个交易者都保持对交易的追踪。不过在 B-money 中,每个节点分别记录自己的账本,这不可避免地会产生节点间的不一致。戴伟为此设计了复杂的奖惩机制以防止节点作弊,但是并没有从根本上解决问题。中本聪发明比特币的时候借鉴了很多戴伟的设计,并和戴伟有很多邮件交流。

哈尔·芬尼(Hal Finney)是 PGP 公司的一位顶级开发人员,也是密码朋克运动早期和重要的成员。2004 年,芬尼推出了自己的电子货币,在其中采用了可重复使用的工作量证明机制(RPOW)。哈尔·芬尼是第一笔比特币转账的接受者,在比特币发展的早期与中本聪有大量互动与交流。由于身患绝症,哈尔·芬尼已于 2014 年去世。

比特币的诞生

比特币诞生于 2008 年 9 月,以雷曼兄弟的倒闭为开端,金融危机在美国爆发并向全世界蔓延。为应对危机,世界各国政府和中央银行采取了史无前例的财政刺激方案和扩张的货币政策并对金融机构提供紧急援助。这些措施同时也引起了广泛的质疑。

2008 年 10 月 31 日下午 2 点 10 分,在一个普通的密码学邮件列表中,几百个成员均收到了自称是中本聪(Satoshi Nakamoto)的人的电子邮件,“ 我一直在研究一个新的电子现金系统,这完全是点对点的,无需任何可信的第三方 ” ,然后他将收件人引向一个九页的白皮书,其中描述了一个新的货币体系。同年 11 月 1 日,自称是中本聪的人在网络上发表了比特币白皮书《比特币:一种点对点的电子现金系统》,阐述了以分布式账本技术、PoW 共识机制、加密技术等为基础构建的电子现金系统,这标志着比特币的诞生。其实比特币白皮书英文原版并未使用 “ Blockchain ” 一词,而是使用的 “ Chain of Blocks ” 。最早的比特币白皮书中文翻译版中,将 Chain of Blocks 翻译成了区块链。这是 “ 区块链 ” 这一中文词词汇最早出现的时间。

两个月后(2009 年 1 月 3 日),第一个(序号为 0 )创世区块诞生,意味着比特币从理论步入实践。几天后(2009 年 1 月 9 日)出现了序号为 1 的区块,并与序号为 0 的创世区块相连接形成了链,标志着区块链的诞生。

2015 年《经济学人》杂志以 “ 区块链,信任的机器 ” 为封面文章,指出比特币背后的技术可以改变经济运作模式,称 “ 区块链让人们可以在没有一个中心权威机构的情况下,能够对互相协作彼此建立起信心。简单地说,它是一台创造信任的机器 ” 。此后,比特币及区块链获得民众越来越多的关注。

关于比特币的资料网上很多,这里就不展开详细介绍了。

继续了解加密朋克早期的故事。

概述

什么是 IC 和 ICP ?

-

IC 的全称是互联网计算机(Internet Computer),是专门为去中心化应用设计的高速区块链网络。

-

ICP 是互联网计算机协议(Internet Computer Protocol),也是代币的名称。

互联网计算机(IC)的出现为软件开发带来了革命性的变化。它让开发者能够直接在去中心化云上构建应用,摆脱了对传统中心化云服务的依赖,降低了开发和运维的成本。IC 的安全性和高性能使得应用和服务的安全性得到极大的提高。

IC 的愿景是成为一个提供无限扩展性、安全性和去中心化治理的全球性计算平台。

IC 是通过结合分片、VRF 随机数、BLS 阈值签名、DKG 、嵌入 DAO 治理模型等技术构建的高性能去中心化云服务。

那它性能到底有多高呢?

子网们的目前确认区块速度为一秒 36 个区块。

目前每秒可以处理 6355 笔交易。

这里可以查到 IC 网络上的实时数据 。随着子网越来越多,这个数据在未来也会越来越高。(TPS 无上限😎)

目前( 2023 年 6 月)每个区块包含 1000 条信息,也就是说,一个子网一秒处理 1000 条更新调用消息(实际数据略低于 1000 条消息 / 秒,大概是 970 条 / 每秒)。每个子网约 970 次更新 / 秒,约 4000 次查询 / 每个节点。

软件开发的新时代

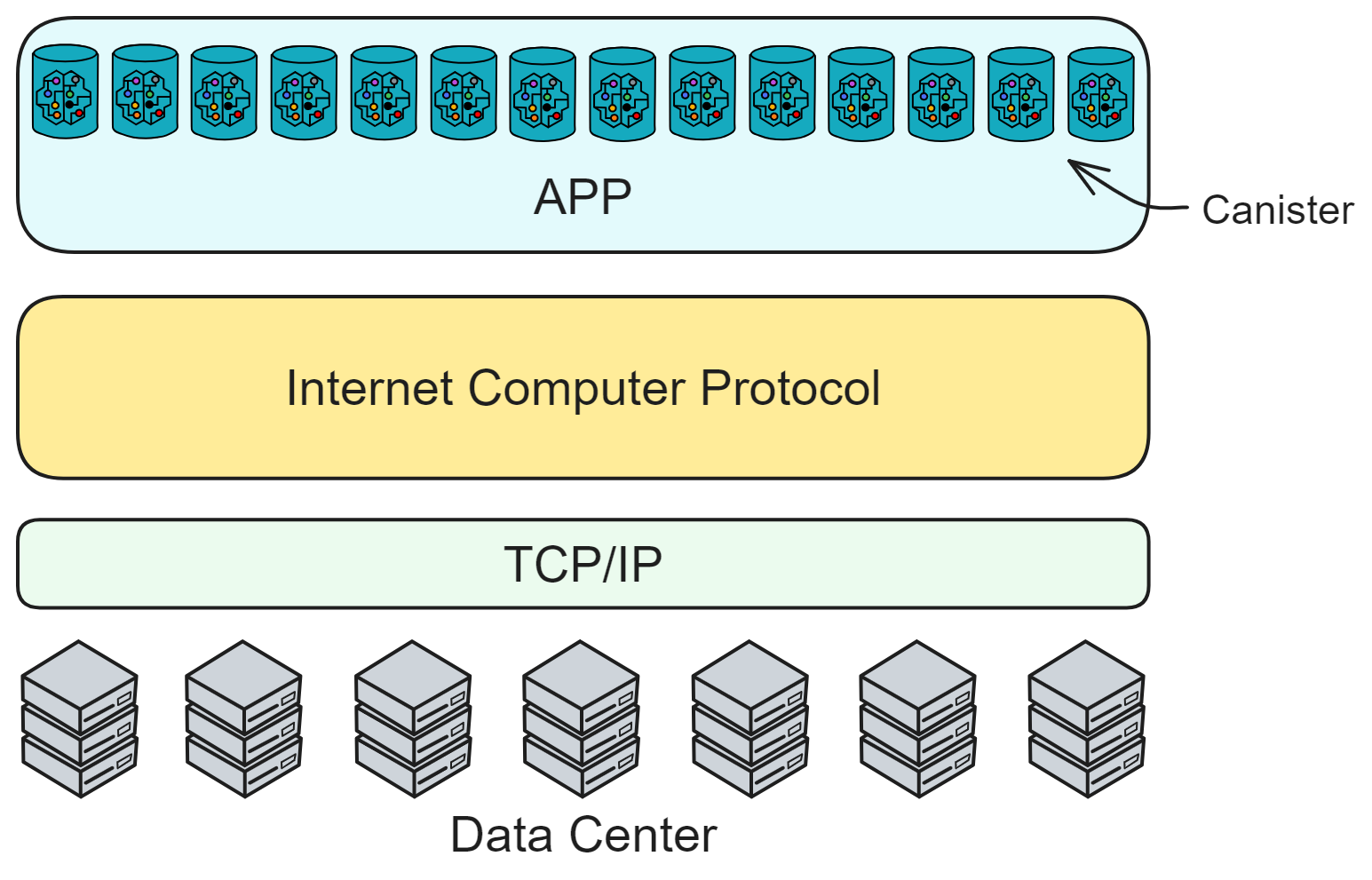

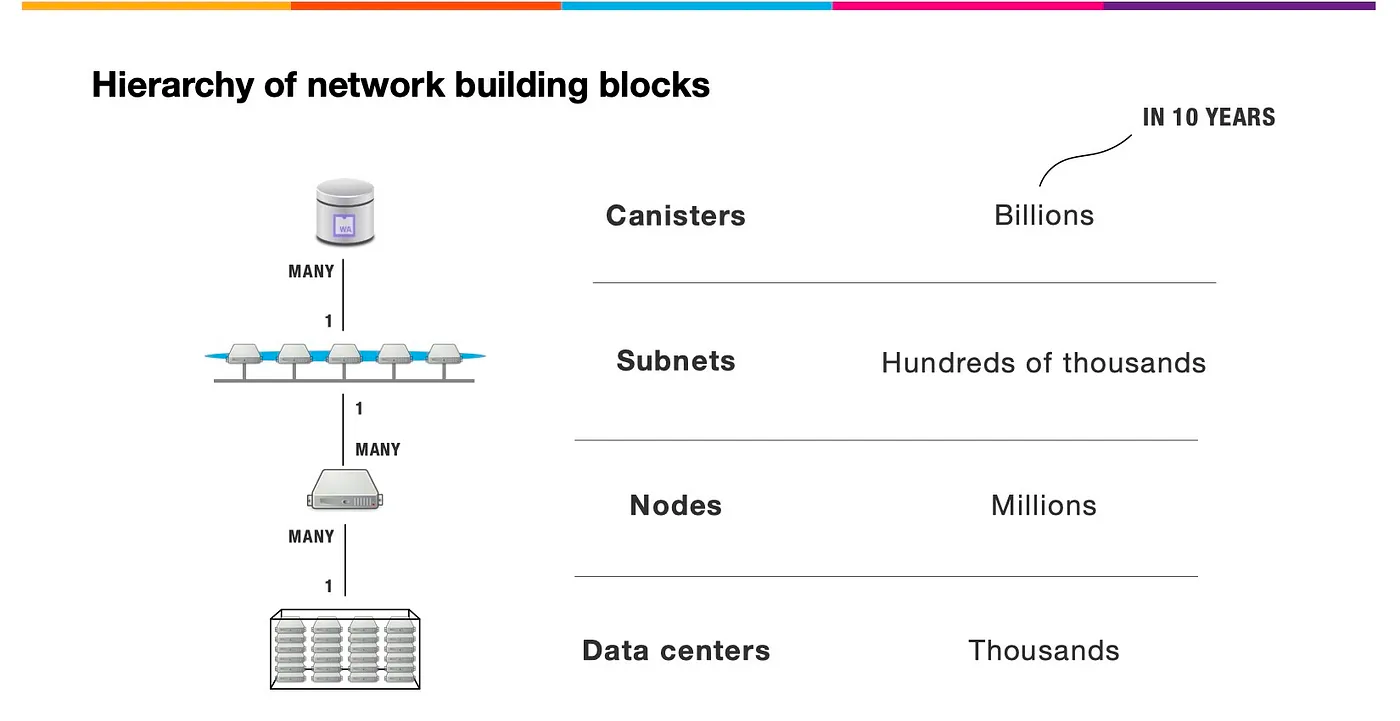

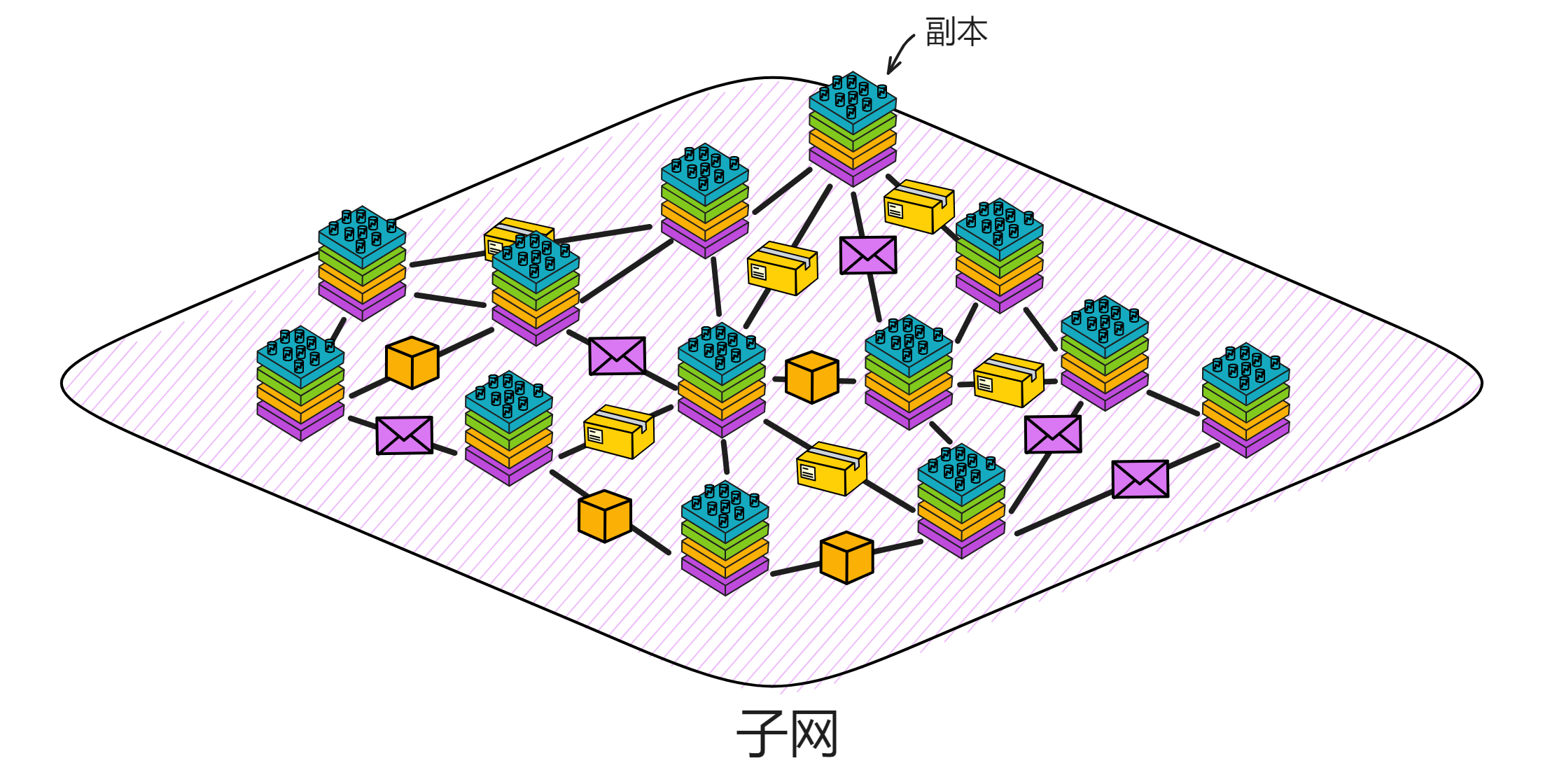

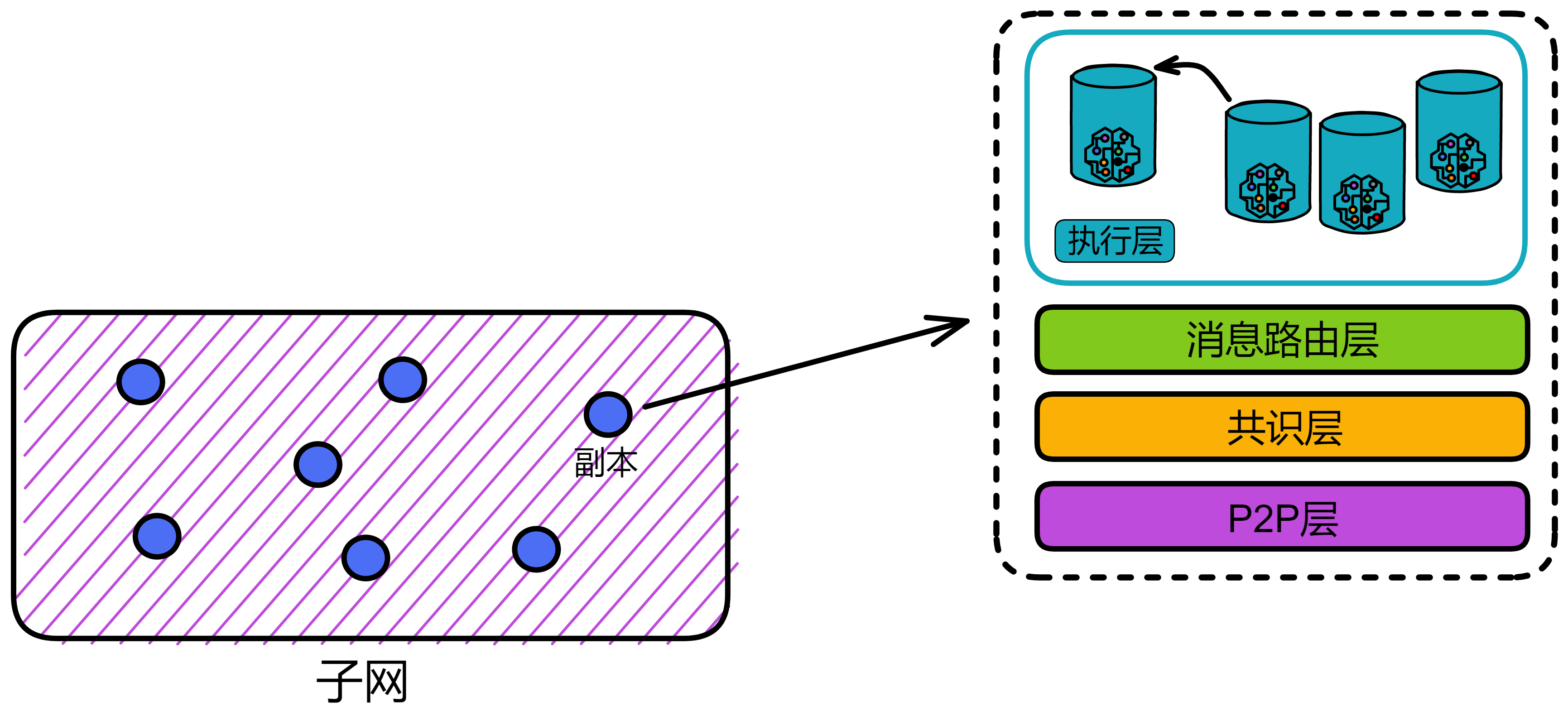

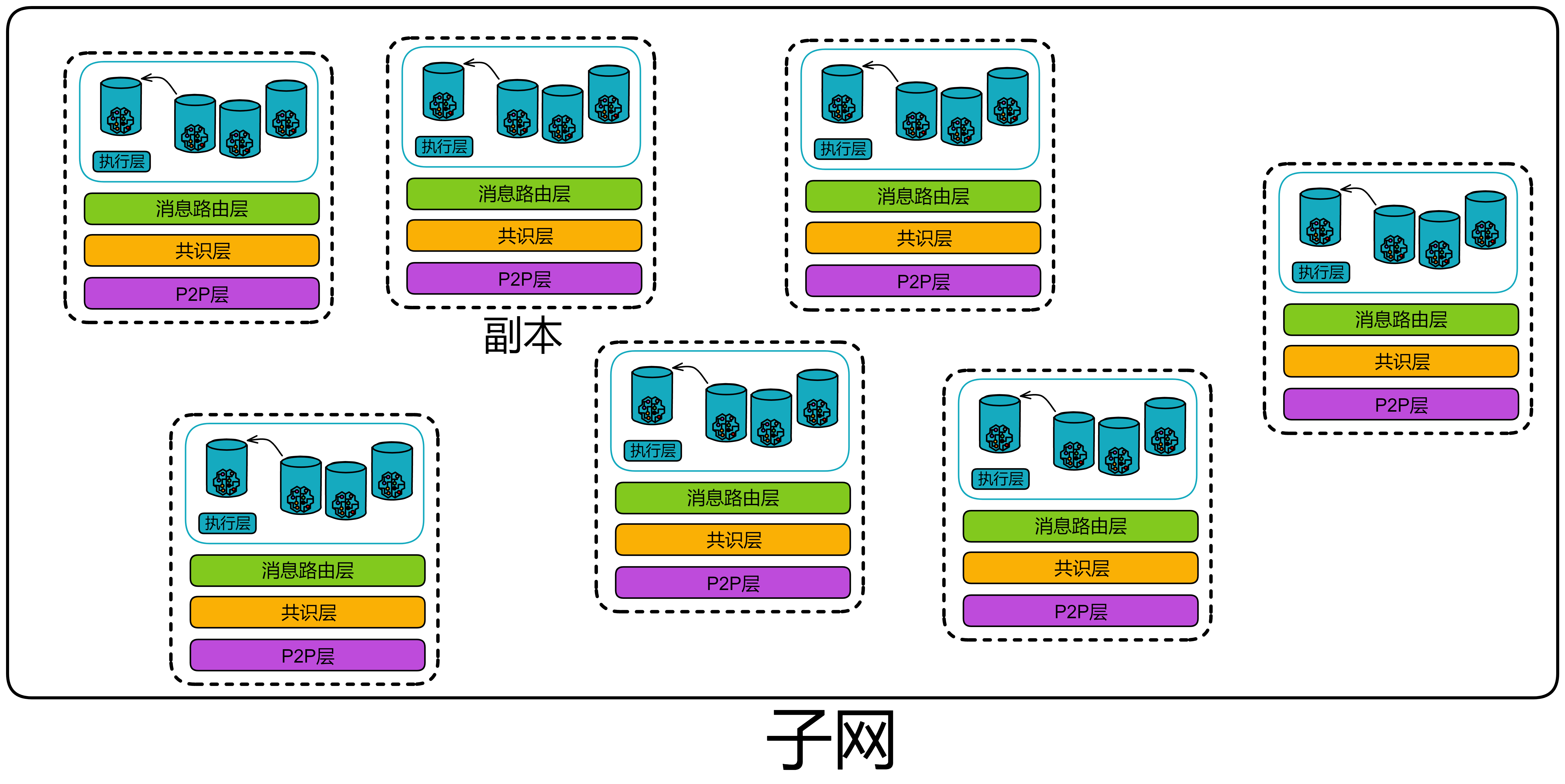

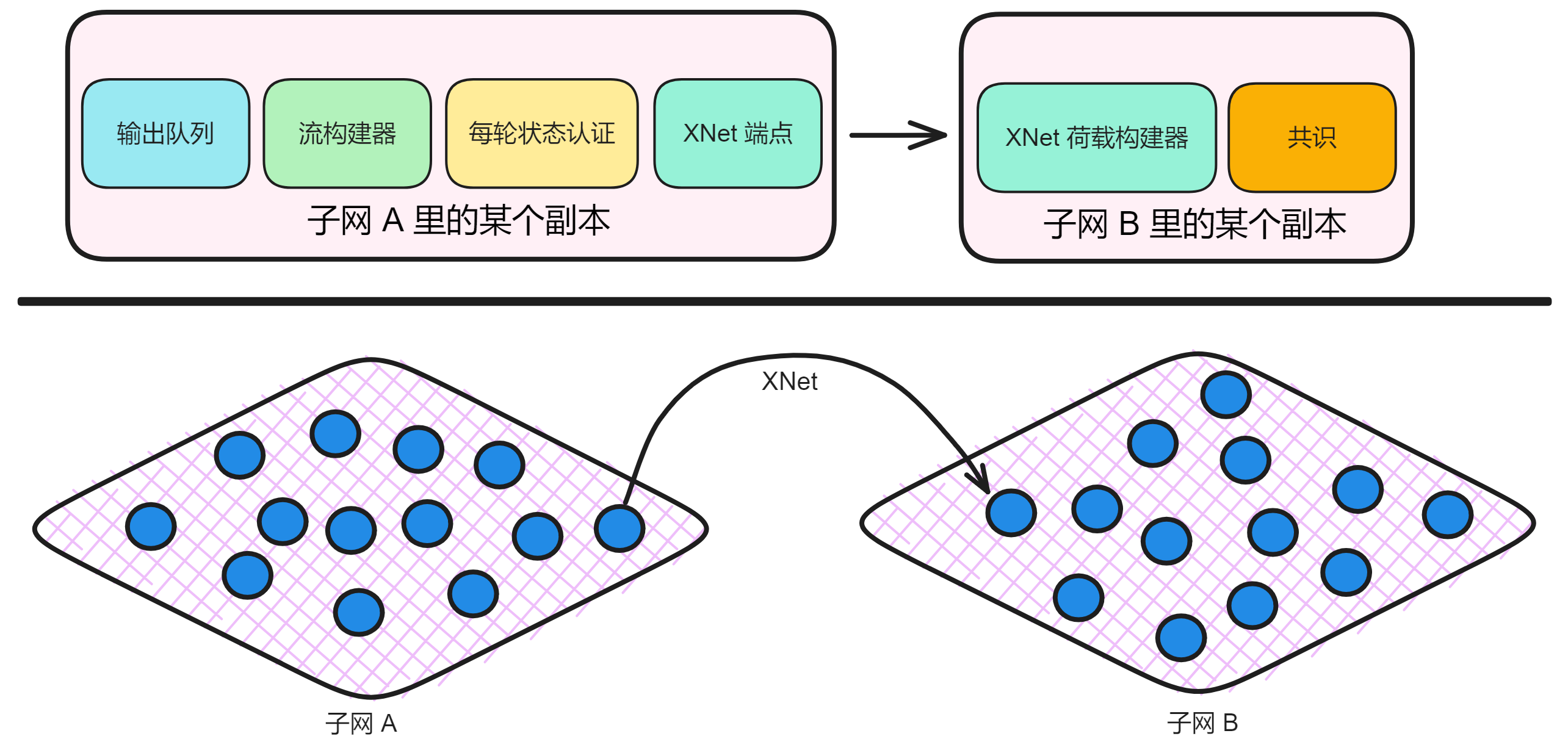

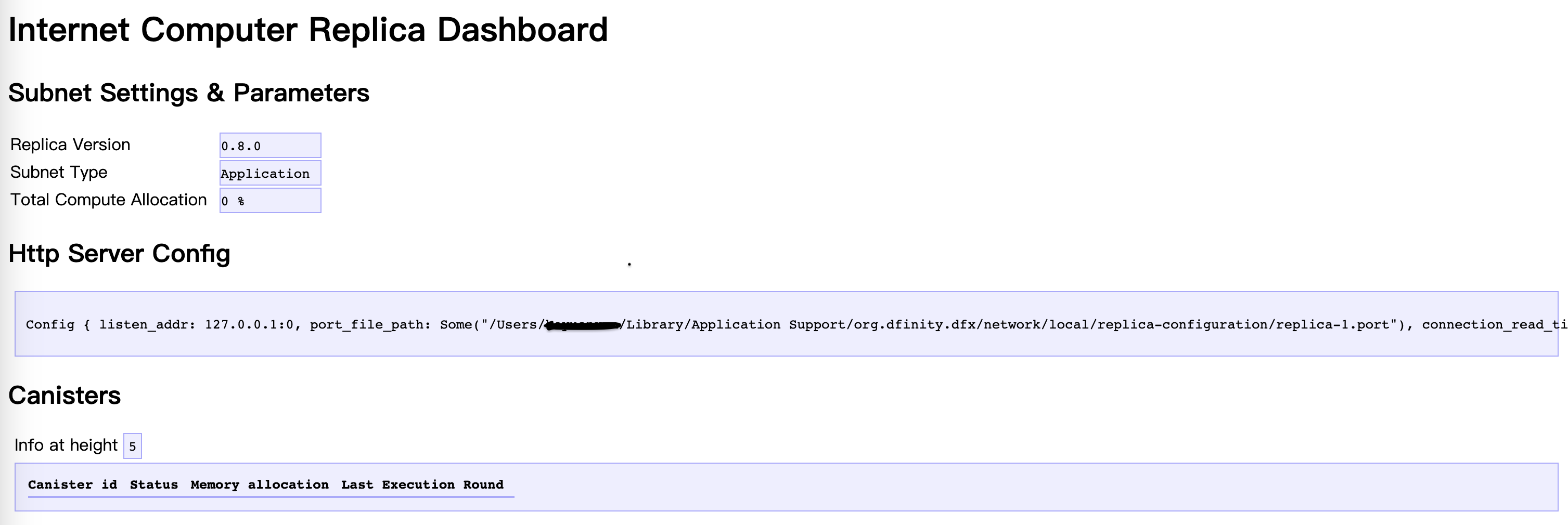

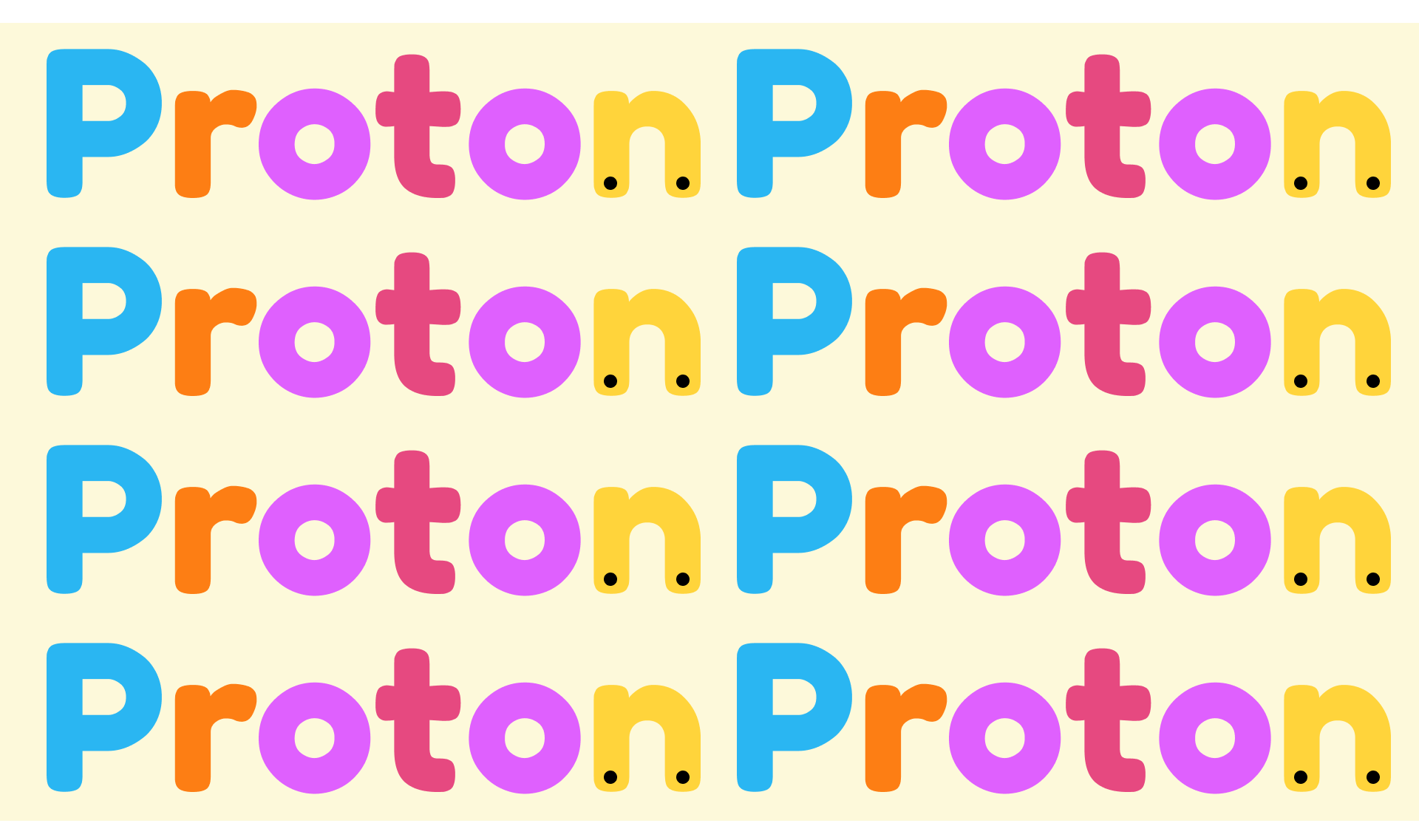

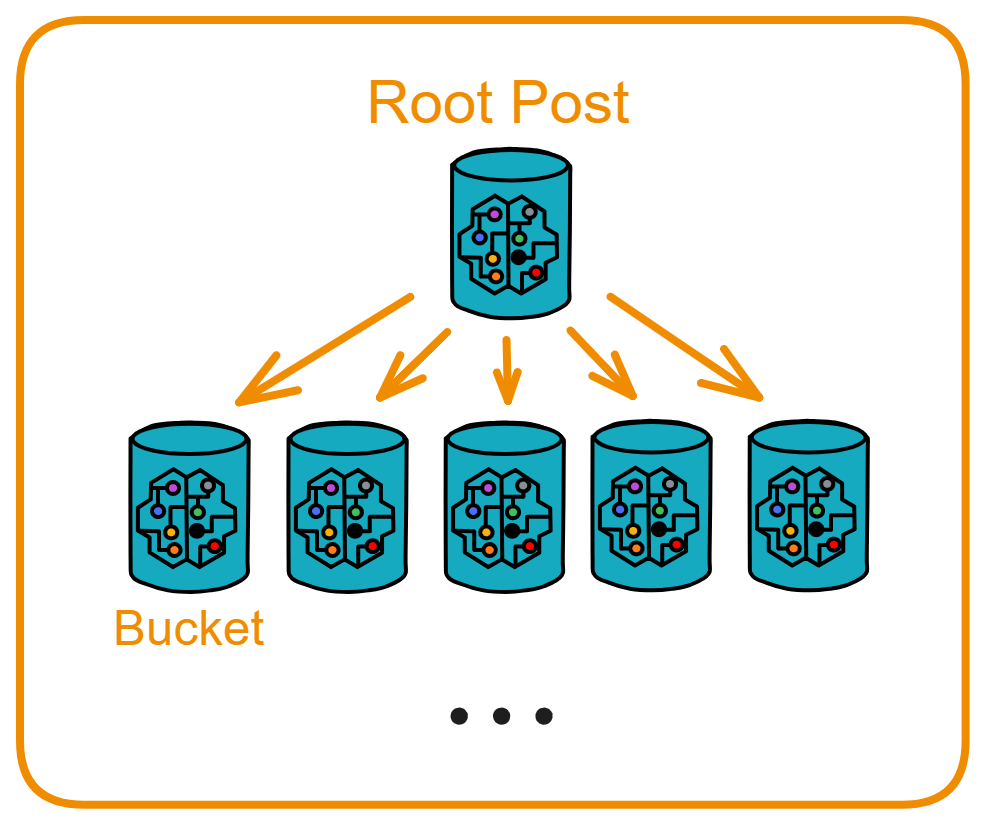

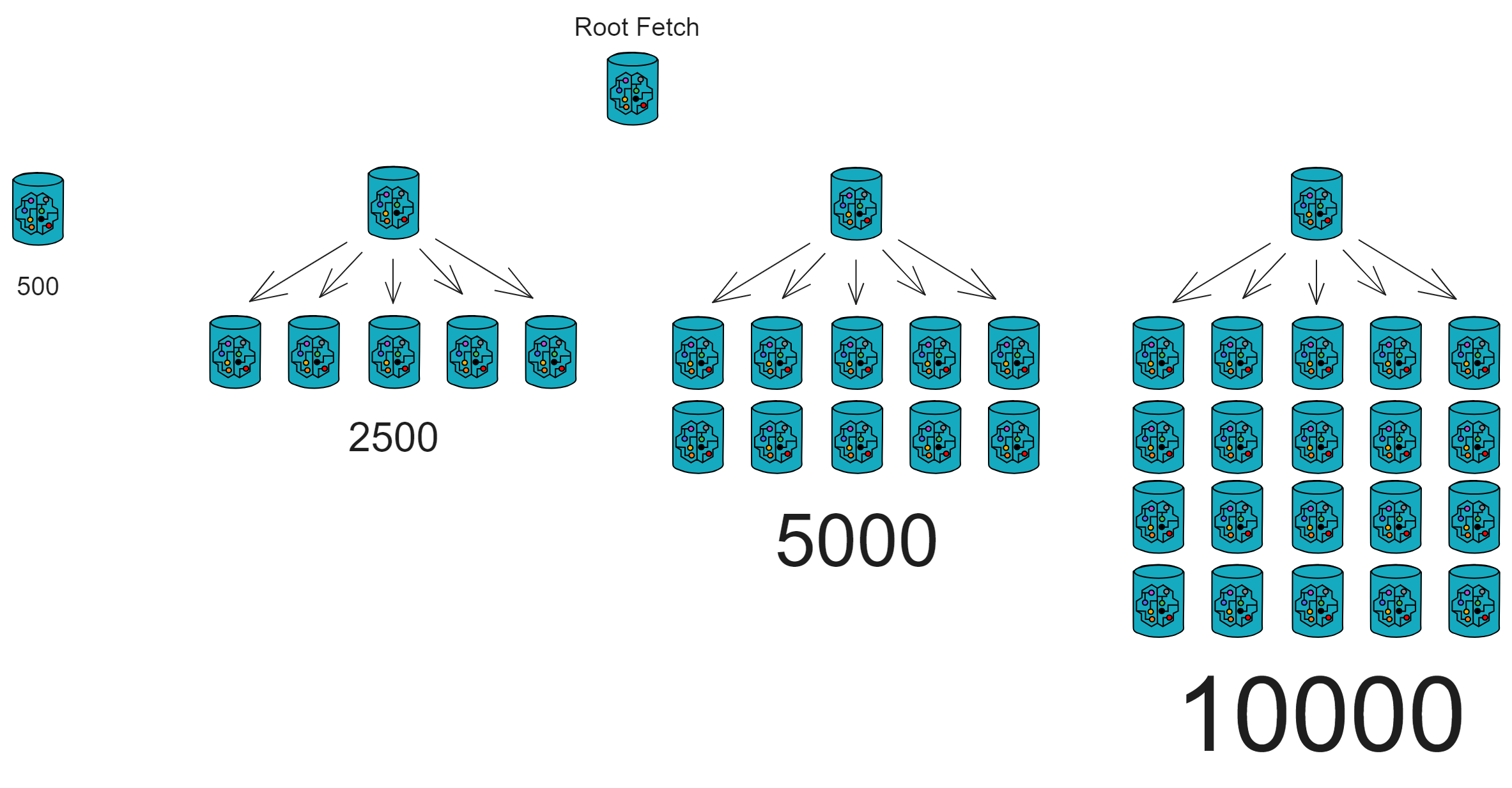

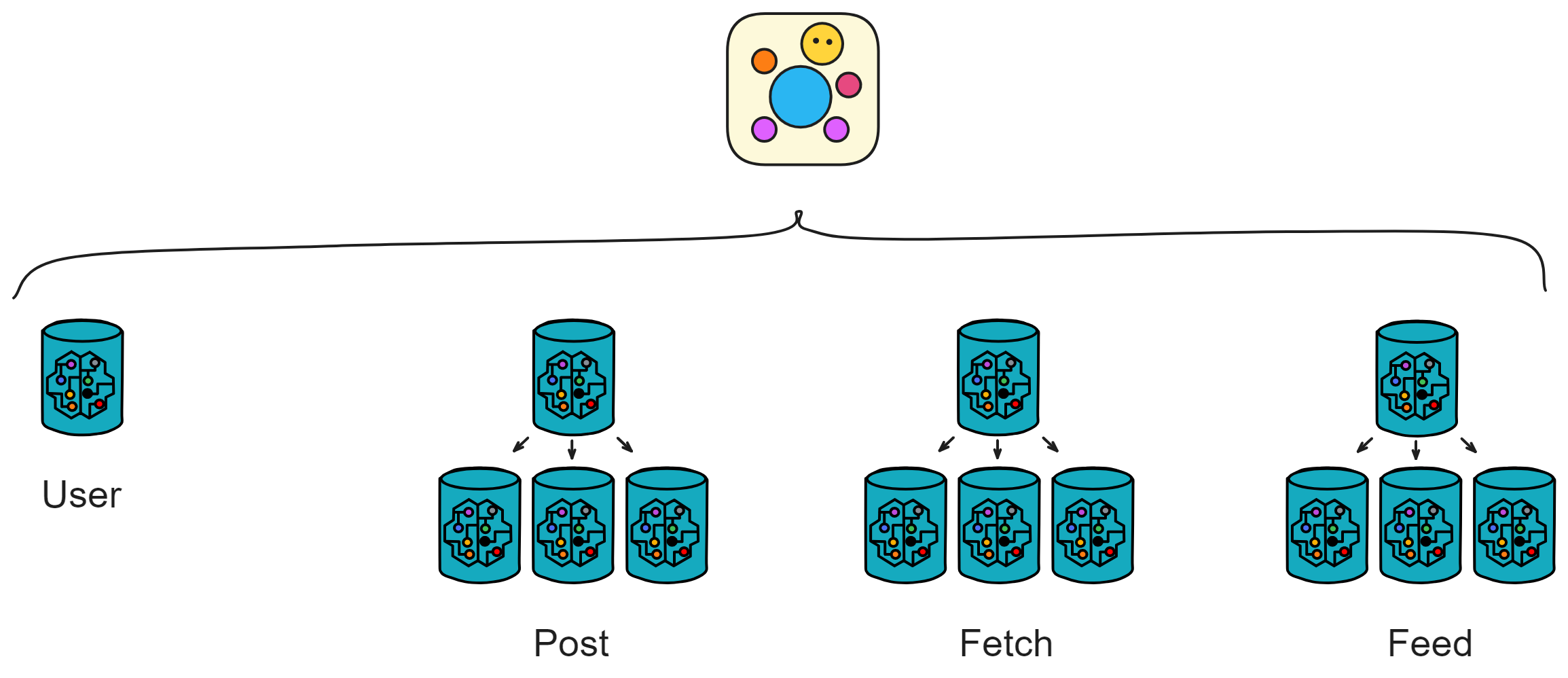

互联网计算机(IC)是基于互联网计算机协议构建的一种全新的区块链设计。它的核心部分分为 4 层,运行在各个子网的节点上。通过运行核心协议,一个子网的节点实现了一个基于区块链的复制状态机,该状态机独立于其他子网取得进展(但与它们异步通信)。IC 采用多子网分片结构,在保持去中心化的同时,克服了传统区块链的性能瓶颈。这种架构可以使 IC 无限生成子网(分片),使 IC 几乎不受限制地扩展。

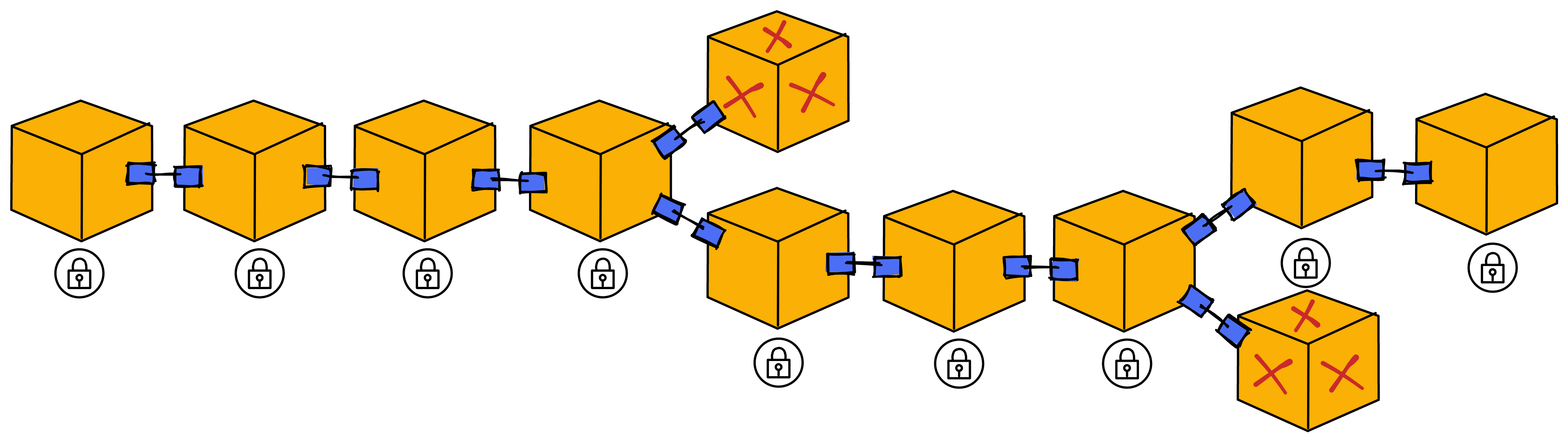

在传统不分片的区块链中,通常在一段时间里只产生一个块,全网所有的矿工竞争唯一的挖矿权,或者针对一个块达成共识。为了提高吞吐量和延迟,通常只能通过提高区块生产速度或者增加区块的大小来完成扩容。这两种方式都存在缺点(频繁分叉或者网络延迟)。

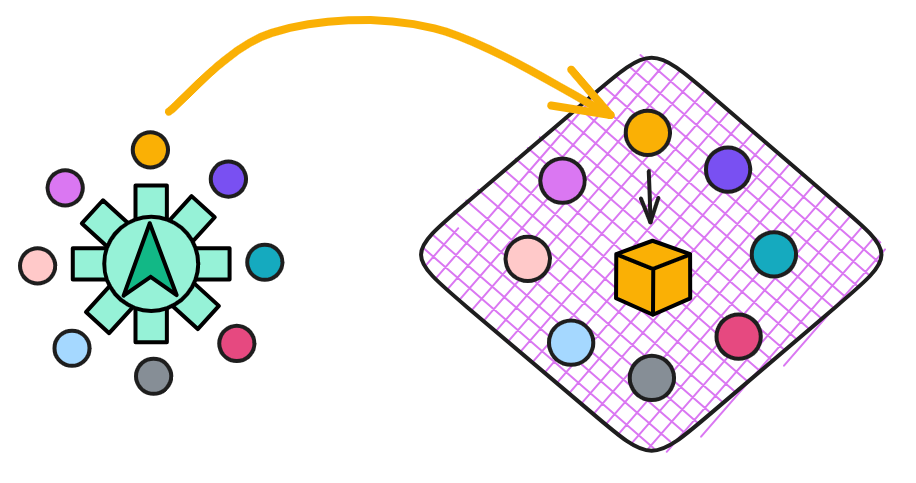

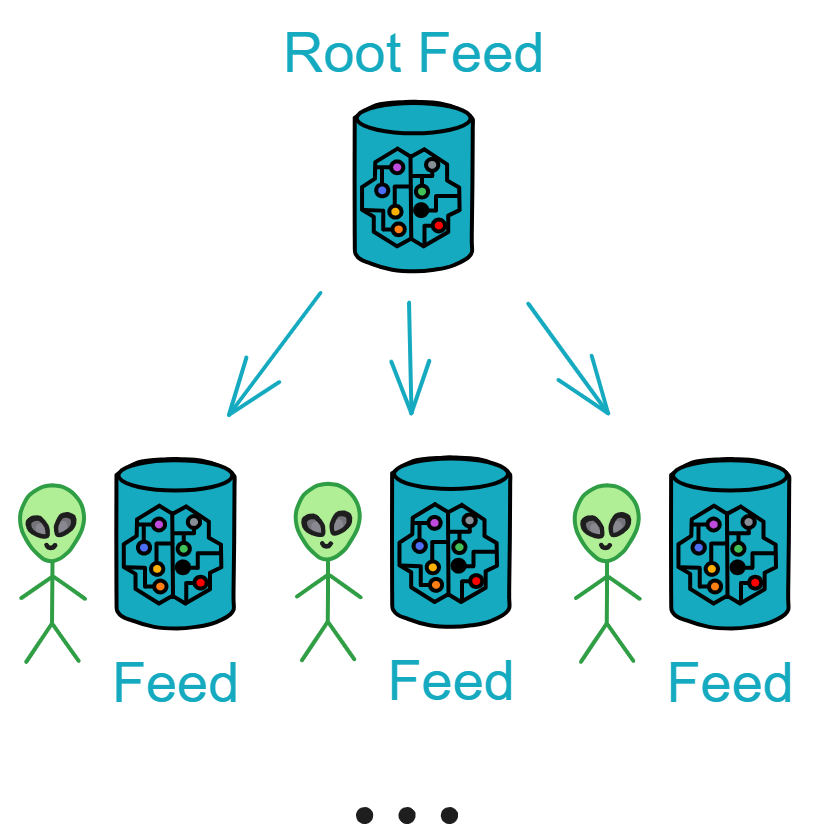

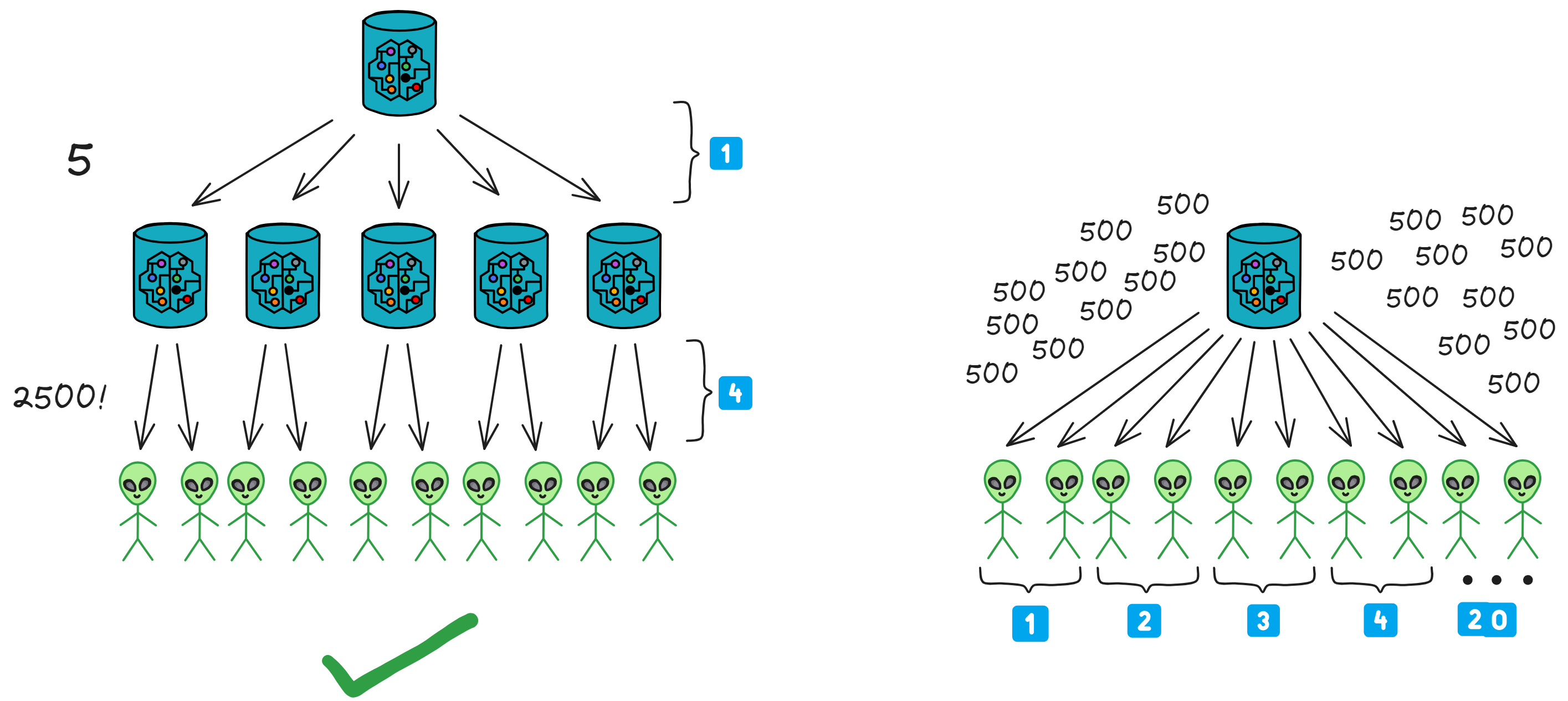

IC 通过创建新子网来横向扩展其容量,就像传统的云基础设施通过添加新机器来扩展一样。一旦 IC 的网络神经系统(Network Nervous System, NNS)决定创建一个新子网,它就会选择一组尚未分配到任何子网的备用节点,并创建新子网的初始配置。然后,选定的节点组成一个新的子网区块链。

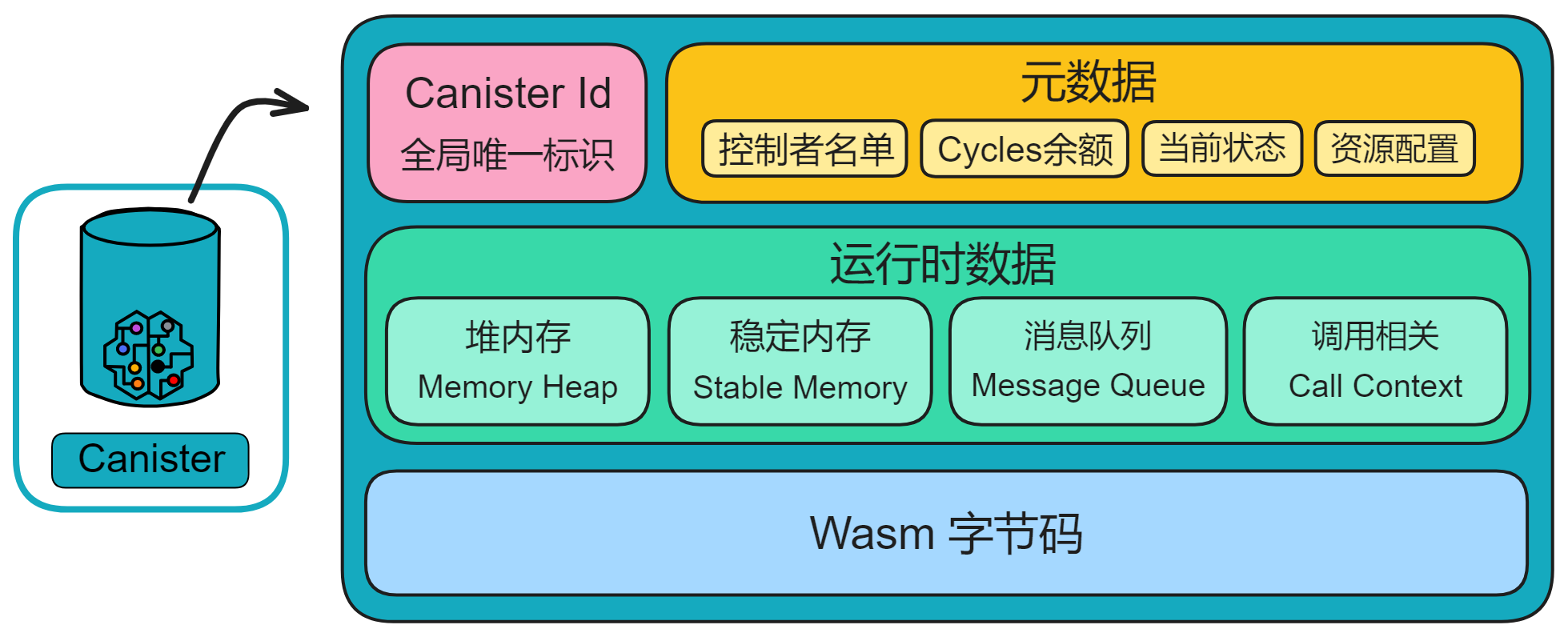

IC 摆脱了智能合约在传统区块链上的速度、存储成本和计算能力方面的限制。使智能合约实现完全的去中心化,前端到后端都能被托管在区块链上。IC 的智能合约叫 Canister (罐子、容器)。Canister 可以存储数据,对数据进行通用计算,并提供完整的技术栈,直接为终端用户提供网络访问服务。

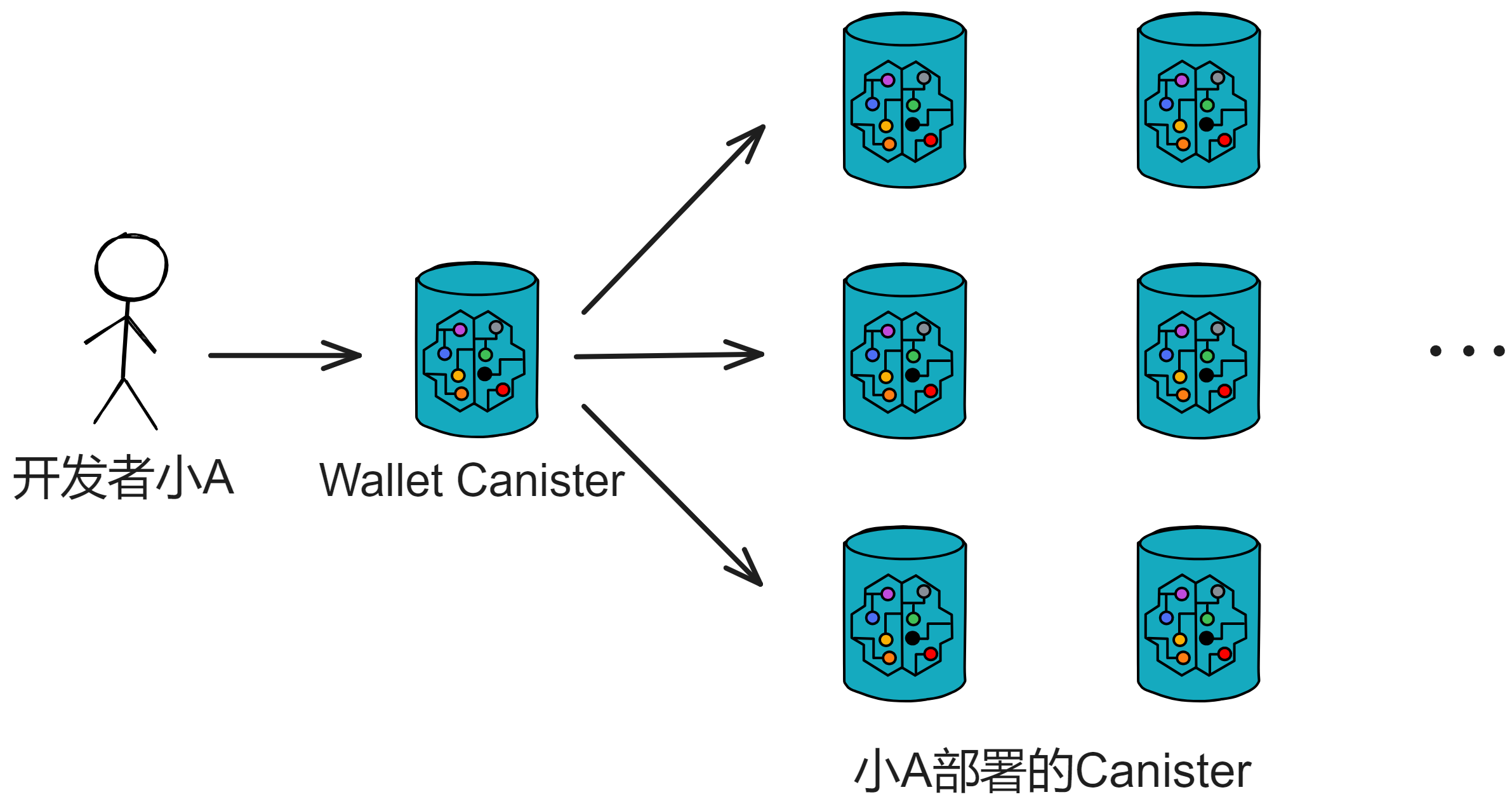

计算和存储开销采用 “ 反向 Gas 模型 ” ,Gas 费由部署 Canister 的开发人员将原生代币 ICP 兑换成 Cycles 支付。ICP 代币同时也用于治理:IC 由去中心化自治组织(以下简称 DAO )进行管理。IC 底层直接嵌入了 DAO :Network Nervous System。DAO 可以决定变更 IC 的网络拓扑结构和升级 IC 协议。

IC 还可以与其他区块链互操作。IC 的链密钥密码学技术使其能够与其他区块链进行交互,集成其他加密货币。

IC 使用 WebAssembly(Wasm)作为代码执行的标准,所以开发者可以使用多种流行的编程语言(如 Rust、Motoko、Java 等)编写智能合约。

传统 IT 开发者面临许多问题:必须通过众多商业云服务、云工具、操作系统的专有和开源变体、数据库和防火墙等组件、虚拟化技术,软件开发平台等等一系列的关卡,要去解决组装系统的高度自定义、维护它们所需的特殊开发人员的人工成本,以及相关的供应商关系,使得随着需求的变化、迁移和调整旧系统变得昂贵且困难的问题。随之而来的便是高昂的开发运维成本,以及中心化存储数据的安全问题。

IC 可以让开发者在一个开放世界中构建应用、企业系统和互联网服务类 APP ,在基于区块链去中心化理念下,保证它可以安全运行并且可以经受住时间的考验。IC 可以自动扩展、抵抗攻击、从不宕机。这种新颖的设计使开发者能专注于创造新应用和服务,而不用担心底层基础设施的安全性、成本和可扩展性。这对于软件开发的新时代具有深远的影响。

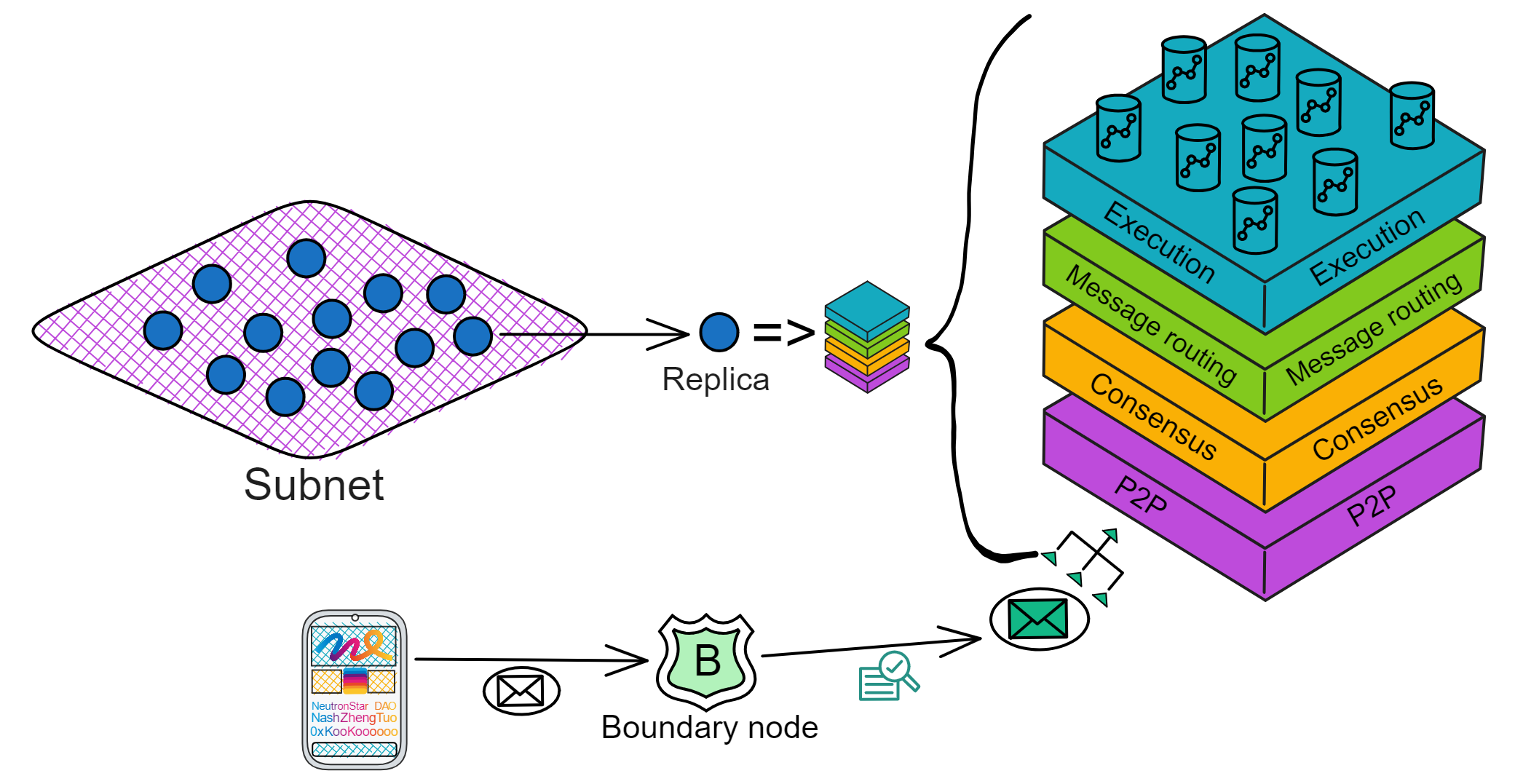

架构

IC 的架构特立独行:

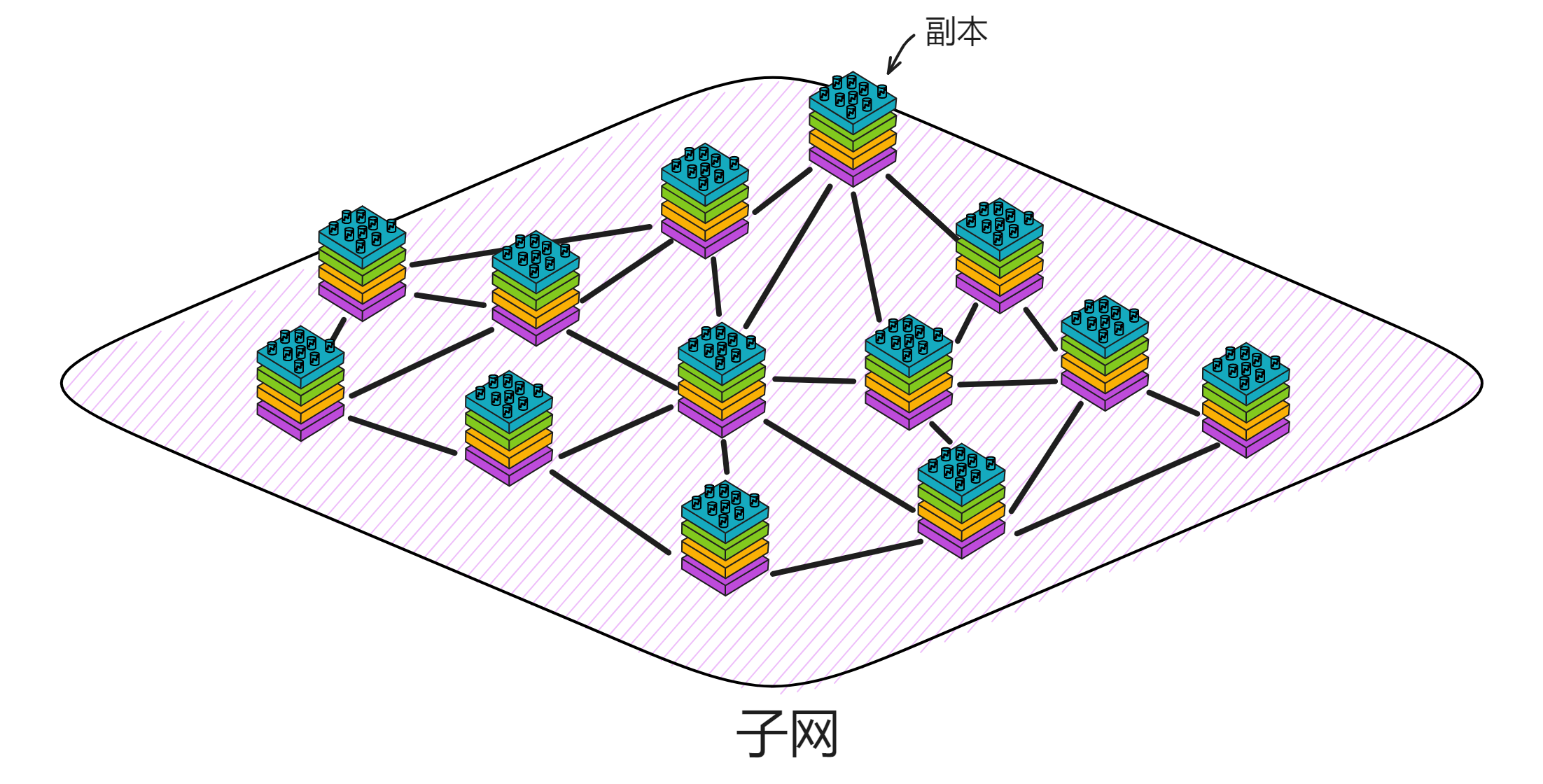

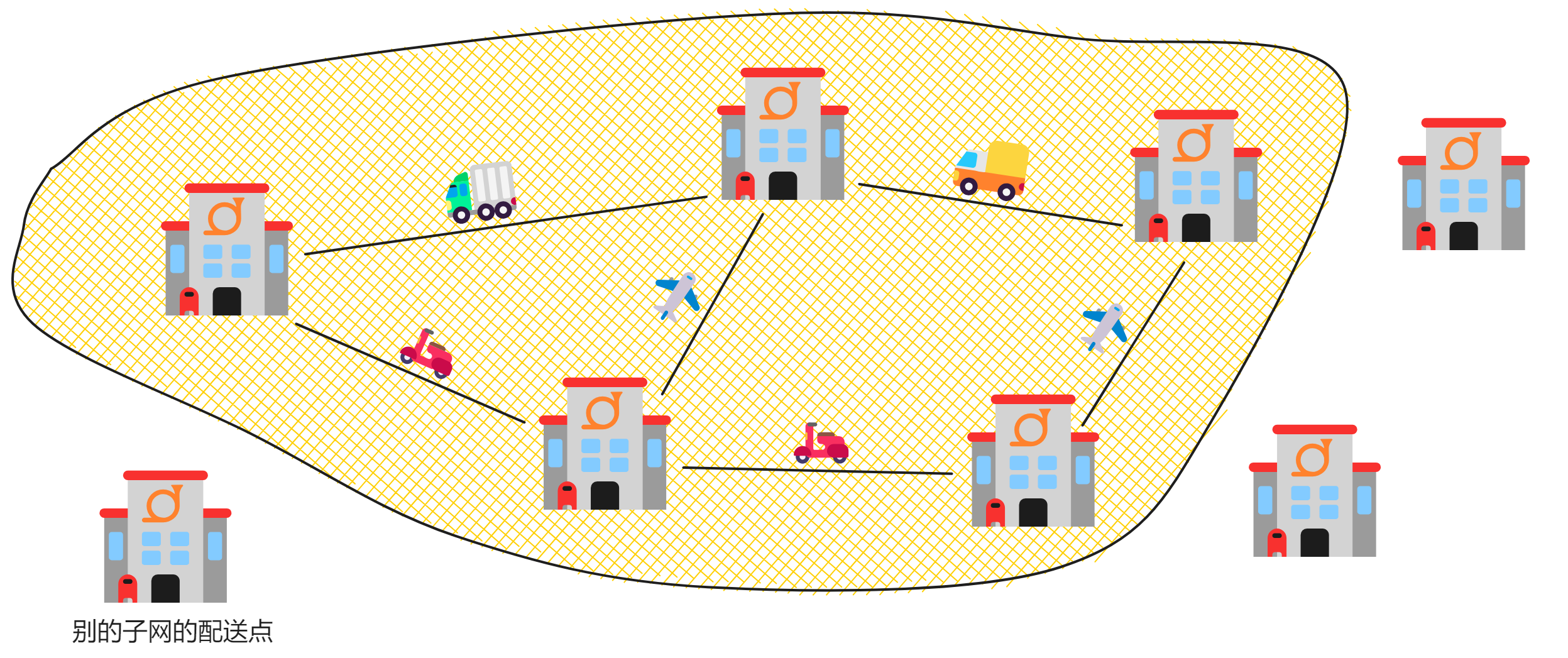

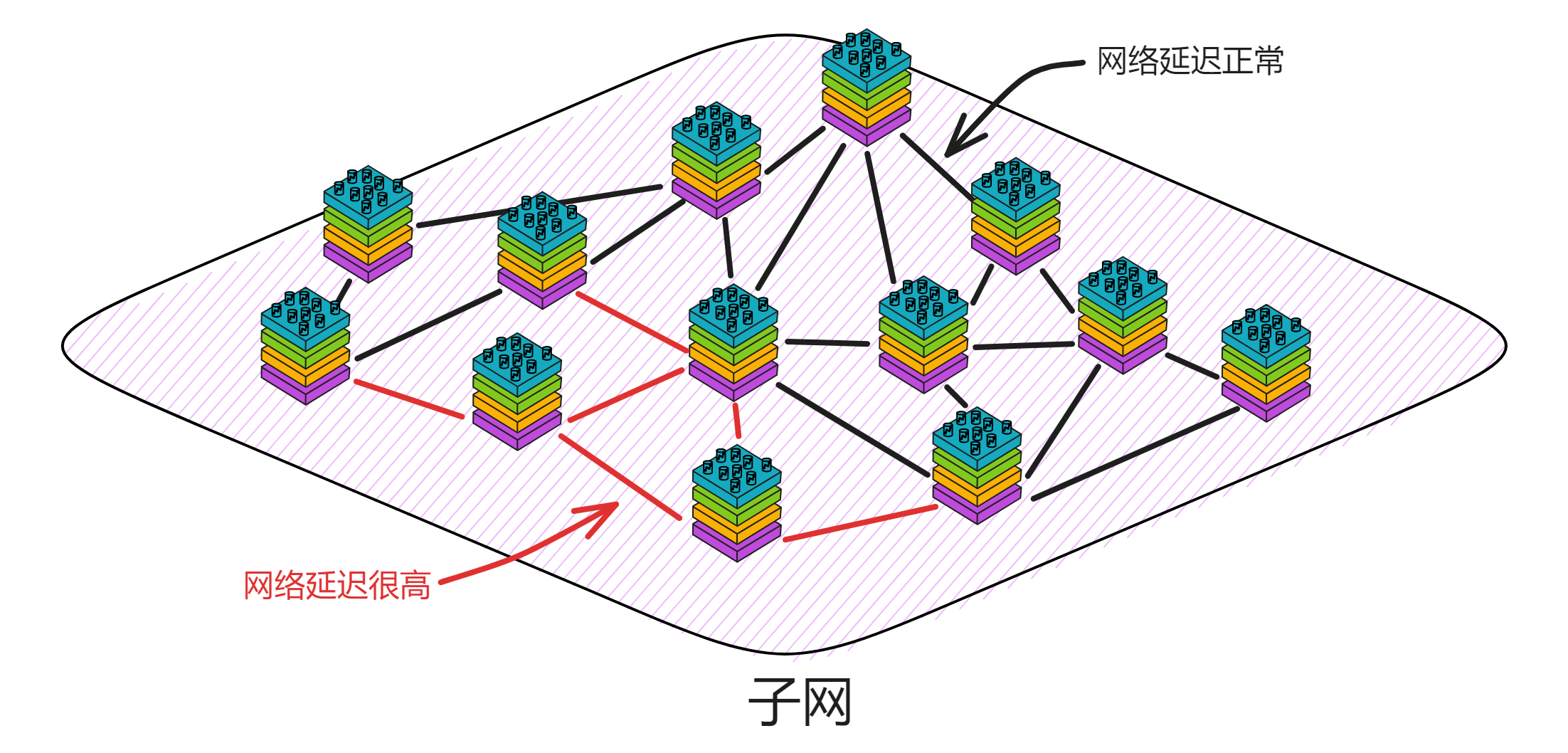

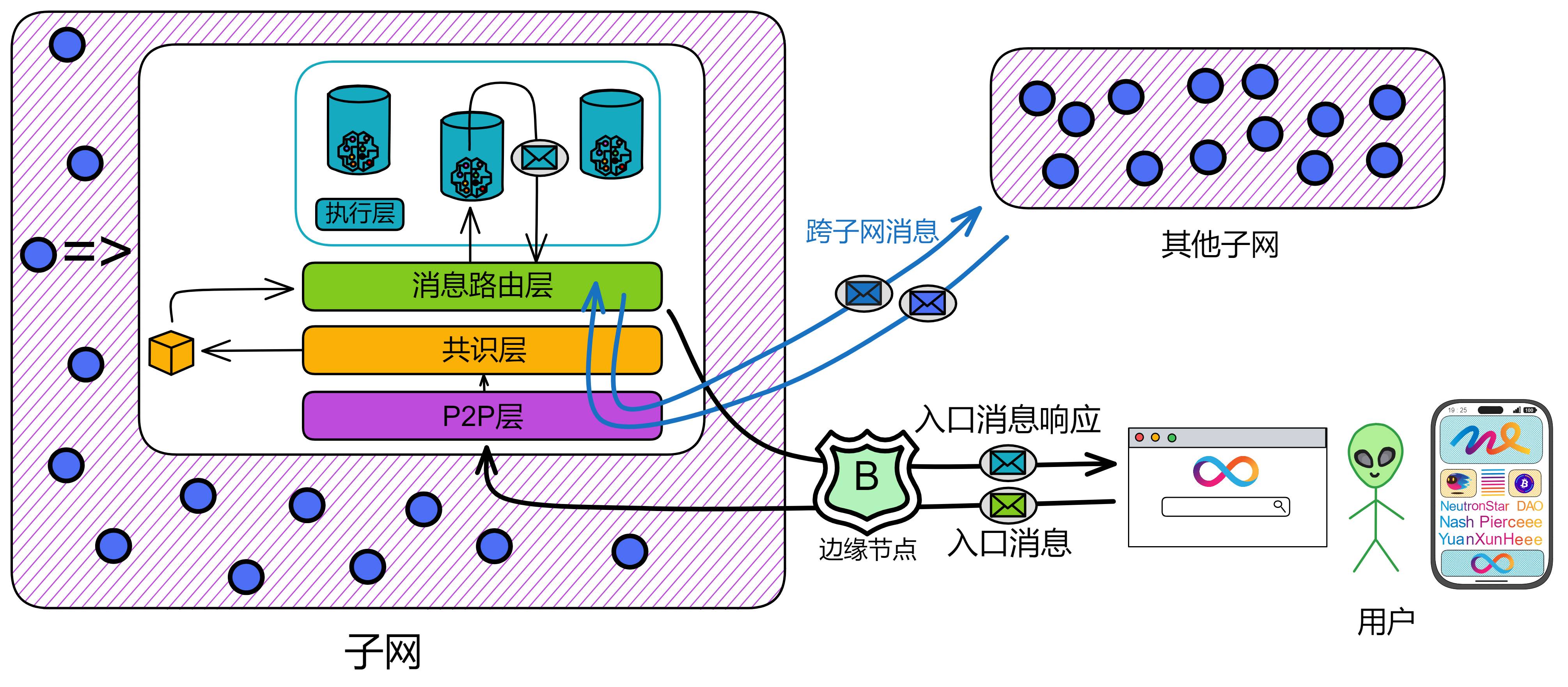

各个数据中心的节点(Node)通过节点软件 IC-OS 虚拟化为一个副本(Replica),再随机选取一些副本组成一个子网(Subnet)。

一个子网由多个数据中心的节点组成。每个节点都用 IPv6 建立 TCP 会话,与 NNS 节点、同一子网里的其他节点连接。

NNS(Network Nervous System) 是嵌入 IC 的治理系统,一个 DAO ,持有 ICP 的任何人可以对 NNS 上的提案投票表决。

比特币网络的节点随时随地想加入就加入,可这样带来的问题是确认交易的速度太慢了;联盟链是先确定了网络中的几个节点,然后由这几个固定的节点达成共识,那速度嗖嗖的。而 IC 结合了他俩的优点,像联盟链一样由几个固定节点组成子网,节点(副本)之间达成共识的速度非常快,并由一个 DAO:NNS ,来控制子网和节点们(副本们)。一举两得。

IC 在区块链协议底层集成了一个 DAO :DAO控制网络(DAO-controlled network)。由这个 DAO 来控制每个子网,配置网络的拓扑结构,创建子网公钥,并且升级副本的协议版本。因此所有 NNS 的决策都由社区成员决定,社区成员的投票权重由其在 NNS 中质押的 IC 原生治理代币数量决定。

如果大家投票通过了提案,NNS 里的 Canister 会自动执行决策。比如,如果一个提议改变网络的拓扑结构的提案被通过,NNS 将自动使用新配置来更新注册表 Canister 。

NNS 也是帮助 IC 网络实现自我进化的去中心化治理系统。NNS 的目的是让互联网计算机网络以一种开放、去中心化和安全的方式进行管理。它是 IC 的系统子网,控制着 IC 的子网。它还可以对节点升级协议;调节 Gas 代币 Cycles 与 ICP 的兑换比例;在极端情况下,它甚至可以冻结恶意的 Canister ,以保护网络。

副本可以理解为是子网里虚拟化出来的 “ 虚拟节点 ” 。在以下内容中,我们就把 IC 的 “ 节点 ” 叫做副本了。

IC 的子网类似分片(Sharding)思想。分片技术是一种区块链扩容方案。拿比特币举例,全世界的节点都在抢一个区块的记账权,相当于是一个覆盖整个地球的网络。如果所有亚洲的节点组成一个 “ 比特币子网 ” ,欧洲、非洲、美洲、大洋洲也都组成自己的子网。那么交易在子网里达成共识,这样节点相对少一点、通信距离更短,可以提升一些性能了。

IC 由许多个子网组成,没有母网、主链、侧链、信标链这种概念,每个子网之间是平等的(除了 NNS)。每个子网独立运行,子网内部达成共识出块,没有比特币那样的 “ 全局共识 ” ,不同的子网同步并行出块。可以理解为每个子网都是一条区块链,许多链共同组成了 IC 。跨子网的通信在 IC 底层靠 ChainKey 解决。开发者和用户都不用在意智能合约被部署在哪个子网里、怎么跨子网通信等等问题。

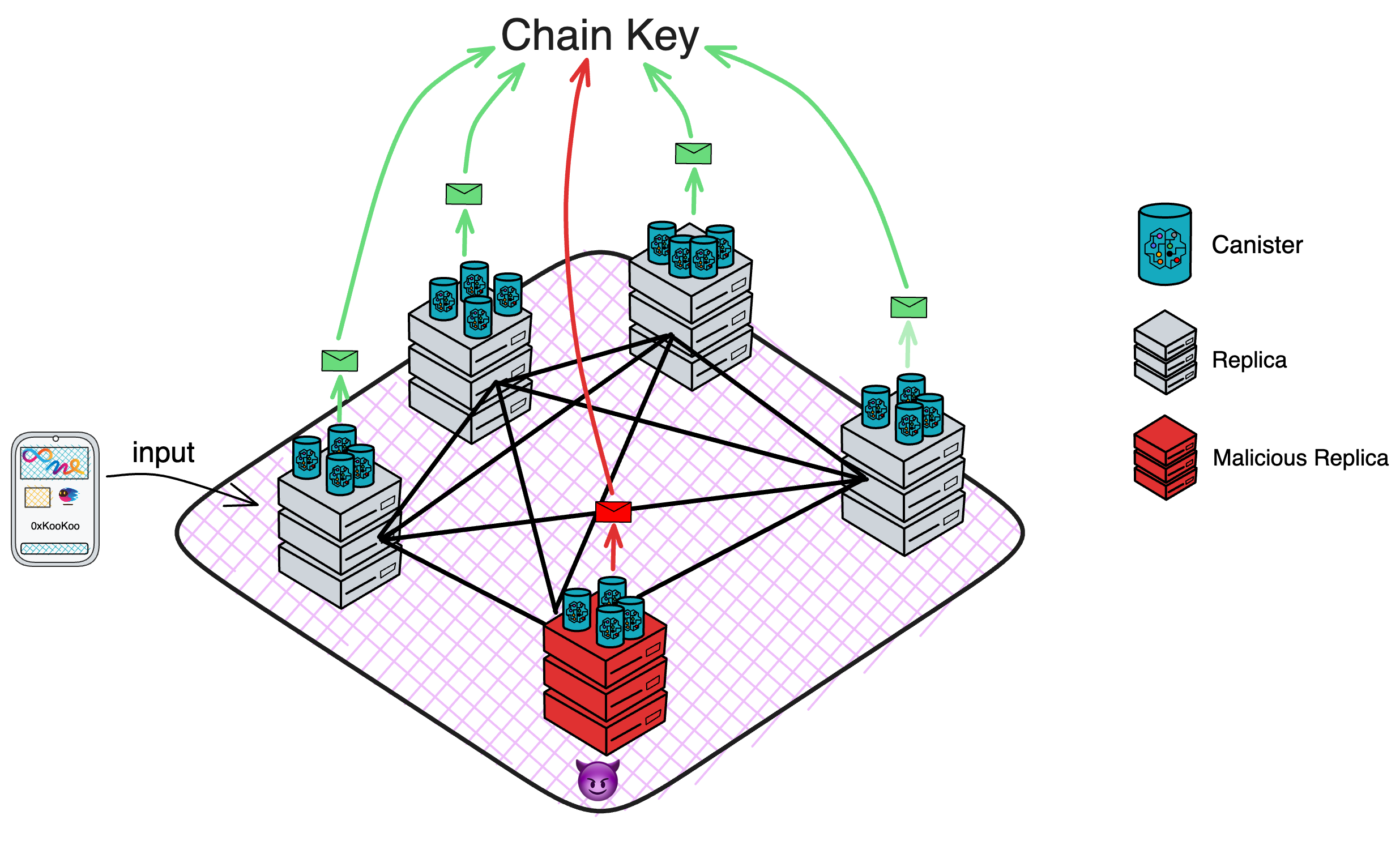

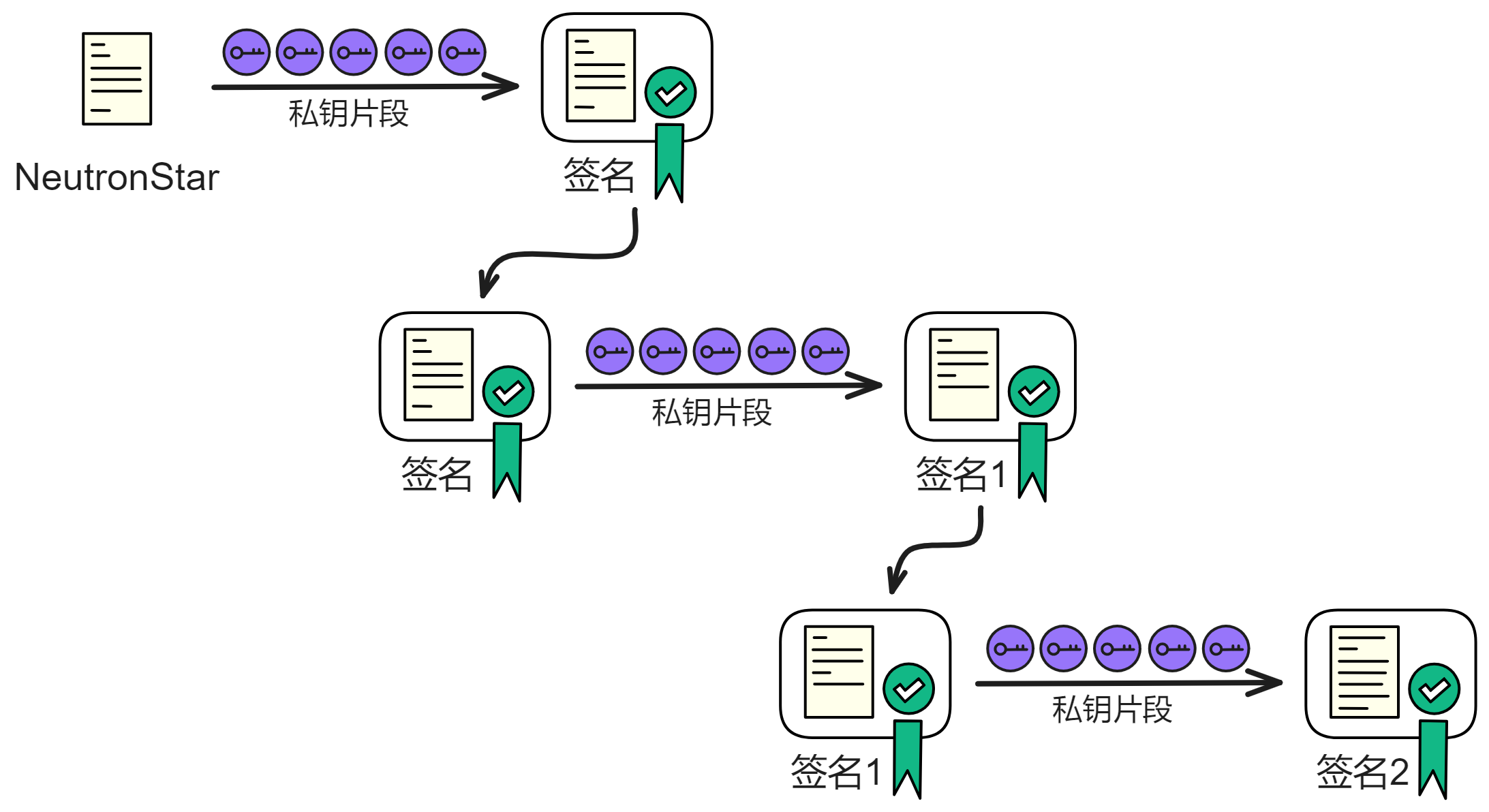

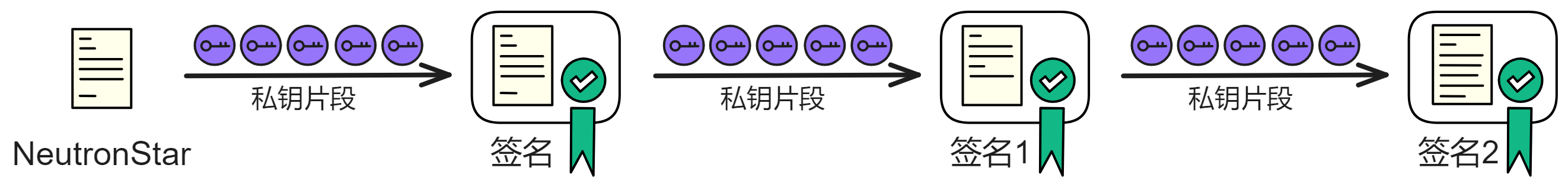

ChainKey 是互联网计算机背后的核心技术,它解决了 IC 的子网之间互相通信的问题。ChainKey 使每个子网根据 root key 生成自己唯一的子网公钥 ( Subnet Key ) 。这是 IC 无限扩展性能的基础技术。

每个子网都有一个只有 48kb 的公钥。任何人都能验证自己收到的消息是不是 IC 网络发过来的、有没有被篡改,当然各种物联网设备和其他区块链也能验证来自 IC 的信息。相比之下,去验证 ETH 这类传统区块链时,因为每次出块都由不同的副本签名,设备需要同步几百 GB 的签名数据。而在 IC ,所有副本一起签名一个区块。因此设备只需要保存 48kb 的唯一公钥即可验证子网的消息。

子网可以随着网络的资源使用情况动态地增加、删减、合并、拆分。子网的数量没有上限,所以理论上支持 “ 无限扩容 ” ,在世界各地新增子网。

可是由谁来决定子网们的拆分重组呢?NNS!

NNS 是一种特殊子网,也和别的子网一样由一些节点组成, NNS 可以管理其他子网。不过 NNS 子网的节点比较多,安全性自然也比其他的子网高一些。数据中心成为节点、某个节点加入哪个子网、某个子网由哪些节点组成、选几个节点创建新子网、把一个子网拆分成几个子网等等,这些操作都需要获得 NNS 的许可。

许多子网的这种架构使 IC 可以无限扩展。

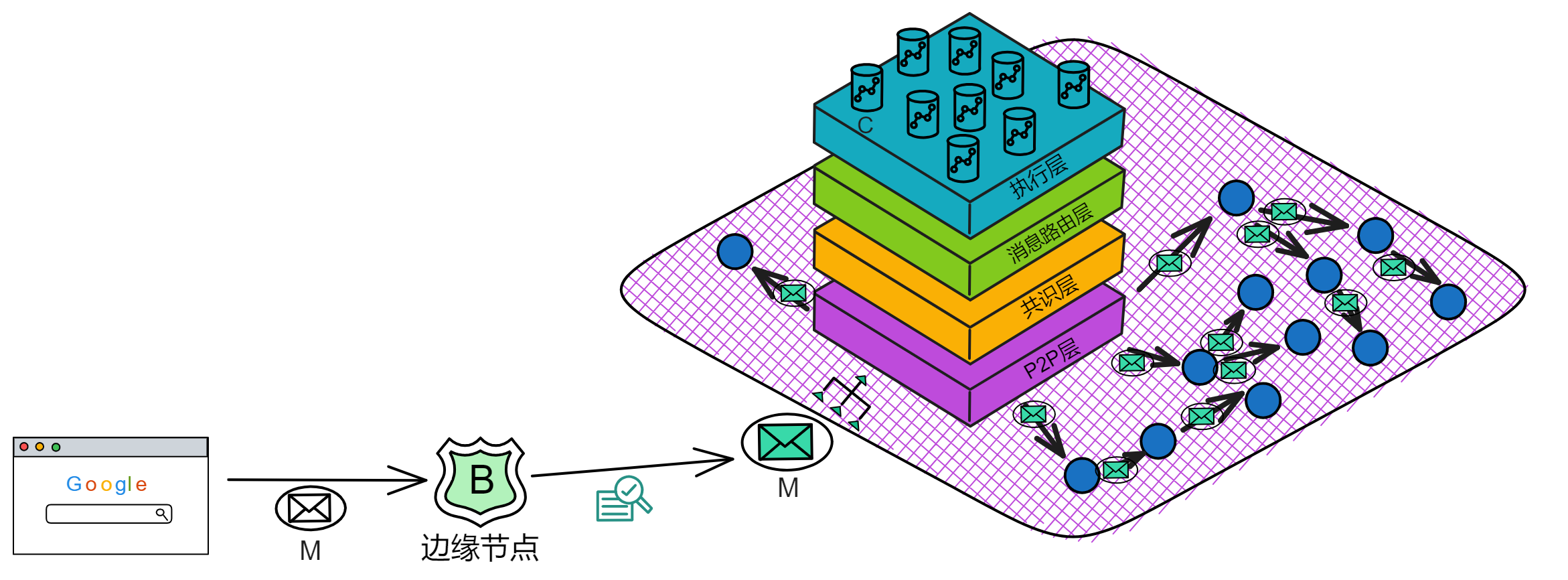

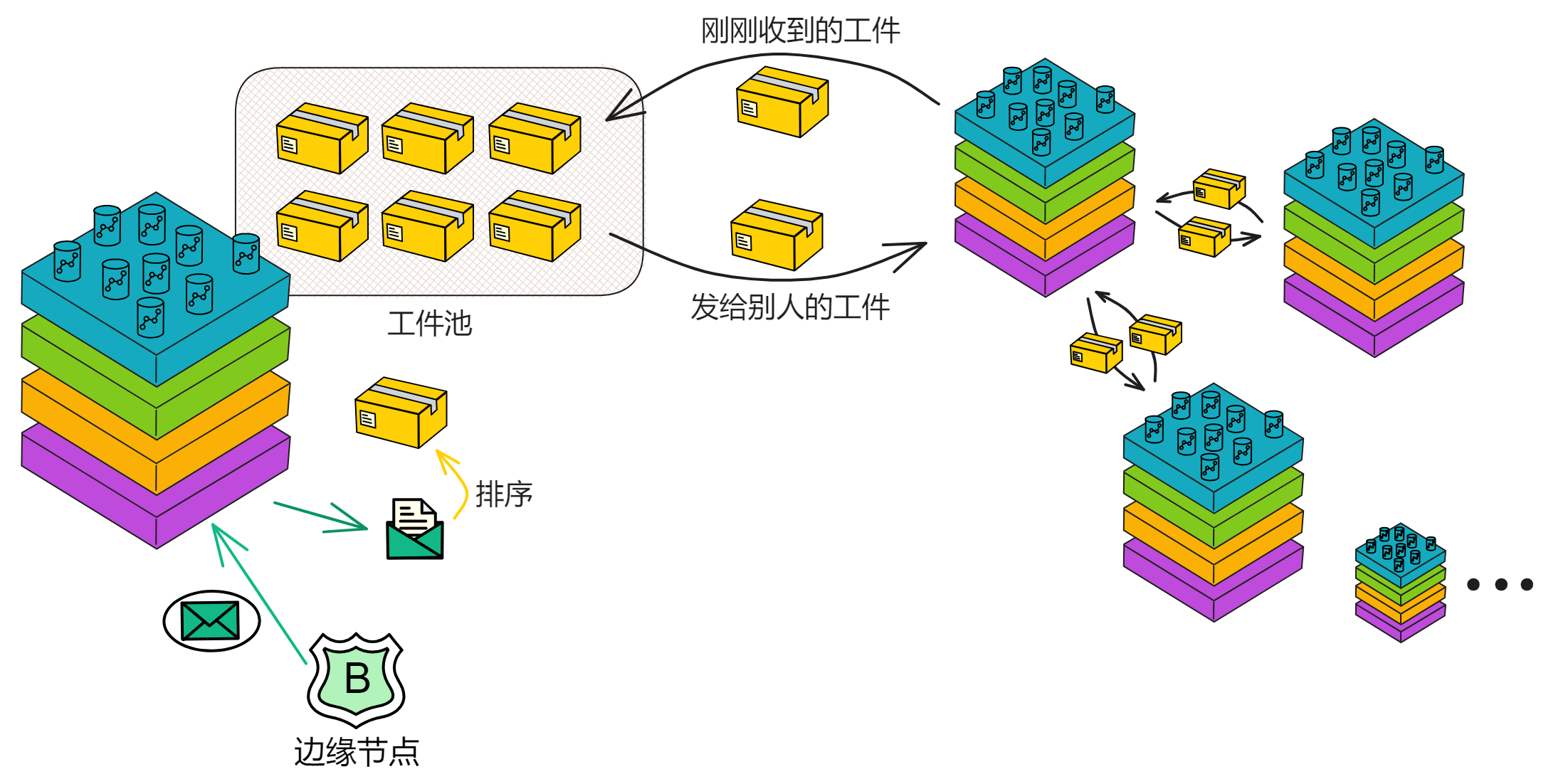

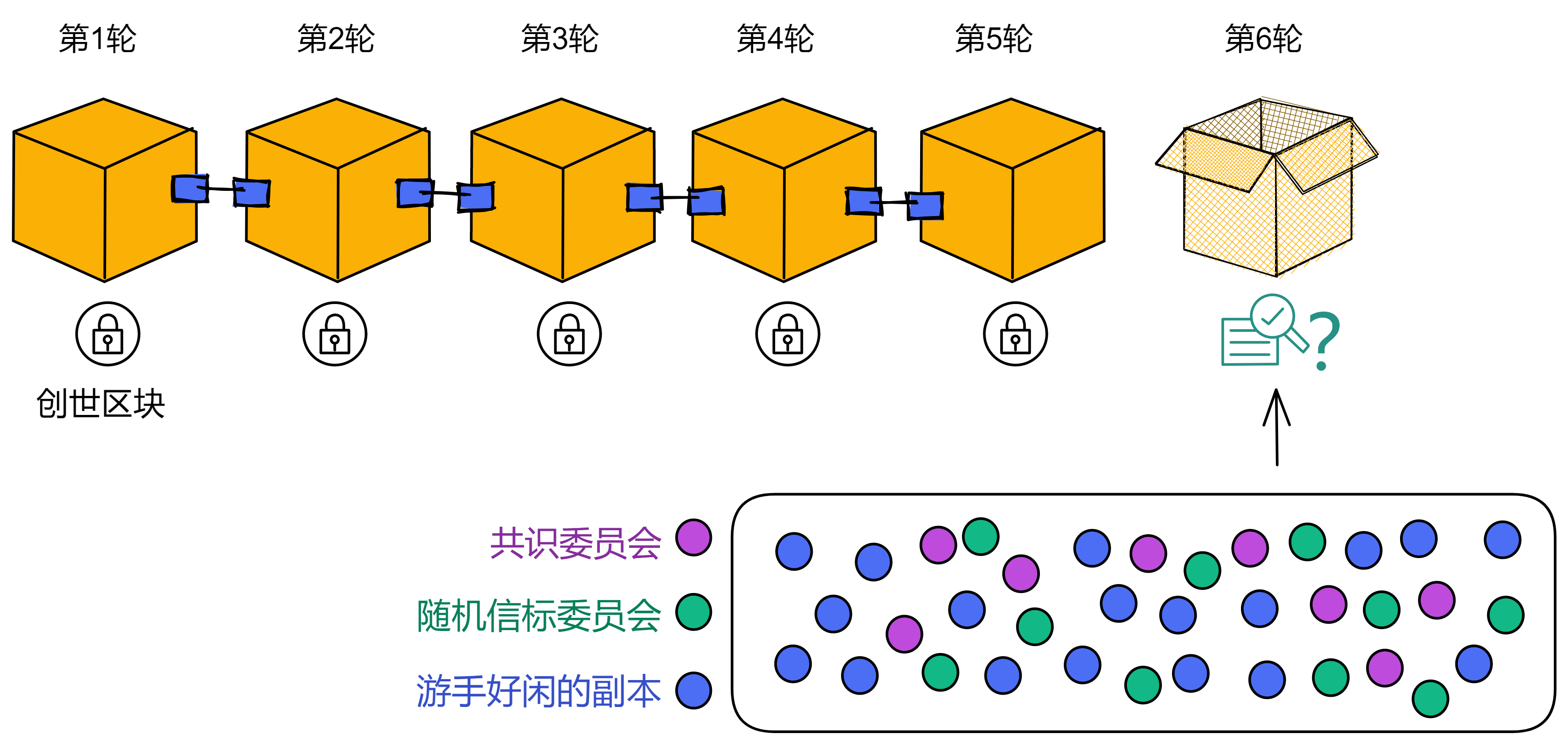

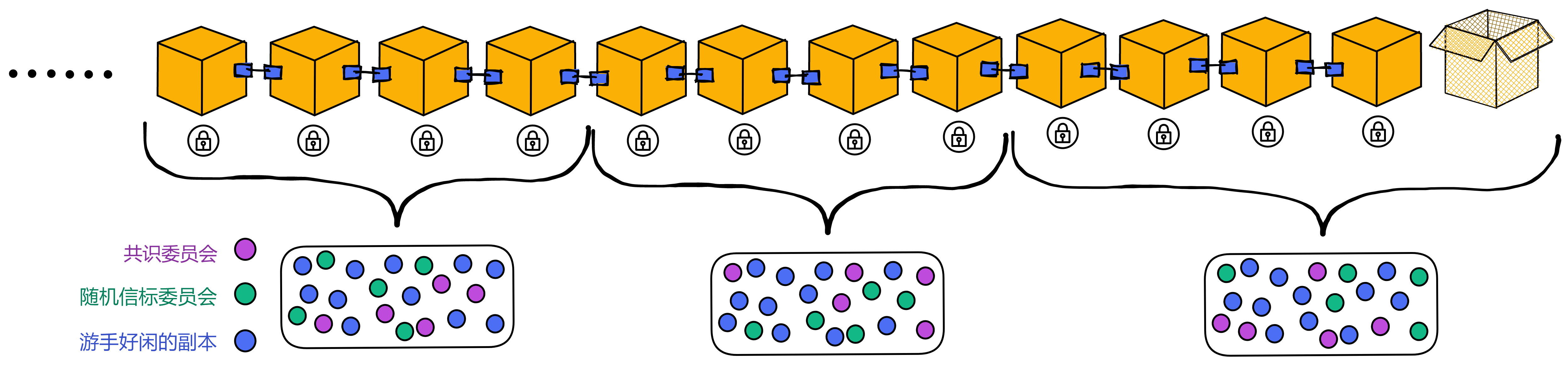

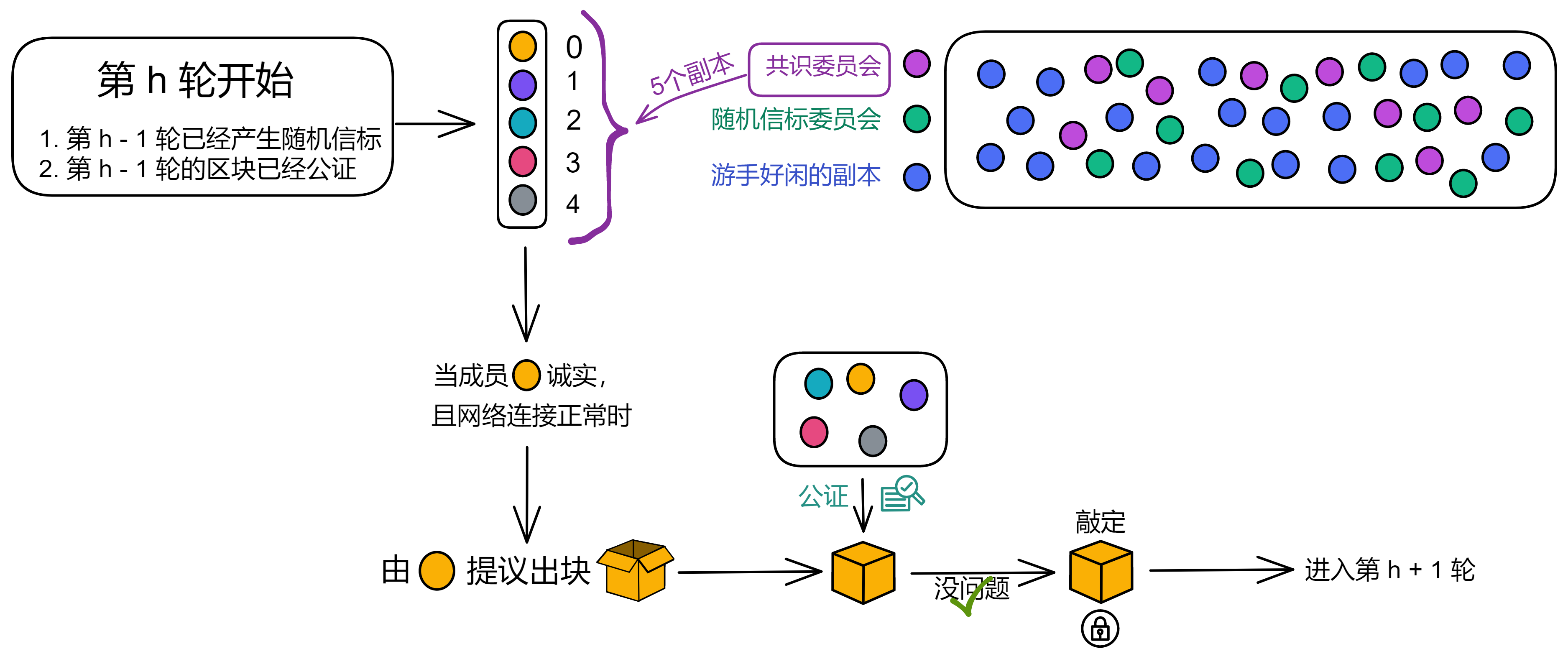

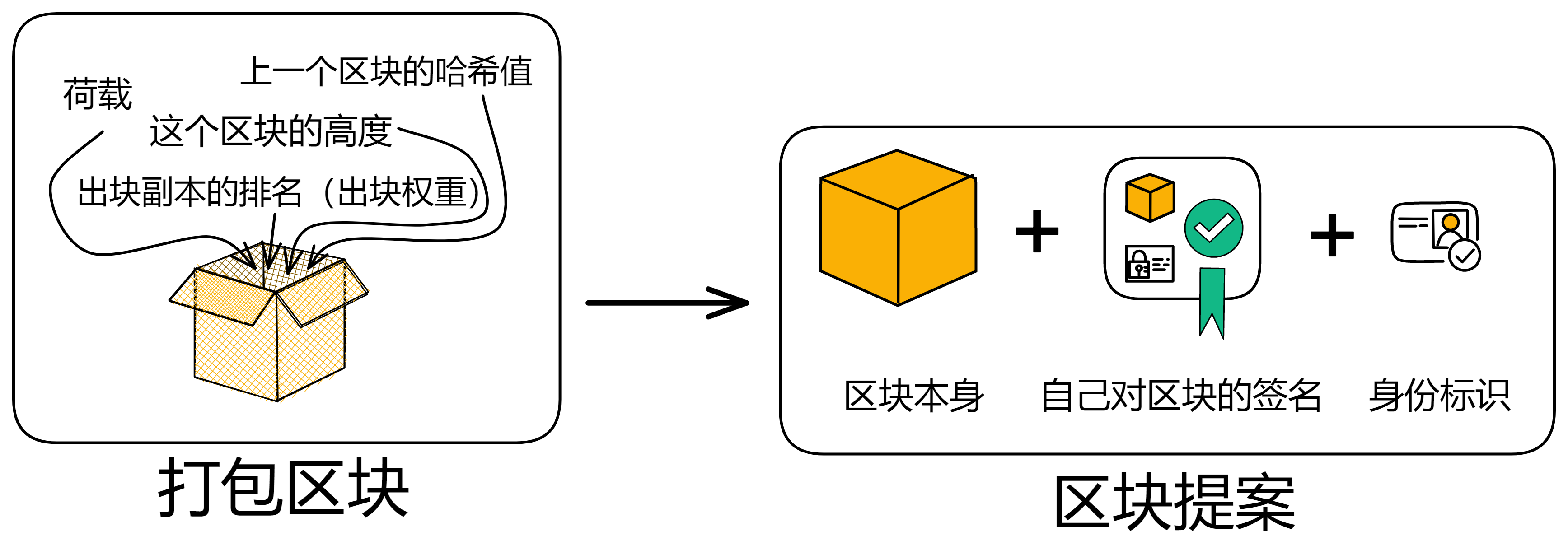

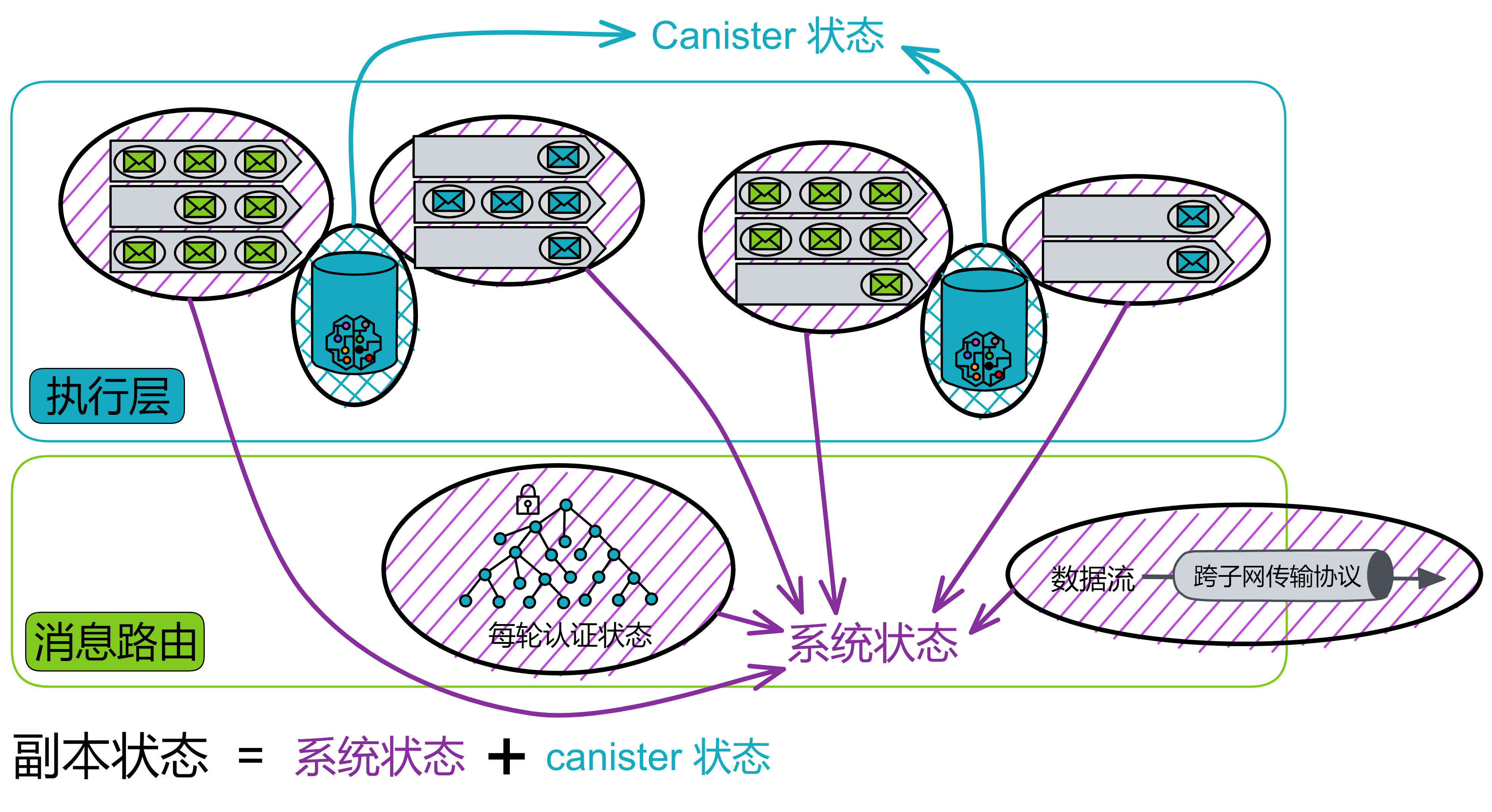

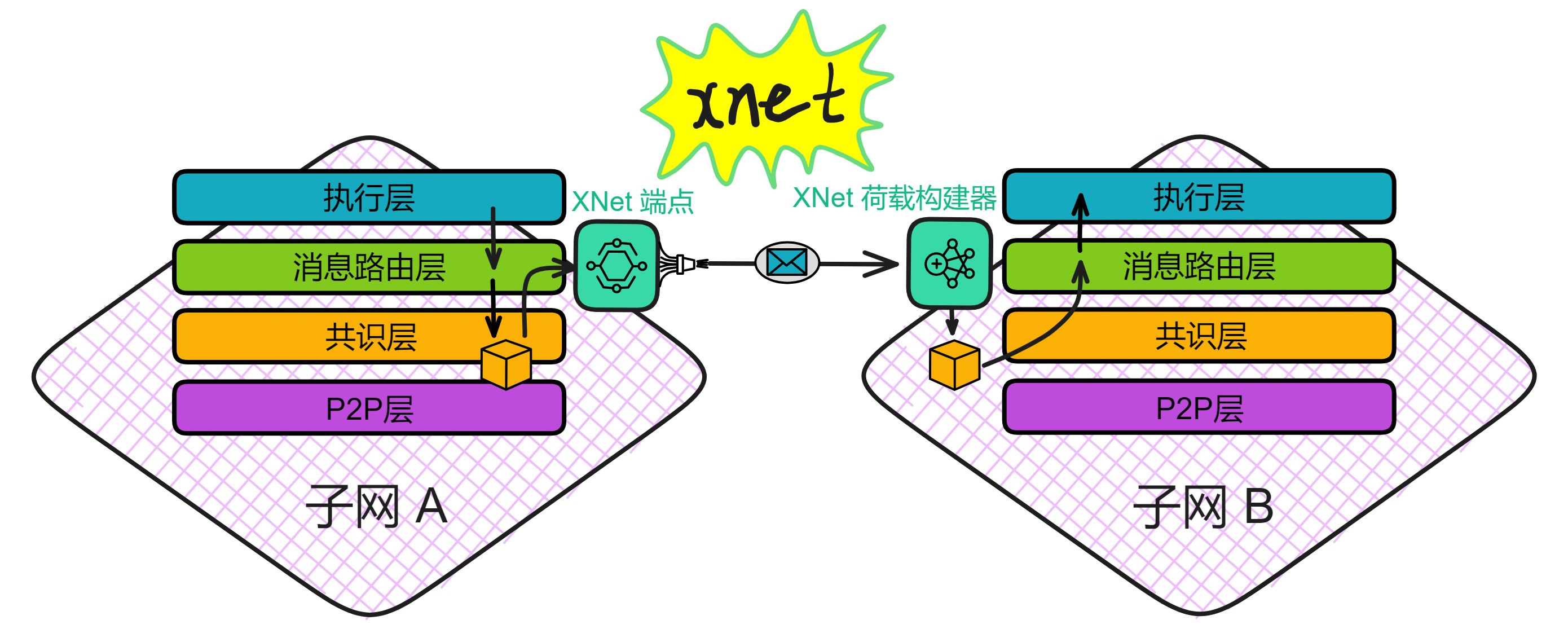

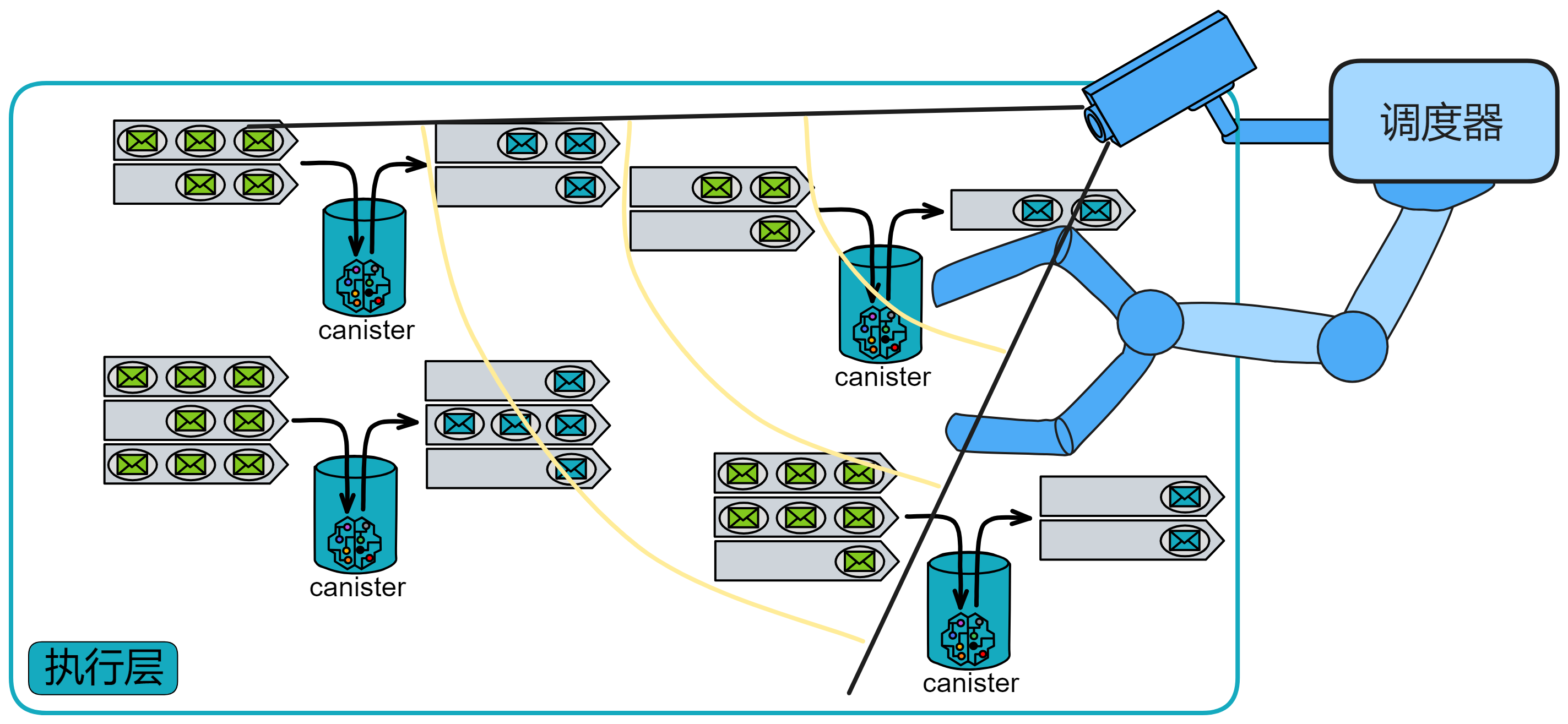

IC 协议的核心部分分为 4 层,运行在各个子网的节点上。现在我们把视角转入子网内部,看一看 IC 的核心协议。为了方便理解,我把子网的俯视图转为侧视视角;紫色格子方块代表子网,蓝色小球代表子网里的副本。

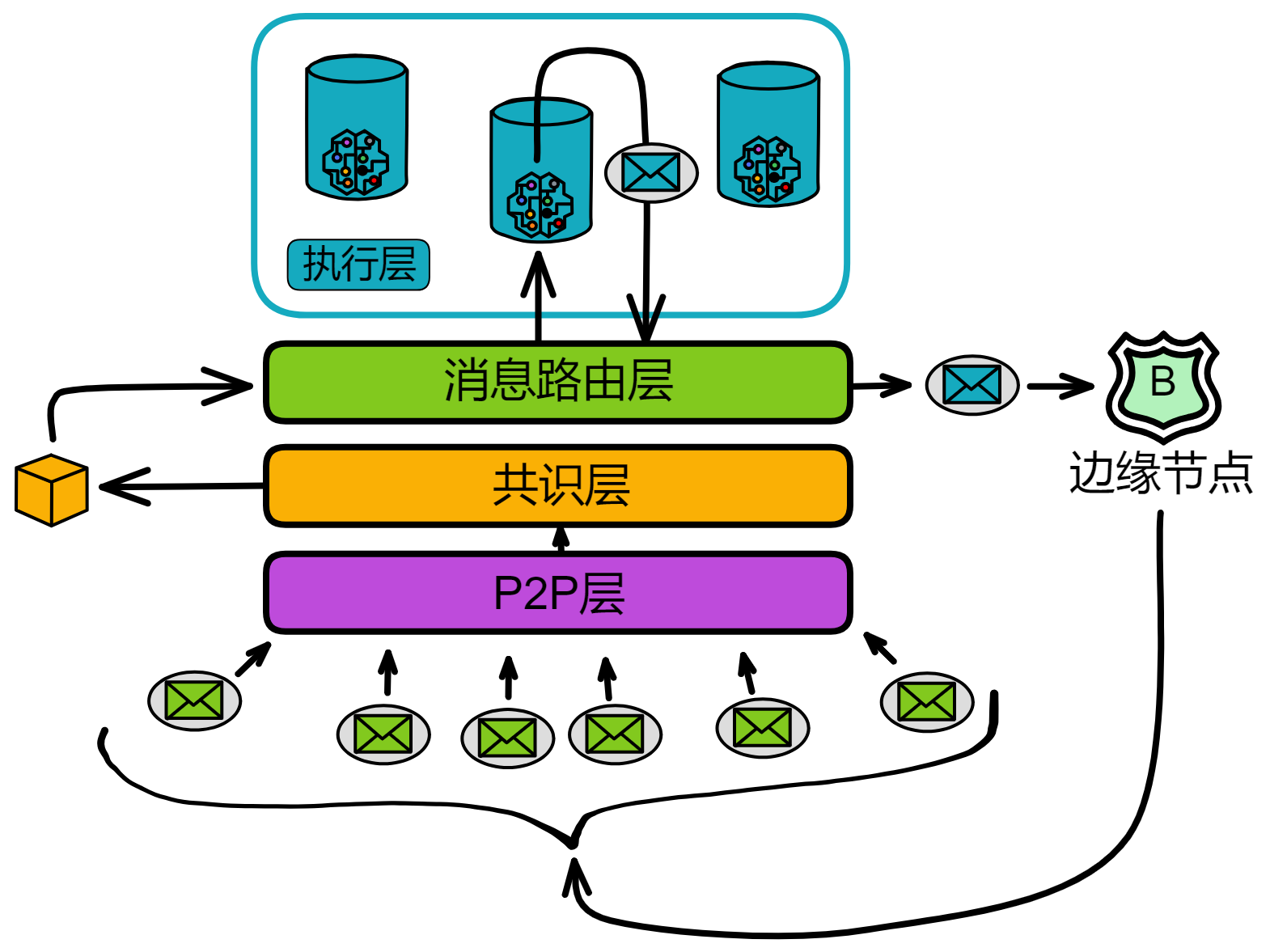

IC 核心协议总共有 4 层,每个副本都有这 4 层结构。从下到上依次是 P2P 层、共识层、消息路由层、执行层:

-

P2P层,收集和发送来自用户、子网中的其他副本和其他子网的消息。保障消息能传递到到子网中的所有节点,以确保安全性、可靠性和弹性。

-

共识层,子网内部对处理各种消息的顺序达成共识。然后这些区块被传递到消息路由层。

-

消息路由层,转发消息。共识层将区块敲定后,相应的荷载会被传递给消息路由层。由消息路由输入执行层。

-

执行层,运行 Canister 的地方。执行层更新复制状态机中相应 Canister 的状态,完成智能合约的计算任务并将输出交给消息路由层处理。

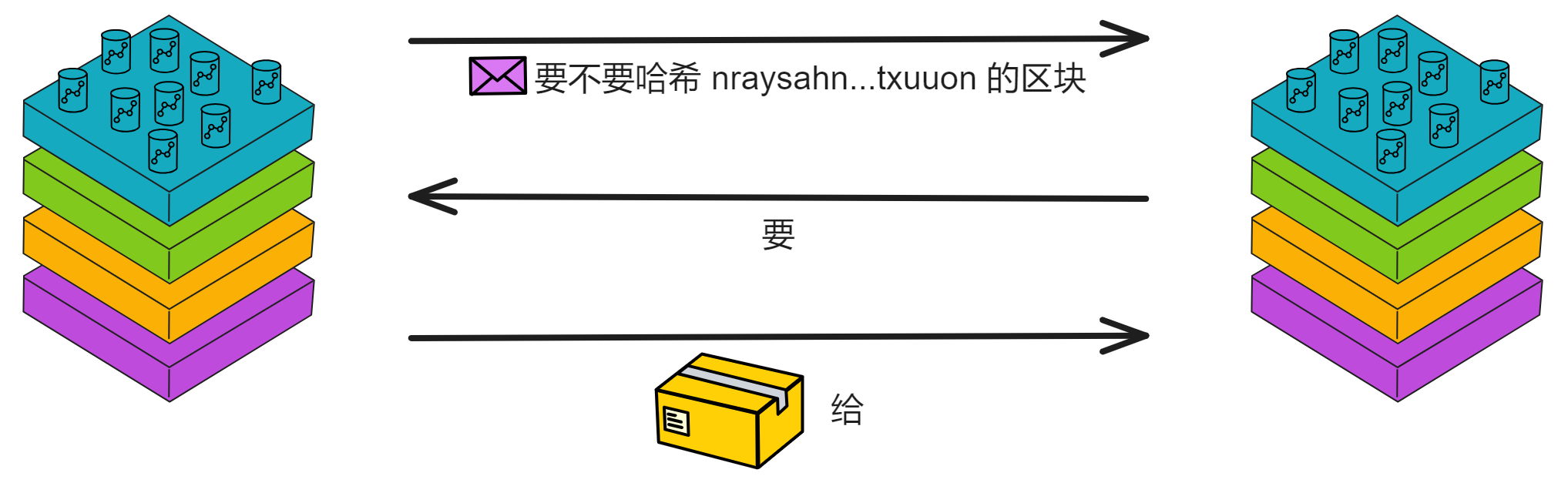

P2P层

P2P 网络就像一个大型的聚会,参加聚会的人都是子网里的副本。在这个聚会上,人们想要分享最新的消息,并且希望尽可能多的人都听到这些消息。但是让每个人都大声喊出完整消息很费劲(占用网络资源),我们可以采取一种更高效的方法。

这个方法就是公告-请求-传递机制。就像在聚会上,有人(副本)大声宣布:“ (。・∀・)ノ゙ 嗨,我有个大新闻要分享!” 这个宣布就是一个小公告。其他人(其他副本)听到这个公告后,如果他们觉得这个消息很重要,就会走过去(请求)并要求那个人告诉他们具体的消息内容(传递)。这个过程可能会牺牲一些时间(延迟),但是它能够节省体力(降低带宽使用)。

如果这个聚会非常大,比如一个巨大的音乐节现场。在这样一个庞大的场合下,公告-请求-传递机制会在一个 覆盖网络(Overlay network) 上运行。这个覆盖网络就像一个大型朋友圈,每个人都只和他们的好友(对等节点/Peers)分享消息。

当某个人想要广播一个消息时,他会先告诉自己的好友这个消息的公告。那些好友在收到公告后,可能会请求消息的传递,并在满足特定条件的情况下,把这个消息的公告告诉自己的好友。这就像一个八卦网络(Gossip network)。

P2P 层通过公告-请求-传递机制以及在覆盖网络上运行,能够在牺牲一定延迟的情况下,有效降低带宽使用,从而实现高吞吐量的目标。

在这里了解 IC P2P 层的更多运行机制。

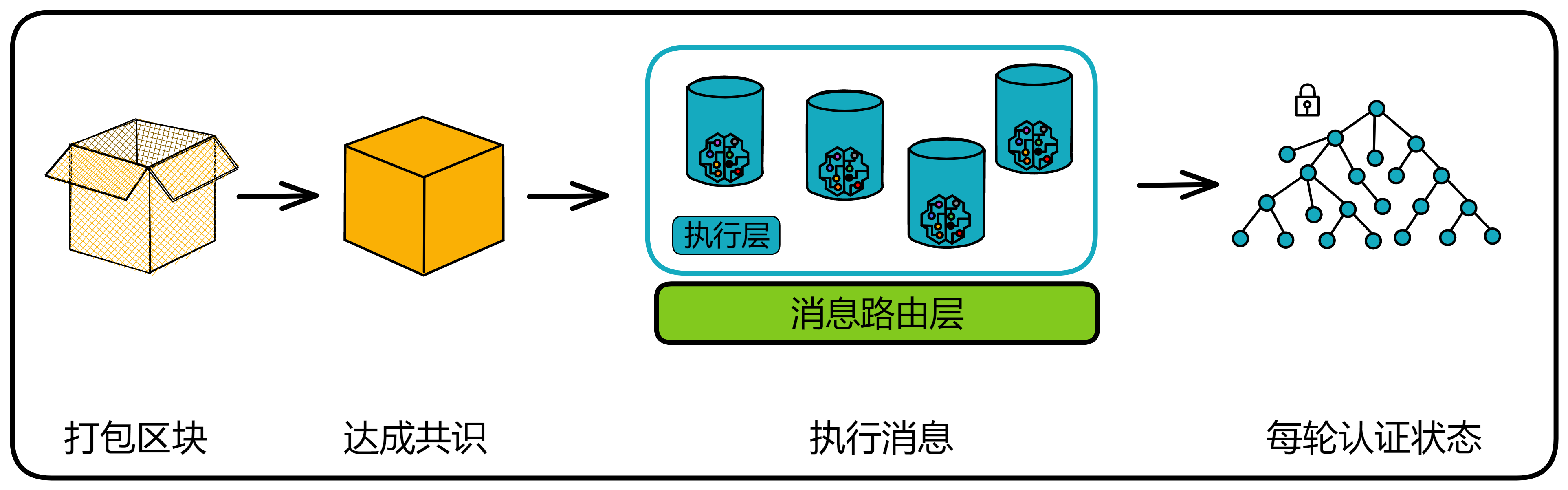

共识

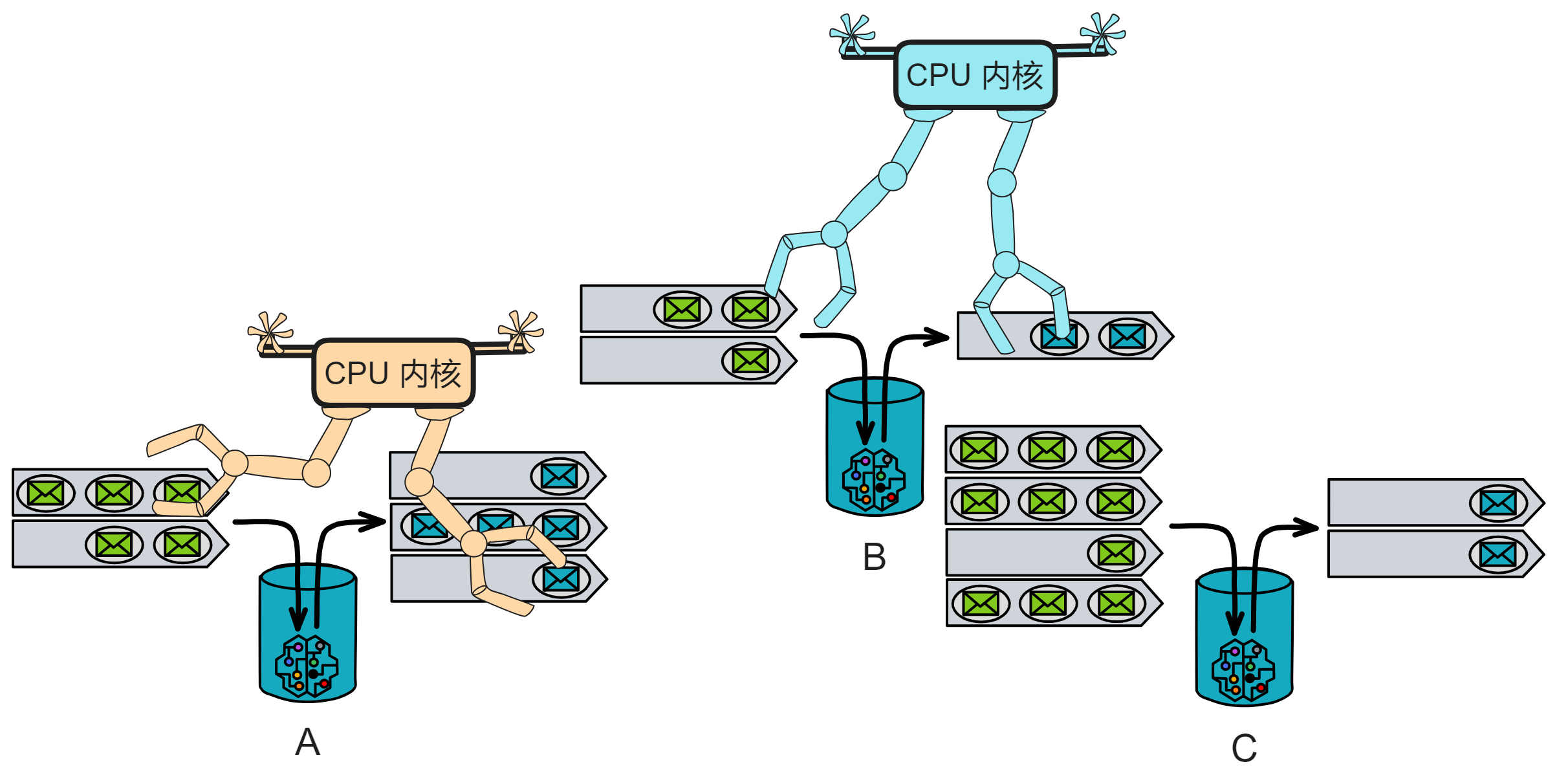

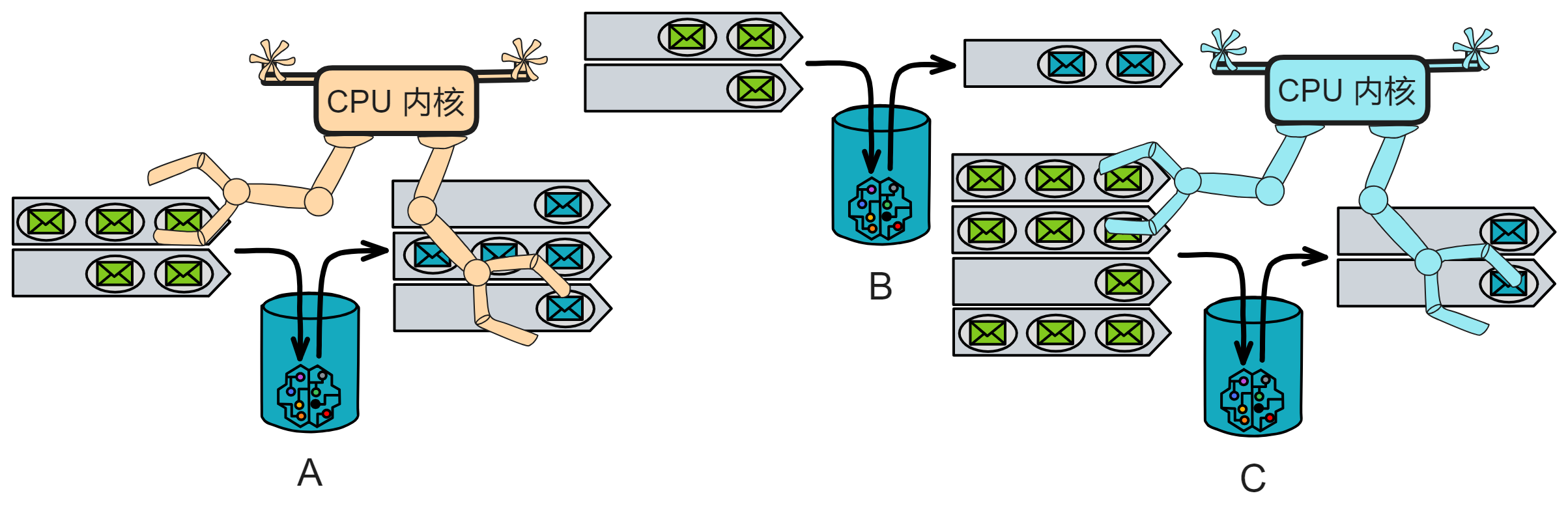

共识由子网内部的副本们达成。

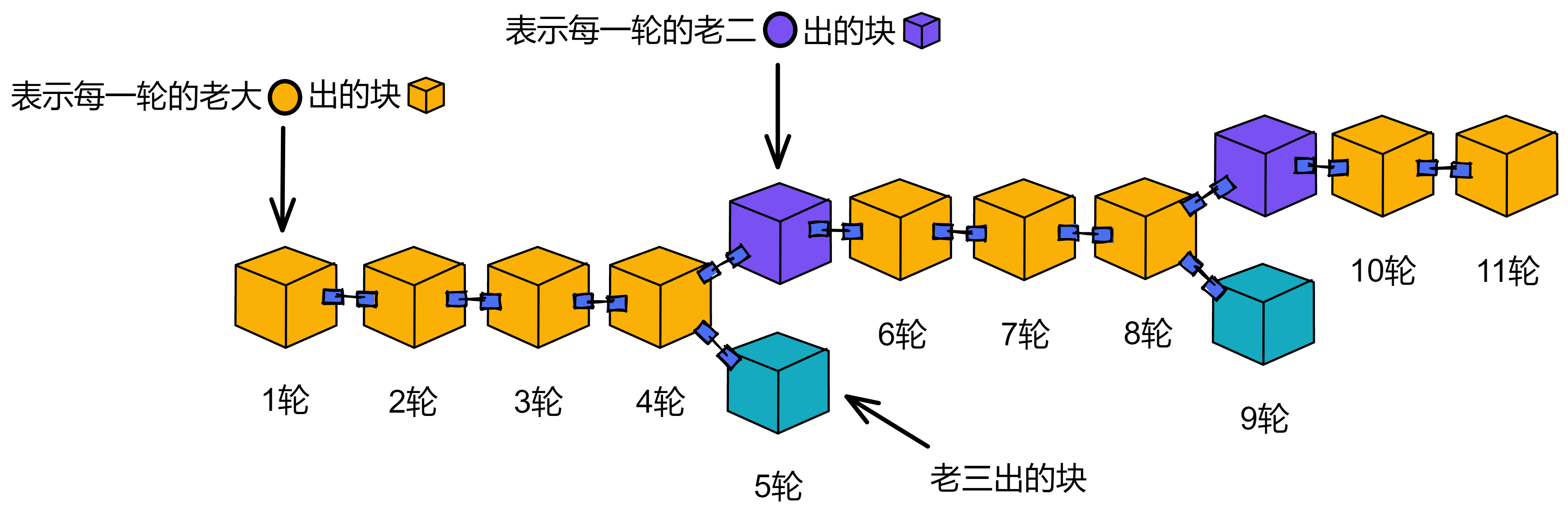

IC 共识层的任务是对输入消息进行排序,以确保所有的副本按照相同的顺序处理输入消息。这些消息是用户与 Canister 之间的通信、Canister 之间的通信以及这些通信的顺序。

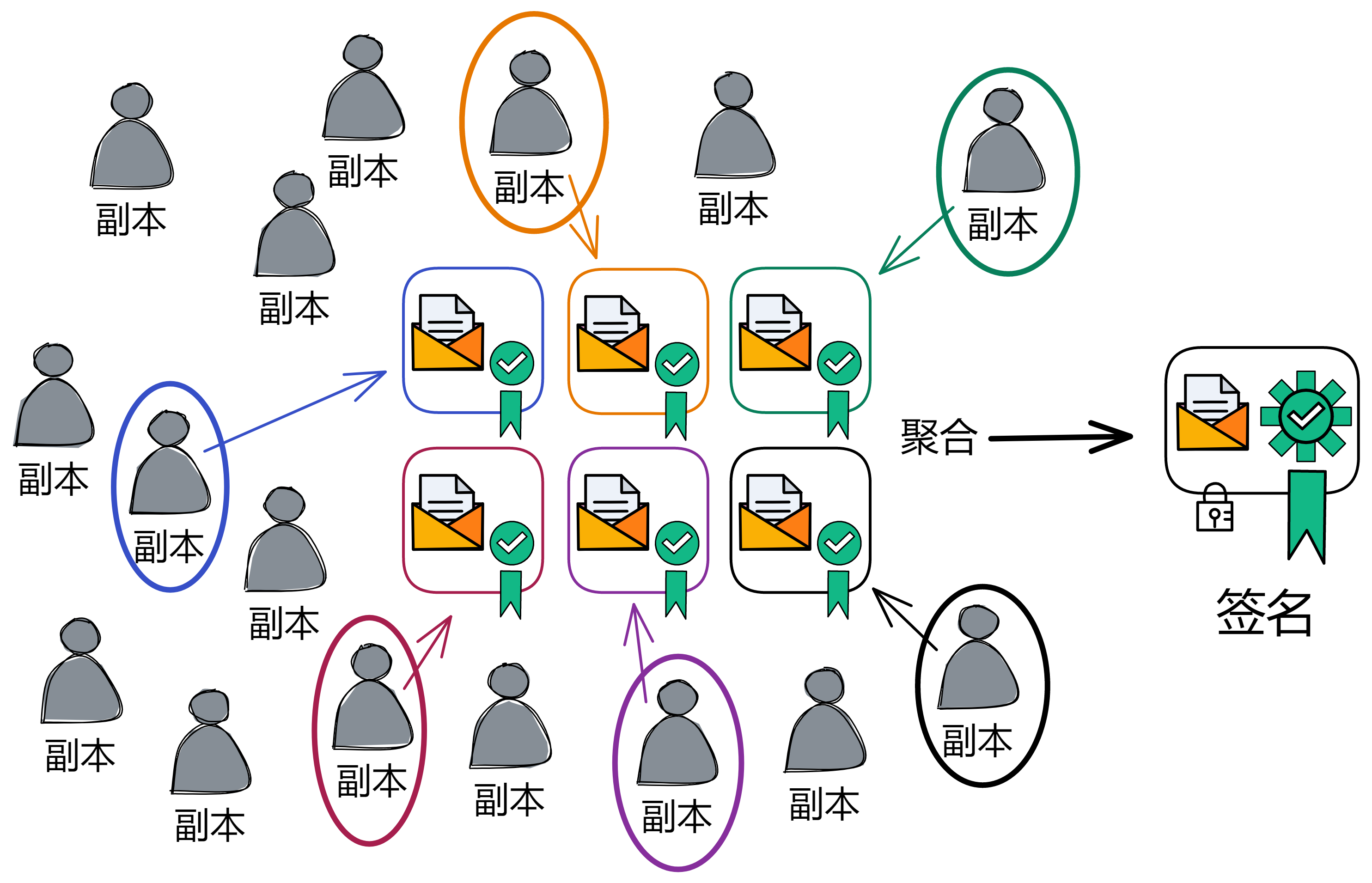

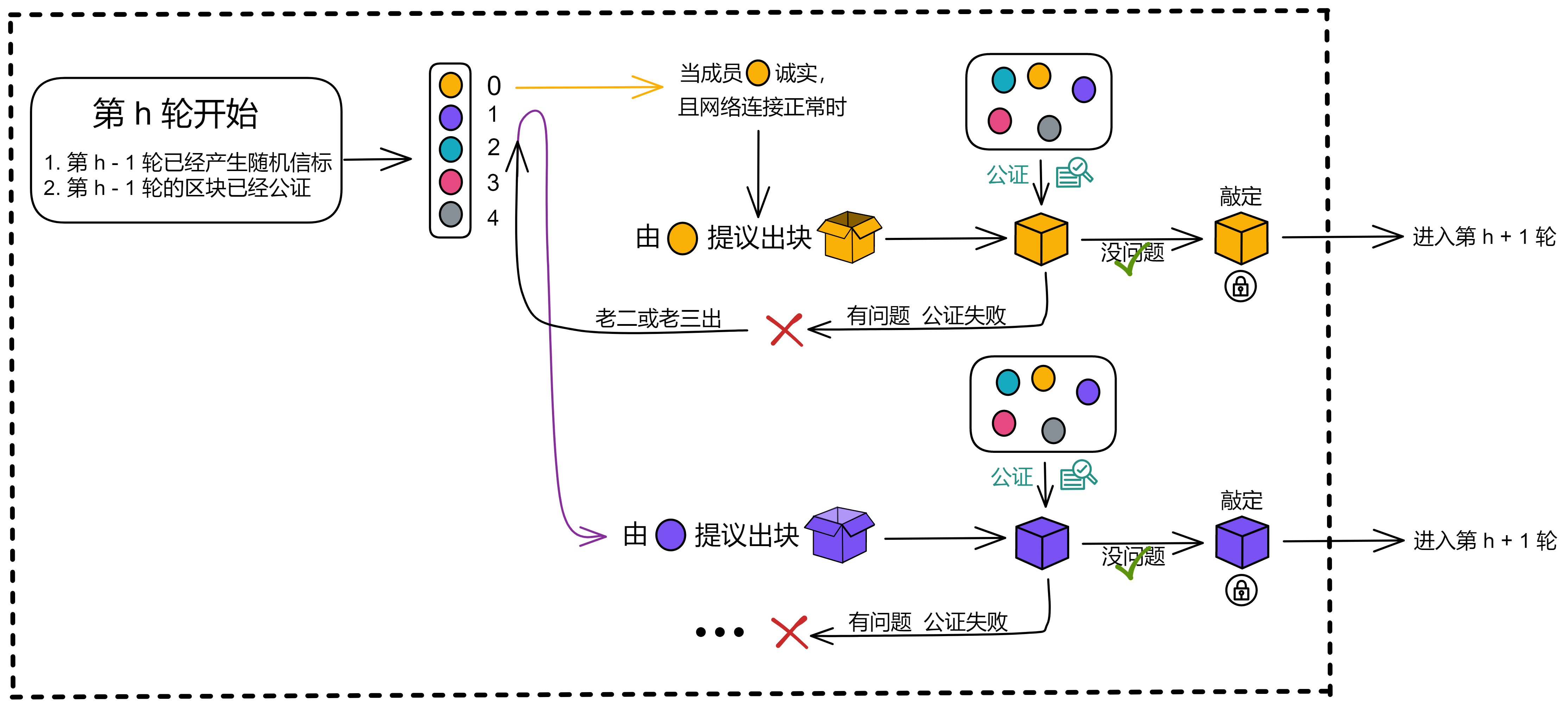

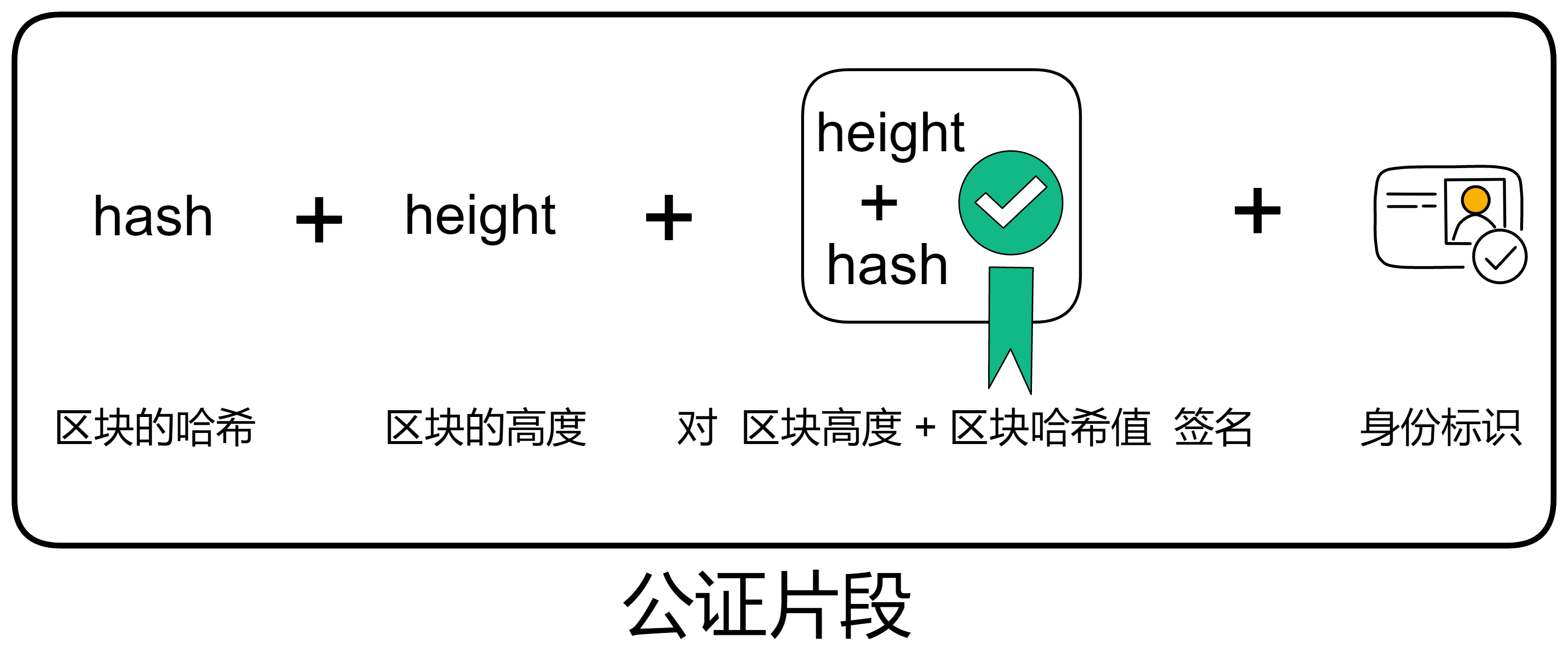

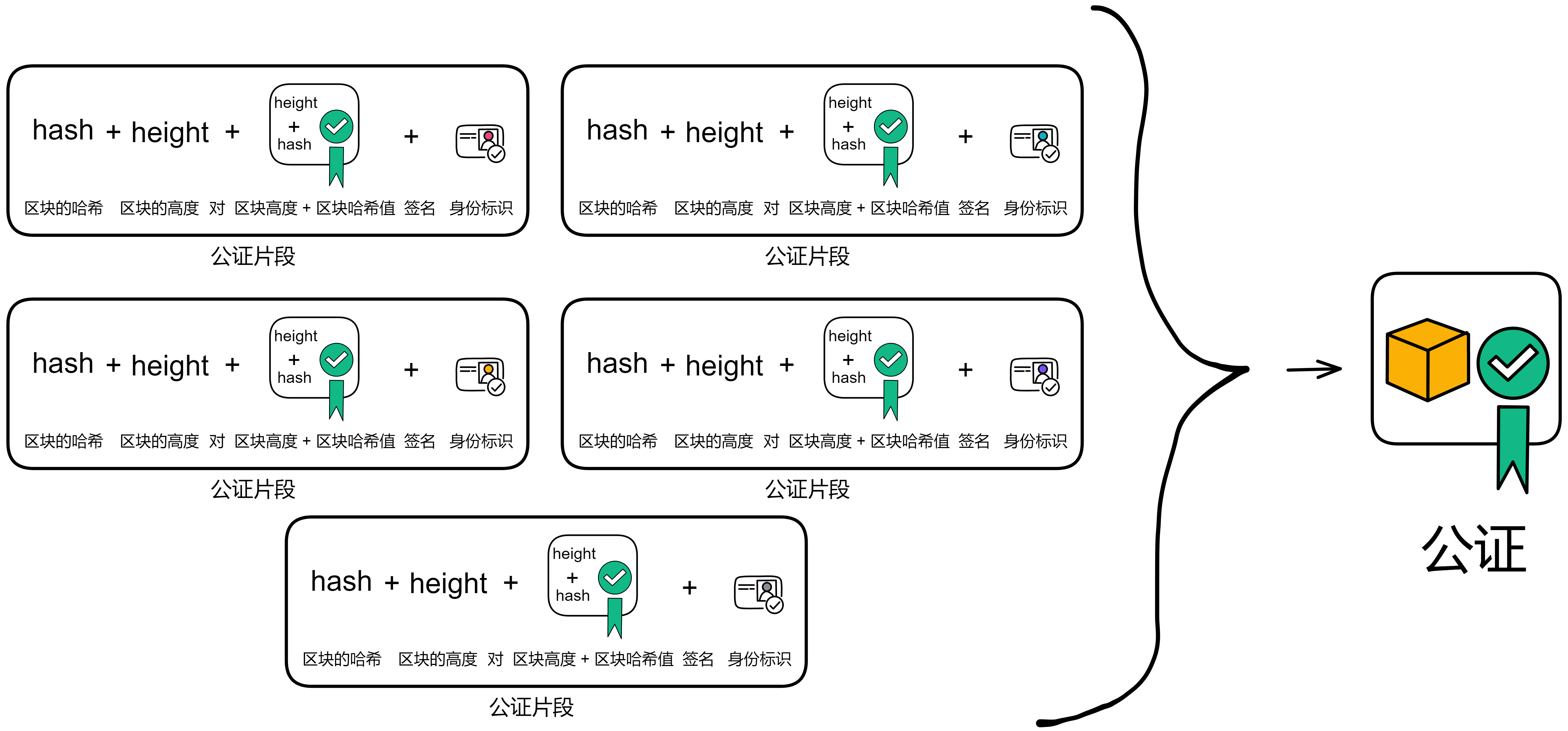

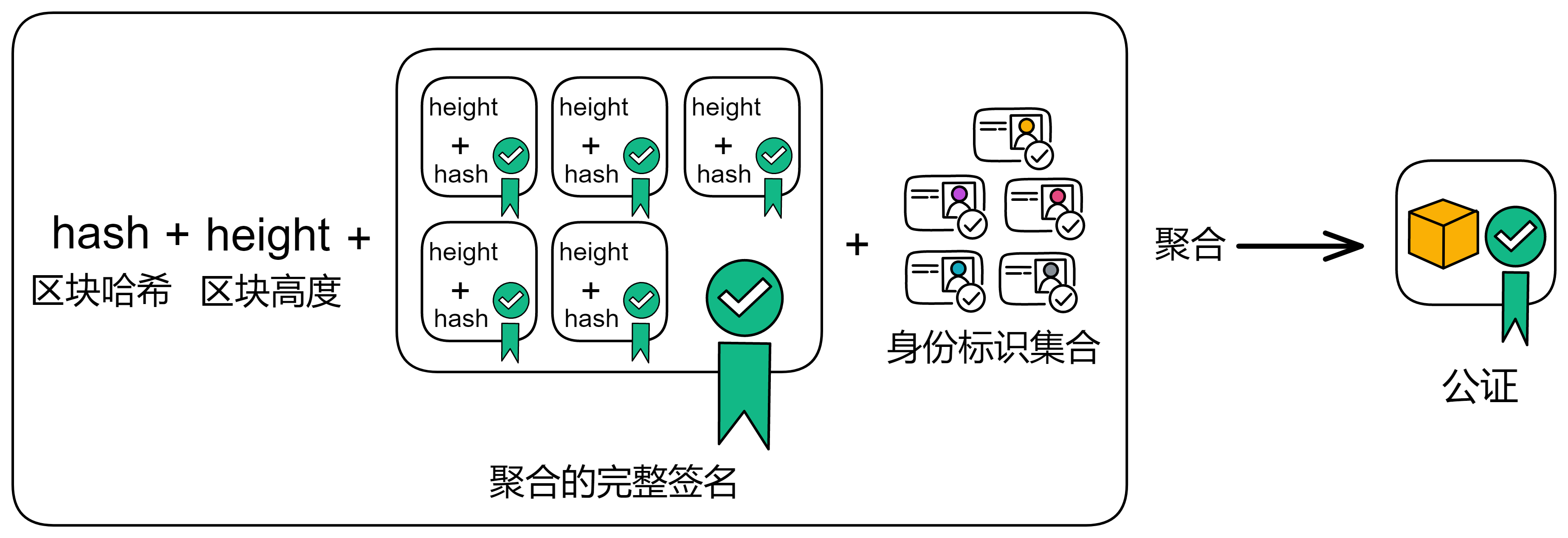

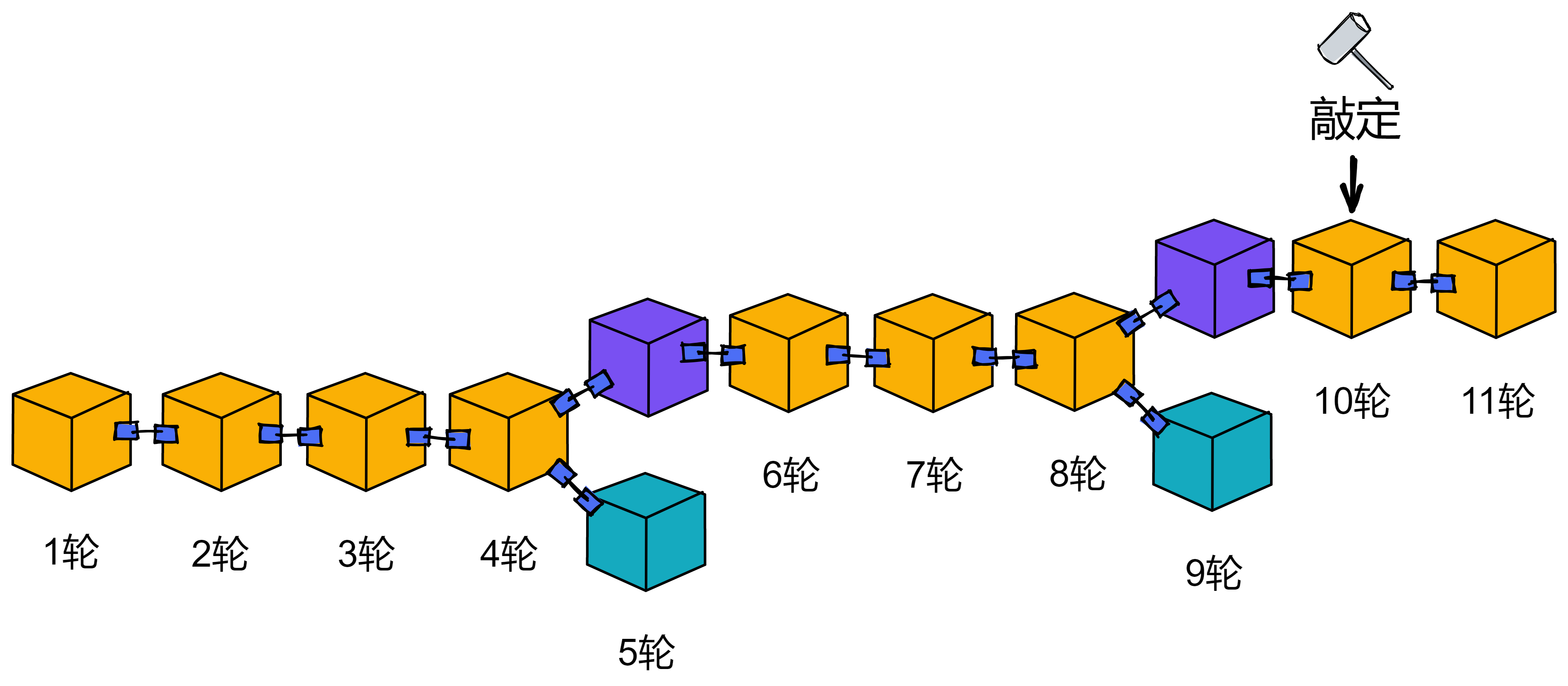

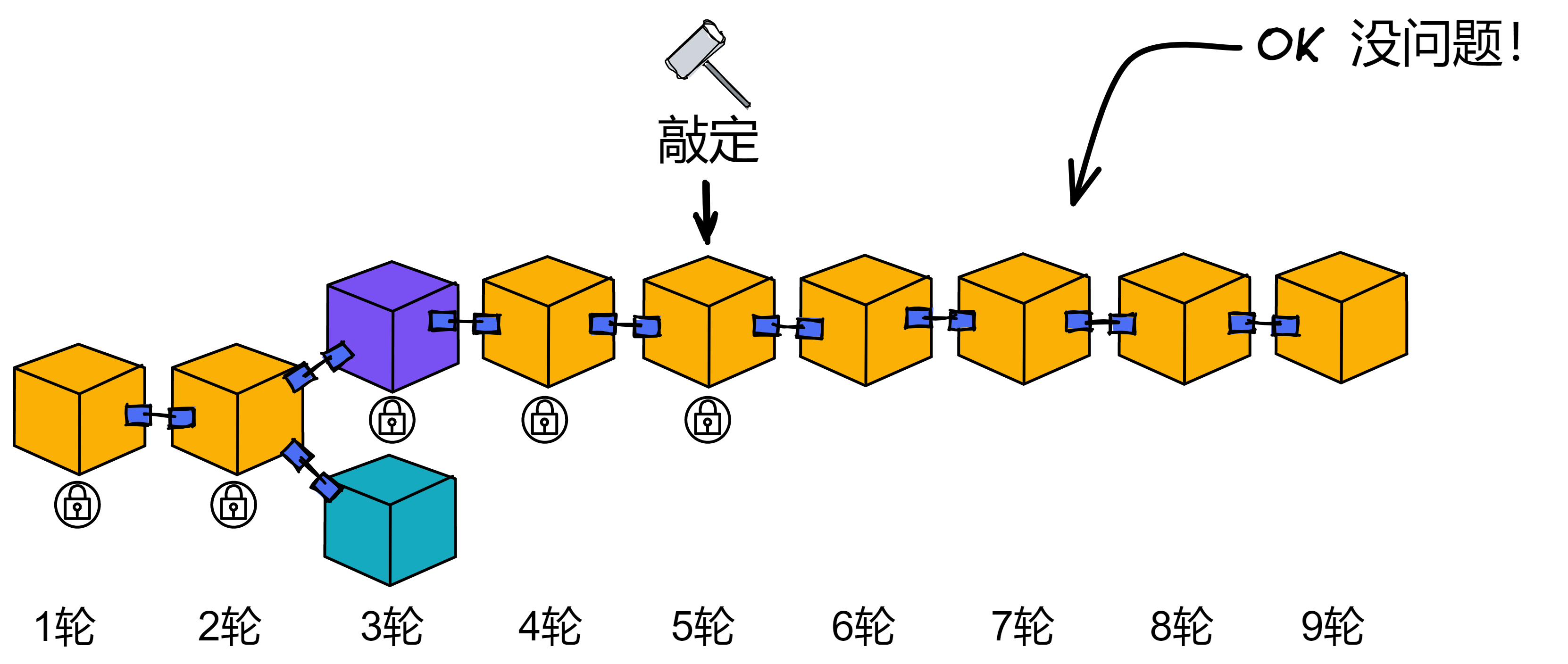

通过不可预测的随机数给副本们排序,选择谁先出块。如果被选中的副本诚实且没有故障问题,它就会出块,并广播给大家验证。大家觉得没问题,给出自己的公证片段。公证片段达到三分之二后,形成对这个区块的公证。如果大多数副本只对这一个块做过公证,大家会用敲定作为对区块的最终确认。

IC 的共识协议满足:低延迟(几乎即时最终确认性);高吞吐量;鲁棒性(在副本或网络故障时,延迟和吞吐量会稳定下降一点,而不是直接卡住宕机)

在这里了解 IC 共识层的更多运行机制。

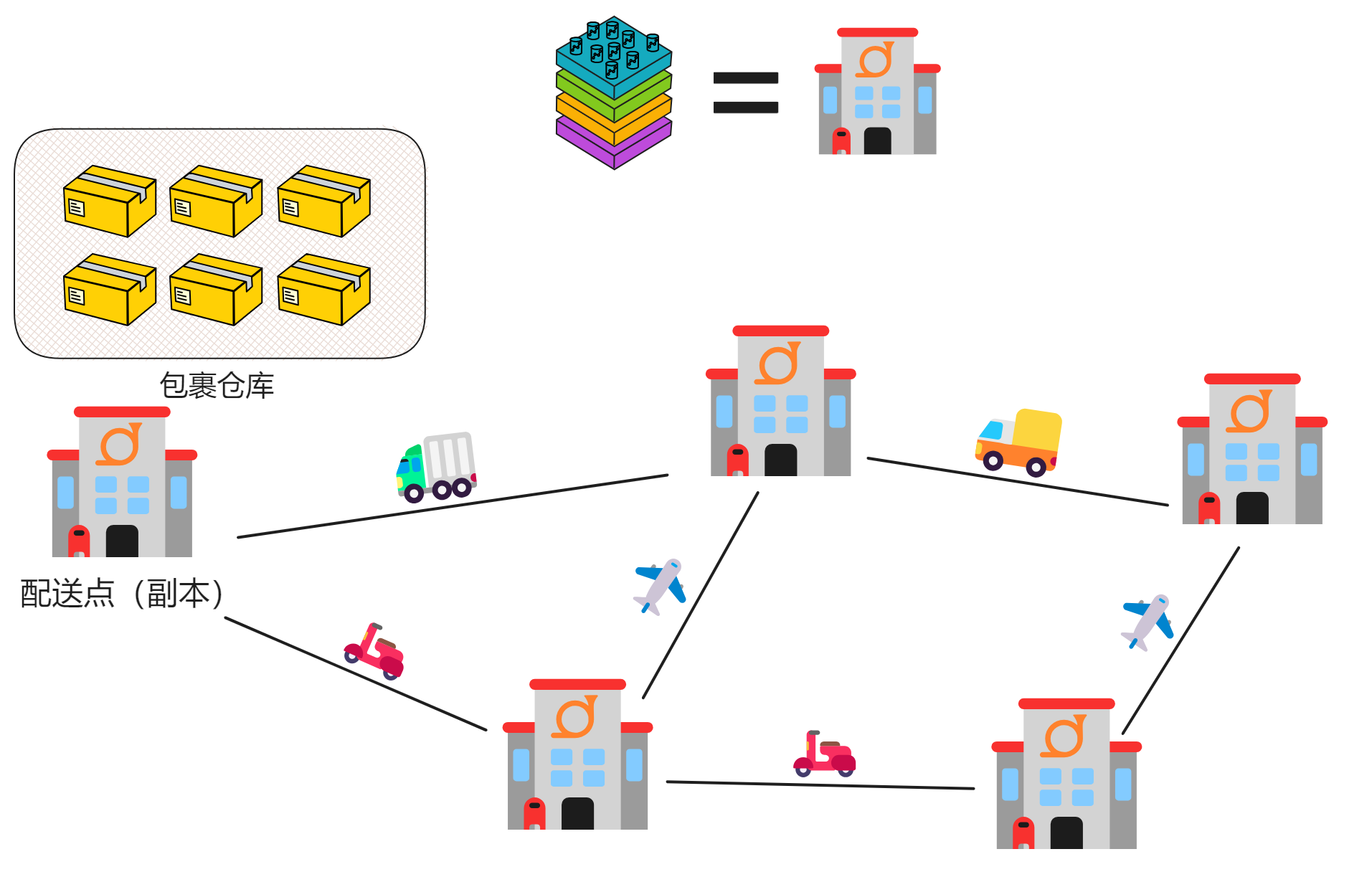

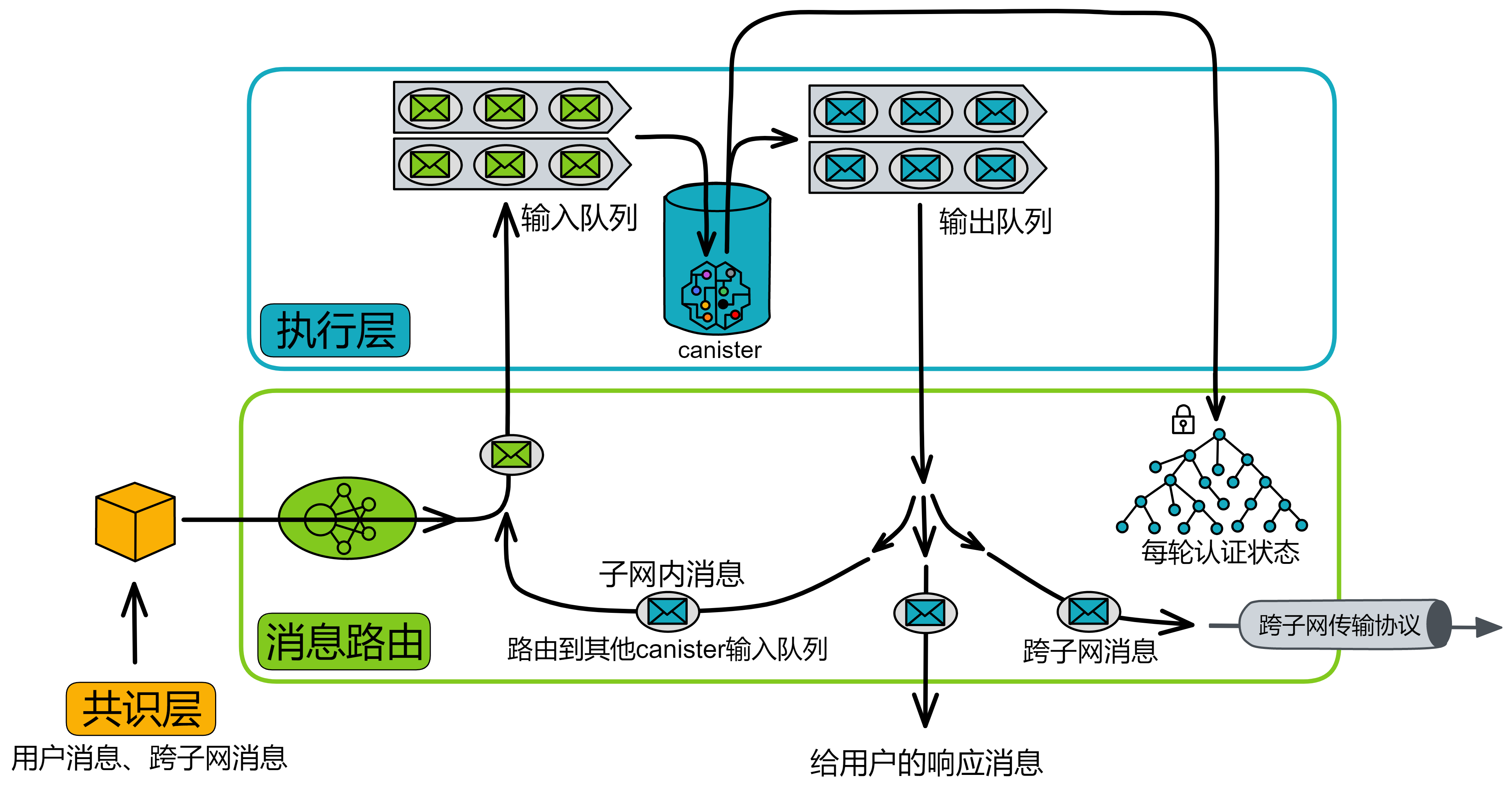

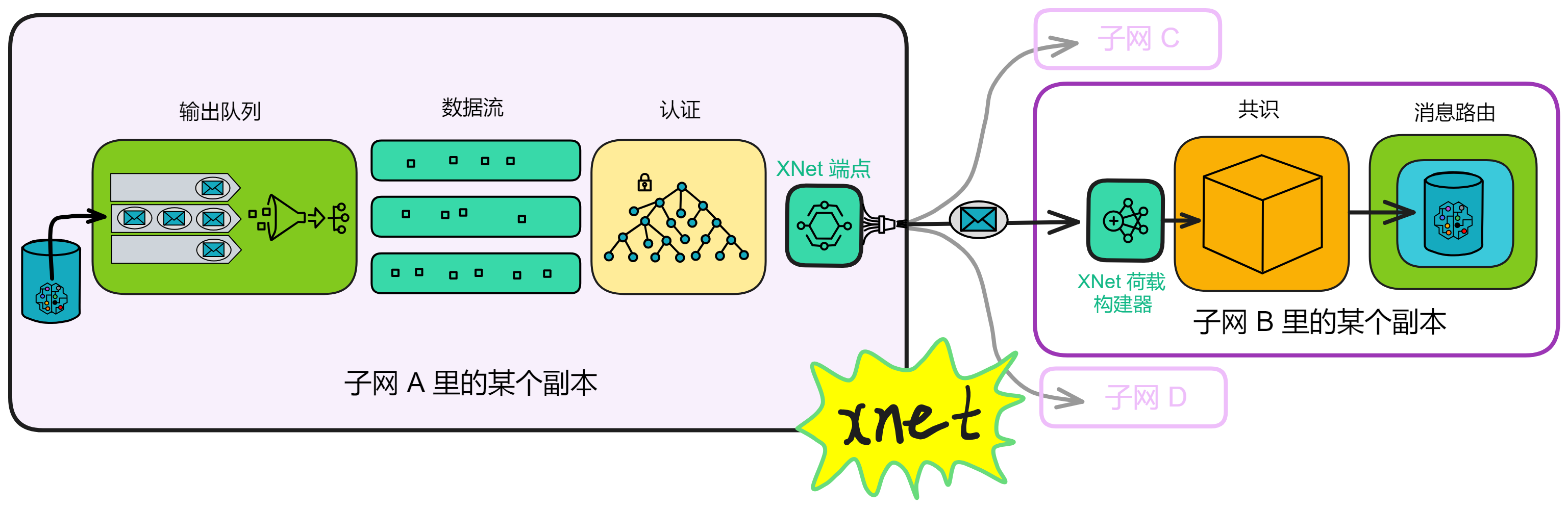

消息路由

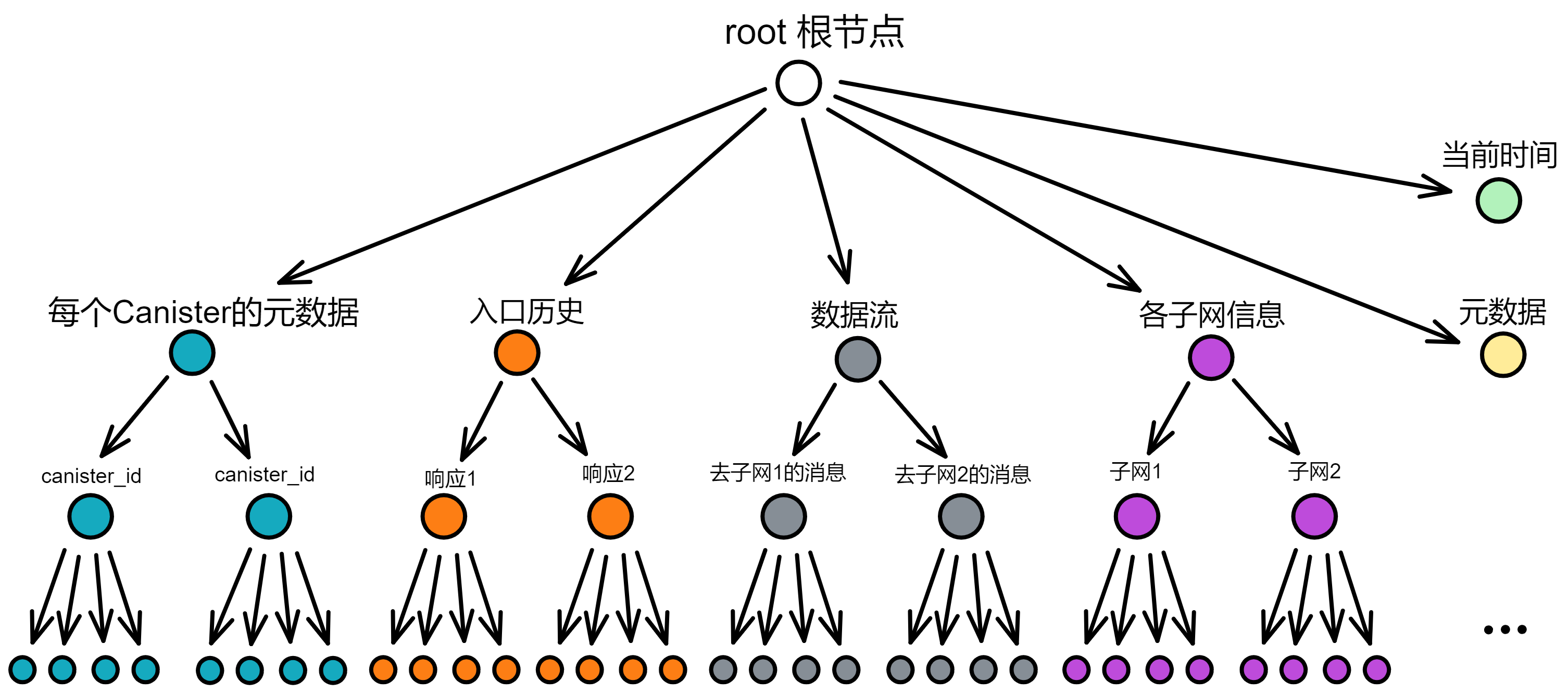

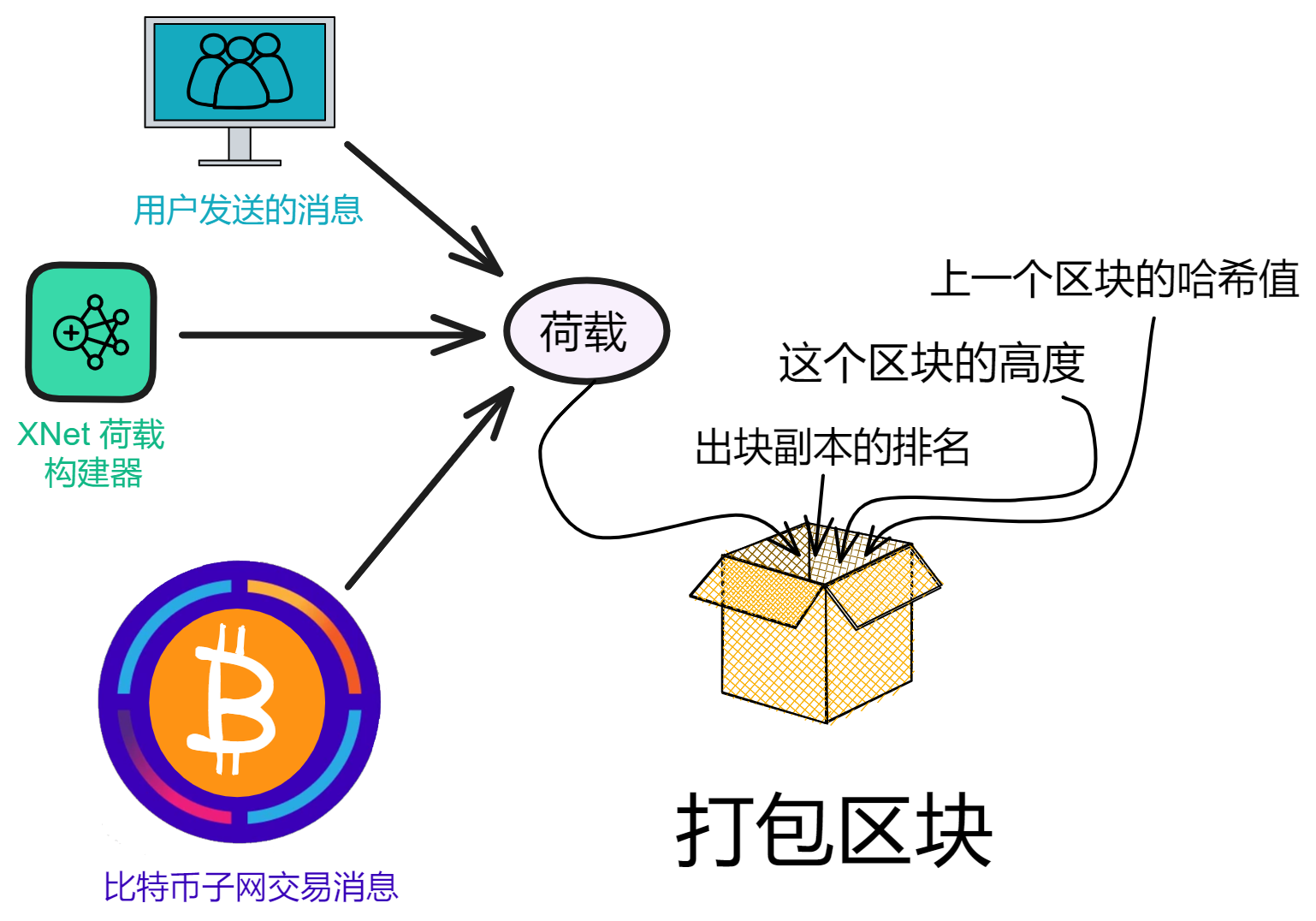

在 IC 的每个轮次中,共识层把输入打包进区块的荷载中,在共识层最终确认之后,相应的荷载会被传递给消息路由层。消息路由组件从共识接收一个要处理的消息。消息路由把消息路由到对应 Canister 输入队列里。然后它触发执行,执行完成后,Canister 把结果放进输出队列。最后将输出交给消息路由层发送出去。

消息路由层还可以进行子网之间的通信。这个叫跨子网消息或简称为 XNet 消息。

消息路由层实现的另一个关键功能是状态认证。子网在每个轮次里,会对子网在这一轮次改变的状态进行 BLS 阈值签名。这种认证可以用于子网验证一个子网到另一个子网数据流的真实性,也可以让用户在读取之前提交的消息的响应。状态认证和安全的 XNet 协议使得 Canister 能够在子网之间安全透明地通信,这是任何具有多个分片的区块链都面临的挑战。

注意,共识层和消息路由层是独立的。传入荷载之前,共识中的分叉都已经被解决了。而且共识层可以提前进入下一轮次运行,并不需要和消息路由层保持完全一致的进度。

在这里了解 IC 消息路由层的更多运行机制。

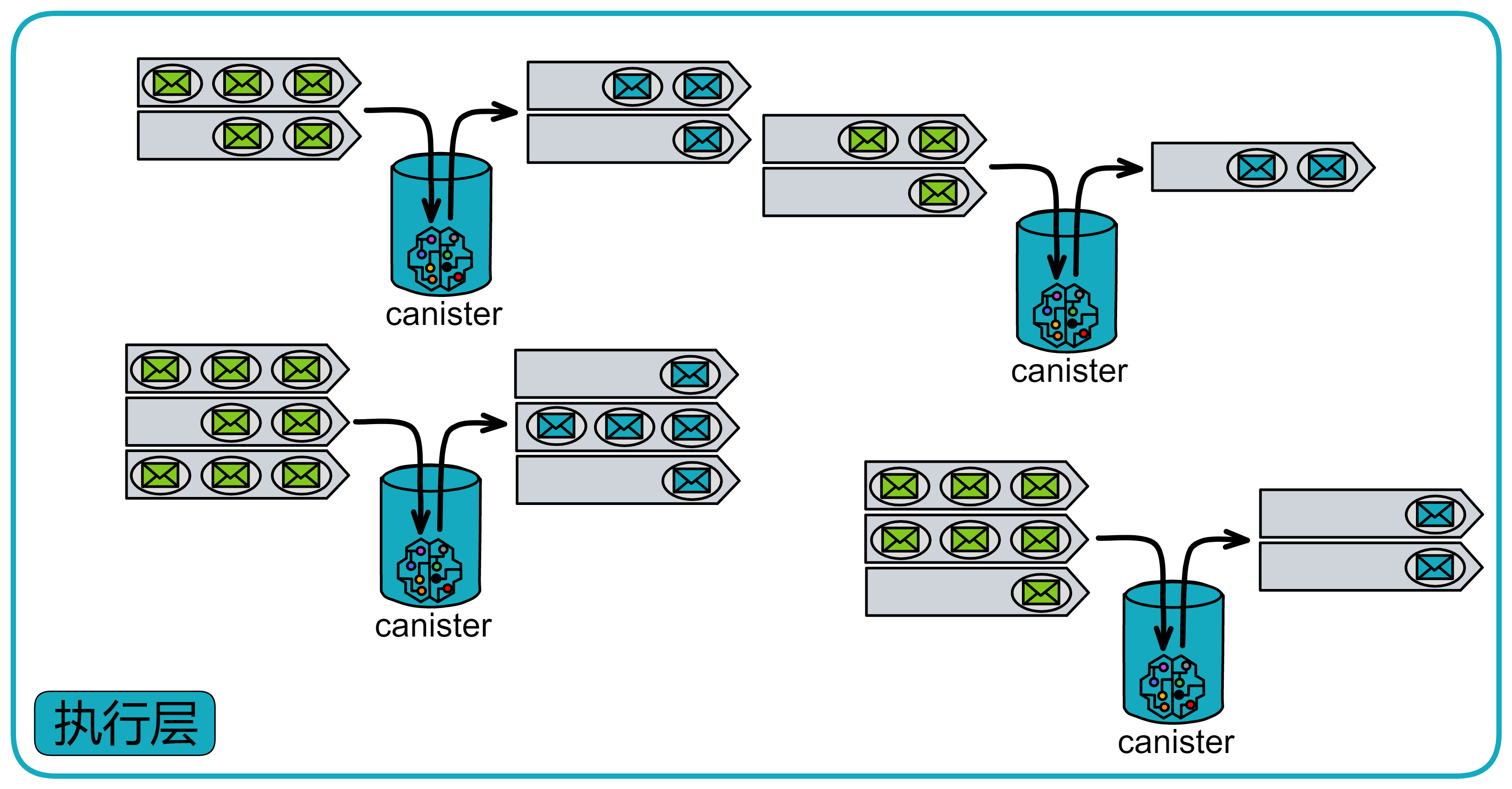

执行

IC 中的基本计算单元叫做容器或罐子(Canister)。IC 提供了运行环境,使得 Canister 中可以执行程序,并可以(通过消息)与其他容器 Canister 和外部用户通信。

执行层有许多其他区块链没有的功能:

-

确定性时间分片(DTS):需要执行数十亿条 Wasm 指令的大消息时,可以拆开,在之后的几次共识中逐步完成。这种拆分在几次共识中执行消息的能力是 IC 独有的。

-

并发:在多个 CPU 内核上同时执行多个 Canister 。因为每个 Canister 都有自己的隔离状态。

-

伪随机数生成器:执行层可以访问不可预测且无偏的伪随机数生成器。现在 Canister 可以执行需要随机性的算法。

在这里了解 IC 执行层的更多运行机制。

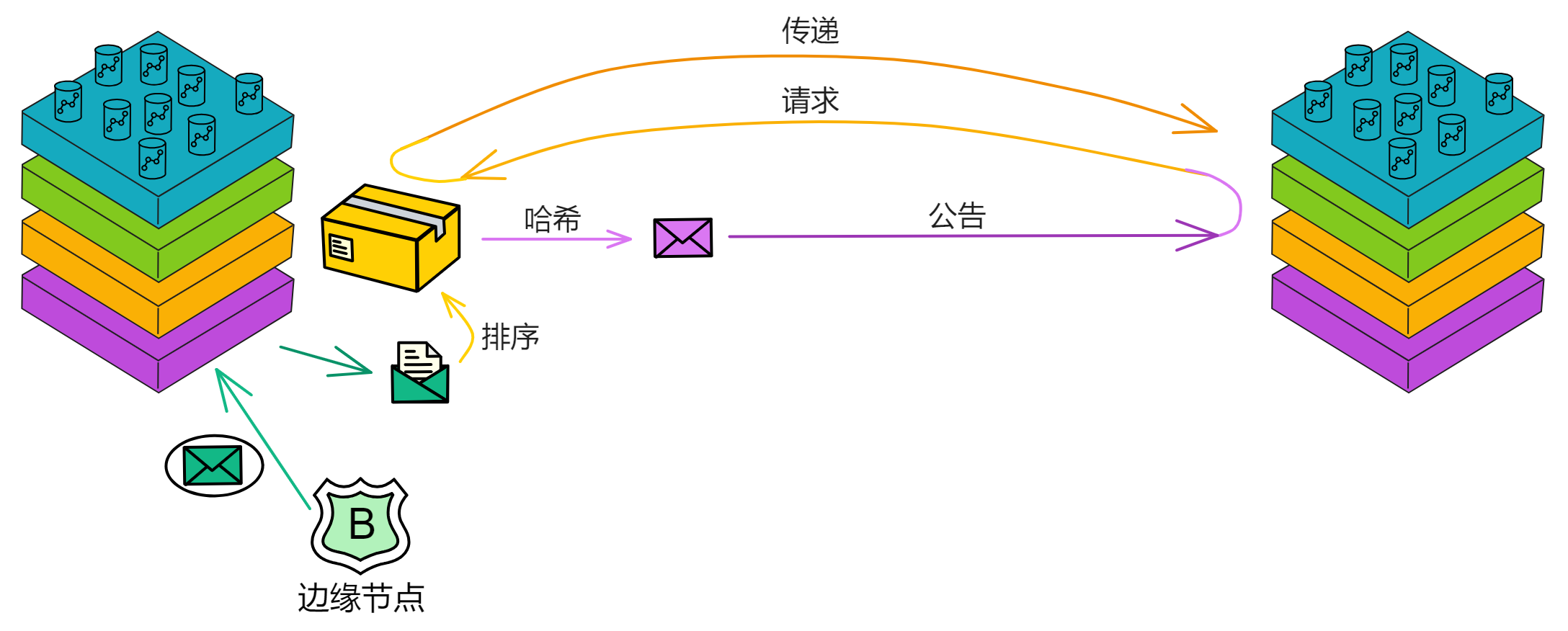

边缘节点

前面说过,IC 就是去中心化的云,可以给用户直接提供完整的网络服务,而不依赖任何中心化服务。

那么用户的请求是怎么发给某个子网里的副本(节点)的? IC 是怎么防护 DDoS 攻击的?有防火墙吗?有 CDN 缓存吗? 😏 You know what I mean.

这些服务就是 IC 的边缘节点(Boundary node)提供的。

边缘节点负责把请求转发到对应的子网,保护子网,提供缓存。

当用户通过浏览器访问 IC 时,IC 会通过域名上的 Canister id 找到对应的 Canister 。首先,浏览器会查找域名对应的 DNS 记录,得到边缘节点的 IP 地址。然后向边缘节点发送一个 HTTPS 请求。边缘节点返回一个 JS 库 “ 服务助手 ”(或网络服务助手,Service worker),在浏览器上运行。

这个服务助手的一个主要任务就是用链钥密码学来验证 IC 发过来的响应。为了实现这个功能,NNS 的公共验证密钥被硬编码在服务助手里面。

边缘节点负责把我们的请求路由到目标 Canister 的子网副本。它从 NNS 获取所需的路由信息,并在一个实时响应的副本列表中随机选择一个。用户和边缘节点之间,以及边缘节点和副本之间的通信安全都是由 TLS 保证的。

除了和主网通信,边缘节点还提供了缓存、负载均衡、速率限制、防火墙和验证 IC 响应消息的能力,让用户体验更好。

在这里可以看到更多关于边缘节点的内容。

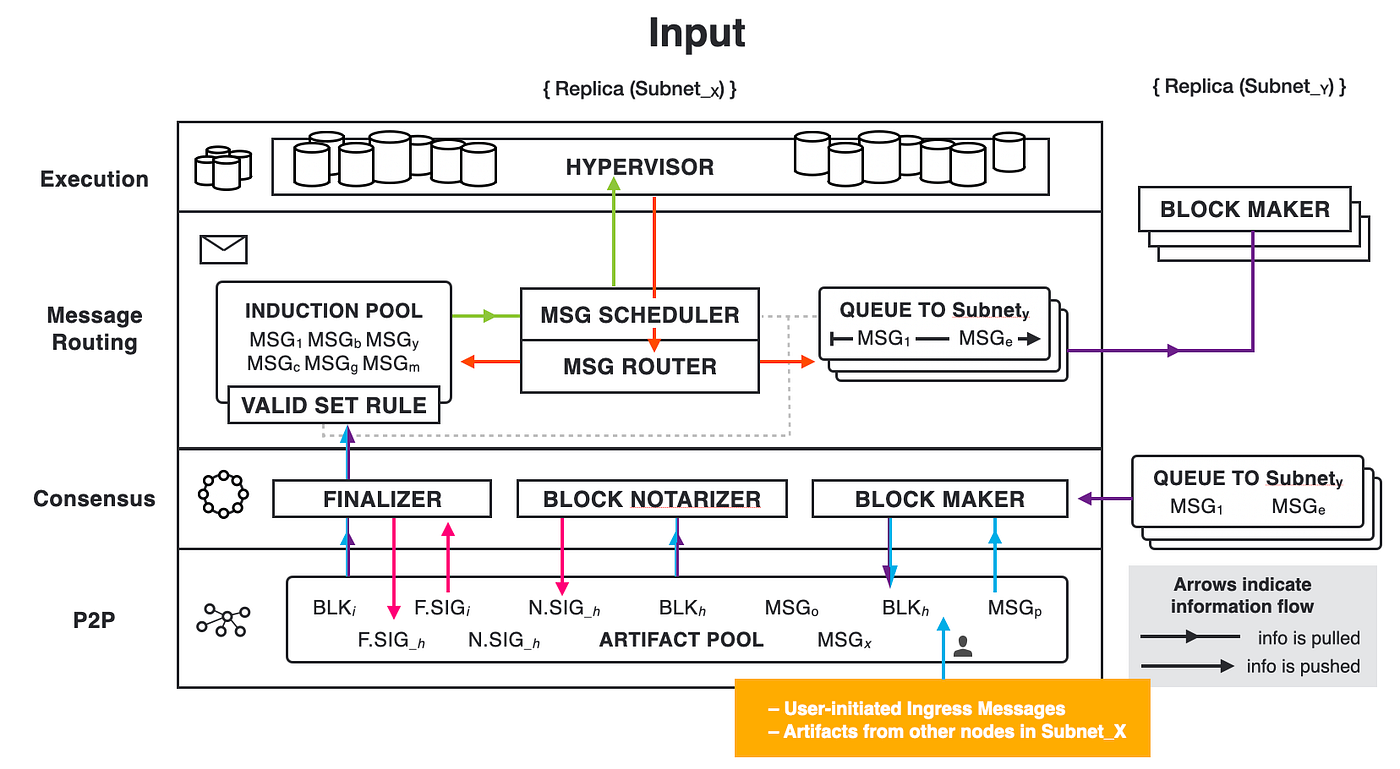

请求消息流程

有了这 4 层核心协议,再来看看 IC 上一个用户请求的流程:

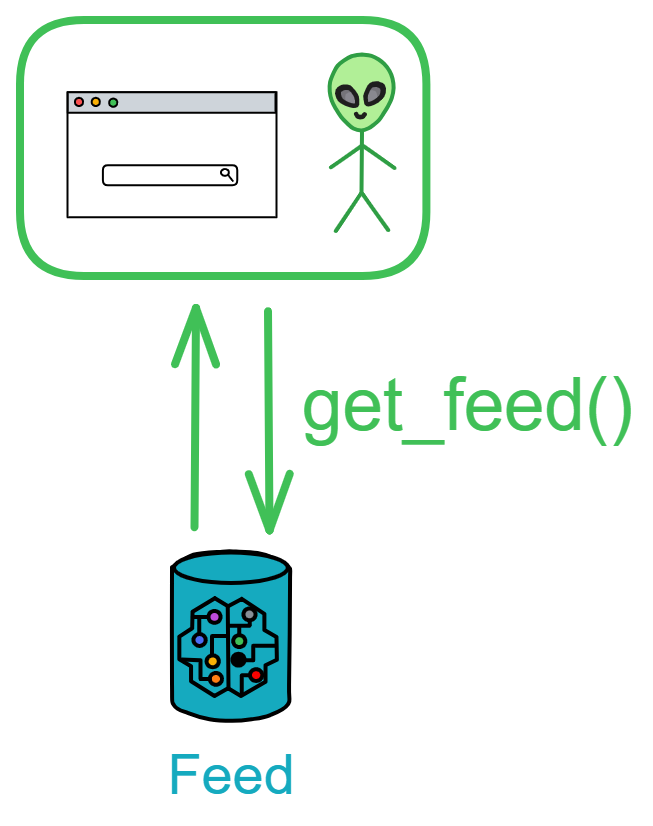

用户请求分为查询调用和更新调用。

查询调用:

客户端向边缘节点发送一个请求消息,想要访问某个容器。边缘节点把这个消息传送给托管目标容器的子网中的副本。副本收到消息后,返回响应,再通过边缘节点发给用户。

更新调用:

客户端向边缘节点发送一个请求消息 M ,目标是 Canister C 。边缘节点把消息 M 传送给托管 Canister C 的子网副本。

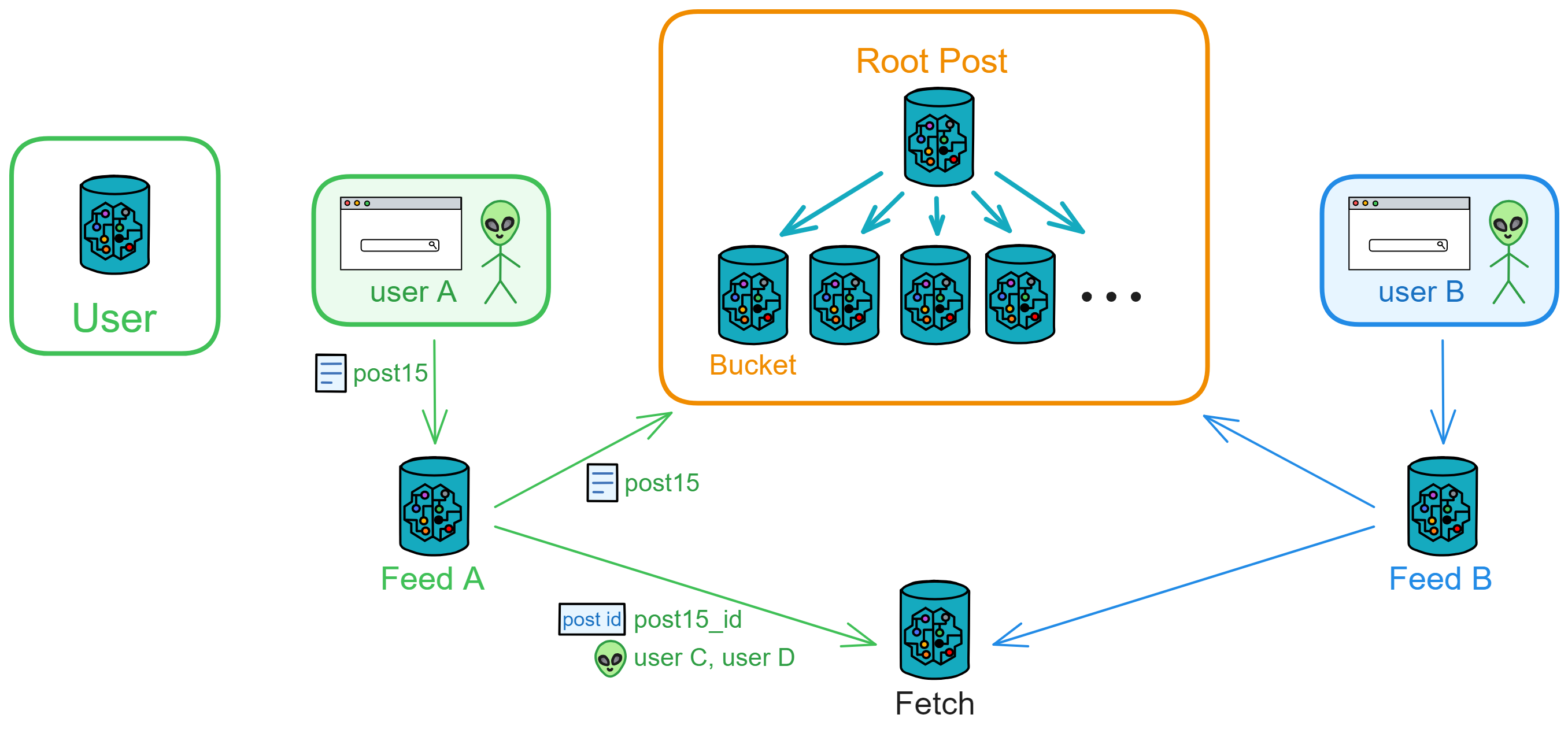

副本收到消息 M 后,通过 P2P 层向子网中的所有副本广播消息 M 。

收到消息 M 的主节点会把消息 M 和其他输入打包进一个区块 B 。

一段时间后,区块 B 被确认,里面的内容被发送到消息路由层处理。

消息路由层把消息放进 Canister C 的输入消息队列。

执行层处理消息 M ,并更新 Canister C 的内部状态。

随后消息路由取出响应 R 交给边缘节点,返回给用户。

有时候,处理请求消息 M 需要调用其他子网的 Canister 。比如,Canister C 需要向另一个子网的 Canister C' 发起请求 M' 。请求 M' 会被放在 Canister C 的输出队列里,然后执行以下几步:

- 消息路由层把调用请求 M' 移到对应的跨子网数据流,最后传输到托管 Canister C' 的子网。

- 第二个子网收到请求 M' ,通过共识层和消息路由层,最后由执行层处理。执行层更新 Canister C' 的状态,生成请求 M' 的响应 R' 。响应 R' 会进入 Canister C' 的输出队列,最后被传回第一个子网。

- 回到第一个子网,收到来自第二个子网的响应 R' 后,经过共识层、消息路由层和执行层的处理。执行层会更新 Canister C 的状态,生成原始请求 M 的响应 R 。这个响应 R 会被记录在入口历史的数据结构中。

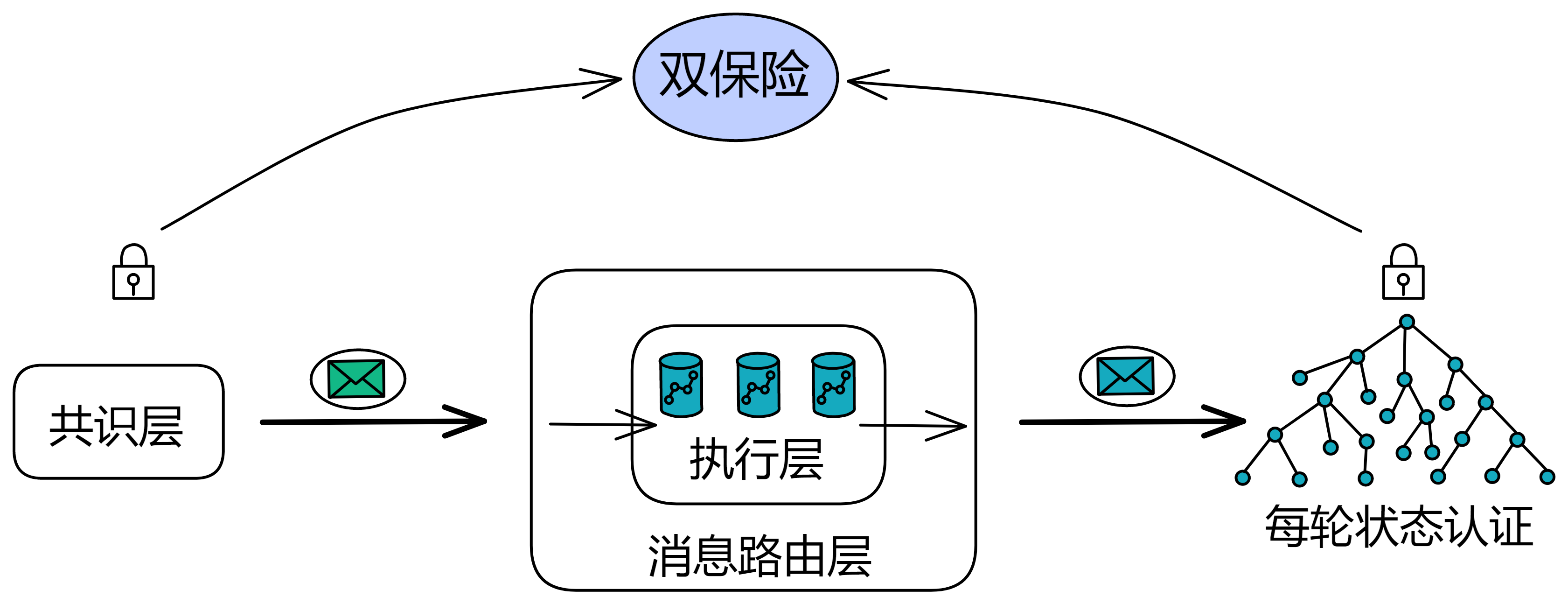

链钥密码学

IC 使用了一种高级加密机制工具箱,统称为链密钥密码学(Chain Key)。这种技术让 IC 实现了其他区块链无法实现的功能和可扩展性。

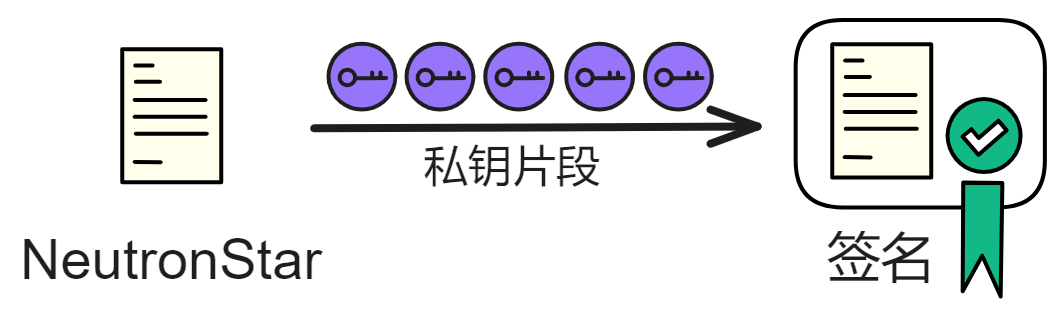

它的一个关键组成部分是阈值签名方案,这类似于普通的数字签名方案,但它有个不同之处,就是秘密签名密钥分布在子网的副本中,这样密钥就不会被轻易泄露或窃取。

链密钥带来了很多好处。比如:

-

任何人(手机、平板电脑、笔记本电脑)都可以简单地验证签名,以验证从 IC 接收到的内容,而无需同步整个区块链。

-

它能让 IC 的拓扑结构可以自主演化,比如添加新的副本和子网,恢复故障副本,以及自主升级协议。

-

它还能提供不可预测和无偏的伪随机数,让 Canister 可以安全地运行需要随机性的算法。

IC 的关键创新在于子网实际上是共识的孤岛。有了链密钥,它们可以安全地互相通信,并在不下载其他区块链数据的情况下验证对方的消息。这使得 IC 能够实现高度的可扩展性和安全性,同时保持轻量级和易于验证的特性。

这种独特的链密钥技术为构建下一代分布式应用提供了强大的基础。

网络神经系统(NNS)

IC 跟比特币和以太坊的去中心化方式有点不一样。它的节点不是随时随地、想加入就加入,而是你要加入或退出,都不需要受任何第三方中心化机构约束。节点加入 IC 网络之前,需要经过 NNS 的投票同意。IC 的底层协议里是直接嵌入了 DAO 来进行治理。

详细解释一下:

最早的共识协议,比如 PBFT ,是有许可的。也就是说网络的拓扑结构和节点是固定的,不是谁想加入就加入的。虽然这样的协议效率更高,但是它们违背了去中心化的精神。所以,现在有了像比特币、以太坊这样的无许可共识协议,它们使用工作量证明(PoW)或权益证明机制(PoS)。这些协议虽然完全去中心化,但效率相对较低。

IC 结合了他俩的优点,它既有有许可协议的效率,又有无许可 PoS 协议的好处。你可以叫它 DAO 控制网络(DAO-controlled network)(半许可网络)。

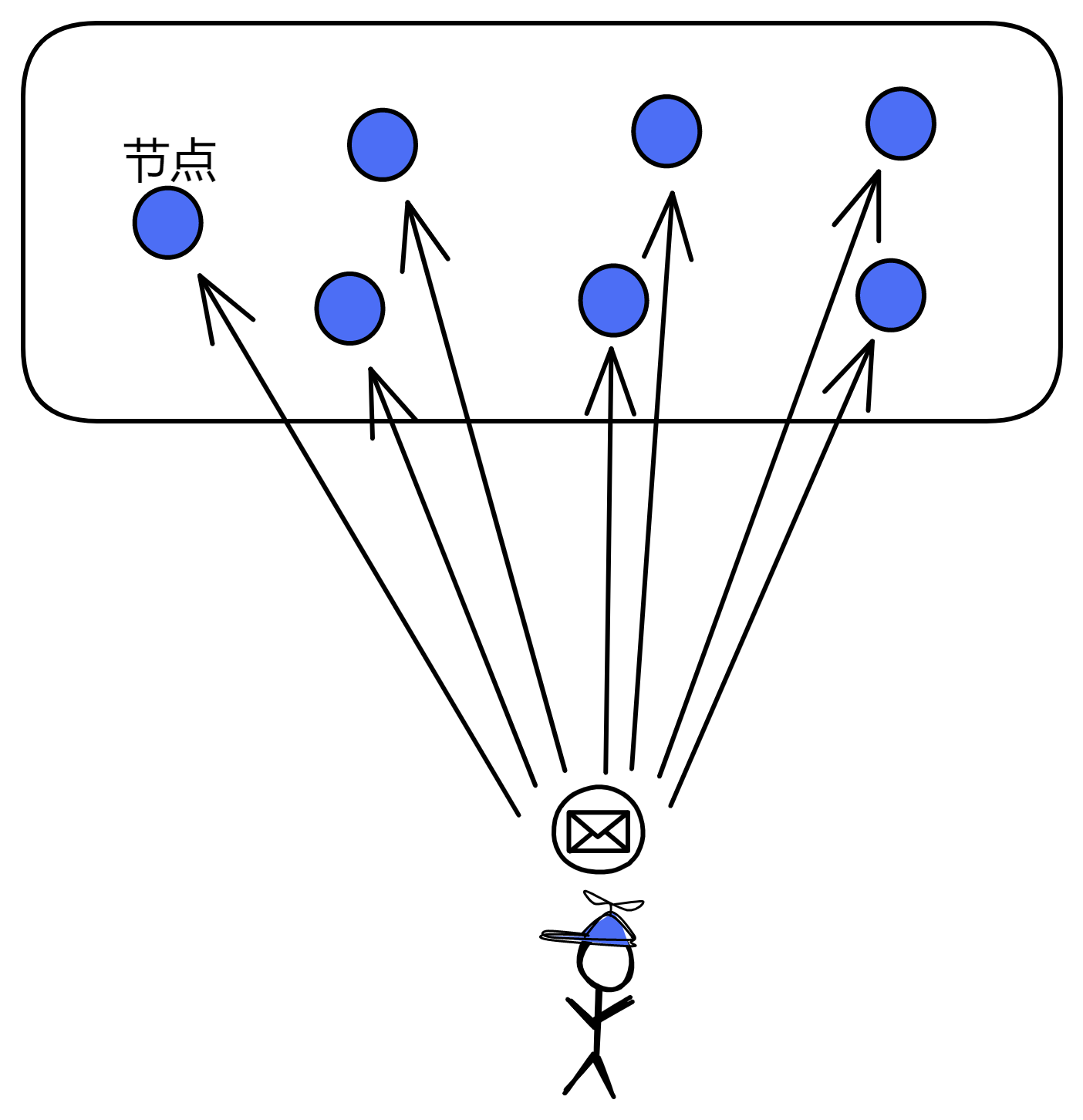

每个子网都运行一个有许可的共识协议,子网里的副本(节点)是固定的。在需要调整网络拓扑结构的时候,由一个叫做 网络神经系统(Network Nervous System) 的 DAO 决定哪些节点可以加入某个子网,配置网络的拓扑结构,配置公钥,以及控制副本部署的协议版本。NNS 的决策都是由社区成员投票决定的,投票权跟他们在 NNS 中质押的 ICP 有关。质押的数量越多、时间越长、参与投票越多,权重越大。

通过这个治理系统,IC 可以在现有子网中增加或移除副本;可以部署软件更新;可以对副本进行升级;可以创建新的区块链子网,实现扩容;可以拆分子网,来均衡网络负载;它可以配置经济参数,如调节 Gas 代币 Cycle 与 ICP 的兑换比例,Cycles 燃烧比率;在极端情况下,它可以冻结恶意的 Canister ,保护网络,等等。NNS 运行在特定的子网上,和其他子网差不多。只是副本数量更多,更安全,NNS 的子网是系统子网,只部署着几个最重要的 Canister 。

系统子网中的容器不收取 Cycles 费用,因为只部署了几个 IC 系统自己的 Canister 。普通开发者不能在系统子网上部署 Canister 。所以 IC 是由一个 DAO 来管理所有子网的。

NNS 维护着一个叫做注册表的数据库,用来跟踪 IC 的网络拓扑结构,比如哪些副本属于哪个子网,副本的公钥是啥等等。

IC 的 DAO 控制网络既让 IC 享受到有许可网络在效率方面的好处,又保留了去中心化网络在 DAO 治理下的优势。而且,运行 IC 协议的副本都托管在地理上分布式的、独立运行的数据中心上,这样也增强了 IC 的安全性和去中心化性。

智能合约(Canister)

当我了解 IC 之后,第一次见到能直接部署网页的区块链。( ఠൠఠ )ノ

IC 是唯一可以托管完整 DApp(前端、后端和数据)的区块链。IC 可以安全地提供 HTTP 请求。

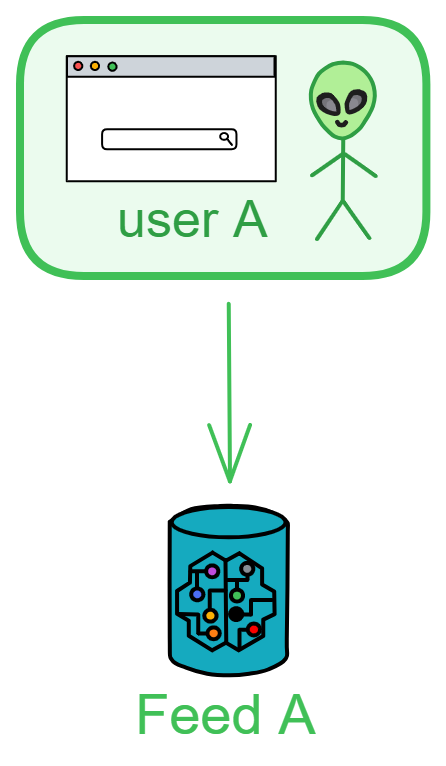

Canister 就是 IC 的智能合约,可以存储代码逻辑、数据状态、前端资源。开发者无需关心底层通信,只要把代码部署到 Canister 里,用户就可以直接通过网址访问到应用。

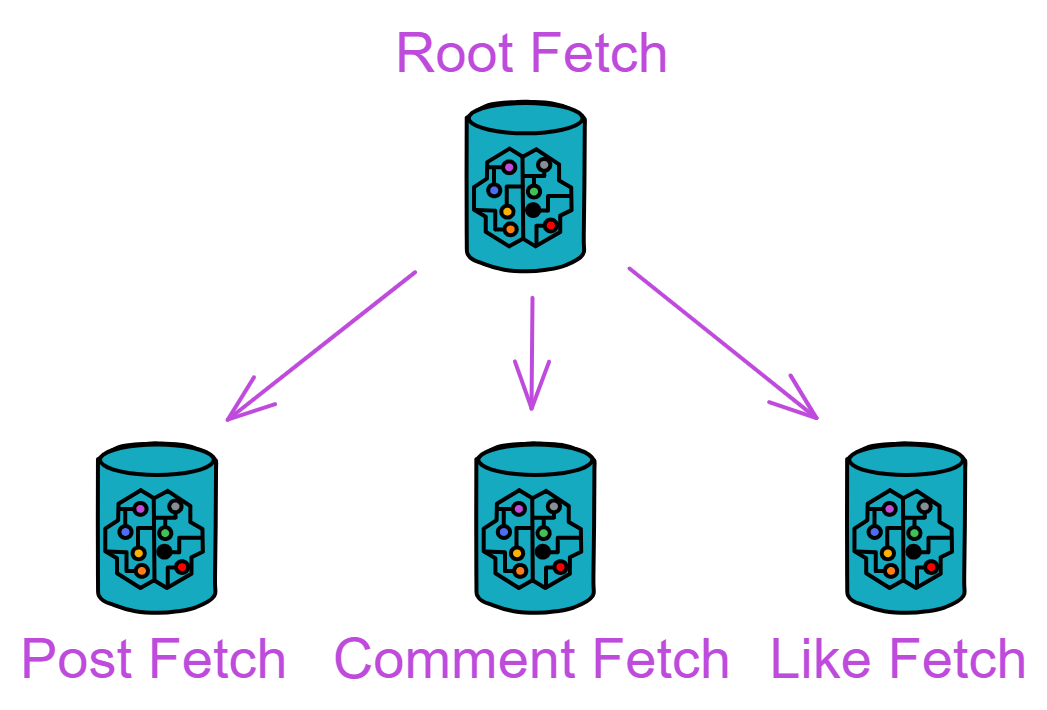

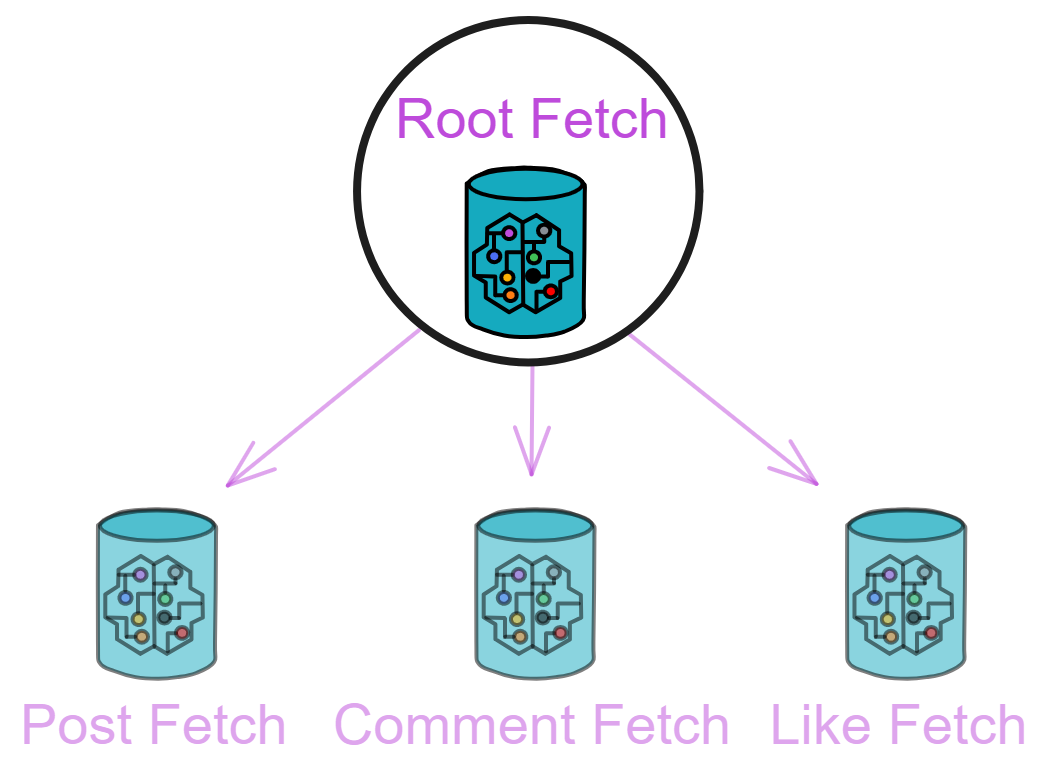

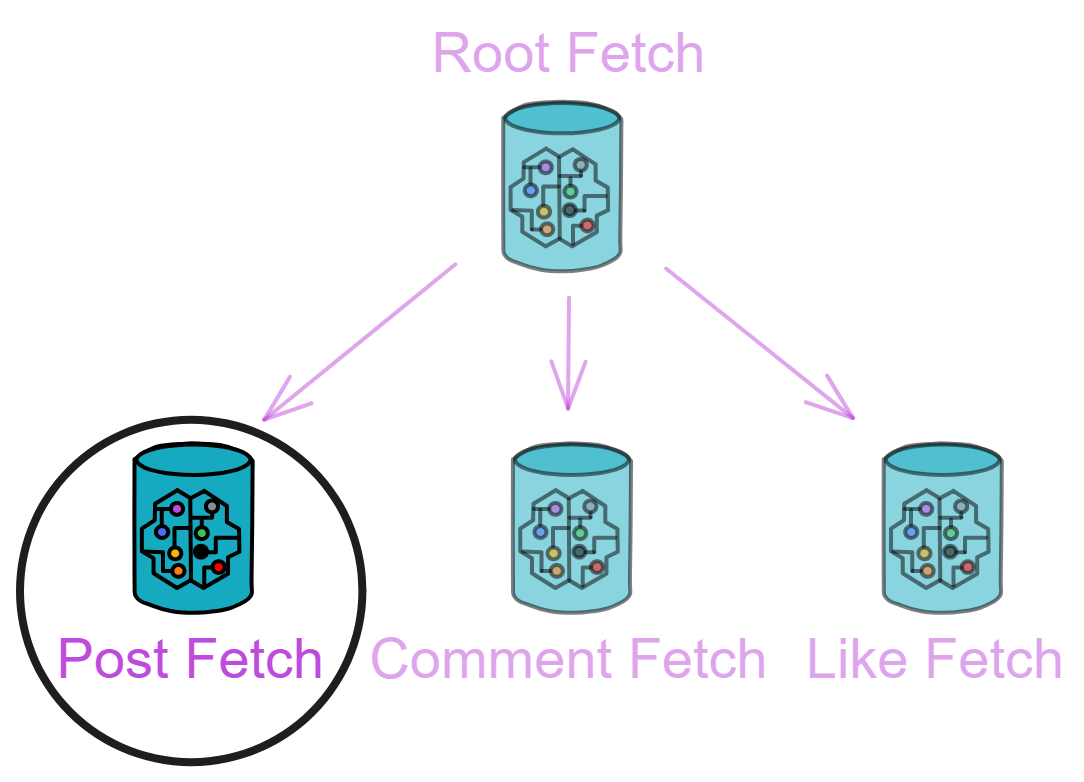

比如项目里有一个专门放前端页面的 Canister 和一个后端 Canister 。客户端发请求,浏览器发出请求后,浏览器需要先从边缘节点下载一个 Service Woker 检查浏览器是否支持 Wasm 、网络环境是否安全等等。Service Woker 可以验证前端页面是否来自 IC ,是否经过篡改。请求消息经过 IC 协议定位到某个前端 Canister ,前端 Canister 直接发送 HTML 网页到客户端。之后通过官方的 JS 代理库与后端 Canister 交互。Canister 之间也可以互相调用交互。

ETH 是一台同步的状态更新机器,由交易触发智能合约,然后达成共识;IC 是一台异步状态更新机。只要客户端发出消息传到 IC ,就会返回一个结果:成功或者失败。

IC 对以太坊 DApp 开发和传统 Web 开发做了简化。开发 DApp 无需第三方钱包,也不用开发者考虑负载均衡、防火墙,这些都由 IC 协议层解决。

上面说的只是最简单的 DApp 项目实例,实际开发中,一个 DApp 一般都有很多个 Canister 。

Canister 英语原意为罐子、容器,是一种轻量级 Wasm 容器。

Canister 自动持久化数据于内存中,无需数据库服务器和存储管理,提升了计算效率并简化了软件开发。所有可以编译为 Wasm 字节码的语言理论上都可以用来写 IC 的智能合约:Motoko 、Rust 、C 、C++ 、Go 、JavaScript 等等。(现在 Motoko 和 Rust 的 cdk 比较成熟,别的语言的 sdk 正在开发)因此,前后端都可以编译为 Wasm 并安装进容器里上链。当然也只有支持 Wasm 的浏览器才能打开 DApp ,不过支持 Wasm 的浏览器以后会越来越多。

还有 HTTP 集成,可以让 Canister 读取 IC 外部的任意网页,不用预言机!

在这里可以看到更多关于 Canister 的内容。

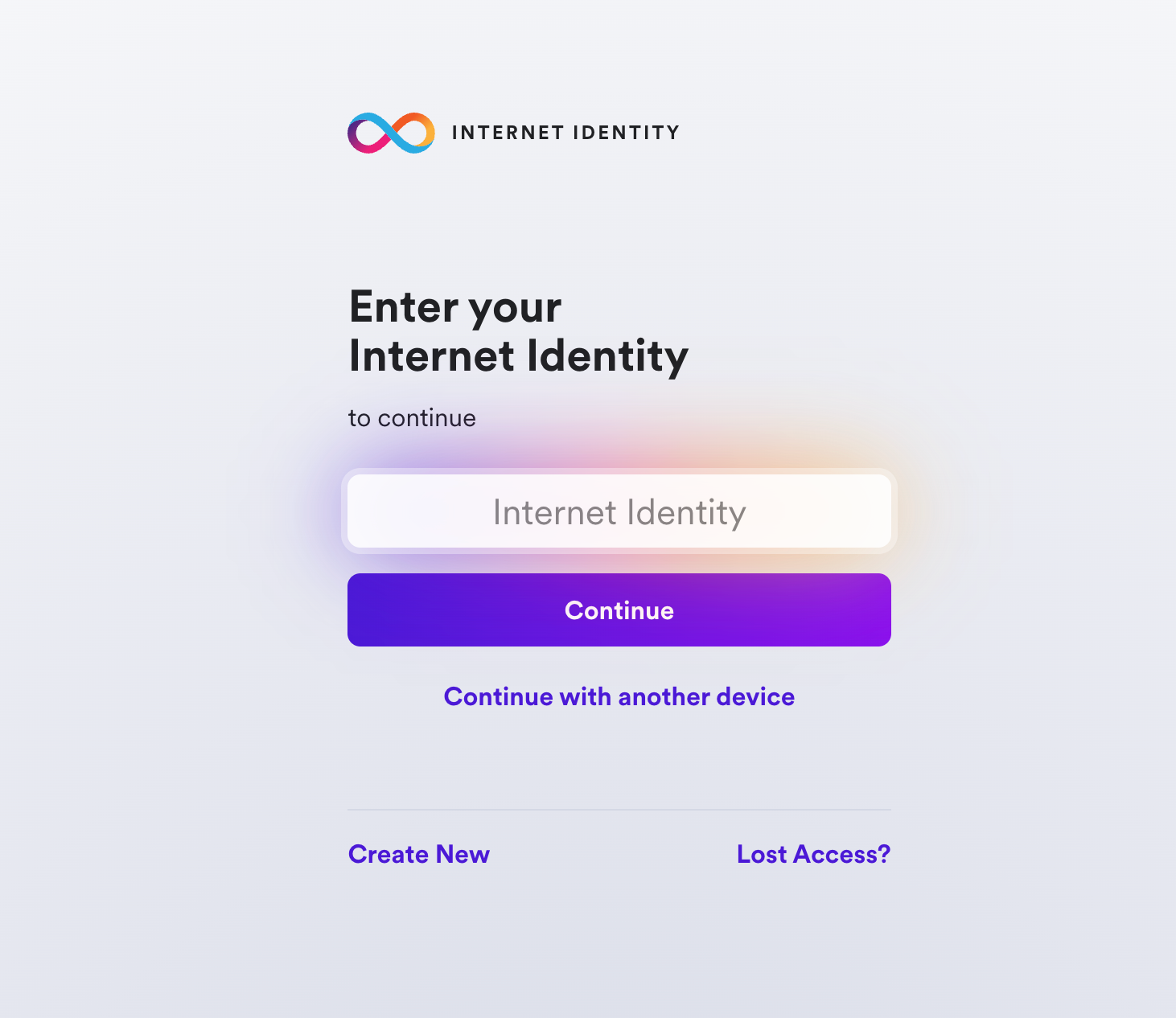

互联网身份

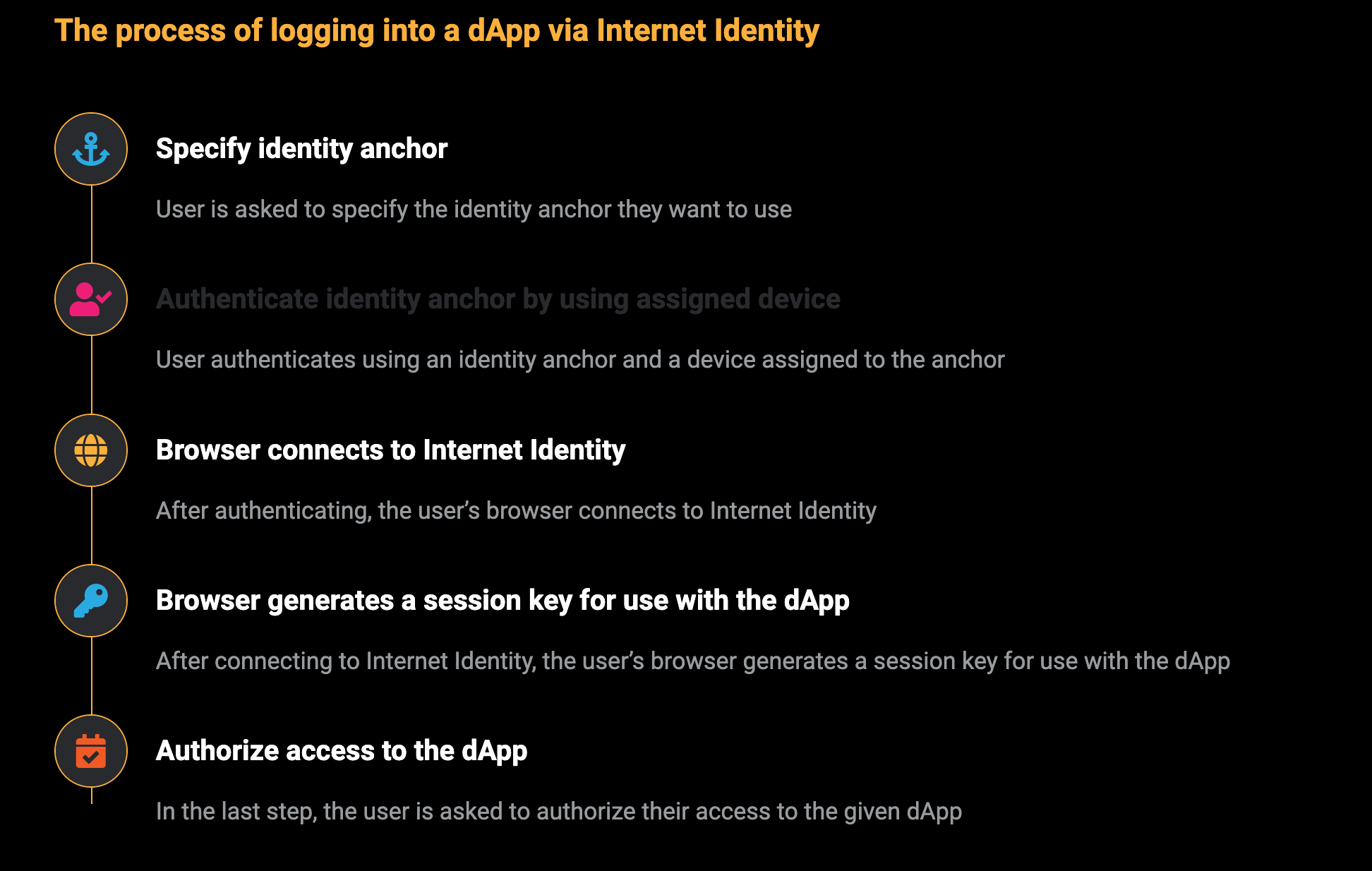

在网络上我们通常用用户名和密码来识别和验证身份,但这些方法很难管理,而且安全漏洞很多。为了解决这些问题,IC 做了一种更先进、更安全的加密身份验证方法,它叫做互联网身份(Internet Identity),可以在 IC 生态的 DApp 上使用。登录 DApp 时不需要输入任何密码,也不用记下复杂的私钥或者助记词,就可以轻松的控制自己的去中心化身份。

用户使用互联网身份时,网站就收集不到关于用户在线活动的信息了。因为它会帮你在每个网站上创建和管理匿名、独立的帐户,让你可以在不用担心管理这些帐户的情况下,享受到拥有许多不同帐户的隐私保护。它不仅让你摆脱了复杂的用户名和密码管理,还能让你在使用网络服务时更加安全、更加隐私。

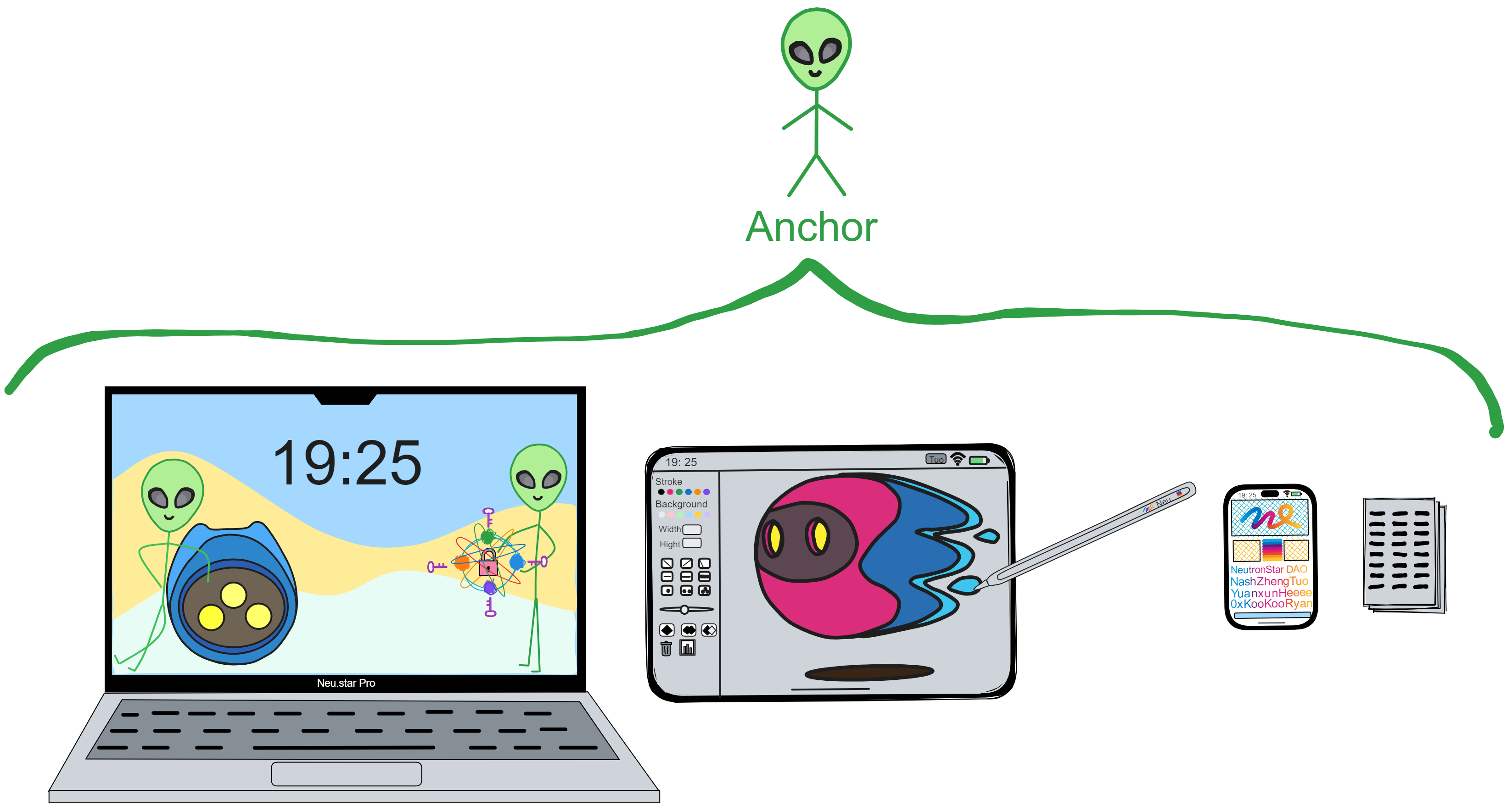

用户可以用设备进行面部扫描、指纹识别、Ledger 或者 Yubikey 硬件钱包,创建一个去中心化身份。用这个身份可以登录 / 注册各种 DApp 。

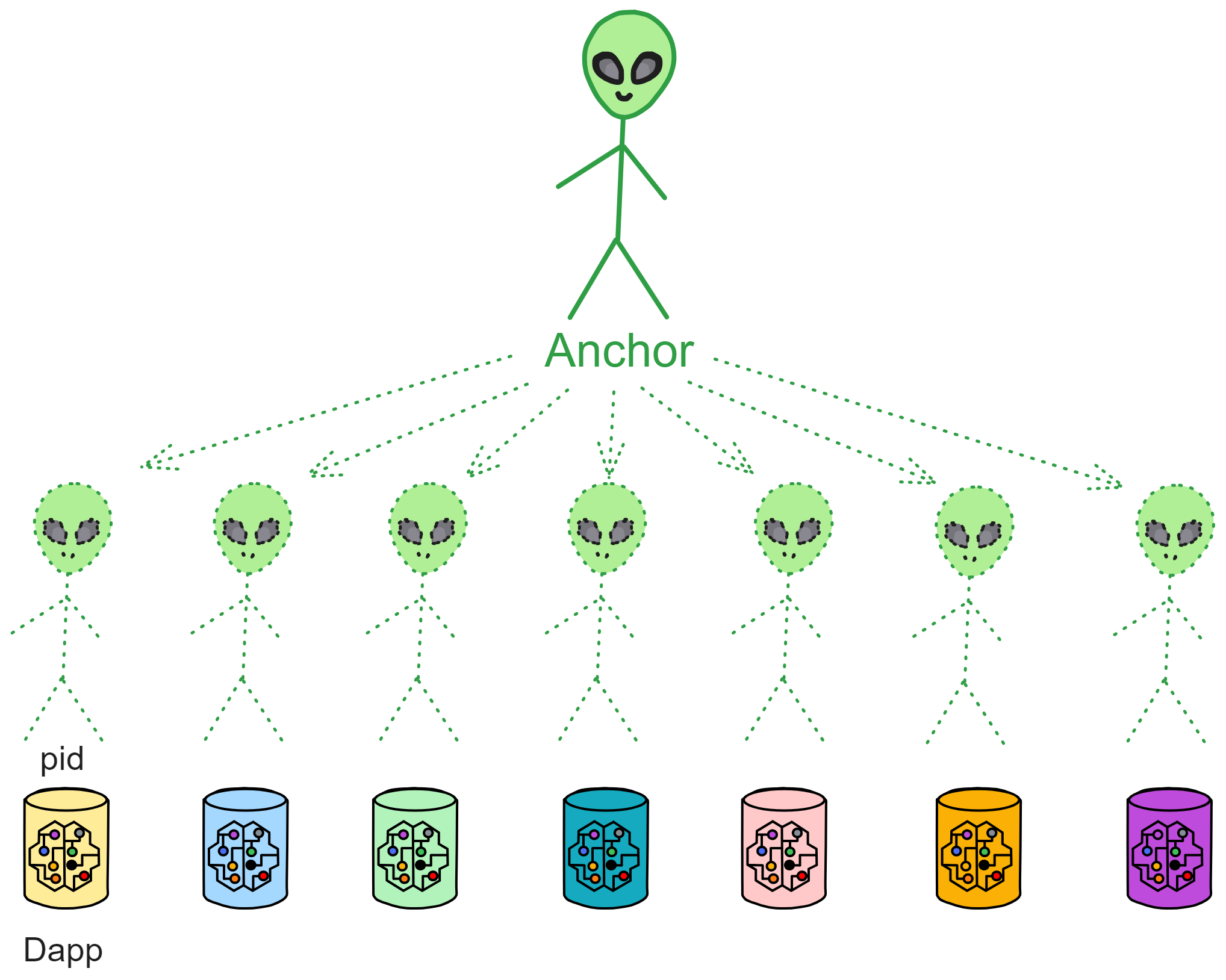

用这个身份登录不同的 DApp 会有不同的账户。也就是说,它是隔离的,身份不互通(和 ETH 不一样),这个身份在不同的 DApp 里是完全隔离的账户。在每个 DApp 里相当于从主身份里衍生出的一个分身,用一个 DID 身份控制所有的 DApp 。

我们喜欢叫它 “ ii ” 。

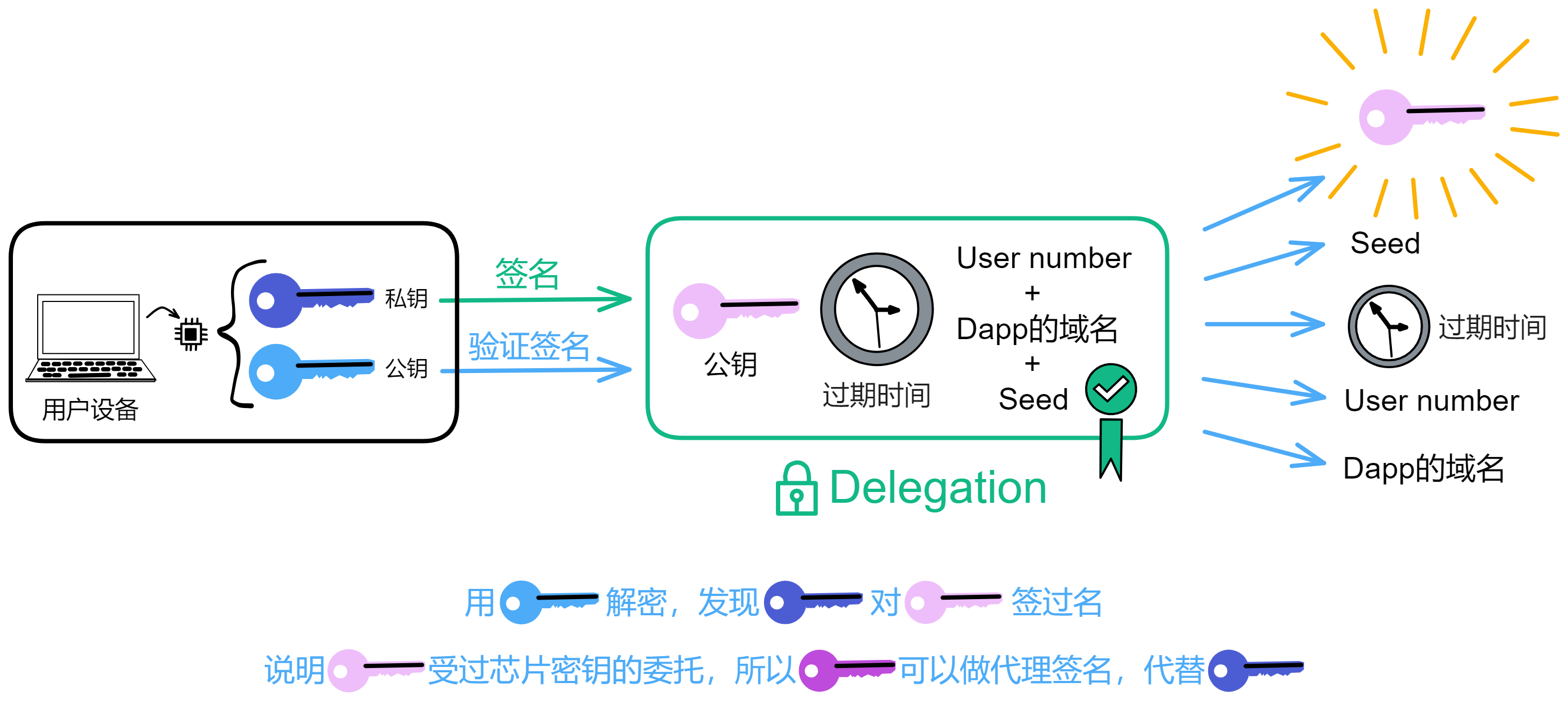

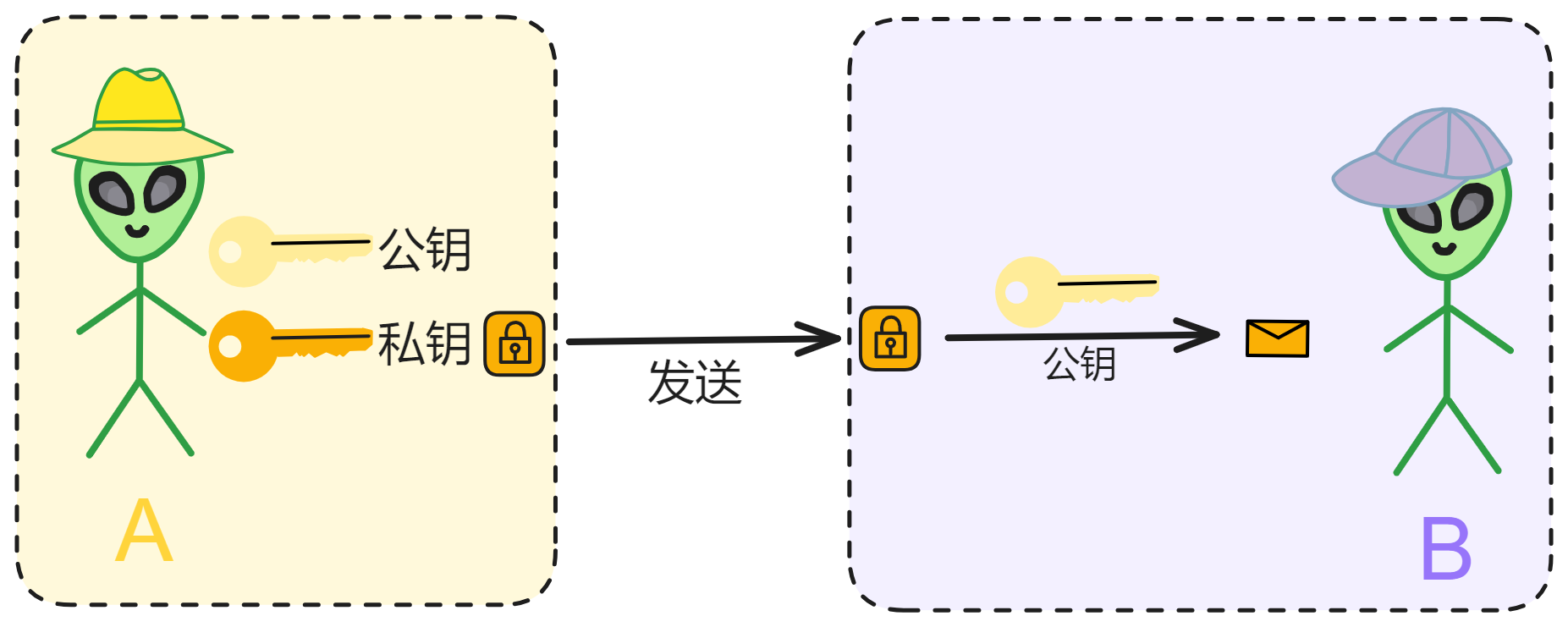

ii 是一种身份认证机制,底层原理还是私钥、公钥那些的。

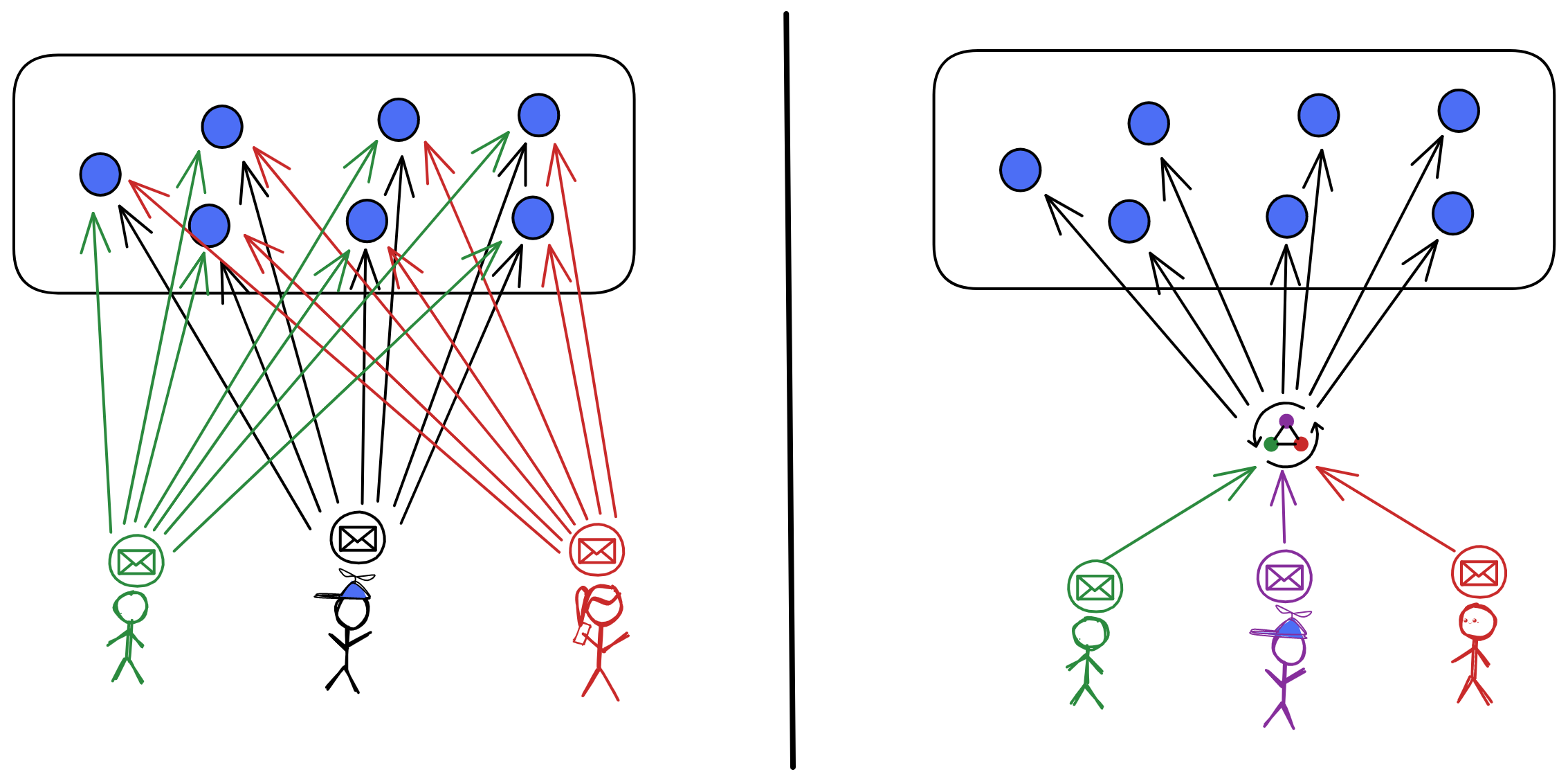

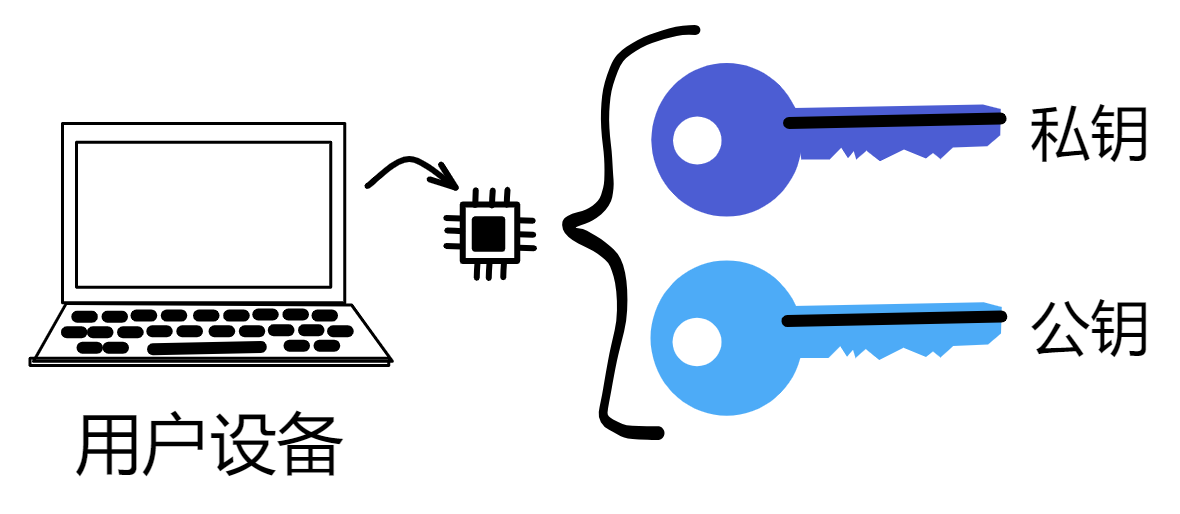

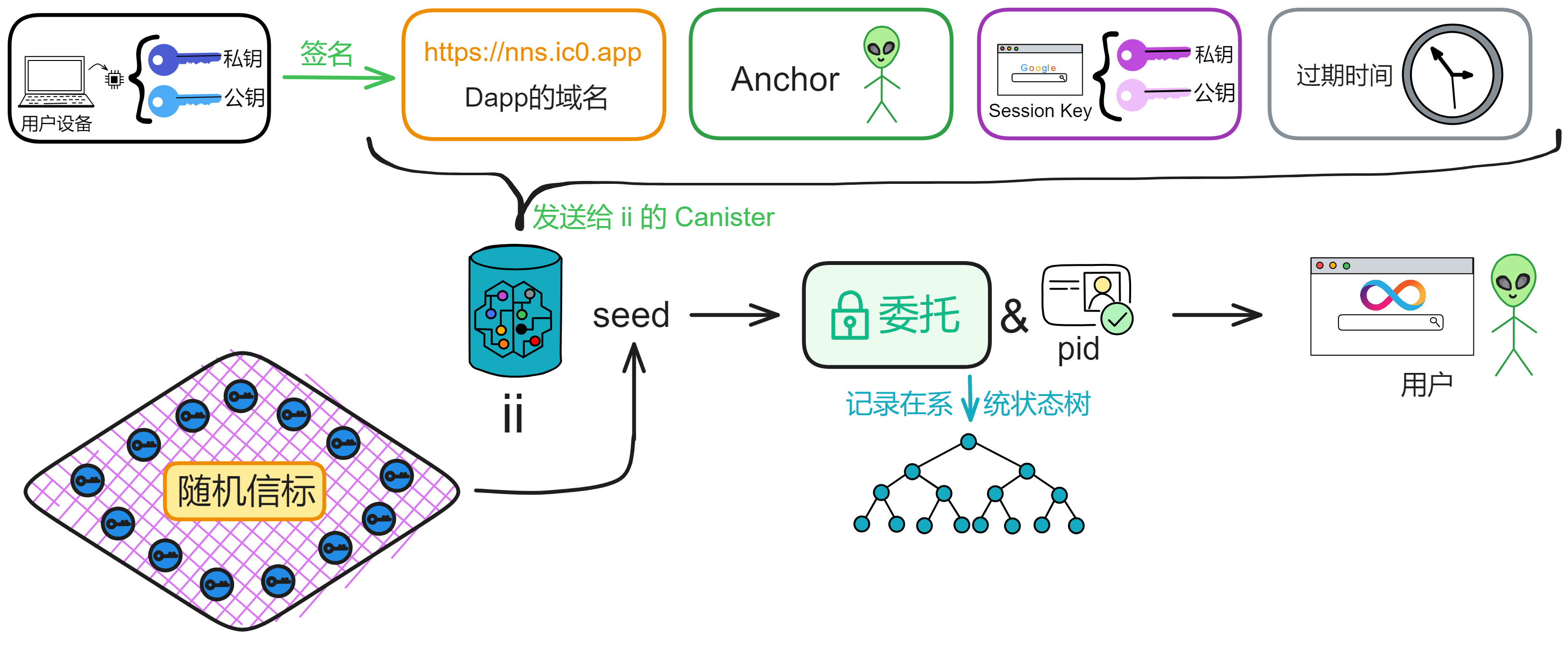

用户的手机、电脑里有一个 TPM 安全芯片,可以生成一对密钥。公钥上传到 ii 的 Canister 里存储下来;私钥由设备的 TPM 芯片生成并保存,任何人都拿不到(包括用户本人)。

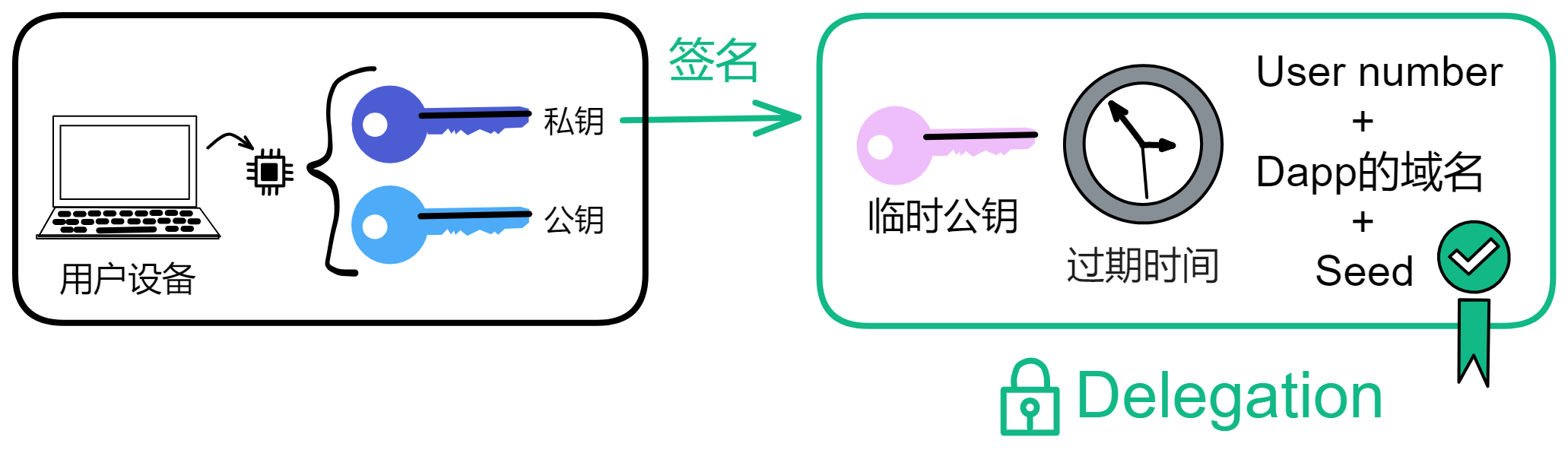

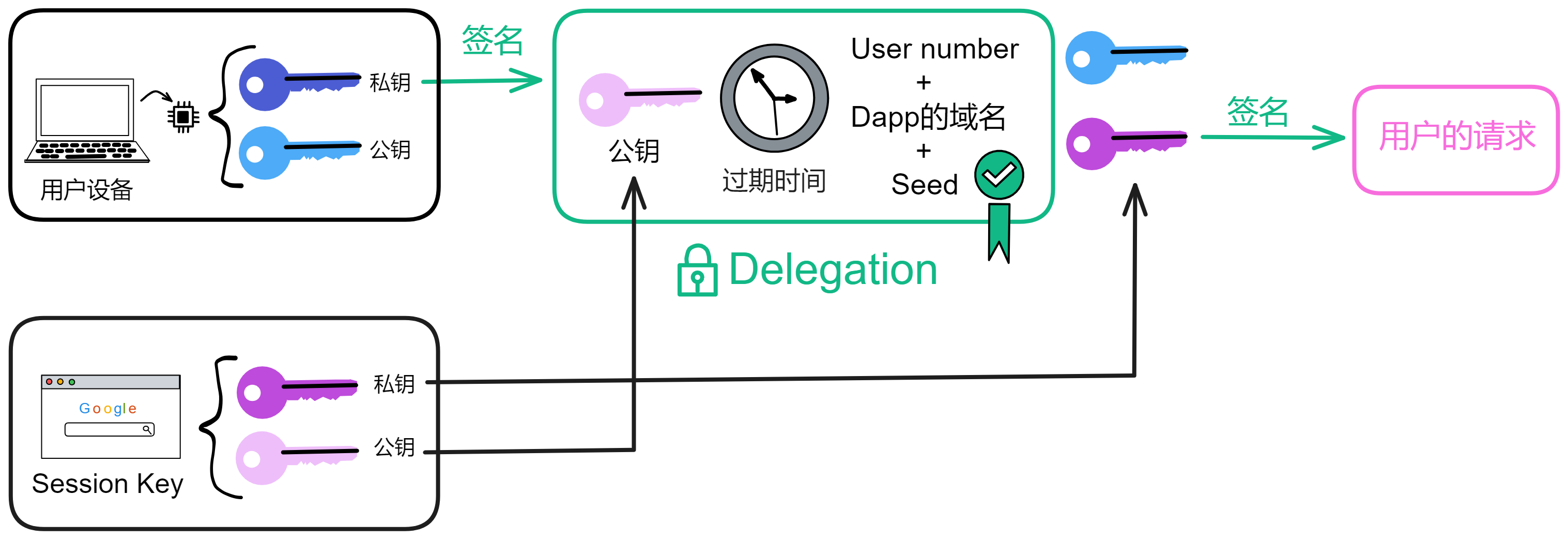

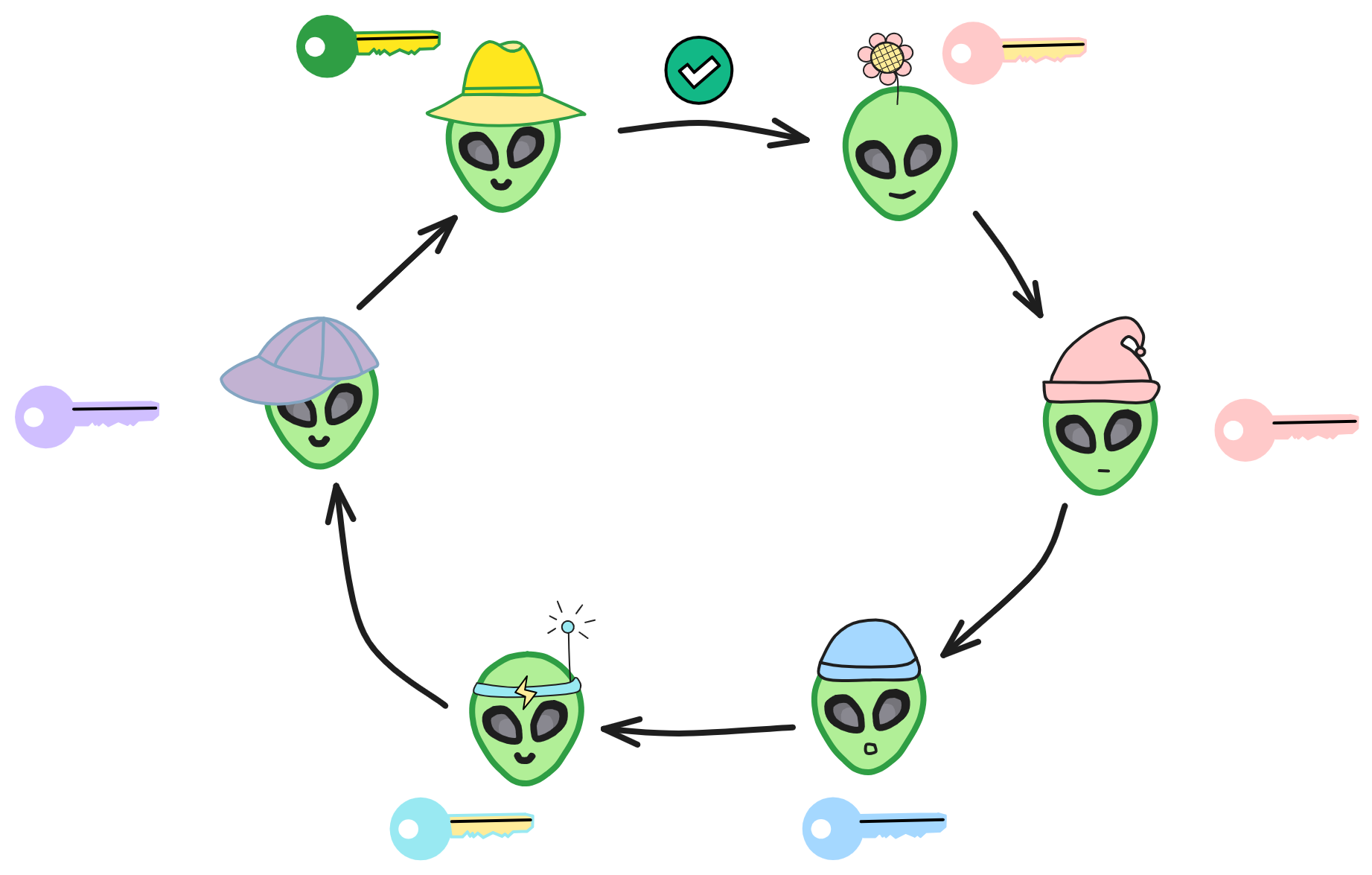

在 IC 上用户与 DApp 每次交互都需要签名鉴权,而且私钥存在安全芯片里,当然不能让用户每次交互发一个请求都用指纹签名。所以 ii 使用了委托密钥(Delegation key)形成一条委托密钥链。给委托密钥设置过期时间,然后用委托密钥的私钥做签名。

那这个委托密钥到底是啥意思呢?

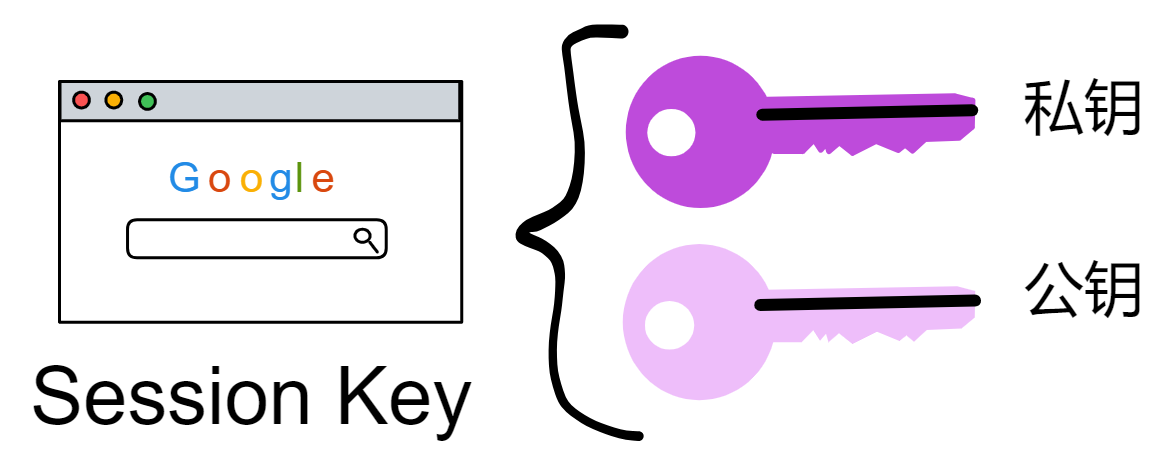

你看,设备安全芯片生成一对密钥,再让浏览器生成一对密钥(Session key)。让安全芯片生成的私钥对浏览器生成的公钥和过期时间等信息签名。生成的这个签名就是委托(Delegation)。有了这个委托,就可以用浏览器的私钥对请求签名了。然后把委托、浅蓝色的公钥、Session key 私钥签名的内容、浅粉色的公钥发出去。

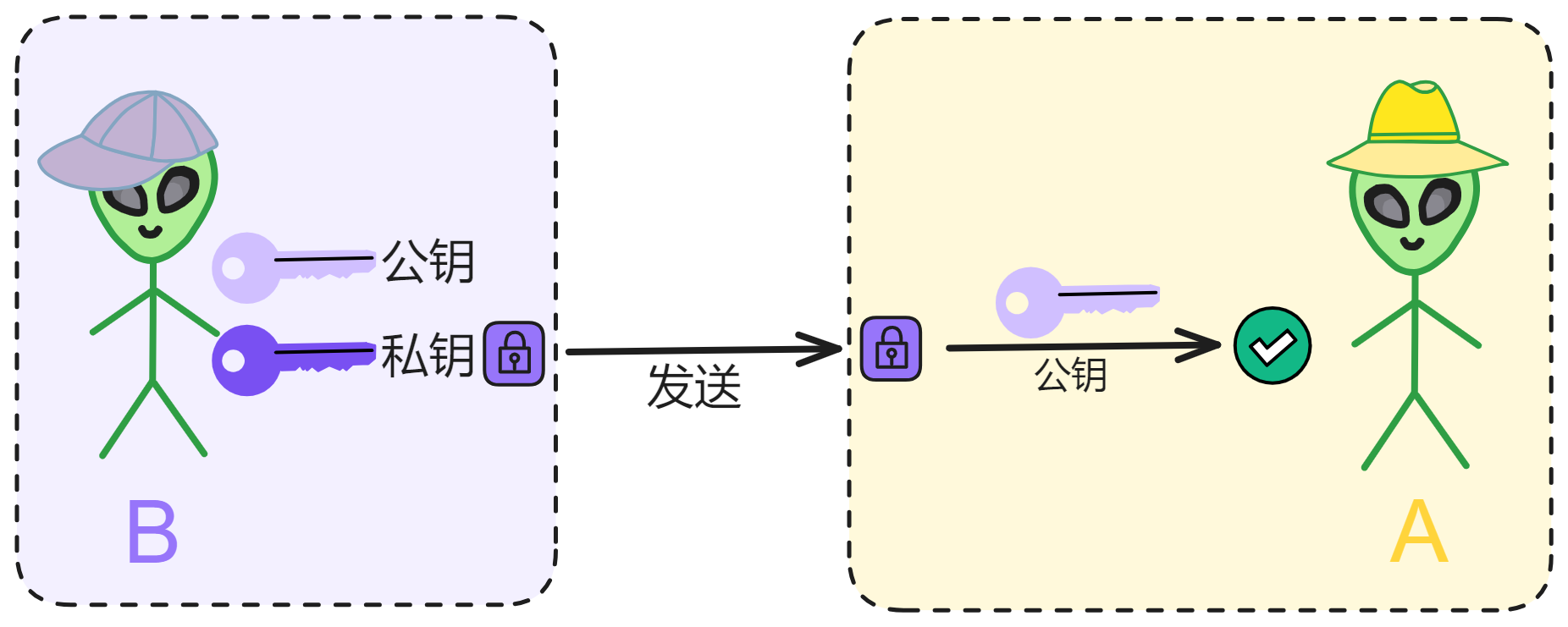

如上图所示。接收方拿到蓝色公钥、委托、粉色私钥签名过的内容、粉色公钥。用蓝色公钥解锁委托,发现里面有粉色公钥,说明蓝色私钥对粉色公钥签过名。也就是蓝色私钥授过权,就像大将军拿着皇上的虎符调兵遣将一样,虎符代表皇帝授权。

为了方便理解,上面这张图做了简化,实际上 DApp 看不到用户的 User number ,User number 和 DApp 域名都会经过哈希,生成一个 pid(Principal id)。

因为每个 DApp 的域名不一样,所以生成的 pid 也不一样。pid 是一个 DApp 里用户的身份标识,这个以后再详细说。

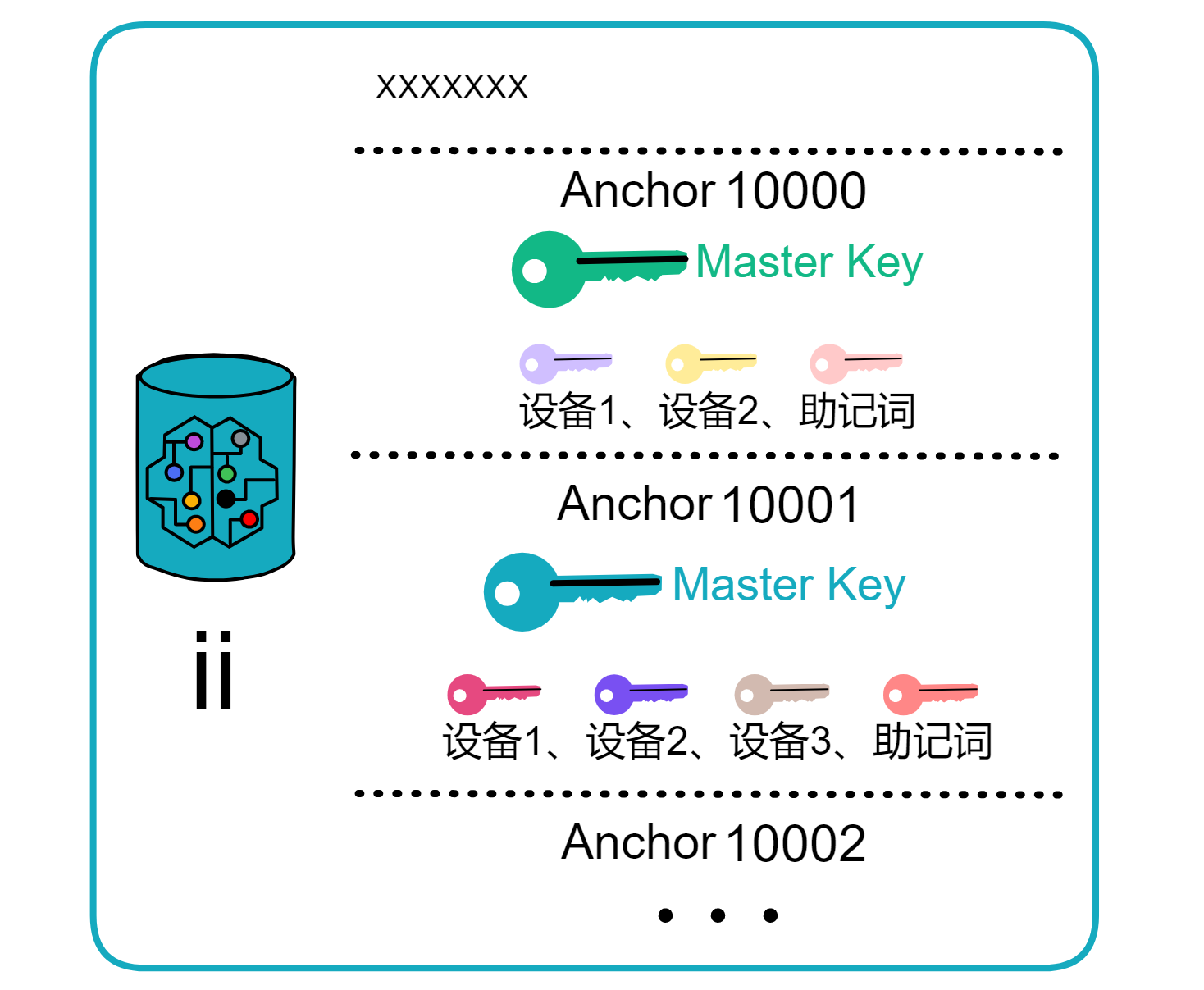

Anchor 就相当于用户名,就是上图的 User number 。用户在 ii 里保存的每个设备都是一个公钥,用户可以增加、删除设备,也就是用户可以增加删除公钥。所以假如用户手机丢了,相当于丢了一个公钥,只要用 Anchor 在其他设备上登录就可以删除手机这个设备了。

ii 干的一件事就是把用户不同的设备添加进来,通过 ii 的 Anchor 对应的 Master key 绑定,这个 Master key 是托管到 Canister 上的,这样只要有一个设备能添加进来,就能更改 ii 里保存的设备,用户就不用接触私钥了。这个 Master key 可以理解为一个总的私钥,只要有设备绑定在这个总私钥上,就不用担心 ii 身份丢失,如果所有设备都丢了,就只能靠助记词恢复了。助记词也丢了就没得恢复了,都丢了 😝 。

所以 ii 就是一种身份认证机制,ii 里没有保存用户信息,只有用户的一个 ii 身份,用户相关信息都是由 DApp 自己保存的。

Canister 里存的是 Anchor 和对应的 Master key ,Anchor 是从 10000 开始递增的。

这使得 ii 有了以下两点特性:

-

当一个 Anchor 登录不同 DApp 时,身份是不一样的。至于这个身份对应的用户信息是什么:用户名之类的,ii 不保存。

-

在一个 Anchor 不同的设备上登录 DApp ,身份是一样的。

在这里可以看到更多关于 ii 的内容。

ICP的经济模型

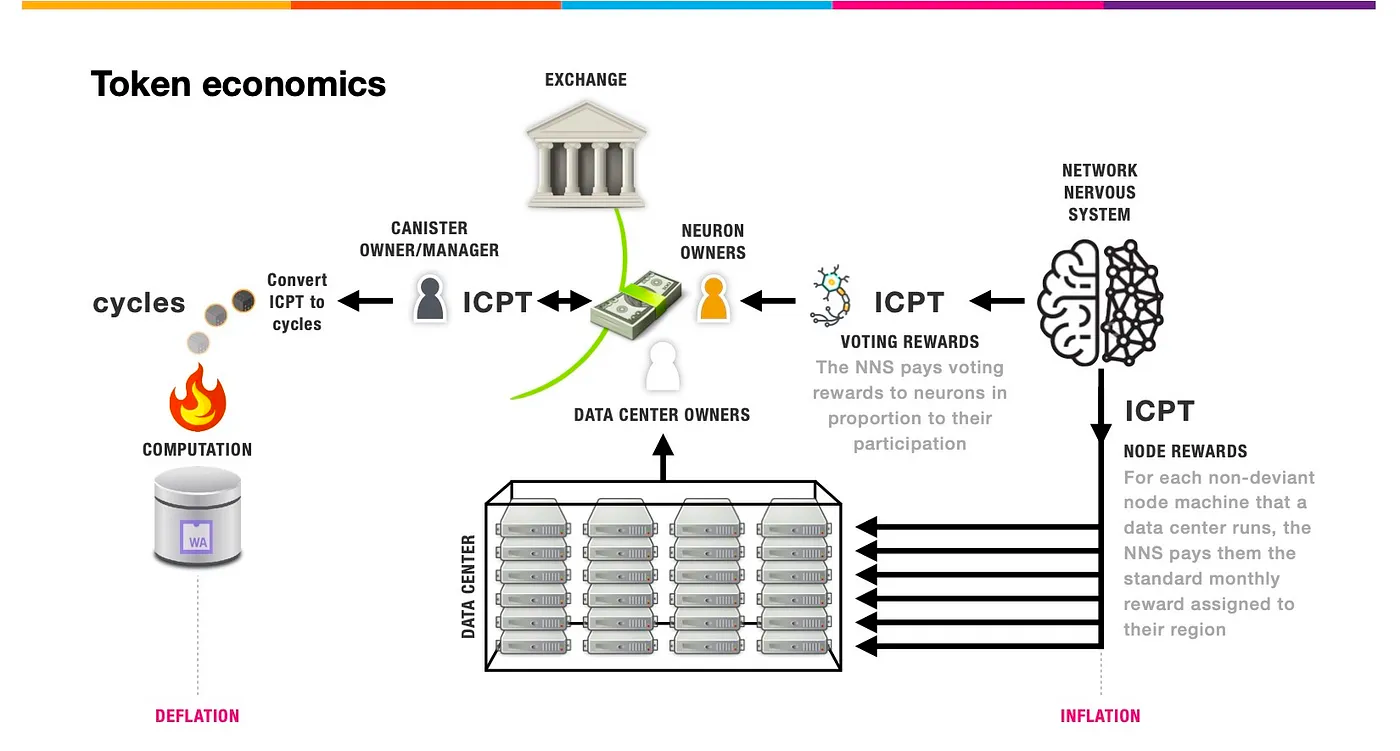

IC 网络通过 Network Nervous System(NNS ,网络神经系统)治理,治理代币叫 ICP 。另外还有一个代币叫 Cycles ,Cycles 用于支付在 IC 网络上 Canister 的存储数据、收发数据、计算费用,类似于以太坊的 Gas 费。

Cycles 是用来供 Canister (智能合约)运行的费用。 ICP 只能单向燃烧成 Cycles ,没法再变回 ICP ,ICP 与 Cycles 的汇率根据 ICP 价格动态调整,永远保持稳定的兑换一定数量的 Cycles ,以保证 Cycles 价格相对稳定,防止造成 Gas 费用大幅波动的情况。;这样 ICP 就会越来越少,随着 IC 网络使用者不断增加,更多的人会购买 ICP 来运行智能合约, IC 网络的价值也会不断增加。

数据中心想成为节点需要根据节点提供商机器硬件指南配置设备,完成节点提供商自我声明,然后需要至少10 ICP质押为至少为6个月的神经元以在NNS发起提案,提案通过后就可以成为节点。NNS会在每月15日向节点提供商发放奖励,奖励锚定XDR的价格,但以ICP的形式发放,也就是说ICP价格越低,节点奖励获得的ICP数量越多。如果节点作恶,节点运营实体会面临被起诉、扣发节点奖励等惩罚。

当 IC 上的生态越来越繁荣,越来越多的企业、组织在 IC 上部署去中心化应用 DApp 时,就需要把 ICP 燃烧成 Cycles 交部署应用的费用。

持有 ICP 的用户可以把 ICP 质押在 NNS 中,创建 Neuron(神经元),然后进行投票,投票之后会收到 ICP 奖励,这是 ICP 的通胀机制之一;但 NNS 的作用是投票治理,并不是赚利息。

另外,NNS 会给数据中心提供者每个月发送 ICP 代币激励,这种另一种通胀机制。

在那些数据中心的 Canister 里消耗的 Cycles 和这个数据中心获得的 ICP 的数量是动态平衡的。激励多少 ICP 是根据数据中心对 IC 网络做出的贡献决定的,在数据中心部署的 Canister 越多提供算力、储存数据就越多,激励的 ICP 也多。

加密资产用户在使用以太坊智能合约进行签名、转账、交易的过程中都需要向网络支付一笔 Gas 费,而 Gas 费会随着网络拥堵导致上涨。尤其是在 DeFi 行情火爆时,高昂的 Gas 费成为了阻挡广大普通用户参与的门槛。

区块链奇点

由于跨链桥的存在,跨链存在本质的 51% 攻击安全问题。

但是 IC 解决了跨链桥问题,IC 直接抛弃了跨链桥。IC 本身就是一个云服务,IC 可以直接集成其他链。

目前 IC 已经集成了比特币和以太坊。Canister 可以直接接收、持有、发送比特币。Canister 可以做阈值 ECDSA 签名。这项技术使 Canister 可以控制 ECDSA 私钥片段,私钥片段分布在比特币子网的副本中,用法和 BLS 阈值签名差不多。这样一来,跨链不再需要桥,也不用把资产包装,比如 BTC 包装成 WBTC 。

开发者只需要在 Canister 中编写业务逻辑,就可以实现比特币的 DeFi,比如交易和借贷,而且速度很快,只需要几秒钟,成本很低。

所以说了这么多,IC 能干什么不用我多说什么了吧 😏 。下面内容来自 IC 白皮书:

IC 设计上是一个完整的技术栈,可以构建完全在 IC 上运行的系统和服务。特别的是,IC 上的智能合约可以处理终端用户的 HTTP 请求,因此智能合约可以直接提供交互式的网络体验。这意味着,构建系统和服务不需要依赖于公司的云托管服务或者私人服务器,从而以一种真正的端到端的方式提供智能合约的所有优势。

对于终端用户而言,访问基于 IC 的服务在很大程度上是透明的。他们的个人数据比在访问公有云或私有云的应用时更安全,但是与应用程序的交互体验是一样的。

然而,对于创建和管理基于 IC 的服务的人来说,IC 消除了许多在开发和部署当前的应用程序和微服务时的成本、风险和复杂性。例如,在当前垄断互联网的科技巨头们所推动的整合下,IC 平台提供了另一种选择。此外,IC 安全的协议可以确保消息的可靠传递、透明可追溯,以及不需要依赖于防火墙、备份设施、负载均衡服务器和故障编排就可以实现的网络弹性。

多米尼克 2021 年 1 月 6 号在博客上很激动:

水星(阶段)代表惊人的技术成就,以及与众不同的区块链愿景的实现,但即使在这个阶段,网络也无法在大量独立各方的努力下建立。在幕后,尽管 COVID-19 疫情造成了困难,几家制造商一直在制造用于创建物理网络的第一代标准化互联网计算机节点机器,数十个独立的融资合作伙伴也提供资金和控制节点机器部署到第一批数据中心。正如我所写,数百台新的节点机器已被部署到数据中心,这需要付出巨大努力,许多机器已经在运行,可以让网络神经系统将它们编织进网络,以扩展互联网计算机的容量 —— 世界上第一个能无限扩展容量、以 Web 速度运行的公共区块链,这将很快产生巨大影响,未来数年内,该网络预计将扩展到数百万个节点,运行在成千上万个数据中心。我们预期历史将证明这是一个区块链和互联网双方的重要时刻。

“ 区块链奇点将会出现,因为智能合约实际上是一种全新形式的软件系统,它比传统 IT 具有巨大的优势。这意味着在线系统和服务的未来是区块链,您可以成为其中的一部分。”

这是本片文章的结构:了解 IC 的每个部分都可以对应到后面的章节。

继续深入了解 IC 的 4 层核心协议。

TL;DR

注:本文为作者个人在现阶段的观点,一些思考可能存在事实上的错误和观点上的偏见,仅作为交流之用,期待来自其他同学的指正。

- BTC 提出电子现金,开辟区块链行业从 0 到 1

- ETH 提出智能合约,率领区块链行业从 1 到 100

- ICP 提出 Chainkey 技术,驱动区块链行业可以从 100 到 100,000,000

Introduction

2009 年 1 月 3 日,BTC 第一个区块被挖出,自此区块链激荡发展 14 年。

纵观过去 14 年,BTC 的精妙与伟大,Ethereum 的横空出世,EOS 的激情众筹,PoS&PoW 的宿命之争,Polkdadot 的万链互连,一项项惊为天人的技术,一个个美妙绝伦的故事,让无数圈内人竞折腰!

当前,2023 年,整个区块链的格局是怎样?以下是我的思考,详见此文中的公链格局解读部分

- BTC 凭借着引入电子现金的正统性,屹立不倒,是行业的巨石

- ETH 凭借着引入智能合约的可编程性,L2 生态的可组合性,百花齐放,是行业的领导者

- Cosmos,Polkadot 等凭借着跨链互操作性,试图一统天下

- 各类以太坊杀手层出不穷,小领域内各领风骚

但未来 10 年,整个区块链行业会如何发展?以下是我的思考

- 主权是区块链唯一需要解决的一个问题,包括资产主权,数据主权,言论主权等,否则没必要有区块链这个东西;

- 不可篡改性是充分条件,但不是必要条件,只要你能保证我的主权不受损害,我随便你篡改,世界上每个人的资产都被篡改同比例翻倍,有什么区别?

- 完全的去中心化不可能做到,不管怎么设计,总有“天赋”异禀者/既得利益者占据更大话语权,也总有人会主动选择不参与,【去中心化的多点中心化】是最终格局;

- 透明化是必须,这场全人类的社会实验不就是为了让每个人都说得上话,都能有权利保护自己的主权吗?虽然总有人懒,总有人愿意相信更专业的人,总有人为了效率最大化主动选择放弃投票,但是,这也是他们主动做出的选择,他们有权利但主动选择不行使。只要一切是透明的,没有暗箱操作,死个明白我也愿意接受,输了是我技不如人,优胜劣汰,这也符合市场经济;

- 去中心化代码执行的控制权才是核心,否则就是脱裤子放屁,投票公示一周,最后项目方还是部署了作恶版本的代码,哪怕不是作恶版本,也是在戏弄大家。可以说现在半个世界都是代码组成的,去中心化的实体不包括代码执行的控制权,那人们包括政府怎么敢让区块链行业做大?

- 线性成本的无限扩展性,随着区块链与现实生活结合得越来越紧密,参与的人越来越多,需求越来越大,基础设施上无法支持无限的扩展性,或者扩展起来太贵,都是不可接受的。

Why ICP

这里先引入一个故事,2009 年阿里巴巴提出 “去 IOE” 战略,这也是后来成就阿里 “双十一” 的一大里程碑。

去 IOE

“去 IOE” 战略的核心内容就是要去除 IBM 小型机、Oracle 数据库及 EMC 存储设备,将 “云计算” 的本质植入阿里的 IT 基因。其中

- I 指 IBM p 系列小型机,操作系统是 AIX(IBM 专有的 Unix 系统);

- O 指 Oracle 数据库(RDBMS);

- E 指 EMC 中高端 SAN 存储。

去 IOE 的原因主要有以下三点,但第一点是本质原因,后两者更间接:

- 无法满足需求,传统 IOE 系统难以适应互联网企业高并发需求,无法支持大规模分布式计算架构;

- 成本太高,维护 IOE 成本太高,比如 IBM 小机 50 万,Oracle 年保数十万等;

- 依赖性太强,IOE 系统依赖性太强,被 IBM 和 Oracle 等厂商 “绑架”,难以根据自身需求进行灵活配置。

那为什么是 2009 年提出 “去 IOE” 战略而不是更早呢?

- 在此之前,

- 阿里业务规模和数据量还没有达到使传统 IOE 系统难以适应的程度,因此去 IOE 的需求不急;

- 国内数据库产品在技术和质量上还不够成熟,无法很好替代 IOE 作用;

- 互联网思想和云计算概念在国内还未普及,分布式架构未成流行方向;

- 管理层和技术人员可能需要一段时间的实践积累,才意识到存在的问题和必须采取的措施。

- 2009 年,

- 阿里快速扩张业务,IOE 系统难支持规模,成本更易显现出问题;

- 一些开源数据库产品如 MySQL 成熟程度较高,可以作为替代品;

- 互联网思想和云计算在国内开始广泛流传、应用,更便于推广 "去 IOE" 概念;

- 前微软技术大牛,王坚,带着全球性的技术视角在 08 年加入阿里,深受马云信任,提出了 "去 IOE"。

但是 “去 IOE” 不是简单地改变软件和硬件本身,用新的软硬件取代旧的软硬件,而是用新的方式取代旧的方式,是用云计算彻底改变 IT 基础架构。换句话说,这是行业的变化导致的,而不是仅仅是简单的技术升级。

企业发展三大阶段

一个企业的发展可以分为 3 个阶段,

- 塑造基因,组织文化,Start-up,从 0 到 1

- 快速成长,小步快跑,Scale-up,从 1 到 100

- 无限扩展,拓宽边界,Scale-out,从 100 到 100,000,000

下面把整个区块链行业当成是一个企业来分析

Start-up / 区块链 1.0 / BTC

比特币的创新之处在于它解决了数十年来困扰计算机科学家的一个问题,即如何创建一个可以在无需信任任何中央机构的情况下运行的数字支付系统。

但 BTC 在其设计和开发中,也确实存在一些局限性,这些局限性为以太坊(ETH)等后续的区块链项目提供了市场机会。以下是一些主要的局限性:

- 交易吞吐量和速度:比特币的区块生成时间约为 10 分钟,且每个区块的大小限制导致了其交易处理能力的上限。这意味着在网络繁忙时,交易确认可能需要较长时间,且可能需要支付较高的交易费用。

- 智能合约功能有限:比特币的设计主要是作为一种数字货币,它支持的交易类型和脚本语言功能相对有限。这限制了比特币在复杂的金融交易和去中心化应用(DApps)方面的应用。

- 不易升级和改进:由于比特币的去中心化和保守的设计原则,对其进行大的升级和改进通常需要社区的广泛共识,在实践中很难达成,这也使得比特币的进步相对缓慢。

- 能耗问题:比特币的共识机制是基于工作量证明(PoW)的,这意味着大量的计算资源被用于矿工之间的竞争,导致了大量的能耗。这在环保和可持续性方面受到了人们的批评。关于这一点,大家也可以关注一下 EcoPoW,算是部分缓解了这个局限性。

Scale-up / 区块链 2.0 / ETH

当前以太坊的 Layer 2 扩容形式可以看作是一种 “纵向扩展”,依赖于底层 Layer 1 的安全性和数据可用性保证。虽然看似是 2 层结构,但是最后还是会被 Layer 1 的处理能力所限制,即使换成多层结构,即打造 Layer 3,Layer 4,无非也只是增加整个系统的复杂性,拖延一点时间而已。更何况根据边际递减效应,后面每多加一层,多出来的 overhead 就会导致扩容效果大打折扣。这种纵向分层的方式可以看作是单机硬件升级,只不过这个单机指的是整个 ETH 生态。

且随着使用量增加,用户对低廉费用和高性能需求也会增加。而 Layer 2 作为 Layer 1 上的一个应用,其费用只能降低到一定程度,最终仍受制于 Layer 1 的基础费用和吞吐量。这类似经济学中的需求曲线理论 - 随着价格下降,总需求量会增加。纵向扩展很难从根本上解决可扩展性问题。

以太坊是一棵参天巨树,所有的人都依靠着那个根,一旦那个根汲取养分的速度跟不上,人们的需求也就得不到满足;

因此,只有横向扩展才是更容易拥有无限性的。

有人认为多链跨链也算是一种横向扩展方式,

- 拿 Polkadot 来举例子,它是异构王国,每一个国家长得不一样,但每做一个东西就要建一个王国;

- Cosmos 是同构王国,每个国家的经脉骨骼长得一样,但也是每做一个东西就要建立一个王国;

但从 Infra 角度来看,以上这两者的模式略显奇怪,每多做一个应用就要多建立一整个王国?我们举个例子来看看有多奇怪,

- 3 个月前我买了一台 Mac,在它上面开发了一个 Gmail 应用;

- 现在我想开发一个 Youtube 应用,但我必须要重新买一台 Mac 来开发,这太奇怪了。

且以上这两种方式都面临新增链时跨链通信复杂度高的问题,因此它们并不是我的首选。

Scale-out / 区块链 3.0 / ICP

想要 scale-out,需要一整套底层的基础设施,支持快速地横向扩展,不用重复造轮子。

一个比较典型的支持 scale-out 的例子就是云计算,【VPC+子网+网络ACL+安全组】这些底层模版大家都一模一样,所有的机器都带着编号和类型,上层的 RDS,MQ 等核心组件支持无限扩展,如果需要更多的资源,点击一个按钮就可以快速启动。

之前有一位 Leader 给我分享过,如果你想了解互联网企业需要哪些基础设施和组件,那你只需要去 AWS 看一下他们提供的所有服务就行了,那是最全最强的组合。

同理,我们来 high-level 看看 ICP,看看为什么它满足 Scale-out 的要求。

这里先说明几个概念,

- Dfinity Foundation:是一个非营利性组织,致力于推动去中心化计算机技术的发展和应用。它是 Internet Computer 协议的开发者和维护者,旨在通过创新的技术和开放的生态系统,实现去中心化应用的全面发展。

- Internet Computer (IC):是 Dfinity Foundation 开发的一种高速区块链网络,专门为去中心化应用设计。它采用了一种新的共识算法,可以实现高吞吐量和低延迟的交易处理,同时支持智能合约和去中心化应用的开发和部署。

- Internet Computer Protocol (ICP):是 Internet Computer 协议中的原生代币,它是一种数字货币,用于支付网络使用费用和奖励节点。

What’s ICP

以下许多内容会有一些些硬核,但是我已经进行了大白话描述,希望大家都可以跟得上。如果有更多细节内容希望与我讨论,可以在文章最上方找到我的联系方式。

架构概述 / Architecture Overview

- 从分层结构看,从下至上分别为

- P2P 层,收集和发送来自用户、子网中的其他副本和其他子网的消息。保障消息能传递到到子网中的所有节点,以确保安全性、可靠性和弹性。

- 共识层:主要任务是对 input 进行排序,以确保同一子网内部的所有节点以相同的顺序处理任务。为了实现这一目标,共识层使用了一种新的共识协议,该协议旨在保证安全性和活性,并具有抗 DOS / SPAM 攻击的能力。同一子网内部对处理各种消息的顺序达成共识后,这些区块会被传递到消息路由层。

- 消息路由层:根据共识层传来的任务,准备好各 Canister 的输入队列。执行完毕后,它还负责接收 Canister 产生的输出,并按需转发给本地或其他区的 Canister。此外,它还负责记录和验证用户请求的响应。

- 执行层,为 Canister 提供运行时环境,按照调度机制有序读取输入,调用相应Canister 完成任务,并将更新后的状态和产生的输出返回给消息路由层。它利用随机数带来的非确定性,以保证计算的公平性和可审计性。因为在某些情况下,Canister 的行为需要是不可预测的。例如,在进行加密操作时,需要使用随机数来增加加密的安全性。此外,Canister 的执行结果需要具有随机性,以避免攻击者通过分析 Canister 的执行结果来发现漏洞或者预测 Canister 的行为。

4-layers of ICP

关键组件 / Key Components

- 从组成成分看,

- 子网(Subnet):支持无限扩展,每一个子网就是一个小型区块链。Subnet 之间通过 Chain Key 技术通信,因为已经在子网内部达成共识了,所以只要通过 Chain Key 验证就行了。

- 副本(Replica):每一个 Subnet 中可以有很多个节点,每一个节点都是一个 Replica,IC 的共识机制会保证同一个 Subnet 中的每一个 Replica 都会以相同的顺序去处理相同的 input,使得每一个 Replica 的最终状态都是相同的,这种机制被称为 Replicated State Machine,

- 罐子(Canister):Canister 是一种智能合约,它是一种运行在 ICP 网络上的计算单元,可以存储数据和代码,并且可以与其他 Canister 或者外部用户进行通信。ICP 提供了一个运行时环境,用于在 Canister 中执行 Wasm 程序,并通过消息传递与其他 Canister 和外部用户进行通信。可以简单地认为就是跑代码用的一个 docker,然后你自己注入 Wasm Code Image 在里面运行。

- 节点(Node):独立的服务器,Canister 还是需要有一个实体机器来跑的,这些实体机器就是真实的机房里面的机器了。

- 数据中心(Data Center):数据中心的节点通过节点软件 IC-OS 虚拟化为一个副本(Replica),从多个数据中心中随机选取一些 Replica 组成一个子网(Subnet)。这样可以保证即使一个数据中心被黑了或者是遭遇天灾了,整个 ICP 网络还是正常运行的,有点像阿里巴巴 “两地三中心” 容灾高可用方案的升级版。数据中心可以分布在全世界各地,甚至以后可以在火星搭建一个数据中心。

- 边界节点(Boundary Nodes):提供外部网络和 IC 子网之间的入口和出口,验证响应。

- 身份主体(Principal):外部用户的标识符,由公钥派生,用于权限控制。

- 网络神经系统(NNS):使用抵押 ICP 进行治理的算法 DAO,用于管理 IC。

- 注册表(Registry):由 NNS 维护的数据库,包含实体(如 Replica、canister、Subnet)之间的映射关系,跟现在的 DNS 工作原理有点像。

- Cycles:本地代币,代表用于支付 canister 运行时消耗的资源的 CPU 配额。非要用中文表示的话,我会用 “计算周期” 这个词,因为 cycles 主要是指用于支付计算资源的单位。

关键创新技术 / Key Innovative Technologies

- 从底层来看,采用了 Chain-key 技术,其中

- Threshold BLS signatures:ICP 实现了阈值签名方案,对于每一个 Subnet,有一个公共的可验证的公钥,而它对应的私钥却是拆分成多份 share 的,每一份 share 由这个 Subnet 中的一个 Replica 去持有,只有同一个 Subnet 中超过阈值数量的 Replica 对消息签名了才被认为是有效。这样 Subnet 之间,Replica 之间传递的消息都是加密但可快速验证的,既保证了隐私性,又保证了安全性。其中 BLS 算法就是比较著名的一种阈值签名算法,它是唯一能产生非常简单且高效的阈值签名协议的签名方案,且签名是唯一的,这意味着对于给定的公钥和消息,只有一个有效的签名。

- Non-interactive Distributed Key Generation (NIDKG):为了安全地部署阈值签名方案,Dfinity 设计、分析并实现了一种新的 DKG 协议,该协议在异步网络上运行且具有很高的健壮性(即使子网中多达三分之一的节点崩溃或损坏,它仍然可以成功),同时仍然能够提供可接受的性能。除了生成新密钥外,此协议还可用于重新共享现有密钥。此功能对于实现 IC 拓扑的自主演进至关重要,因为子网随着时间推移会发生成员变化。

- Publicly Verifiable Secret Sharing scheme (PVSS Scheme):即公开可验证秘密共享方案。在 Internet Computer 协议的白皮书中,PVSS scheme 被用于实现去中心化密钥生成(DKG)协议,以确保节点的私钥在生成过程中不会被泄露。

- 前向安全公钥加密方案(forward-secure public-key encryption scheme):前向安全公钥加密方案可以确保即使私钥被泄露,以前的消息也不会被解密,从而提高了系统的安全性。

- Key resharing protocol:一种基于阈值签名的密钥共享方案,用于在 Internet Computer 协议中实现密钥管理。该协议的主要优点是它可以在不创建新的密钥的情况下,将现有的密钥共享给新的节点,从而减少了密钥管理的复杂性。此外,该协议还使用阈值签名来保护密钥共享的安全性,从而提高了系统的安全性和容错性。

- PoUW:PoUW 比 PoW 多了一个 U,它代表 Userful,主要是提高了不少性能,让节点机器少做无用功。PoUW 不会人为制造困难的哈希计算,它将算力尽可能的放在为用户服务上。大部分资源(CPU、内存)用于实际 canister 中代码的执行上。

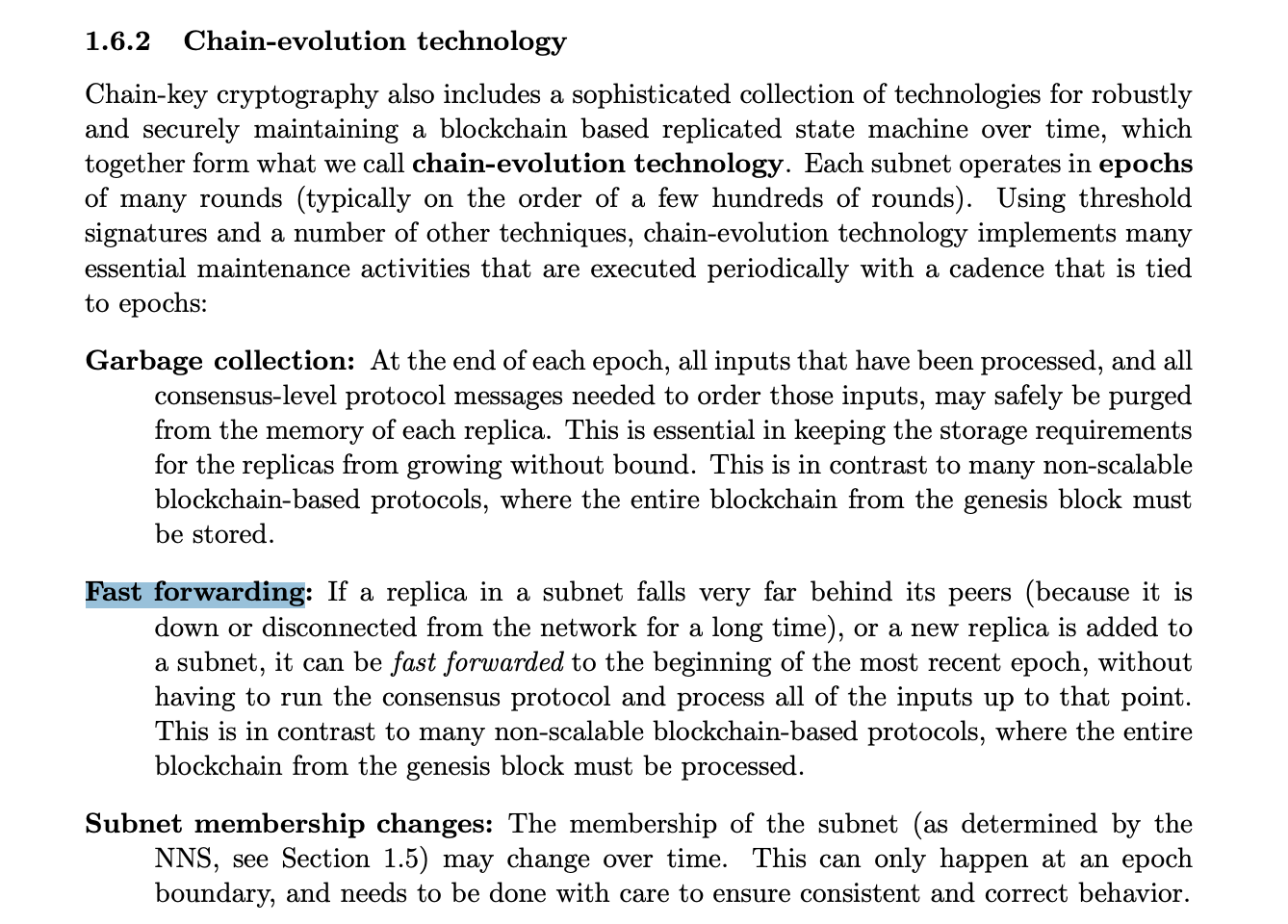

- Chain-evolution technology:是一种用于维护区块链状态机的技术,它包括了一系列的技术手段,可以确保区块链的安全性和可靠性。在 Internet Computer 协议中,Chain-evolution technology 主要包括以下两个核心技术:

- Summary blocks:每个 epoch 的第一个区块是一个 summary block,它包含了一些特殊的数据,用于管理不同的阈值签名方案。其中,一个低阈值方案用于生成随机数,而一个高阈值方案用于认证子网的复制状态。

- Catch-up packages (CUPs):CUPs是一种用于快速同步节点状态的技术,它可以让新加入的节点快速地获取到当前状态,而不需要重新运行共识协议。

我对整个 IC 底层技术的逻辑性推导为:

- 在传统的公钥密码学中,每个节点都有自己的公私钥对,这意味着如果一个节点的私钥被泄露或被攻击,那么整个系统的安全性都会受到威胁。而阈值签名方案将一个密钥分成多个部分,分配给不同的节点,只有当足够数量的节点合作才能生成签名,这样即使某些节点被攻击或泄露,也不会对整个系统的安全性造成太大影响。此外,阈值签名方案还可以提高系统的去中心化程度,因为它不需要一个中心化的机构来管理密钥,而是将密钥分散到多个节点中,这样可以避免单点故障和中心化风险。因此,IC 使用阈值签名方案来提高系统的安全性和去中心化程度,希望用阈值签名的方式来完成一个安全性高,可扩展,可快速验证的通用区块链。

- 而 BLS 就是一种著名的阈值签名算法,它是唯一能产生非常简单且高效的阈值签名协议的签名方案。且 BLS 签名还有一个优点就是不需要保存签名状态,只要消息内容不变,签名就是固定的,这意味着对于给定的公钥和消息,只有一个有效的签名。这都保证了极高的扩展性,因此 ICP 选择了 BLS 方案。

- 因为用了阈值签名,所以需要有一个分发者来分发密钥片段给不同的参与者,但是这个分发密钥片段的人就是一个单点,容易导致单点故障问题,因此 Dfinity 设计了一种分布式的密钥分发技术,也就是 NIDKG,在子网创建的初始化时期,所有参与的 Replica 共同非交互式地生成一个公钥 A,对于对应的私钥 B,每个参与者通过数学方式分别算出和持有其中的一个衍生计算出来的 secret share。

- 要想做 NIDKG,就得保证分布式的每一个参与方都没有作假,因此每个参与者不仅可以得到自己的 secret share,还可以公开让别人验证自己的 secret share 是否正确,这是实现分布式密钥生成的一个非常重要的点。

- 那如果万一某个历史时刻的子网密钥被泄漏了呢?怎么保证历史数据的不可篡改性呢?Dfinity 采用了一种前向安全的签名方案,这保证了即使某个历史时刻的子网密钥被泄露,攻击者也无法更改历史区块的数据,这样也防止了后期腐败攻击对区块链历史数据的威胁。如果这个限制更强一些,其实也可以保证信息在传输时不会被窃听成功,因为时间戳对不上,即使短时间内密钥被破解了,也无法破解过去的通信内容。

- 有了 NIDKG 之后,如果某一段 secret share 长期被一个节点持有,一旦各个节点逐渐被黑客侵蚀,整个网络有可能会出现问题。因此需要不停地进行密钥更新,但是密钥更新也不能要求所有参与者 Replica 必须齐聚一堂交互通信,而是也必须非交互式地进行。但是因为公钥 A 已经在 NNS 里面注册好了,别的子网也都会用这个公钥 A 来进行验证,因此子网公钥最好不要变。可是子网公钥如果不变的话,节点间的 secret share 怎么更新呢?因此 Dfinity 设计了一种 Key resharing protocol,在不创建新公钥的前提下,所有持有当前版本 secret share 的 Replica 非交互式地生成新一轮的衍生 secret share 给到新版本的 secret share 持有者,这样

- 既保证了新版本的 secret share 是经过当前所有合法 secret share 持有者的认证的

- 也保证了旧版本的 secret share 不再合法

- 还保证了即使未来新版本的 secret share 泄漏了,旧版本的 secret share 也不会泄漏,因为两者之间的多项式毫不相关,是无法反推出来的。这也是前面刚刚介绍的前向安全性。

- 另外保证了高效重新随机分发,当受信任节点或访问控制发生变化时,可以随时修改访问策略和控制者,无需重新启动系统。这在许多场景下都大大简化了密钥管理机制。例如,这在子网成员变化的情况下非常有用,因为重新共享将确保任何新成员都有适当的 secret share,而任何不再是成员的副本将不再有 secret share。此外,如果在任何一个时期或甚至每个时期中泄露了少量的 secret share 给攻击者,这些 secret share 对攻击者也没有任何帮助,因为旧版本的 secret share 已经是非法的了。而只有当前的子网节点才能生成合法的当前 epoch 的签名,因此即使旧的子网节点合谋,生成的签名对现在也没有用。

- 因为传统的区块链协议需要存储从创世块开始的所有块信息,随着区块链的增长,这会导致可扩展性问题,这也是为什么很多公链想开发一个轻客户端都非常麻烦。于是 IC 想解决这个问题,因此 IC 开发了 Chain-evolution Technology,在每个 epoch 结束时,已处理的所有 input 和需要 consensus 信息都可以安全地从每个 Replica 的内存中清除,这极大地降低了每一个 Replica 的存储要求,它使得 IC 能够扩展以支持大量的用户和应用程序。此外,Chain-evolution technology 还包含 CUPs 技术,它可以让新加入的节点快速地获取到当前状态,而不需要重新运行共识协议,这大大降低了新节点加入 IC 网络的门槛和同步时间。

- 综上,IC 的所有底层技术都是一环扣一环,基于密码学(来自理论),也充分考虑了整个行业的难题如快速同步节点(来自实践)。真乃集大成者也!

特性 / Key Features

- 从特性上来看

- 反向 Gas 模型:传统的区块链系统大多要求用户先持有原生代币,例如 ETH,BTC,然后消耗原生代币来支付交易手续费。这增加了新用户的进入障碍,不符合人们的使用习惯。为什么我刷个 Tiktok 一定要先持有 Tiktok 的股票?而 ICP 采用了反向 Gas 模型设计,用户可以直接使用 ICP 网络,项目方会负责手续费,这降低了使用门槛,更契合了互联网服务的习惯,有利于获得更大规模的网络效应,从而支持更多用户的加入。

- 稳定的 Gas:对于市面上的其他公链来说,为了链的安全性,也为了转账需要,就会有人去买原生代币,矿工就去拼命地挖,或者有人拼命地屯原生代币,这样就为这条公链贡献了算力例如 Bitcoin,或者为这条公链提供了质押经济安全性例如 Ethereum。可以说我们对 btc/eth 的需求其实是来源于 Bitcoin/Ethereum 公链对于算力/质押的要求,本质上也是链的安全要求。因此,只要是直接用原生代币来付 gas 的链,以后还是会贵的,也许现在原生代币便宜,但是只要链本身生态起来了,后面都会变贵。而 ICP 不一样,ICP 区块链中消耗的 Gas 叫 Cycles,这是通过消耗 ICP 兑换而来的,Cycles 在算法调节下处于稳定,与 1 SDR 锚定(SDR 可以看作综合多国法币计算后的稳定单位)。因此不管 ICP 以后涨到多少,你在 ICP 里面做任何事情消耗的金钱跟今天都是一样的(不考虑通胀)。

- Wasm:使用 WebAssembly (Wasm) 作为代码执行的标准,开发者可以使用多种流行的编程语言(比如 Rust,Java,C++,Motoko 等)去写代码,从而支持更多开发者的加入。

- 支持跑 AI 模型:Python 语言也可以编译为wasm,Python 用户量世界名列前茅,也是 AI 的第一语言,比如矩阵和大整数计算。已经有人在 IC 上跑 Llama2 模型了,如果说未来 AI + Web3 的概念发生在 ICP 上,我一点也不会惊讶。

- Web2 速度的体验:目前 ICP 上的很多应用都做到了毫秒级查询、秒级更新的惊人成绩。如果不信你可以直接去使用 OpenChat,一个纯链上的去中心化聊天应用。

- 链上运行前端:你只听说过后端的部分内容写成简单的智能合约,然后放在链上跑,这样可以保证数据资产等核心逻辑不被篡改。但是前端其实也需要完全跑在链上才安全,因为前端攻击是非常典型和频繁发生的问题。试想一下大家可能觉得 Uniswap 代码很安全,智能合约经过这么多年的这么多人的验证,代码也简单,肯定不会出问题吧。但是突然有一天如果 Uniswap 的前端被劫持了,跟你交互的合约其实是黑客部署的一个恶意合约,你可能瞬间就会倾家荡产。但是如果你将前端代码全都存储和部署在 IC 的 Canister 里,最起码通过 IC 的共识安全保证了前端代码无法被黑客攻击篡改,这个防护就比较完善了,且 IC 上可以直接运行和渲染前端,并不影响应用的正常运作。在 IC 上,开发者可以直接构建应用程序,无需传统云服务、数据库或支付接口,也没有必要购买一个前端服务器或担心数据库、负载均衡、网络分布、防火墙等问题。而用户通过浏览器或移动端 App 就可以直接访问 ICP 上部署的前端网页,例如我之前部署的一个个人博客。

- DAO 控制代码升级:现在许多 DeFi 协议,项目方拥有完全控制权,可以任意发起重大决定如暂停运营、卖出资金等,完全不经过社区投票商议,这种 case 相信大家都有见证或者听说过。相比之下,ICP 生态下的 DAPP 代码运行在 DAO 控制的容器内,即使某个项目方在投票中占较大比重,但也实行公示投票流程,满足了本文最开始描述的区块链透明化的必要条件。这种流程保证机制更能反映社区意愿,相对目前的其他公链项目来说在治理上实现程度更优。

- 协议自动升级:当需要升级协议时,可以在summary block中添加新的阈值签名方案,从而实现自动协议升级。这种方式可以确保网络的安全性和可靠性,同时避免了硬分叉所带来的不便和风险。 具体来说,ICP 中的 Chain Key 技术可以确保网络的安全性和可靠性,它通过一种特殊的签名方案来维护区块链状态机。在每个 epoch 的开始,网络会使用一个低阈值签名方案来生成随机数,然后使用一个高阈值签名方案来认证子网的复制状态。这种签名方案可以确保网络的安全性和可靠性,同时也可以实现自动协议升级,从而避免了硬分叉所带来的不便和风险。

Proposal Voting

- Fast fowarding:是 Internet Computer 协议中的一种快速同步节点状态的技术,它可以让新加入的节点快速地获取到当前状态,而不需要重新运行共识协议。具体来说,Fast forwarding 的过程如下:

- 新加入的节点获取当前 epoch 的 Catch-up package (CUP),其中包含了当前 epoch 的 Merkle 树根、summary block 和随机数。

- 新加入的节点使用 state sync subprotocol 从其他节点获取当前 epoch 的完整状态,同时使用 CUP 中的 Merkle 树根验证状态的正确性。

- 新加入的节点使用 CUP 中的随机数和其他节点的协议消息运行共识协议,从而快速地同步到当前状态。

Fast forwarding的优点是可以让新加入的节点快速地获取到当前状态,不需要像一些其他公链一样必须从头开始出块。这样可以加速网络的同步和扩展,同时,它也可以减少节点之间的通信量,从而提高网络的效率和可靠性。

fast forwarding

- 去中心化的互联网身份:在 IC 上的身份系统,真的让我觉得 DID 问题完全可以被解决掉了,而且是彻底解决掉,不管是扩展性还是隐私性。IC 上的身份系统目前有一个实现版本被称为 Internet Identity,还有基于它开发的更强大的 NFID。

- 它的原理如下:

- 注册时,它会为用户生成一对公钥和私钥。私钥储存在用户设备内的 TPM 安全芯片中且永远不会泄漏,而公钥会被分享给网络上的服务。

- 当用户要登录一个 DApp 时,DApp 会为用户创建一个临时会话密钥。这个会话密钥会被用户通过授权电子签名的方式签名,这样 DApp 就获得了验证用户身份的权限。

- 会话密钥的签名后,DApp 就可以使用该密钥代表用户访问网络服务,而用户无需每次都进行电子签名。这类似 Web2 中的代表授权登录。

- 会话密钥只有短时间的有效期,过期后用户需要重新通过生物识别授权签名来获得新的会话密钥。

- 用户的私钥一直保存在本地的 TPM 安全芯片中,不会离开设备。这保证了私钥的安全和用户的匿名属性。

- 通过使用临时会话密钥,不同 DApp 无法互相追踪用户身份。实现真正的匿名和私密访问。

- 用户可以方便地在多设备间同步管理自己的 Internet Identity,但设备本身也需要相应的生物识别或硬件钥匙进行授权。

- 它的原理如下:

- Internet Identity 的一些优点如下:

- 不需要记住密码。使用 biometrics 功能如指纹识别直接登录,无需设置和记住复杂密码。

- 私钥不离开设备,安全性更高。私钥保存在 TPM 的安全芯片内,无法被窃取,解决 Web2 中用户名密码被盗的问题。

- 匿名登录,无法被跟踪。不同于 Web2 用邮箱作为用户名可跨平台追踪,Internet Identity 解除了这种跟踪。

- 多设备管理更便利。可以在任何支持 biometrics 的设备登录同一个账号,而不是单设备限定。

- 不依赖中心服务商,实现真正去中心化。不同于 Web2 中 usernames 对应邮箱服务商的模式。

- 采用委托认证流程,每次登录无需重复签名,用户体验更好。

- 支持使用专用安全设备如 Ledger 或 Yubikey 登录,安全性提升。

- 隐藏用户实际公钥,无法通过公钥查询交易记录从而保障用户隐私。

- 与 Web3 区块链无缝兼容,可以安全高效地登录和签名区块链 DApp 或交易。

- 架构更先进,代表了 Web2 和 Web3 优点的有机融合,是未来网络账号和登录的标准。

- 除了能提供新的用户体验,同时也采取了以下技术手段来保证其安全性:

- 使用 TPM 安全芯片储存私钥,该芯片被设计成即使开发人员也无法接触或提取私钥,防止私钥被窃取。

- 生物认证如指纹或面容识别等二次认证机制,需要结合所在设备进行验证,使得只有持有设备的用户能使用该身份。

- 会话密钥采用短期失效设计,限制被盗用的时间窗口,并强制在会话结束时销毁相关密文,降低风险。

- 公钥加密技术使得传输过程中的数据被加密,外部监听者无法得知用户私密信息。

- 不依赖第三方身份提供商,PRIVATE KEY 由用户自行生成和控制,不信任第三方。

- 结合 IC 区块链共识机制带来的不可篡改性,确保整个系统运转的可靠性。

- 正在不断更新升级相关密码学算法和安全流程,例如加入多重签名等更安全的机制。

- 开放源代码和去中心化设计优化透明度,利于社区协作提升安全性。

Internet Identity

核心团队 / Core Team

- 从团队来看,共有 200+ 员工,都是非常精英的人才。员工共发表论文 1600+,被引用 10w+,共持有专利 250+。

- 创始人 Dominic Williams 是一名加密理论家,也是连续创业的企业家。

- 从学术上看,他最近的数学理论包括 Threshold Relay 和 PSC 链,Validation Towers and Trees 和 USCID。

- 从技术背景上看,他具备深厚的技术研发背景,早年就从事大数据和分布式计算领域的研究,这为建设复杂的 ICP 网络奠定技术基础。

- 从创业上来看,他之前利用自己的分布式系统运营了一个 MMO 游戏,该系统托管了数百万用户。2015 年 Dominic 开始启动 Dfinity ,同时他也是 String labs 的总裁和 CTO。

- 从视野上来看,他早在10多年前就提出了去中心化互联网的概念,长期推进这个宏伟项目是一个不易之举,目前来看他的设计思路很具备前瞻性。

- 在技术团队上,Dfinity 的实力非常强大。Dfinity 基金会集结了大量顶尖的密码学和分布式系统专家,例如 Jan Camenisch, Timothy Roscoe, Andreas Rossberg, Maria D., Victor Shoup 等,甚至 BLS 密码算法作者中的 “L” - Ben Lynn 也在 Dfinity 任职。这为 ICP 的技术创新提供了强有力的支持。区块链项目的成功离不开技术,而顶尖人才的聚集能带来技术突破,这也是 ICP 一个关键的优势所在。

- 创始人 Dominic Williams 是一名加密理论家,也是连续创业的企业家。

Dfinity Foundation Team

融资与经济模型 / Fund-raising & Tokenomics

这一块内容如果也讲的话,本文就太长了,因此我决定后面单独写一篇文章给大家详细分析下。本文更侧重从区块链行业的发展方向看,为什么 ICP 机会很大。

应用 / Applications

- ICP 上可以开发所有类型的应用,社交平台,创作者平台,聊天工具,游戏,甚至元宇宙游戏。

- 有很多人说 IC 上由于很难做到全局状态一致,因此天然不适合做 DeFi,但是我觉得这个问题本身就是错误的。不是全局状态一致难做,是低延迟下的全局状态一致难做。如果你能接受 1 分钟的时间,全球 1 万台机器也可以做全局一致性。Ethereum 和 BTC 现在这么多节点,不是已经被迫实现了高延迟下的全局状态一致嘛,也因此它们目前无法做到横向的无限扩展。IC 通过切分子网的方式首先解决横向无限扩展的问题,至于低延迟下的全局状态一致,通过强一致性的分布式一致性算法,良好设计的网络拓扑,高性能的分布式数据同步,时间戳有效校验,成熟的容错机制,也是可以达成的。但是实话实说,在 IC 应用层面上做一个交易平台和现在华尔街那批人做的高性能交易平台难度会更大,不仅仅是多机房达成一致。但是,难度大不代表完全不能做,而是要先解决很多技术问题,终归会找到一种适中的状态,既保证了安全性,也保证了人们可以接受的体验。比如下面的 ICLightHouse。

- ICLightHouse,一个全链上的 orderbook dex,全链上什么概念?多少技术难点要解决?在别的公链上这连想都不敢想,但是在 IC 上最起码 it’s doable,让我们看到了希望。

- OpenChat,一个体验非常棒的去中心化聊天应用,我目前在整个区块链行业没有看见过第二个这样的产品,之前有很多其他团队也在这个方向做过尝试,最终都因为各种各样的技术问题失败了,归根结底还是用户觉得体验不行,比如速度实在是太慢了,发一条消息要 10 秒,接收别人的消息也要 10 秒。但是,在 ICP 上三个人的一个小团队就做出了这么成功的产品,到底有多丝滑大家自己去体验。欢迎加入组织,在这里你可以享受到思想的碰撞,且一定程度上可以享受到言论自由的爽感。

- Mora,一个属于超级创作者的平台,在这里每一个人都可以创建一个星球,打造自己的个体品牌,且你输出的内容永远是属于你自己的,甚至可以支持付费阅读。堪称是去中心化的知识星球了,我现在已经每天都要在上面刷新文章了。

Mora - 0xkookoo

- OpenChat 和 Mora 应用是我真真实实基本上每天都在用的产品,让人有一种离不开的舒适感,两个词形容就是自由和充实。

- 目前已经有一些团队在 IC 上开发游戏应用了,我觉得全链游戏这个叙事可能最终会由 IC 来接管。就像我之前写的这篇文章里面的 GameFi 部分所说的,游戏可玩性和趣味性是项目方要考虑的事情,可玩性在 IC 上是更容易实现的,期待 Dragginz 的大作。

总结 / Summary

- ICP 就像地球一样,Chainkey 技术就像地球内核,它与 ICP 的关系类似于 TCP/IP 协议与整个互联网行业的关系,每一个 Subnet 就像亚非拉大陆一样,当然 Subnet 也可以是太平洋/大西洋,在大陆和海洋中有不同的建筑和区域(Replica 和 Node),每一个区域和建筑上可以种植物(Canister),也有不同的动物快乐地生活着;

- ICP 支持横向扩展,每个子网自治的同时还可以在不同子网之间进行通信。不管你是什么应用,social media,金融,哪怕是元宇宙,都可以通过这种分布式的网络来达成最终一致性。想要在同步的条件下达成全局账本很容易,但是想在异步的条件下达成 ”全局状态一致” 的挑战就很大了,目前来看只有 ICP 有机会做到这一点。

- 需要注意,这里指的不是 “全球状态一致”,而是 “全局状态一致”。“全局状态一致” 要求所有参与的节点【对所有的操作顺序达成一致】,【最终结果一致】,【客观一致,不依赖于节点是否发生故障】,【时钟一致】,【即时一致,所有的操作都被同步处理】,这在 IC 单子网中是可以保证的。但是如果想要保证 “全球状态一致”,就需要所有的子网作为一个整体都对同一数据和状态达到上面的 “全局状态一致”,在实际实现上,这是不可能在低延迟内达到的,这也是目前 ETH 等公链无法横向扩展的瓶颈所在。因此 IC 选择了在单子网内达成共识,其他子网通过通信的方式快速验证其结果没有造假,以此达到 “最终的全局状态一致”。相当于同时结合了大型公链的去中心化性和联盟链的高吞吐量与低延迟性,并通过数学与加密算法证明的方式实现了子网横向无限扩展。

综上,可以看到,按照我在文章最前面思考的区块链最终发展方向,【主权】+【去中心化的多点中心化】+【透明化】+【代码执行的控制权】+ 【线性成本的无限扩展性】,

- 主权是区块链唯一需要解决的一个问题,包括资产主权,数据主权,言论主权等,否则没必要有区块链这个东西;

- IC 完全做到了